传感器融合是自动驾驶汽车的先决条件

汽车电子

描述

自动驾驶汽车需要摄像头、雷达和激光雷达等传感器来查看周围环境。自动驾驶汽车还需要计算能力和人工智能来分析多维数据流,有时甚至是多源数据流,从而为车辆实时提供整体和统一的环境视图。如果传感器融合为实现完全自主开辟道路,那么仍然存在许多技术挑战。

在 AutoSens Brussels 2020 的演讲中,英飞凌奥地利技术公司的概念工程师 Norbert Druml 分享了价值 5100 万欧元的欧洲研究项目 Prystine——汽车智能可编程系统的雄心壮志。Druml 展示了迄今为止在超越 3 级自主性的故障操作传感、控制和 AI 控制的车辆演示器领域取得的一些关键成果。

Prystine 的财团由来自 14 个欧洲和非欧洲国家的 60 个合作伙伴组成,其中包括宝马、福特和玛莎拉蒂等汽车制造商;英飞凌科技和恩智浦半导体等半导体公司;技术合作伙伴;和研究机构。

(来源:普利斯汀)

故障操作行为

车辆将逐渐获得更多自主功能,驾驶员将减少对驾驶的关注,而更多地关注智能系统的监控,驾驶行为将委托给这些系统。在第 3 级,驾驶员可以在系统故障或自动驾驶功能达到其操作极限的情况下接管驾驶任务。然而,在 4 级和 5 级,不能依靠驾驶员及时和适当的方式进行干预。自动化必须能够自行处理安全关键情况。在这方面,故障操作行为在自动化链的感知、预测和行动阶段至关重要。

Prystine 的主要目标之一是实施 FUSION(故障运行城市环绕感知),它基于强大的雷达和 LiDAR 传感器融合,以及在农村和城市环境以及传感器启动的场景中实现安全自动驾驶的控制功能由于恶劣的天气条件而失败,”Druml 说。

目标是从故障安全转向故障操作行为系统,“以真正提高集成到未来汽车中的所有组件的安全性,”Druml 说。“这包括安全控制器、传感器、雷达、激光雷达、摄像头和具有处理能力的计算平台等组件。”

Prystine 合作伙伴设想的故障操作行为系统在检测到故障时不会关闭整个功能;相反,Druml 说,“它将激活能够支持某些功能的备用系统,并以较低的速度驾驶汽车到下一个进站。”

为了实现 Prystine 的 FUSION,研究重点是开发了四个 AI 算法集群,描述如下。

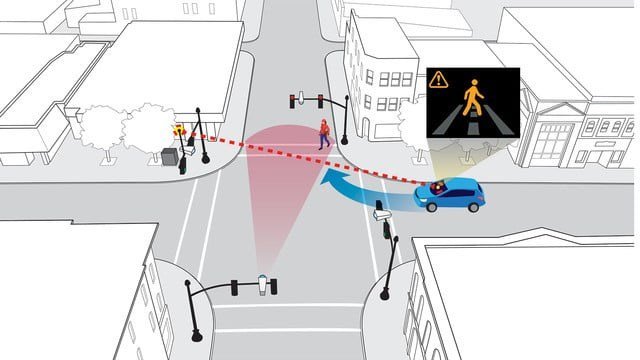

检测易受伤害的道路使用者

在欧盟,22% 的道路死亡事故是行人,8% 是骑自行车的人。该集群通过融合来自雷达、激光雷达和摄像头传感器的数据来解决弱势道路使用者(行人、骑自行车者、儿童、残疾人和老年人)的感知问题。SuperSight 解决方案的开发旨在消除盲点,以便在易受伤害的道路使用者进入驾驶员的自然视野之前就可以看到他们。合作伙伴声称 SuperSight 还提供自动安全警报,从而减少道路事故并提高驾驶员的积极性。SuperSight 解决方案使用 360° 视频处理,并在车辆上安装了周围的摄像头。

(来源:普利斯汀)

交通管理

在从 2 级和 3 级自动驾驶到 4 级的过渡过程中,车辆需要应对更复杂的交通条件和道路网络,尤其是在城市环境中。Prystine 合作伙伴正在开发一种交通管理解决方案,该解决方案融合了来自交通控制器、浮动汽车数据和自动车牌识别摄像头的交通数据。“我们融合这些数据并为汽车和道路使用者提供交通预测,”Druml 说。“这提供了超越实际汽车视野的视野方式,汽车可以优化其轨迹和路径规划。” 例如,他说,汽车可能会调整其轨迹和速度以进行绿灯运行并优化时间和能源消耗。

悬挂控制

该联盟评估了各种传感器技术——激光三角测量、雷达和超声波成像——它们可以扫描路面状况,以便车辆可以通过改变悬挂系统的阻尼系数量或垂直位置来对预测的状况做出反应。“算法分析前方道路的几何形状,并调整汽车的悬架,使用户不会感觉到道路上有洞和颠簸,”Druml 说。“驾驶汽车的便利性大大提高。”

车辆控制和轨迹规划

这组算法适用于碰撞检测、避碰、变道、紧急停车、超车、重型卡车和全尺寸拖车的后部操纵以及启动/停止安全等用例,Druml 说. 该集群部署在具有三个复杂级别的演示器中。在第一级,称为共享控制场景,驾驶员由基于 AI 的副驾驶员支持,“持续分析汽车的轨迹。如果检测到安全危急情况,基于人工智能的副驾驶会为驾驶员提供支持,并希望能够以安全的方式解决危急情况。”

Druml 说,下一个复杂级别称为分层控制,“在不同的自动化级别之间平滑切换”。例如,车辆可以从“受监督的城市控制切换到城市司机,这不仅通过持续监控汽车周围的驾驶场景和情况,还通过分析驾驶员状态和操作的复杂性来实现。”

第三级复杂性是完全由人工智能控制的车辆。“在这里,我们融合了来自雷达、激光雷达和摄像头的传感器数据,并考虑了基于云的信息——特别是交通状态和交通预测信息——以改进基于人工智能的自动驾驶解决方案,”说鼓。

他说,为期三年的 Prystine 项目将于 2021 年 4 月结束,但“这个项目的想法”将继续下去。“我们 [合作伙伴] 聚集在一起以获得一些资金,以加快我们的开发和研究活动。”

进步、机遇、挑战

加速自动驾驶汽车出现的激烈竞争压力已经在传感器融合算法开发方面取得了重大进展。但我们在 AV 传感器融合方面走了多远?市场参与者如何接近它?

EE Times Europe 向 Yole Développement(法国里昂)的技术和市场分析师 Pierrick Boulay 提出了这些问题。“汽车中的 E/E [电气/电子] 架构正在从分布式架构演变为域集中式架构,”Boulay 说。“中间会有步骤。”

他指出,汽车制造商奥迪在 2016 年使用 zFAS 域控制器迈出了第一步。所有传感器数据,包括来自 3D 相机、远程雷达、激光雷达和超声波传感器的信号,都不断地输入模块并由模块进行处理。

“使用这种类型的域控制器,更容易实现数据融合,”Boulay 说。特斯拉的 Autopilot 硬件采用了类似的方法,“从所有嵌入式传感器收集数据,同时控制音频和射频,以及导航系统。”

正如 Prystine 项目中所述,解锁自主性的一个关键是融合和解释来自各种传感器的数据,以便系统可以像人类驾驶员一样看到和理解车辆的周围环境。人工智能将越来越多地得到应用,所有开发算法来分析如此大量的异构数据的公司都有望找到很多机会,Boulay 说。对于制造芯片来处理数据的公司来说也是如此。对计算能力的需求随着自治水平的提高而不断增加。例如,机器人汽车每秒的运算量已经超过 250 兆兆字节,而特斯拉的全自动驾驶能力接近 70 TOPS。

算力能否无限提升?对于完整的 AV,它在什么水平上才算足够?“一些公司将通过需要中等计算能力的优化系统实现完全自主,而其他公司可能需要两倍的计算能力,”Boulay 说。“只有时间会告诉我们极限在哪里。”

一些挑战与传感器和计算的功耗有关,尤其是在电动汽车中。“处理大量数据可能会对电动汽车的续航里程产生影响,”Boulay 说。“由于范围是客户的主要关注点,因此这种自主系统必须是节能的。”

与传感器融合相关的另一个挑战是融合不同维度空间(即 2D 和 3D)中的数据的能力。“这是 OEM 和一级供应商必须回答的关键问题,”Boulay 说。“激光雷达将能够设置 3D 场景,摄像头和雷达将用于微调该场景,为图像带来色彩,为物体带来速度。

“这将是相当复杂的实现,这将是领先者和落后者之间的区别。”

审核编辑 黄昊宇

-

未来已来,多传感器融合感知是自动驾驶破局的关键2024-04-11 2201

-

自动驾驶的到来2017-06-08 7305

-

AI/自动驾驶领域的巅峰会议—国际AI自动驾驶高峰论坛2017-09-13 7353

-

自动驾驶汽车的定位技术2019-05-09 3342

-

智能感知方案怎么帮助实现安全的自动驾驶?2019-07-31 3162

-

自动驾驶系列报告大放送了涉及传感器,芯片,执行控制等2019-08-09 3522

-

自动驾驶的五大传感器各有千秋2020-05-13 2137

-

自动驾驶汽车中传感器的分析2020-05-14 3470

-

这些自动驾驶传感器,你了解多少?2020-05-18 2859

-

传感器融合是通向自动驾驶时代的关键一步2020-05-20 2477

-

传感器成自动驾驶“硬实力” 有哪些2020-07-29 2013

-

汽车传感器融合系统浅析2020-07-31 3029

-

边缘计算在自动驾驶汽车的应用2021-07-12 1580

-

传感器融合在自动驾驶领域的应用2019-07-27 2382

-

自动驾驶汽车的未来趋势:集中式传感器融合2022-11-16 3194

全部0条评论

快来发表一下你的评论吧 !