国际视频编码标准mpeg简述及AVS视频关键技术

视频技术

描述

国际视频编码标准mpeg简述

20世纪90年代以来,ITU-T和ISO制定了一系列音视频编码技术标准(信源编码技术标准)和建议,这些标准和建议的制定极大地推动了多媒体技术的实用化和产业化。从技术进步的角度看,1994年完成的第一代信源编码技术标准MPEG-1和MPEG-2的压缩能力为50-75倍。进入新世纪以来,第二代信源编码技术标准相继出台,压缩效率可达到100-150倍。第二代信源编码技术标准将使原来刚刚形成不久的国际数字电视和数字音视频产业格局重新“洗牌”。

国际上音视频编解码标准主要有两大系列:ISO/IEC JTC1制定的MPEG系列标准,数字电视采用的是MPEG系列标准;ITU针对多媒体通信制定的H.26x系列视频编码标准和G.7系列音频编码标准。

CCITT(国际电报电话咨询委员会,现并入国际电信联盟ITU)从1984年开始提出一系列有关音频编码算法和国际标准。1984年CCITT第15研究组成立了一个专家组,专门研究电视电话的编码问题,经过5年以上的研究和努力,在1990年12月完成和批准了CCITT推荐书 H.261。在H.261的基础上,1996年ITU-T完成了H.263编码标准,在编码算法复杂度增加很少的基础上,H.263能提供更好的图像质量、更低的速率,目前,H.263编码是IP视频通信采用最多的一种编码方法。1998年ITU-T推出的H.263+是H.263建议的第二版,它提供了12个新的可协商模式和其他特征,进一步提高了压缩编码性能。

MPEG是国际标准化组织和国际电工委员会第一联合技术组(ISO/IEC JTC1)1988年成立的运动图像专家组(Moving Picture Expert Group)的简称,全称为ISO/IEC JTC1第29分委会第11工作组(ISO/IEC JTC1/SC29/WG11),负责数字视频、音频和其他媒体的压缩、解压缩、处理和表示等国际技术标准的制定工作。从1988年开始,MPEG专家组每年召开四次左右的国际会议,主要内容是制定、修订、发展MPEG系列多媒体标准。视音频编码标准MPEG-1(1992)和MPEG-2(1994)、基于视听媒体对象的多媒体编码标准MPEG-4(1999年)、多媒体内容描述标准MPEG-7(2001)、多媒体框架标准MPEG-21。目前,MPEG系列国际标准已经成为影响最大的多媒体技术标准,对数字电视、视听消费电子产品、多媒体通信等信息产业的重要产品产生了深远影响。

CCITT H.261标准始于1984年,实质完成于1989年,是MPEG的先驱。MPEG-1和H.261有共同的数据结构、编码工具和语法元素,然而两者并非完全后向兼容,MPEG-1可看作是H.261的扩展集。MPEG-1的发展始于1988年,实质完成于1992年。MPEG-2可被看作是MPEG-1的扩展集,始于1990年,实质完成于1994年。H.263始于1992年,第一版完成于1995年。MPEG-4(其视频部分建立在MPEG-2和H.263的基础上)始于1993年,第一版实质完成于1998年。

MPEG专家组已经和正在制定的标准包括:

(1) MPEG-1标准:1992年11月正式成为国际标准,名称为“用于数字存储媒体速率为1.5Mbps的运动图像及其伴音的压缩编码”。MPEG-1的支持的视频参数为352 X 240 X 30帧/秒或相当。

(2) MPEG-2:1994年11月成为国际标准(ISO/IEC13818),这是一个适应性广的动态影像和声音编码方案,最初目标是把视频及其伴音信号压缩到10Mb/s,经实验可适用于1.5-60Mb/s的编码范围,甚至还可以更高。MPEG-2可用于数字通信、存储、广播、高清晰度电视等的压缩编码。DVD和数字电视广播采用的是MPEG-2标准。1994年后,MPEG-2标准还进行了一定扩展和修订。

MPEG标准中视频编解码技术

MPEG标准主要基于三大编码工具:自适应块变换编码(Adaptive block transform coding)消除空间冗余;运动补偿差分脉冲编码调制(Motion-compensated DPCM)消除时域冗余,二者融合为混合编码技术(hybrid coding)。熵编码(Entropy coding)用于消除混合编码器产生的统计冗余。还有一些辅助工具作为主要工具的补充,用于消除已编码数据某些特殊部分的剩余冗余,或者根据具体应用对编码进行调整,也有的编码工具支持将数据格式化为特定比特流以便于存储和传输。

现代熵编码始创于20世纪40年代末;60年代末应用于视频编码;然后不断改进,80年代中期引入了二维可变长编码(2D VLC)和算术编码(arithmetic coding)方法。

DPCM始创于1952年,同年首次应用于视频编码。DPCM最初是作为空间编码技术而发展,到了70年代中期,DPCM开始用于时域编码。DPCM作为一种完整的视频编码方案,一直持续到80年代初期。从70年代中早期开始,DPCM的关键元素与变换编码技术融合,逐渐形成了混合编码技术,并于80年代早期发展成为MPEG的雏形。

变换编码60年代末首次用于视频,70年代上半期得到实质性的发展,被认为在空间编码方面达到最高分辨率效果。在混合编码中,变换编码用于消除空间冗余,DCPM用于消除时间冗余。运动补偿预测技术极大地提高了时域DCPM的性能,它始创于1969年,80年代初发展成为MPEG的基本形式。80年代早期,扩展出内插编码(interpolative coding),即通过多帧内插进行预测,中间帧通过比例运动矢量(scaled motion vectors)预测。直至80年代末,双向预测技术(bi-directional prediction)诞生,该技术才发展到最终形式。在近年来的进展中(H.264),预测质量得到改进,亦即不同信号之间的相关性降低。因此,变换的必需性降低,H.264使用了简化的变换(4 x4)。

AVS标准和相关国际标准的时间对应关系以及AVS工作组已经开展的工作如下图所示。

视频压缩基本原理

视频能够压缩的根本原因在于视频数据具有较高的冗余度。压缩就是指冗余的消除,主要基于两种技术:统计学和心理视觉。

消除统计冗余的基本依据是视频数字化过程在时间和空间上采用了规则的采样过程。视频画面数字化为规则的像素阵列,其密集程度适于表征每点最高的空间频率,而绝大多数画面帧包含非常少甚至不含这种最高频率的细节。同样,所选的帧频能够表征场景中最快的运动,而理想的压缩系统只要描述场景所必需的瞬时运动即可。简言之,理想的压缩系统能够动态适应视频在时间和空间上的变化,所需要的数据量远低于数字化采样所产生的原始数据。

心理视觉技术主要是针对人类视觉系统极限。人类视觉在对比度带宽、空间带宽(特别是彩色视觉)、时间带宽等方面存在极限。而且,这些极限并非相互独立,整体的视觉系统存在上限,例如,人眼不可能同时察觉到时间和空间的高分辨率。显然,没有必要表征那些不能被感知的信息,或者说,一定程度的压缩损失是人的视觉系统是感知不出来的。

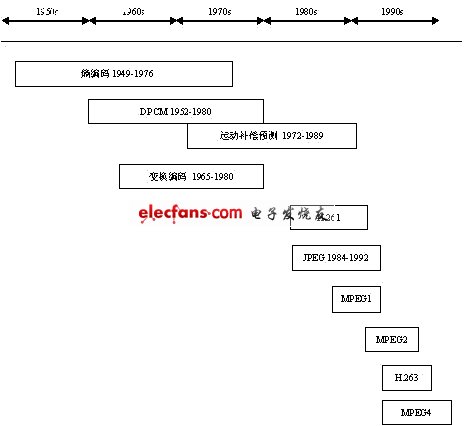

视频编码标准并非一个单一的算法,而是一整套的编码工具,这些工具综合起来就达到了完整的压缩效果。视频压缩的历史可以追溯到上个世纪50年代初,在随后30多年时间里,主要的压缩技术和工具逐渐发展起来,在上世纪80年代初,视频编码技术初步成型。最初每个主要的工具都是作为视频编码的一个完整解决方案而提出,各条技术主线平行发展,最终各性能最佳者汇合成为完整的解决方案,方案集成的主要贡献者是标准化组织,来自各国家和组织的专家们共同完成了方案集成工作,或者说,编码标准方案是标准委员会原创的。另外,尽管有些技术多年前就已经提出,但由于实现代价昂贵而没能在当时得到实际应用,直到近年来半导体技术的发展才满足实时视频处理的要求。

图 2编码工具与标准的发展(Cliff, 2002)

(3) MPEG-4:注意到低带宽应用的需要和交互式图形应用(游戏等合成内容)、交互式多媒体(WWW等内容分发和访问技术)的快速发展,MPEG专家组成立了MPEG-4工作组,以促进上述三个领域的集成。1999年初,定义标准框架的MPEG-4(第一版)成为国际标准(ISO/IEC 14496-1),提供多种算法和工具的第二版已于99年底成为国际标准(ISO/IEC 14496-2),后续还在制定第三、四、五版。

(4) MPEG-7与MPEG-21标准:MPEG-7是面向多媒体信息搜索、过滤、管理和处理的内容表达标准,2001年7月成为国际标准。正在制定的MPEG-21的重点是多媒体框架,为与多媒体内容递交相关的所有已开发的和正在开发的标准提供基础体系。

第二代视频编码标准

1994年制定的MPEG-2标准和H.263标准是国际音视频标准领域的一个里程碑,是音视频行业遵循的基本标准。近十年来,音视频编码技术本身和产业应用背景都发生了明显变化。ITU-T于1997年提出的一个长期的视频标准化项目H.26L,ITU-T并在1999年8月推出该标准的第一版测试模型。为了响应ISO/IEC MPEG对先进视频编码技术的需求,从2001年开始,ISO和ITU开始组建了联合视频工作组(JVT,Joint Video Team ,ISO/IEC MPEG和ITU-T VCEG联合视频工作组),在H.26L的基础上开发新的视频编码标准,即JVT标准。

JVT标准是一套兼顾广播和电信、覆盖从低码率通信到高清晰电视的广域标准。在ISO/IEC中,该标准的正式名称为MPEG-4 AVC(Advanced Video Coding)标准;在ITU-T中的正式名称为H.264标准。2003年下半年,ISO/IEC以MPEG-4第十部分(ISO/IEC 14496-10)的名义正式发布了这项标准。

虽然MPEG-4 AVC/H.264是第二代标准中的一个重要代表,但远不如MPEG-2当年那样一枝独秀,而且面临着多个来自企业和其他标准组织强有力的技术竞争。来自企业的竞争者以微软提出的WMV9为代表。SMPTE(Society of Motion Picture and Television Engineers,美国电影与电视工程师协会)是得到美国国家标准研究所(ANSI)认证的视频、电视和电影工业标准开发组织,在制定和发掘私有规范方面具有丰富经验。2003年09月,SMPTE接收WMV-9所采用的压缩技术规范作为一种视频编解码格式标准,标准草案名称为“SMPTE Standard for Television: VC-9 Compressed Video Bitstream Format and Decoding Process”,简称VC-1。2006年4月,SMPTE 正式发布VC-1。

AVS标准是中国数字音视频编解码技术标准工作组(AVS工作组)制定的数字音视频编码标准。AVS工作组成立于2002年,成员包括国内外从事数字音视频编码技术和产品研究开发的一百多家机构和企业。AVS工作组的任务是面向我国的信息产业需求,组织制定行业和国家信源编码技术标准。AVS国家标准的正式名称是《信息技术 先进音视频编码》,编号为GB/T 20090,包括9个部分,其中《第2部分 视频》(简称AVS视频)于2006年2月颁布,3月实施。AVS视频标准主要面向高清晰度和高质量数字电视广播、数字存储媒体和其他相关应用。它具有四大特点:(1)性能高,编码效率比MPEG-2高2倍以上,与H.264的编码效率相当;(2)复杂度低,算法复杂度比H.264低;(3)实现成本低,软硬件实现成本都低于H.264;(4)专利授权模式简单,费用明显低于同类标准。

MPEG1和H.261的前身是CCITT H.261标准(始于1984年,实质性完成于1989年),它们有共同的数据结构、编码工具和语法元素。然而两者并非恰好后向兼容。MPEG1可看作是H.261的扩展集。MPEG1的发展始于1988年,实质性完成于1992年。MPEG2可被看作是MPEG2的扩展集,始于1990,实质完成于1994年。H.263始于1992年,第一版完成于1995。MPEG4(其视频是建于MPEG2和.263基础上)始于1993,第一版实质完成于1998年。由于芯片等技术的允许,2003年完成的MPEG-4 AVC/H.264比先前的视频编码标准采用了更为复杂的技术,同时也有新的技术模块,多尺寸块的帧内和帧间编码、多方向空间预测技术、4x4整数正交变换、去除块效应的环内滤波器等,可以获得更高的压缩比。由于采用了数据划分,JVT标准还具有更强的容错能力。

AVS标准及其核心技术

AVS是我国自主制定的第二代音视频编码技术标准。AVS视频当中具有特征性的核心技术包括:8x8整数变换、量化、帧内预测、1/4精度像素插值、特殊的帧间预测运动补偿、二维熵编码、去块效应环内滤波等。

1)变换、量化

AVS的8x8变换与量化可以在16位处理器上无失真地实现,从而克服了MPEG-4 AVC/ H.264之前所有视频压缩编码国际标准中采用的8x8 DCT变换存在失真的固有问题。而MPEG-4 AVC/ H.264所采用的4x4整数变换在高分辨率的视频图像上的去相关性能不及8x8的变换有效。AVS采用了64级量化,可以完全适应不同的应用和业务对码率和质量的要求。在解决了16位实现的问题后,目前AVS所采用的8x8变换与量化方案,既适合于16位DSP或其他软件方式的快速实现,也适合于ASIC的优化实现。

2)帧内预测

AVS的帧内预测技术沿袭了MPEG-4 AVC/ H.264帧内预测的思路,用相邻块的像素预测当前块,采用代表空间域纹理方向的多种预测模式。但AVS亮度和色度帧内预测都是以8x8块为单位的。亮度块采用5种预测模式,色度块采用4种预测模式,而这4种模式中又有3种和亮度块的预测模式相同。在编码质量相当的前提下,AVS采用较少的预测模式,使方案更加简洁、实现的复杂度大为降低。

3)多模式帧间预测

帧间运动补偿编码是混合编码技术框架中最重要的部分之一。AVS标准采用了16×16、16×8、8×16和8×8的块模式进行运动补偿,而去除了MPEG-4 AVC/ H.264标准中的8×4、4×8、4×4的块模式,目的是能更好地刻画物体运动,提高运动搜索的准确性。实验表明,对于高分辨率视频,AVS选用的块模式已经能足够精细地表达物体的运动。较少的块模式,能降低运动矢量和块模式传输的开销,从而提高压缩效率、降低编解码实现的复杂度。

4)1/4像素运动补偿

AVS和MPEG-4 AVC/ H.264都采用了1/4像素精度的运动补偿技术。MPEG-4 AVC/ H.264采用6抽头滤波器进行半像素插值并采用双线性滤波器进行1/4像素插值。而AVS采用了不同的4抽头滤波器进行半像素插值和1/4像素插值,在不降低性能的情况下减少插值所需要的参考像素点,减小了数据存取带宽需求,这在高分辨率视频压缩应用中是非常有意义的。

5)参考帧

在传统的视频编码标准(MPEG-x系列与H.26x系列)中,双向预测帧B帧都只有一个前向参考帧与一个后向参考帧,而前向预测帧P 帧则只有一个前向参考帧。而新近的MPEG-4 AVC/ H.264充分地利用图片之间的时域相关性,允许P帧和B帧有多个参考帧,最多可以有31个参考帧。多帧参考技术在提高压缩效率的同时也将极大地增加存储空间与数据存取的开销。AVS中P帧可以利用至多2帧的前向参考帧,而B帧采用前后各一个参考帧,P帧与B帧(包括后向参考帧)的参考帧数相同,其参考帧存储空间与数据存取的开销并不比传统视频编码的标准大,而恰恰充分利用了必须预留的资源。

6)1/4像素运动补偿

AVS的B帧的双向预测使用了直接模式(direct mode)、对称模式(symmetric mode)和跳过模式(skip mode)。使用对称模式时,码流只需要传送前向运动矢量,后向运动矢量可由前向运动矢量导出,从而节省后向运动矢量的编码开销。对于直接模式,当前块的前、后向运动矢量都是由后向参考图像相应位置块的运动矢量导出,无需传输运动矢量,因此也可以节省运动矢量的编码开销。跳过模式的运动矢量的导出方法和直接模式的相同,跳过模式编码的块其运动补偿的残差也均为零,即该模式下宏块只需要传输模式信号,而不需要传输运动矢量、补偿残差等附加信息。

7)熵编码

AVS熵编码采用自适应变长编码技术。 在AVS熵编码过程中,所有的语法元素和残差数据都是以指数哥伦布码的形式映射成二进制比特流。采用指数哥伦布码的优势在于:一方面,它的硬件复杂度比较低,可以根据闭合公式解析码字,无需查表;另一方面,它可以根据编码元素的概率分布灵活地确定以k阶指数哥伦布码编码,如果k选得恰当,则编码效率可以逼近信息熵。

对预测残差的块变换系数,经扫描形成(level、run)对串,level、run不是独立事件,而存在着很强的相关性,在AVS中level、run采用二维联合编码,并根据当前level、run的不同概率分布趋势,自适应改变指数哥伦布码的阶数。

AVS视频目前定义了一个档次(profile)即基准档次。该基准档次又分为6个级别(level),分别对应高清晰度、标准清晰度与CIF(1/4标清,相当于VHS或VCD质量)应用。 与MPEG-4 AVC/ H.264的baseline profile相比,AVS视频增加了B帧、interlace等技术,因此其压缩效率明显提高,而与MPEG-4 AVC/ H.264的main profile相比,又减少了CABAC等实现难度大的技术,从而增强了可实现性。

AVS视频的主要特点是应用目标明确,技术有针对性。因此在高分辨率应用中,其压缩效率明显比现在在数字电视、光存储媒体中常用的MPEG-2视频提高一个层次。在压缩效率相当的前提下,又较MPEG-4 AVC/ H.264的 main profile的实现复杂度大为降低。

-

国际上音视频编解码标准主要两大系列2022-02-14 4327

-

新一代视频编码标准H,264/AVC有哪几种关键技术?2021-06-03 1985

-

怎么设计AVS视频解码芯片仿真和验证平台?2019-09-23 1804

-

基于FPGA NiosII的MPEG-4视频播放器该怎么设计?2019-09-03 2179

-

基于FPGA NiosII的MPEG-4视频播放器该怎么设计?2019-08-30 1644

-

AVS编码与DSP实现的视频编码器2019-01-31 1120

-

新一代视频编码标准VVC和AVS3的进展及关键技术特色等介绍2019-01-13 13231

-

H.264与AVS视频标准核心技术比较2018-12-29 999

-

AVS音频编码技术2011-03-04 1805

-

AVS与国际标准MPEG的区别2011-02-13 3586

-

走出“象牙塔”的AVS-中国自己的数字音视频编解码技术标准2009-05-05 3111

-

IPTV技术及应用2008-10-27 5391

-

数字音视频编解码技术与标准AVS2008-06-25 5011

全部0条评论

快来发表一下你的评论吧 !