NVIDIA 集合通信库加快深度学习训练速度

描述

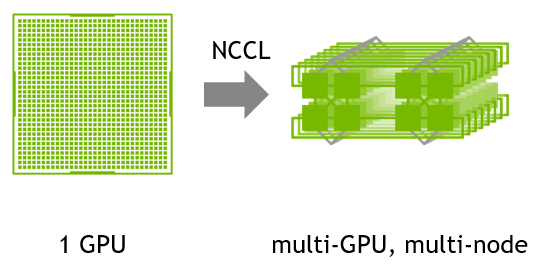

NVIDIA 集合通信库(NCCL)可实现针对 NVIDIA GPU 和网络进行性能优化的多 GPU 和多节点通信基元。

关于 NVIDIA 集合通信库(NCCL)

NCCL 提供了 all-gather、all-reduce、broadcast、reduce、reduce-scatter、point-to-point send 和 receive 等例程,这些例程均经过优化,可通过节点内的 PCIe 和 NVLink 高速互联以及节点间的 NVIDIA Mellanox 网络实现高带宽和低延迟。

先进的深度学习框架(例如 Caffe2、Chainer、MXNet、PyTorch和 TensorFlow)已集成 NCCL,以在多 GPU 多节点的系统上加快深度学习训练速度。

便捷性能

使用 NCCL,开发者无需针对特定机器优化其应用,因而更加便捷。NCCL 可在节点内和节点间实现多个 GPU 的快速集合。

简化编程

NCCL 使用可从多种编程语言轻松访问的简单 C API,且严格遵循 MPI(消息传递接口)定义的主流集合 API。

兼容性

NCCL 几乎可与任何多 GPU 并行模型兼容,例如:单线程、多线程(每个 GPU 使用一个线程)和多进程模型(MPI 与 GPU 上的多线程操作相结合)。

主要特性

对 AMD、Arm、PCI Gen4 和 IB HDR 上的高带宽路径进行自动拓扑检测

凭借利用 SHARPV2 的网络内 all reduce 操作,将峰值带宽提升 2 倍

通过图形搜索,找到更佳的高带宽、低延迟的环和树集合

支持多线程和多进程应用

InfiniBand verbs、libfabric、RoCE 和 IP Socket 节点间通信

使用 Infiniband 动态路由重新路由流量,缓解端口拥塞

-

NVIDIA火热招聘深度学习 (Deep Learning) 达人2017-08-25 5316

-

在Ubuntu上使用Nvidia GPU训练模型2022-01-03 2412

-

NVIDIA深度学习平台2016-08-06 2302

-

各种编程语言的深度学习库整理2017-08-30 2988

-

如何才能高效地进行深度学习模型训练?2018-07-09 15253

-

NVIDIA迁移学习工具包 :用于特定领域深度学习模型快速训练的高级SDK2018-12-07 3725

-

本周NVIDIA在线研讨会亮点前瞻2022-02-17 1598

-

NVIDIA GPU加快深度神经网络训练和推断2022-02-18 2689

-

使用 NVIDIA TAO 工具套件和预训练模型加快 AI 开发2022-12-15 1741

-

深度学习如何挑选GPU?2023-07-12 909

-

深度学习框架区分训练还是推理吗2023-08-17 2198

-

视觉深度学习迁移学习训练框架Torchvision介绍2023-09-22 1886

-

深度学习模型训练过程详解2024-07-01 3963

-

Pytorch深度学习训练的方法2024-10-28 1063

-

如何破解GPU集群集合通信路径的“黑盒”难题?2025-05-22 768

全部0条评论

快来发表一下你的评论吧 !