在全志R329 板子上跑mobilenetv2的流程介绍

今日头条

描述

1、opencv 交叉编译

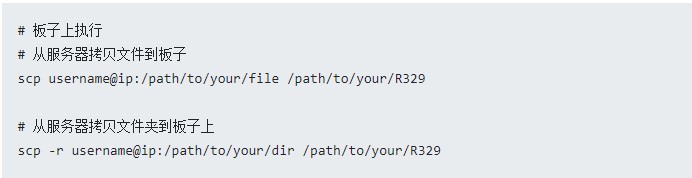

R329 是 aarch64 的,所以用到的 opencv 也需要交叉编译,完了把头和库拷到板子上,板子上的文件传输可以采用 scp,scp 的使用方法类似这样:

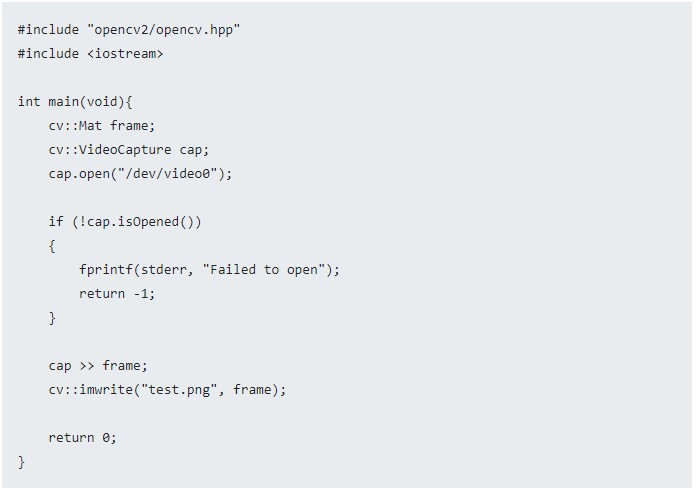

2、板子跑 opencv 抓图

写这个模块,主要目的是用简单的 opencv 工程验证下板子的摄像头是否正常。

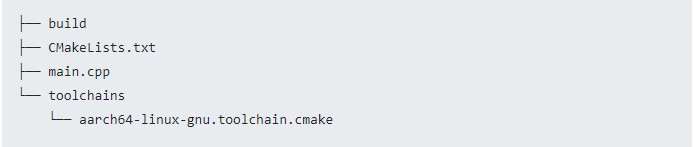

2.1 工程目录结构

搭建cmake工程,结构如下:

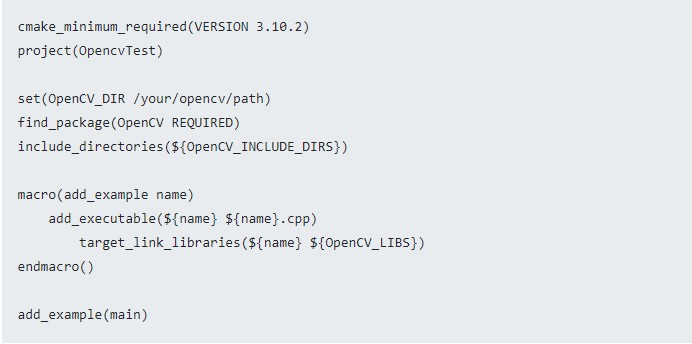

2.2 CMakeLists.txt

2.3 main.cpp

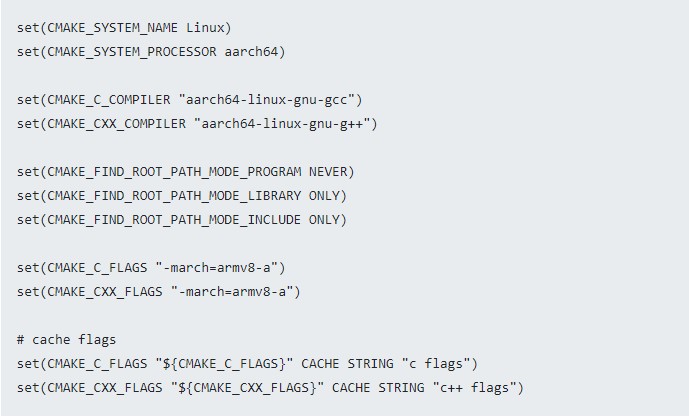

2.4 aarch64-linux-gnu.toolchain.cmake

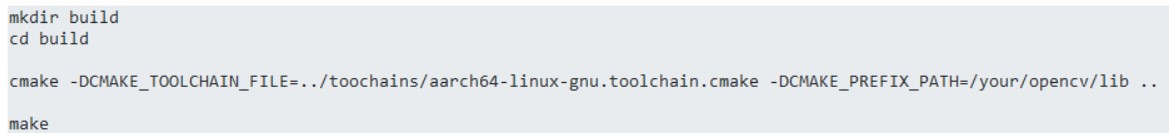

2.5 编译

完了把编译生成的可执行程序用 scp 拷贝到 板子上

在开发板上运行程序:

正常会生成一张 test.png 的图片,这是你板子摄像头现拍的图像。

3、板子跑 mobilenetv2 检测

3.1 转换 mobilenetv2 模型

此步骤是为了将深度学习训练框架(前端)产生的模型(支持 tensorflow pb、tflite、caffemodel、onnx),选择还是挺多的,我这里用的是 tflite 来转换板子可支持运行的模型格式。

转换方法还是可参考这篇 《【嵌入式AI】周易 AIPU 算法部署仿真测试》,这篇里写的前端是来自 tensorflow 的,相比 from_tensorflow,from_tflite 的过程少了模型 export 和 freeze 的过程,所以相对简单一些。

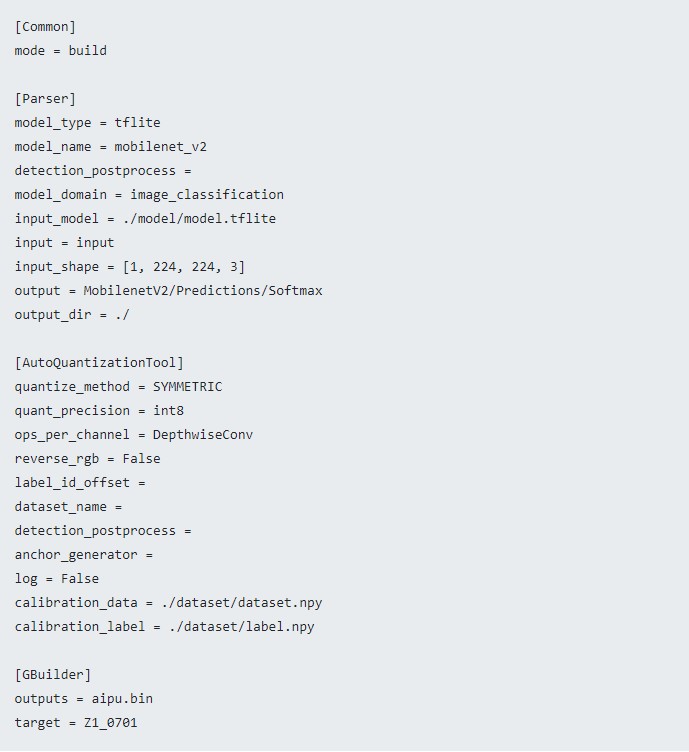

模型转换的关键是 model_build.cfg 配置文件,这里给出 modilenetv2 的 mobilenetv2_build.config。

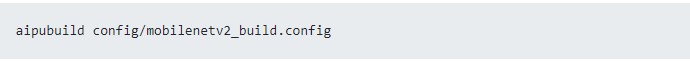

然后执行:

正常情况会生成 aipu.bin 模型文件,这个文件是后面板子上执行的时候调用的。多说一句,个人理解这个 aipu.bin 里面应该是记录了模型的推理执行 flow,就像 tensorrt 的 engine 一样,不知道理解是否有问题。

3.2 zhouyi_cam 交叉编译

交叉编译 zhouyi_cam,工程代码在这里 ,工具链在这里,提取码都是:6666。

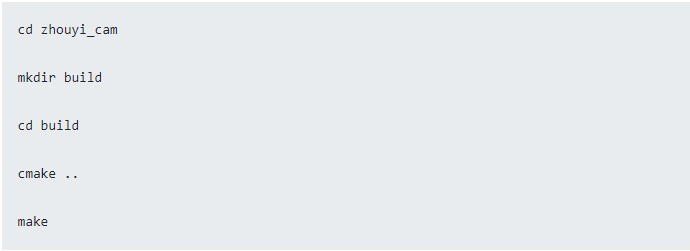

把工程 和 工具链 下载下来后,交叉编译很简单。

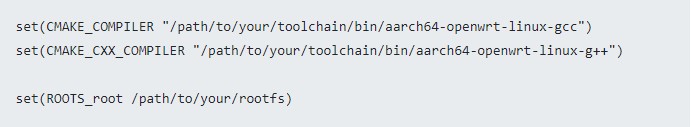

需要改 CMakeList.txt 里的几个地方:

开始编译吧

大功告成后会生成 zhouyi_demo,将其和 3.1 生成的 aipu.bin 拷贝到板子上。

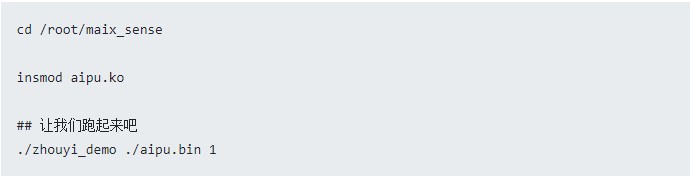

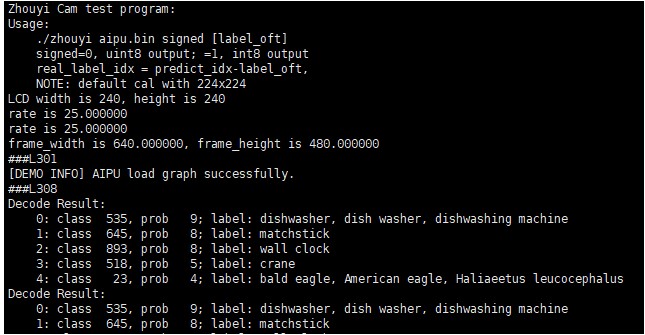

3.3 mobilenetv2 跑起来

目光转到板子上。

差不多可以跑 20 帧,接近实时了~

审核编辑:刘清

-

【R329开发板评测】R329 初体验:ShuffleNet 上板部署2022-01-25 601

-

R329的优势是什么?2021-12-29 710

-

详细介绍R329开发环境搭建的方法2021-12-14 1035

-

全志科技正式发布首款AI语音专用芯片R3292020-11-23 2597

全部0条评论

快来发表一下你的评论吧 !