一文解析HPC存储系统的挑战

存储技术

描述

随着数据集的不断增长和高性能计算(HPC)资源的增加, HPC系统的使用会有显著的增长。最大限度地提高这些系统的效率和效益,成为了首要问题。

高性能计算(HPC)在历史上主要提供给政府、研究机构和少数非常大的公司用于建模、模拟和预测应用。随着HPC平台被部署在云端以提供共享服务,高性能计算正变得更容易获得,这个使用正使所有规模的组织受益。对工业物联网(IIoT)、人工智能的投资不断增加。 人工智能,以及电子设计自动化(EDA)和工程开发的硅IP是推动高性能计算系统使用增加的几个因素。因此,从2020年到2025年,高性能计算市场预计将每年增长超过6%。 有许多类型的应用程序受益于在HPC平台上运行,比如…

• 详细的设计模拟,减少产品的开发时间

• 各个行业的高保真建模,包括汽车、医疗和机器人行业

• 工业应用的物理模拟、优化和机器学习

• 金融建模

• 生命科学模拟 一般来说,用于大数据处理、模拟和预测的日益复杂的模型正在推动对更多计算能力和更大存储容量及性能的需求。 本文强调了不同的存储技术如何在提供高容量和低延迟存储的同时最大限度地提高HPC系统的效率和效益,并最大限度地减少网络带宽和电力消耗。

HPC存储系统的挑战

HPC应用中不断增加的复杂性和数据集规模为HPC基础设施带来了一些挑战,有以下几个方面。

• 带宽。在存储和计算节点之间移动PB级的数据 • 容量。系统容量必须扩大,以容纳使用中的、短期的和长期的存储。

• 延迟。数据访问时间和网络延迟会大大延长应用程序的运行时间 • 安全性。大多数HPC数据是专有的和关键的业务,因此需要访问控制、完整性保护和遵从法律法规(针对数据隐私)

• 访问管理。多节点并行文件系统需要强大的访问管理,以防止出现计算机竞态条件

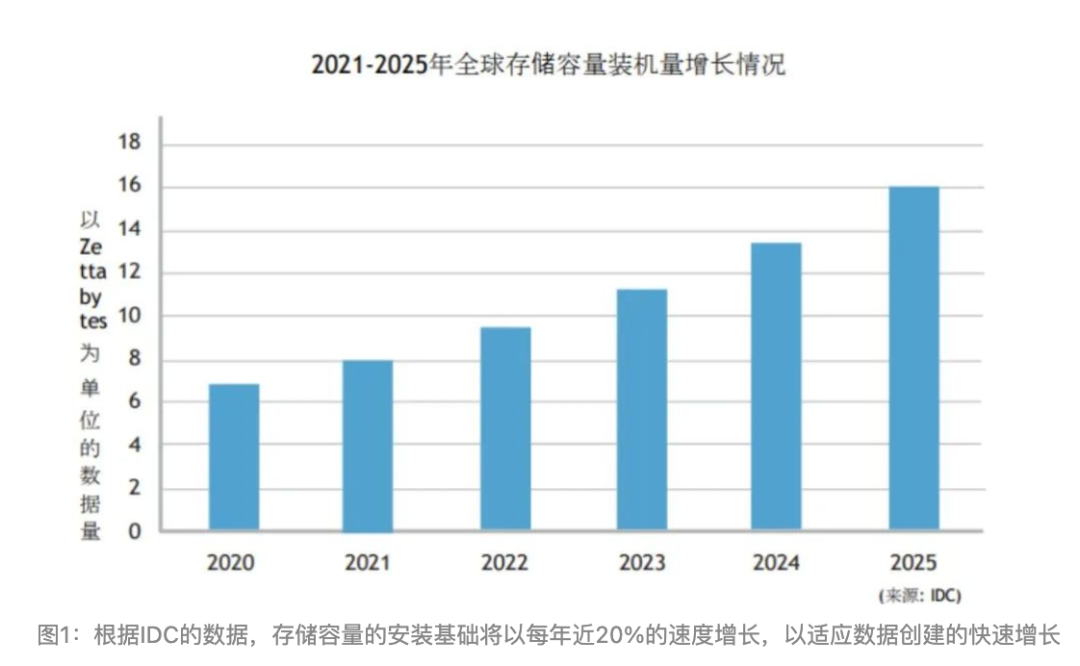

• 功率:超级计算机已接近100千瓦/架,其中大部分被数据移动所消耗 随着HPC应用数据集的增长,在数据网络和设备接口上需要越来越多的带宽,以便在计算和存储节点之间移动这些数据。以太网、PCI Express(PCIe)和其他接口技术正在逐步增加带宽以满足这一需求。网络基础设施从100Gbps到400Gbps以太网的过渡正在顺利进行。还有一些800Gbps和1.6Tbps以太网的早期部署也即将到来。存储设备的数据接口速度也在提高,NVMe固态硬盘采用PCIe 5.0和 6.0,分别利用每车道32Gbps和64Gbps的传输速率。 数据创建的快速速度也推动了对增加数据存储容量的需求。虽然许多被创建的数据是短暂的,没有被写入非易失性存储,但大量的数据被存储起来供将来使用,这就推动了对增加存储容量的需求。IDC预测,从2020年到2025年,全世界的存储容量将以每年19.2%的速度增长,以支持不断增长的数据创建和存储。

除了带宽和容量的改进,还有一些额外的存储技术正在解决HPC的需求。下面几节将介绍其中的一些技术。

用于HPC的存储技术

持久性内存、远程直接内存访问(RDMA)和RDMA over converged Ethernet(RoCE)、Non-Volatile Memory Express over Fabrics (NVMe-oF)和计算存储是最近HPC数据存储的一些技术创新。

• 持久性内存为内存提供了一个新的价格/性能点,并在HPC系统中实现了一个新的存储层。

• RDMA和RoCE为访问远程存储设备中的数据提供了一种低延迟、高效率的手段。

• NVMe-oF使用NVMe协议在网络结构上提供对分类存储设备的访问,其延迟与本地存储设备的延迟相似。

• 计算存储将计算能力整合到存储系统中,以减轻计算服务器的负担,减少必须在存储和内存/计算之间传输的数据量。

持久内存

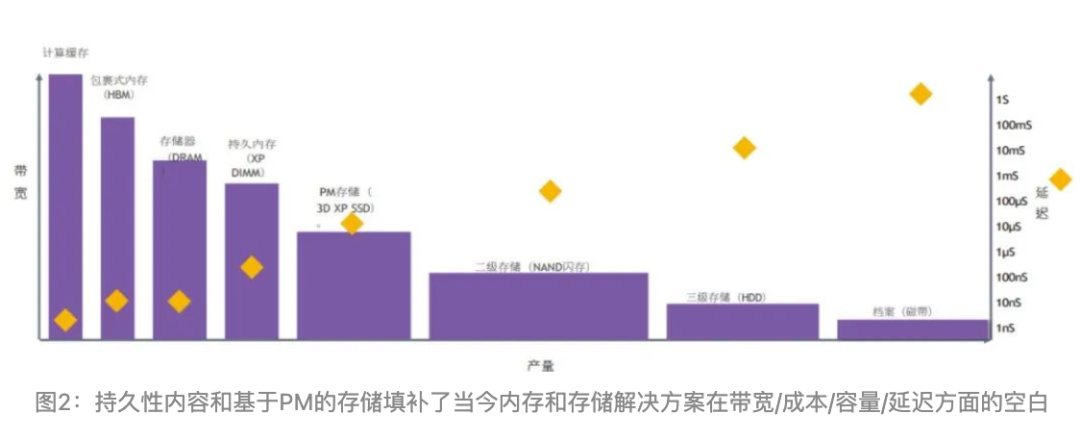

现代计算系统利用各种不同类型的内存和非易失性存储来满足数据在不同阶段的需求。这些不同类型的内存和存储满足了广泛的需求, 从非常高速、低延迟、昂贵的缓存内存到相对低速、高延迟、廉价的存档磁带。然而,迄今为止,系统主存储器(DRAM)和NAND闪存之间存在性能、容量和成本差距。使用3D XPoint、BiCS闪存和Z-NAND等技术的持久内存解决了这一差距。(图2)

持久性存储器提供的容量接近NAND闪存驱动器,而延迟则接近SDRAM。高容量和低延迟的属性使持久性内存成为容量和性能要求高的应用的绝佳选择,如数据库加速器、建模和模拟、实时分析和AI/深度学习培训。

RDMA/RoCE

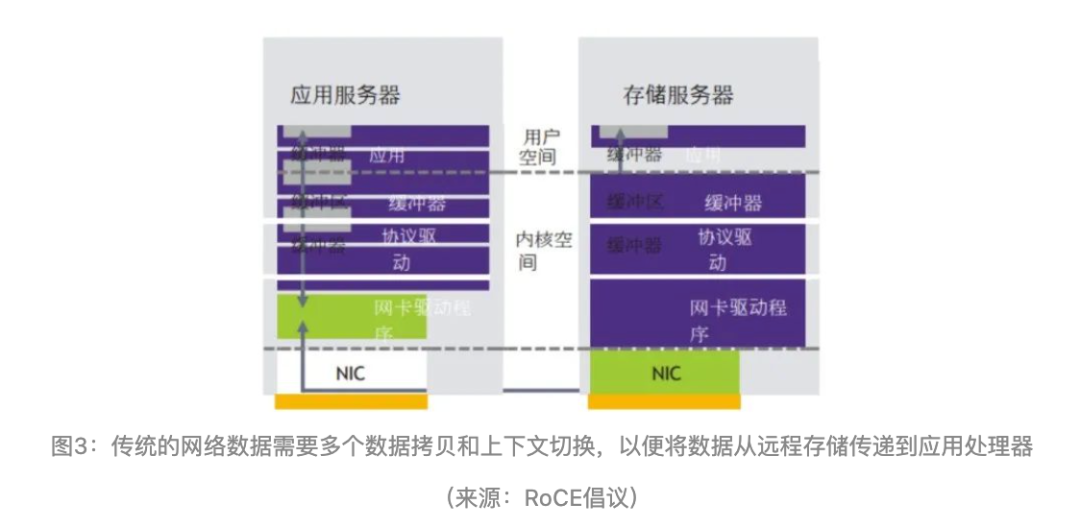

随着数据集规模的增长,在存储设备和计算服务器之间移动数据所需的网络和处理资源也在增加。使用传统的数据网络解决方案从 共享存储到计算服务器应用处理器的数据传输需要几个步骤,如图3所示。

1. 主机应用服务器通过网络堆栈发送一个消息,通知存储服务器所需的数据。

2. 存储服务器处理器将数据从固态硬盘复制到存储服务器用户空间内存的缓冲区。

3. 数据缓冲区从用户空间复制到存储服务器内核空间,供网络接口卡(NIC)驱动程序访问。

4. 网卡驱动程序将数据缓冲区分割成数据包,并通过网络将数据传输到计算服务器的网卡。

5. 计算服务器网卡将数据存储在内核内存中,网络驱动程序将其重新组合并从计算服务器的内核内存复制到用户空间,供应用程序处理。

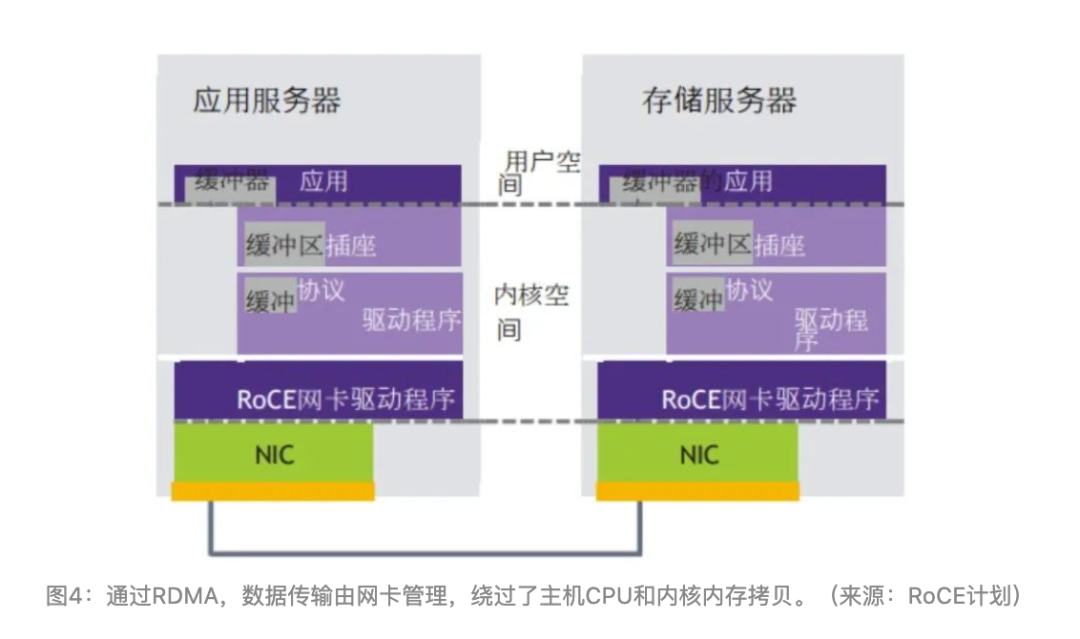

所有这些数据拷贝(以及内核模式《--》用户模式上下文切换)都会消耗存储服务器和计算服务器的大量处理资源。它们还为数据传输操作引入了显著的延迟。 远程直接内存访问,或称RDMA,使各自计算和存储服务器中的网卡能够管理数据传输。不需要上下文切换或中间数据拷贝,两个系统的主机CPU周期都可以释放出来用于应用处理。主机应用处理器建立连接并通知网卡要传输的数据,然后在网卡检索和传输数据时恢复应用处理(图4)。这种简化的数据传输方法不仅减少了主机CPU的处理负荷,而且还可以将数据传输延迟减少一个数量级或更多。应用服务器用户空间存储服务。

随着以太网作为数据中心数据传输结构的几乎普遍部署,一个被称为RDMA over Converged Ethernet(RoCE)的标准被开发出来,用于在以太网上进行RDMA传输。RoCE及其后续的RoCEv2使数据中心运营商能够在其现有的以太网基础设施上利用RDMA的优势。几乎所有先进的网卡都支持RoCEv2,它已经成为RDMA技术的事实标准。RoCE消除了对专用存储区域网络的需求,使数据中心的计算、网络和存储资源能 够部署在一个单一的以太网结构上。

NVMe-oF

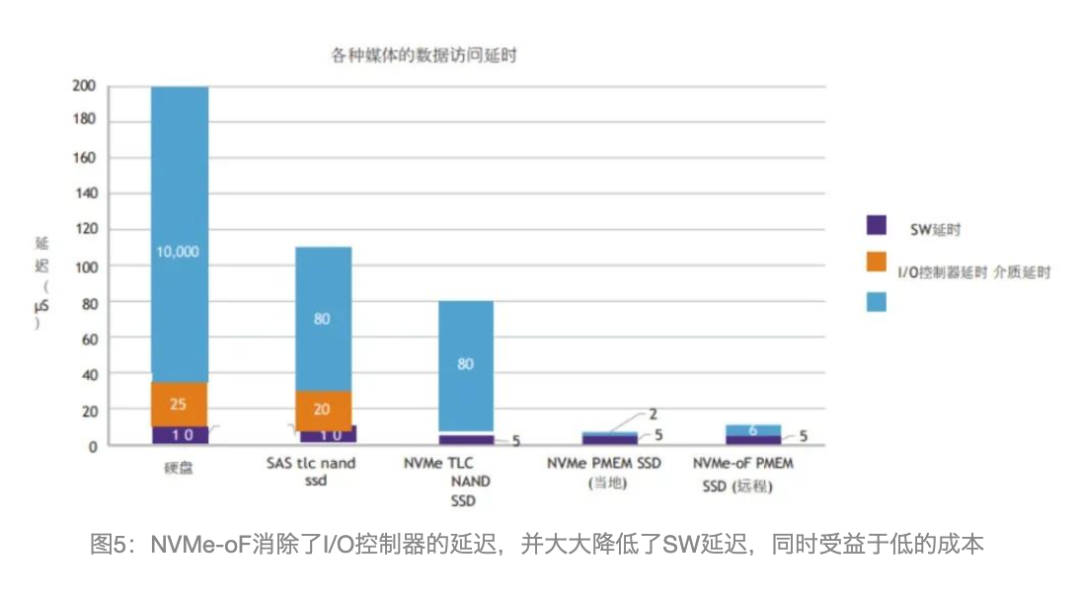

NVMe-oF(Non-Volatile Memory Express over Fabric)将NVMe的低延迟优势扩展到共享存储基础设施。当与低延迟的网络结构(如 RoCE或光纤通道)相结合时,NVMe-oF可以从共享媒体提供数据访问,其延迟可与本地存储相媲美,如图5所示。

计算存储

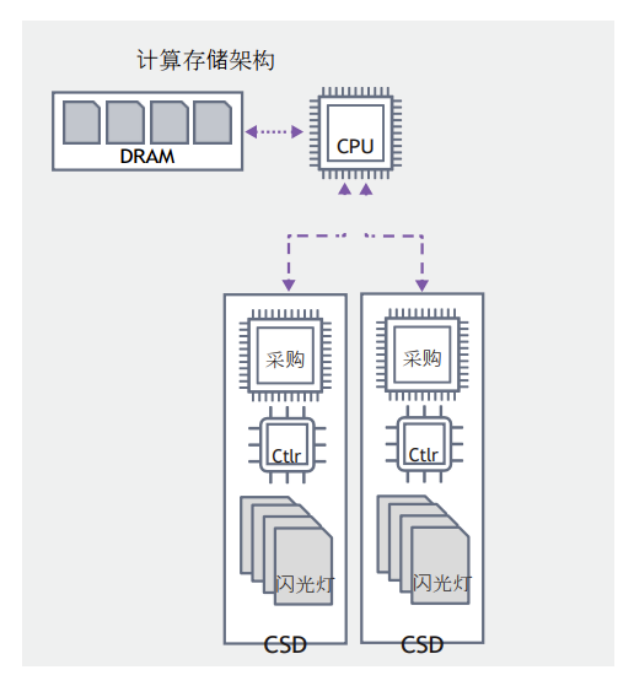

另一个减少系统延迟和更有效地利用数据中心资源的机制是将数据处理能力纳入存储系统。通常被称为计算存储,将一个微处理器放在存储设备中或附近,允许主机应用处理器向存储系统发送特定的参数以返回数据。然后,存储处理器可以在存储设备上搜索相关数据,并只将这些数据返回给计算服务器,如图6所示。

计算存储节省了大量的网络带宽,从应用处理器中卸载了数据处理,并减少了系统的能源消耗。计算存储的另一个有价值的副作用是,大多数数据被保留在存储系统中,因此不容易被拦截或数据被盗,从而提高了数据的安全性。 在传统的计算基础设施中,所有的计算能力都集中在一个中央处理单元中,当一个应用程序需要一个文件中的特定数据时,它必须从存储中加载整个文件,在文件中搜索相关数据,执行必要的数据处理,并返回结果,如图7所示。

存储网络工业协会(SNIA)提出了多种方法来实现计算存储系统。其中一种方法是将一个应用处理器集成到存储设备中,如下图8所示。这个嵌入式微处理器按照主机应用处理器的要求处理数据预处理,以分配工作负荷,提高系统效率。

图8:计算性存储架构,带有嵌入式处理器以提供数据处理和卸载

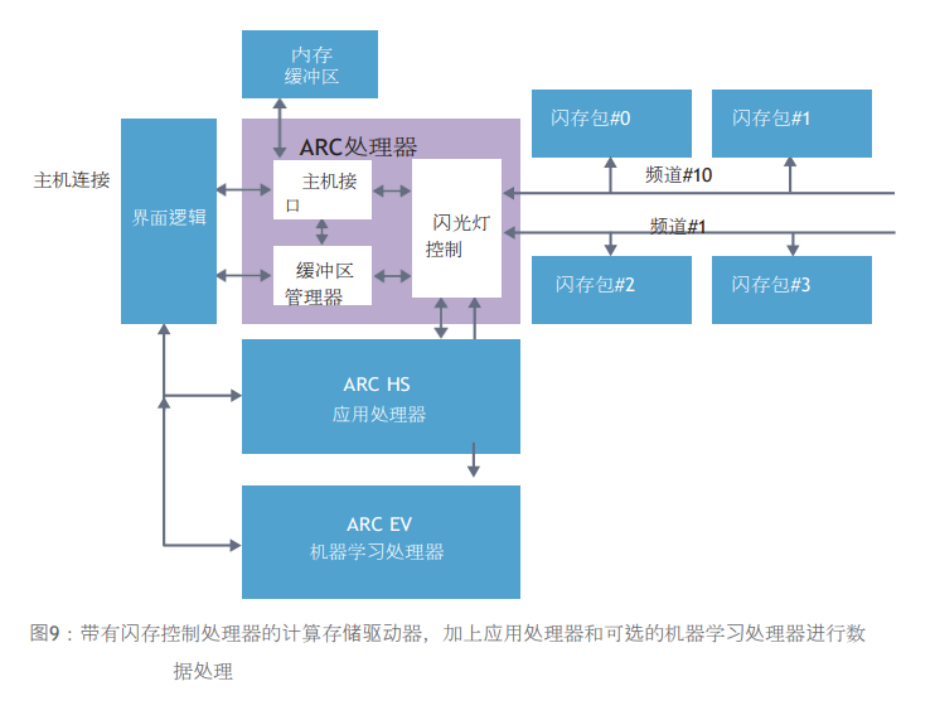

图9更详细地介绍了一个带有闪存控制处理器的计算存储设备,一个用于数据处理的应用处理器,以及一个可以为元数据创建、对象检测和分类以及其他存储加速功能提供神经网络处理的机器学习处理器。

编辑:黄飞

-

网络存储系统可生存性量化评估2010-04-24 2232

-

如何利用FPGA的设计微型数字存储系统?2019-08-01 895

-

什么是云存储?云存储系统的结构是如何构成的?2021-06-02 2841

-

存储系统的层次结构2021-07-29 2086

-

存储系统的层次结构是怎样的?2021-11-02 2215

-

基于FPGA的微型数字存储系统设计2009-11-04 1112

-

基于EVMS的带外虚拟存储系统结构2011-05-18 977

-

基于闪存的图像存储系统设计2016-09-22 675

-

基于单机存储系统故障恢复2018-06-10 1188

-

存储设备类型与存储系统网络构架的详细解析2018-02-05 14590

-

一文详解LeoStor并行存储系统2020-11-16 1946

-

这8个因素会导致HPC存储成本增加2021-02-13 2327

-

当下的HPC存储遇上了哪些挑战2022-03-01 2944

-

计算机存储系统的构成2024-09-26 3836

-

Ceph分布式存储系统解析2025-07-14 807

全部0条评论

快来发表一下你的评论吧 !