2PFLOPS,存算一体迎来新的卷王

2PFLOPS,存算一体迎来新的卷王

描述

存算一体技术作为当下内存厂商和不少AI芯片公司都在全力钻研的方向,已经有了不少成果展示,下一代智能存储的产品均已呼之欲出了。但新技术的新生期就是这样,不断有新的初创企业冒头,不断有新的架构和路线面世,而今年的Hot Chips 34上,就有这么两个存算一体技术的分享,在现有的存算一体生态上做出了创新,再度为这条赛道上的激烈竞争添油加醋。

1PB/s带宽的千核RISC-V AI推理加速器

存算一体技术需要解决的,往往都是AI运算上的问题,比如训练和推理等等,所以不少做存算一体公司与AI芯片公司并无二致。而AI推理的出现为芯片设计者提出了三大关键挑战,一是不断提升的算力和功耗要求,不说是存算一体芯片了,GPU、FPGA、ASIC等AI加速器都在往这个方向卷;二是神经网络的格局一直在变化,现有的芯片可能缺乏跟上节奏的扩展性和灵活性;第三则是推理精度的缺失,在某些业务中精度的缺失可能只是意味着亏损,但在ADAS这样的应用中,就很有可能危及人身安全。

加拿大本土AI初创公司Untether AI就打算从计算的角度来解决AI推理问题,早在2020年他们就推出了runAI200这款加速器芯片,不过该芯片基于台积电16nm工艺,集成了200MB的SRAM,算力最高也只有500 TOPS(INT8),显然不能满足高性能的AI推理需求,但他们的思路却从一开始就和其他存算一体公司不同。

我们常见的存算一体技术无疑就是近存计算和存内计算这两种,前者基于冯诺依曼架构,主要还是完成加快数据转移的过程,后者通过模拟技术来完成乘法累加运算,再利用数字处理器来完成其他运算。

Untether AI却提出了存间计算(At-Memory Computation),将双向的计算逻辑单元放在SRAM之间。如此一来不仅能提供大规模并行却又简短的直接连接,也能提供独立优化过的内存,提升效率和带宽,根据Untether AI所说,存间计算恰好能够解决AI加速的痛点。

1PB/s带宽的千核RISC-V AI推理加速器

存算一体技术需要解决的,往往都是AI运算上的问题,比如训练和推理等等,所以不少做存算一体公司与AI芯片公司并无二致。而AI推理的出现为芯片设计者提出了三大关键挑战,一是不断提升的算力和功耗要求,不说是存算一体芯片了,GPU、FPGA、ASIC等AI加速器都在往这个方向卷;二是神经网络的格局一直在变化,现有的芯片可能缺乏跟上节奏的扩展性和灵活性;第三则是推理精度的缺失,在某些业务中精度的缺失可能只是意味着亏损,但在ADAS这样的应用中,就很有可能危及人身安全。

加拿大本土AI初创公司Untether AI就打算从计算的角度来解决AI推理问题,早在2020年他们就推出了runAI200这款加速器芯片,不过该芯片基于台积电16nm工艺,集成了200MB的SRAM,算力最高也只有500 TOPS(INT8),显然不能满足高性能的AI推理需求,但他们的思路却从一开始就和其他存算一体公司不同。

我们常见的存算一体技术无疑就是近存计算和存内计算这两种,前者基于冯诺依曼架构,主要还是完成加快数据转移的过程,后者通过模拟技术来完成乘法累加运算,再利用数字处理器来完成其他运算。

Untether AI却提出了存间计算(At-Memory Computation),将双向的计算逻辑单元放在SRAM之间。如此一来不仅能提供大规模并行却又简短的直接连接,也能提供独立优化过的内存,提升效率和带宽,根据Untether AI所说,存间计算恰好能够解决AI加速的痛点。

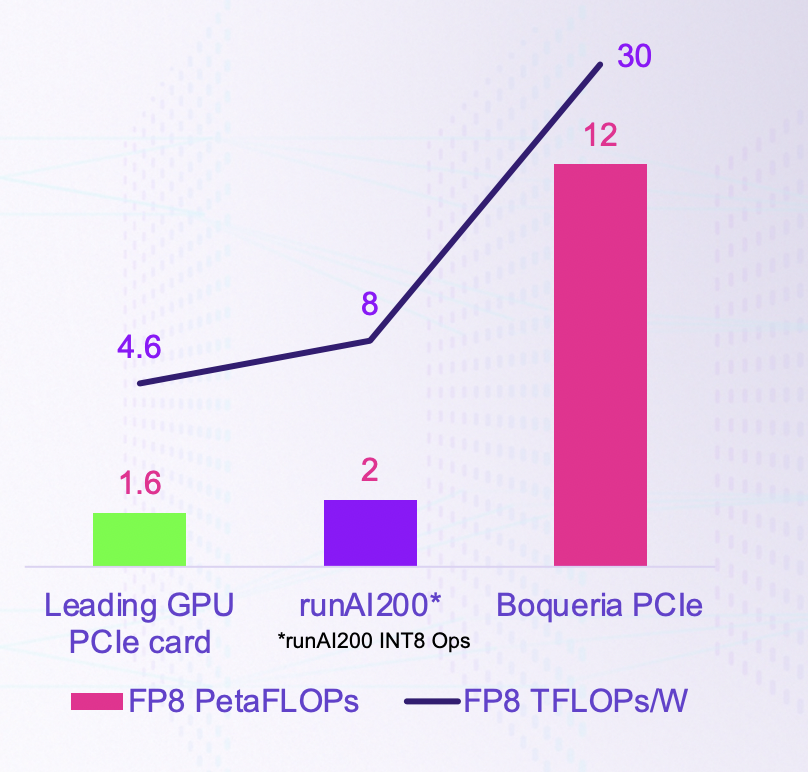

Boqueria与竞品的对比 / Untether AI

为此,Untether AI推出了Boqueria,一个算力高达2PFLOPS、能效比高达30TFLOPS/W的存间计算AI推理加速器芯片。Boqueria基于台积电7nm打造,频率高达1.35GHz,集成了729个存储体、238MB的片上SRAM和1458个RISC-V核心,SRAM内存带宽可以达到1PB/s。

每个存储体中包含2个RISC-V核心,各管理4个行控制器。行控制器之间独立运行,每个行控制器控制64个SIMD处理单元,用于完成矩阵向量乘法运算。这些处理单元支持INT4、INT8、FP8和BF16这四种常见数据格式,而且依Untether AI看来,FP8是精度、吞吐量和能效平衡上最好的一个,更不用说Untether AI在处理单元上加入了零检测,进一步拉高了能效比。

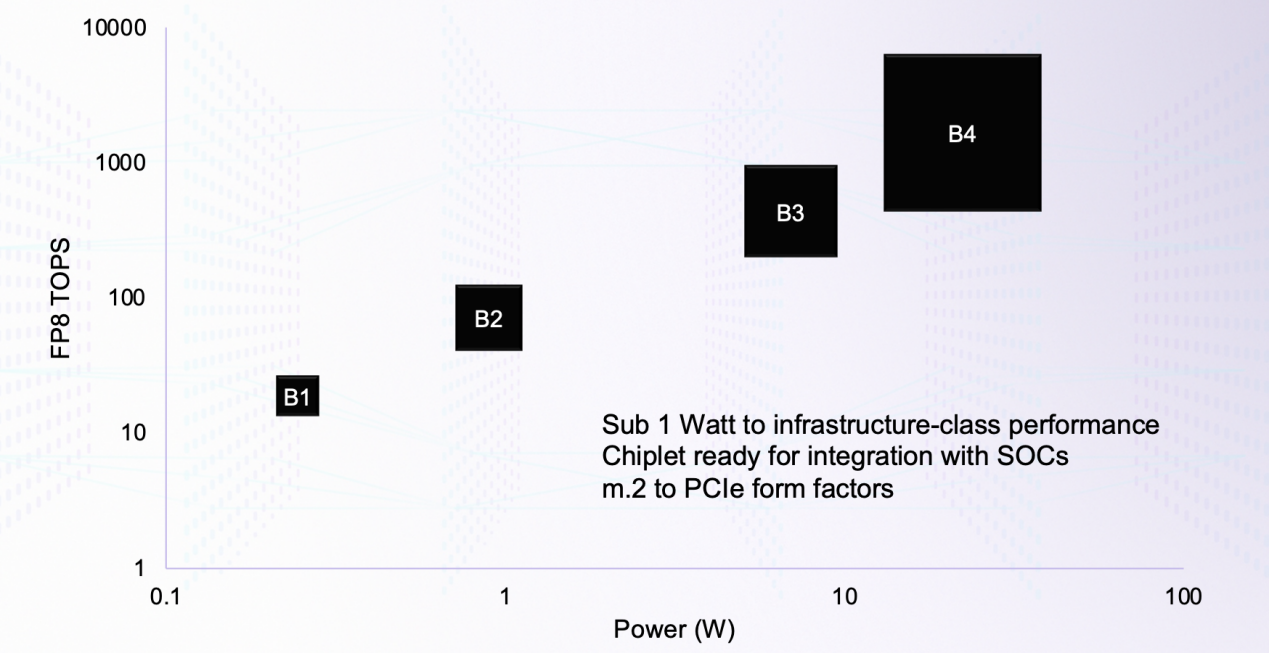

Boqueria架构不同规模下的功耗与算力对比 / Untether AI

Boqueria上的RISC-V核心由Untether AI自己客制化的,本身基于RV32EMC指令集的同时,还加入了20多条专用于存间计算和推理加速的指令。Boqueria的另一大优势,就是它极具扩展性的架构。最小的结构可以做到1W以下,也可以将其做成Chiplet集成在其他SoC中,或者是再大一点的M.2卡、PCIe 5.0卡等。要想追求最高的性能,可以做成集成6个Boqueria芯片的PCIe 5.0卡,SRAM容量可达1.4GB,LPDDR5 DRAM容量可达192GB,FP8算力可达12PFLOPS,更不用说除了芯片到芯片之间的通信外,Boqueria也支持PCIe卡之间的通信。

神经形态存内计算处理器

韩国科学技术院的研究团队在本届Hot Chips上展示了一种新型的存算一体处理器,结合了时下两大新技术,神经形态和存内计算。传统的存内计算处理器由于在矩阵乘法上的优势,可以为深度学习解决最大的计算问题。可这个计算结果的准确性很大程度取决于处理器上DAC和ADC的精度。

可DAC和ADC的精度越高,模拟计算的结果也就越精确,也使得处理器的硬件开销变高,无论是功耗还是面积都是如此,甚至有可能抵消存内计算原本的硬件优势。在整个处理器的功耗中,高精度的ADC甚至可能会占据一半以上的功耗,甚至超过驱动器和控制器的总和。

不仅如此,在真实应用中由于低稀疏度,其能效比也远不如纸面数据那么理想,比如面对CIFAR-10或ImageNet等数据集时,其能效比甚至可能会缩水到十分之一,彻底毁掉了存内计算处理器在算力和能耗上的双重优势。

于是韩国科学技术院团队考虑用二进制脉冲信号的事件驱动运算来生成输入稀疏,并将卷积神经网络转换成脉冲神经网络,从而剔除ADC/DAC,并引入了四大特性。比如用最高有效位Word Skipping和早停法来减少位线活动,从而降低各种模式下的功耗,并用混合模式的神经元放电和电压折叠技术,将该处理器的动态电压范围提高至3倍。

传统存内计算架构与神经形态存内计算架构对比 / 韩国科学技术院

如此一来,他们打造出了一个高能效的神经形态存内计算架构,存内计算减少内存访问和多字线驱动的优势依然保留,但脉冲神经网络的加入,却消除了高精度ADC的需求。他们根据这一架构打造出了一个基于28nm工艺的存内计算芯片,总存储大小只有32KB,频率也只有200MHz,却可以在100到200mW的系统功耗下,实现最高310.4 TOPS/W的高能效比。考虑到这一研究本身也是由三星赞助,这一思路未来很有可能被用于三星的MRAM存内计算芯片中去,届时才会考虑使用更优的工艺来实现更高的性能,并做到更大的容量。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

存算一体技术发展现状和未来趋势电子发烧友网官方 2023-04-25

-

文献调研——存算一体的一些基础知识 精选资料分享2021-07-23 1556

-

知存科技:多款存算一体芯片已批量试产2020-12-02 6560

-

存算一体大算力AI芯片将逐渐走向落地应用2022-05-31 6042

-

比存算一体更进一步,“感存算一体化”前景如何?2022-06-08 6978

-

存算一体技术路线如何选2022-06-21 5821

-

存算一体芯片在可穿戴设备市场有哪些机会2022-10-14 1614

-

2023年存算一体是芯片设计的技术趋势2023-01-13 3008

-

关于存算一体,我们和ChatGPT聊了聊2023-02-09 2547

-

特斯拉的下一代AI芯片:存算一体2023-03-09 3069

-

ChatGPT开启大模型“军备赛”,存算一体开启算力新篇章2023-07-06 726

-

存算一体芯片的技术壁垒2023-09-22 1987

-

存算一体芯片新突破!清华大学研制出首颗存算一体芯片2023-10-11 1765

-

存算一体行业2024年回顾与2025年展望2025-01-23 1695

-

一文看懂“存算一体”2025-08-18 955

全部0条评论

快来发表一下你的评论吧 !