介绍一款仿真器v2e

电子说

描述

事件相机仿真器模拟事件相机,生成事件数据供不同任务使用。本文简介一款仿真器v2e。

Before v2e

在v2e出现之前,也出现过不少仿真器,从uzh的repo上可以找到

比较出名的一个是2017年的Event Camera Dataset附带的仿真器,其根据最基本的事件生成模型进行仿真。

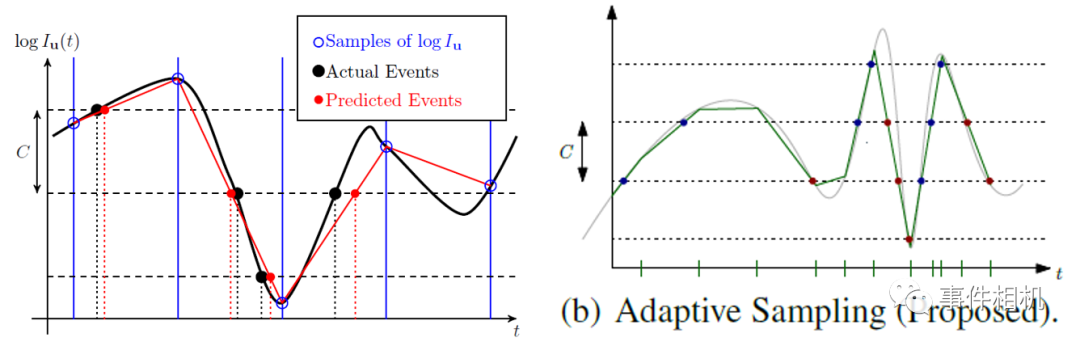

另一个是ESIM,相对于之前的仿真能力强大,仿真技术上的一项改进是将均匀采样改变了自适应采样,使光强变化更快的时候时间采样率更高。见下图右。

左图:[1]的采样原理;[2]ESIM的自适应采样

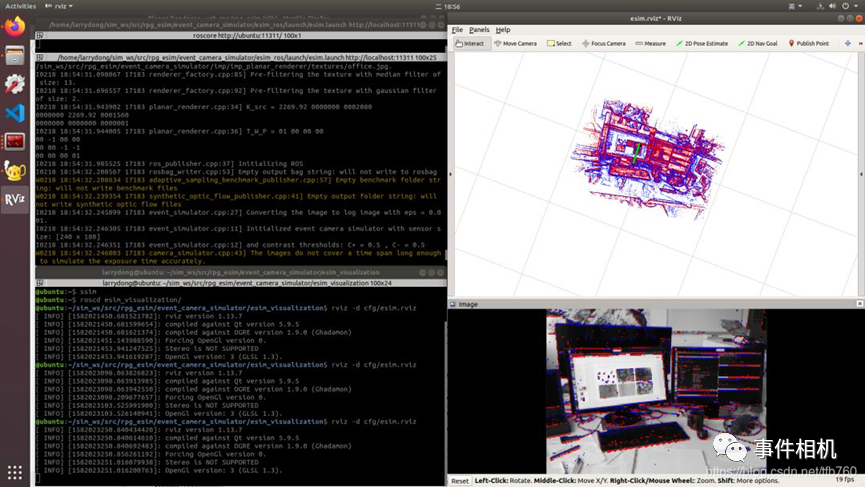

同时,ESIM由于可以自行设置图片或3D场景进行自定义的相机运动,可以获取包括普通图像、深度图等信息在内的数据,广泛的应用于SLAM、光流估计等任务。可以在ROS运行,使用较为方便。

图:ESIM配置后的和运行结果

About v2e

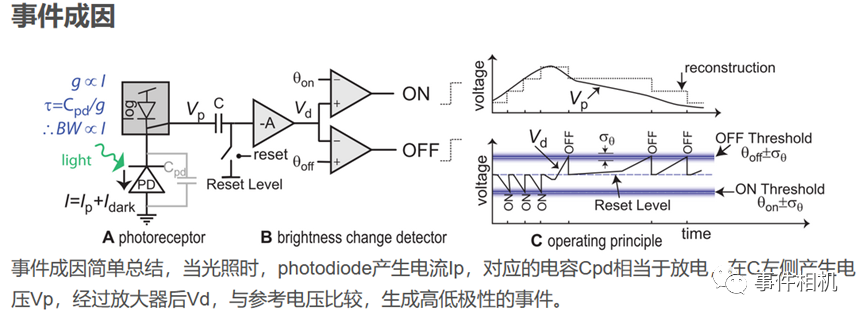

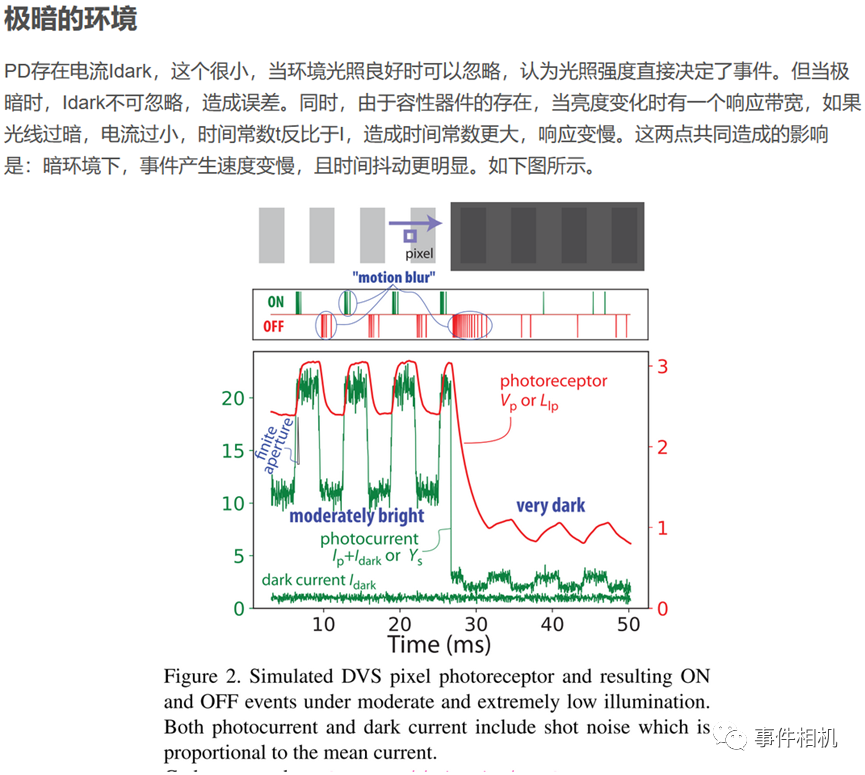

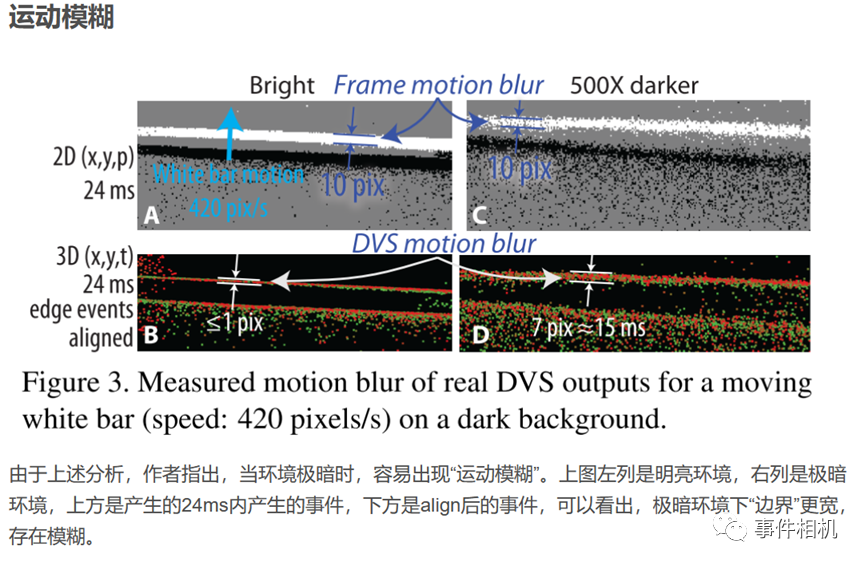

最后出现了本文的重点v2e[3]。在ESIM和vid2e中,生成机制是事件生成模型,考虑了噪声和对比度阈值的影响,但与实际具有较大差距。v2e相比于前者,增加了更多的功能:暗光仿真、运动模糊、时间延迟等。(以下内容来自本人之前的博客,直接进行了搬运。博客连接点击文末“获取原文”)

v2e的安装与使用(windows)

v2e的完整安装可参考github的repo

本人在windows11 RTX3050笔记本上进行了安装测试,进行整理如下:

1. 安装环境

首先需要安装v2e的运行环境,推荐采用conda安装python3.9的虚拟环境。

之后官方说需要有GPU和CUDA加速,我不清楚没有GPU是否可以,但我觉得哪怕可以仿真也会非常慢,不能忍受,所以还是需要有GPU;

最后安装v2e依赖项:下载v2e后采用pip进行安装依赖项。

2. 数据准备

v2e采用SuperSloMo网络首先对原始视频进行慢放,所以需要下载SuperSloMo的模型,并创建一个input路径将模型放在input路径下备用;

之后需要放待仿真的数据,v2e可以对视频进行仿真,也可以对一组图片进行仿真,只需要给定的是视频文件路径或图片文件夹路径即可自动选择。

3. 运行与参数选择

v2e的参数极其多,毕竟仿真的功能很多,包括DVS的参数(时间戳/像素分辨率、噪声水平、对比度阈值、截止频率等)、SuperSloMo的参数、输入输出参数(可以输出视频、文本、hdf5、aedat等多种格式)等,详见v2e的repo。

运行时只需要在cmd进入虚拟环境后执行一行代码即可。

v2e仿真DVS数据输出视频

针对上面的视频,原视频6s,分辨率设置为346x260,其他参数采用默认配置,仿真时间约3-5分钟(RTX3050)。

4. 使用感受:

v2e的内容虽然非常复杂,但是使用起来较为简单,只需要按照文档把参数设置好就可,而且如果遇到错误在运行时给出的报错信息也非常完整,基本可以根据报错信息快速定位问题原因并解决。

后记

我配置过ESIM和v2e,感觉v2e虽然功能复杂,但使用起来更为方便,开发的较为完善,而ESIM配置过程中印象里踩了不少的坑。v2e的另一个好处就是可以windows下使用,对ubuntu和ros不熟悉的朋友更加友好。当然,最重要的是,v2e的仿真更加科学、真实。所以如果有仿真需求的朋友,可以考虑直接用v2e。

审核编辑:刘清

-

xds100v3仿真器引脚定义2024-01-05 8661

-

如何构建一款先进的数字仿真器2023-07-08 998

-

E1/E20仿真器、E2仿真器用户手册附加文档(RH850/F1H和RH850/F1M连接注意事项)2023-07-04 571

-

QB-V850ERS2在线仿真器2023-05-04 385

-

解码国产EDA数字仿真器系列之一 | 从零到一 如何构建一款先进的数字仿真器2023-03-21 1391

-

E1/E20仿真器、E2仿真器用户手册附加文件(RH850/E1M-S2连接注意事项)2023-03-13 638

-

XDS100V2仿真器驱动2021-11-25 2509

-

米尔科技ULINKplus仿真器介绍2019-11-15 2750

-

Terminator:一款一个窗口包含多个终端的 Linux 终端仿真器2016-10-23 3855

-

E2000仿真器软件2008-12-27 780

全部0条评论

快来发表一下你的评论吧 !