一文详解东数西算下绿色数据中心节能减排十大技术、八大趋势

电子说

描述

ODCC | 数据中心 | 东数西算

高效冷却 | 绿色数据 | 智算中心

随着深度学习、生命科学、数字孪生、算力融合、遥感测绘、航天行业、东数西算的快速发展,人们对数据中心的建设要求越来越高。昨日,2022 ODCC开放数据中心峰会成功召开,大会聚集广大数据中心研究者一起讨论交流。

ODCC 2022开放数据中峰会亮点

信通院发展司副司长陈家春在致辞中表示,在各界共同努力下,我国算力基础设施持续夯实、算力产业链持续完善、算力基础设施能效稳中向好。在算力产业发展方面提出了要进一步加快算力基础设施建设、推动产业技术创新、推进产业绿色低碳发展、深化产业协同开放合作四点建议,推动算力产业高质量发展,支撑经济社会数字化转型。

信通院发展司司长闻库在致辞中指出,当前我国数据中心产业已形成“政府高度重视、业界积极推进”的良好局面,为满足不断变化的业务需求,期望开放数据中心标准推进委员会从完善标准体系建设、加强关键技术研究、扩大产业融合三方面努力,推动数据中心充分发挥对数字经济社会发展的支撑作用。

信通院院长余晓晖在致辞中总结了我国算力和数据中心产业的重要性及发展态势,提出当前数据中心发展要重点考虑算力优化配置、产业技术创新、绿色低碳等三个方向,中国信通院将继续推进前瞻性系统性和针对性研究,持续助力政策落地实施,促进我国数据中心算力和数据中心产业向更高水平发展。

此外,峰会上发布了ODCC 2022年55项系列研究成果,覆盖服务器、数据中心设施、网络、边缘计算、新技术与测试、智能监控与管理以及安全等领域。在光辉时刻环节,大会公布了DC-Tech数据中心低碳等级、绿色等级、算力等级、服务能力等级、可靠性等级、智能化运营等级、智能运维机器人、算力强基行动评估结果,及ODCC2022“闪耀之选”“匠心之作”“非凡之星”“精诚之助”等荣誉。

绿色数据中心高效冷却及配套产品

一、高弹性冷却技术

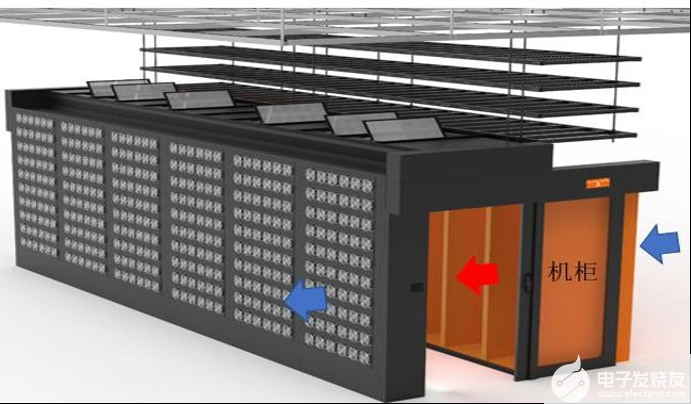

通过定制空调盘管墙和风扇墙置于服务器机柜后部,根据需求统一制冷、控制,通过创新的气流组织减少风阻和局部热点,使得制冷效率大幅提升。适用于新建和改造的数据中心。华东地区某数据中心采用阿里云计算有限公司的产品作为机房散热方案,能耗较传统冷冻水精密空调降低70%,从而提高IT产出4%。预计未来5年市场占有率可达到20%。

高弹性冷却技术

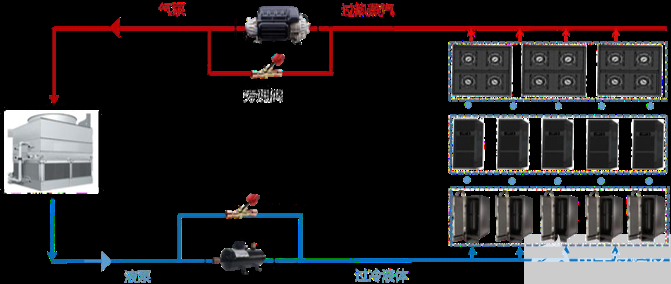

二、“冰川”相变冷却系统

以气泵、液泵、蒸发冷凝器和并联末端为硬件基础,加以AI智能控制,灵活满足数据中心的制冷需求。适用于新建和改造的数据中心。年均制冷负载系数(CLF)可达0.035,单机柜最大支持功率可达30千瓦以上。河北保定某云计算数据中心使用北京百度网讯科技有限公司产品,为200个功率密度10千瓦的机柜提供制冷,“冰川”相变冷却系统具体配置为6+1,单系统的制冷量为350千瓦。制冷部分年节电272万千瓦时。预计未来3年市场占有率可达到30%~40%。

“冰川”相变冷却系统

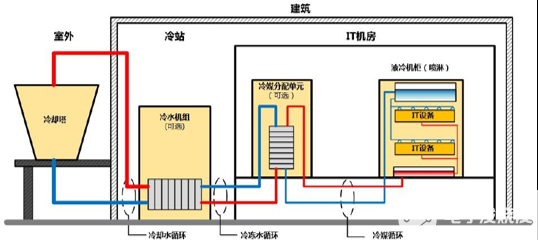

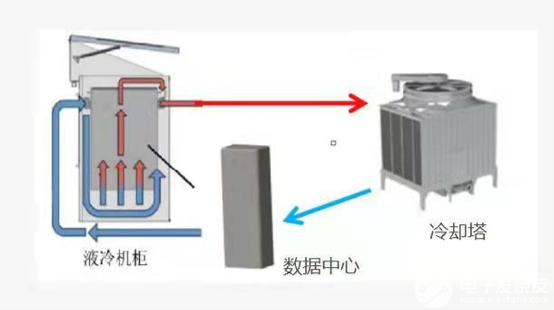

三、喷淋液冷系统

通过将低温冷却液送入服务器精准喷淋芯片等发热单元带走热量,冷却液返回液冷冷却液分配单元(CDU)与冷却水换热处理为低温冷却液后再次进入服务器喷淋,冷却液全程无相变。液冷CDU的冷却水由冷却塔和冷水机组提供。适用于新建和改造的数据中心。数据中心满载运行时,电能使用效率(PUE)值低至1.07,全年平均PUE值处于1.1以下,节电率达50%以上,单体机架功率集成可达50千瓦以上。上海某数据中心使用广东合一新材料研究院有限公司产品,配备12个机架,每机架额定功率32千瓦,总功率384千瓦,采用喷淋液冷技术,年节电196.22万千瓦时。预计未来5年市场占有率可达到10%。

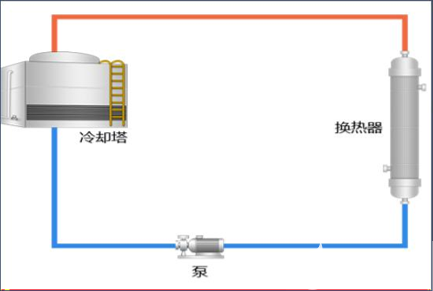

喷淋液冷系统工作原理图

四、节能节水型冷却塔技术

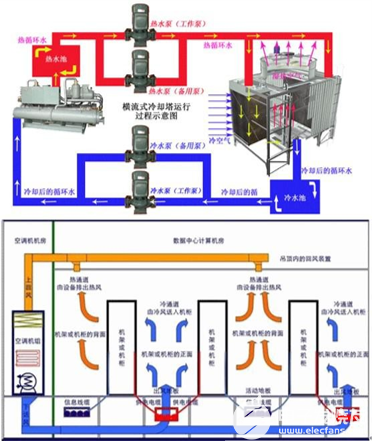

在传统横流式冷却塔的基础上,应用低气水比技术路线,降低冷却塔耗能比,同时减少漂水。适用于新建和改造的数据中心,缺水地区不适宜使用。耗电比在0.030千瓦/(立方米/小时)以下,漂水率小于0.010%。某数据中心使用湖南元亨科技股份有限公司产品,配置4台冷却水量800立方米/小时的元亨节能节水冷却塔,年节电26.1万千瓦时,节水1.1万吨。预计未来5年市场规模将增长至8亿元/年。

节能节水型冷却塔技术

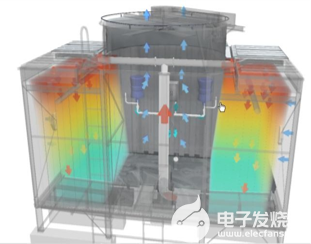

五、浸入式散热数据中心

由密封的液冷机柜、内部循环模组、换热冷却设备、内外控制设备等组成。IT设备完全浸没在单相导热液中,通过单相导热液直接对发热元件进行热交换,升温的导热液再通过外部驱动系统进行二次热交换,冷却后回流到机柜内部,达到控温效果。某数据中心购买兰洋(宁波)科技有限公司10台浸入式散热数据中心产品,并定制无须散热硬件的服务器,该数据中心IT设备负载约500千瓦,使用后,年节电341.65万千瓦时。预计未来5年市场占有率可达到60%。

浸入式散热数据中心

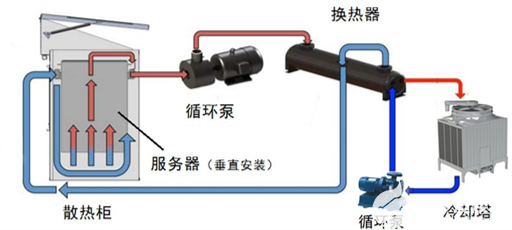

六、数据中心用DLC浸没式液冷技术

通过将IT设备浸没在冷却液里并直接将热量传递给冷却液,冷却液吸收热量后通过液冷主机与水循环系统换热,水循环系统将热量带到外部换热设备(如冷却塔、空冷器等)并散发到空气中,即完成一次液冷系统的散热循环。适用于新建和改造的数据中心。数据中心使用浸没式液冷技术,平均PUE值可达到1.1。上海某数据中心使用深圳绿色云图科技有限公司的直接浸没式液冷产品,部署了504个机柜,单个机柜功率为11千瓦,年节电728.6万千瓦时。预计未来5年市场占有率可达到8%。

数据中心用DLC浸没式液冷技术

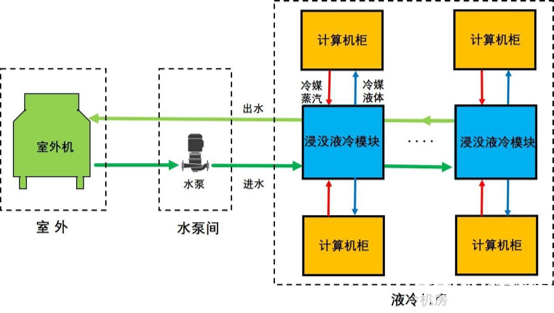

七、数据中心高效液冷技术及其基础设施产品

数据中心高效液冷技术及其基础设施产品通过采用浸没式相变液冷技术,对传统风冷数据中心进行系统化变革,节省原冷却系统约80%的能耗,PUE<1.2,单机柜部署密度>100千瓦,可从冷却性能、功耗、环境效益等综合效能方面加快推进数据中心绿色生态化建设步伐。适用于新建和节能改造的数据中心。北京某中心采用曙光数据基础设施创新技术(北京)股份有限公司产品的88套“1拖2”液冷相变计算单元后,机房配电容量28兆伏安,机房面积仅800平方米,整体系统仅冷却部分年节电0.5亿千瓦时。预计未来5年市场占有率可达到50%。

数据中心高效液冷技术及其基础设施产品

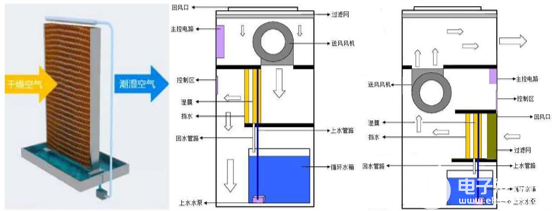

八、机房湿膜加(除)湿技术

机房湿膜加(除)湿技术的加湿方式为机房干热空气通过湿膜时,被加湿、降温和净化,除湿方式为输送机房相对湿润的空气通过换热器冷凝除湿。智能控制器实现对湿度的控制。与传统红外加湿和电极加湿技术相比,湿膜加(除)湿机节能率可达90%以上。适用于新建和改造的数据中心。浙江某数据中心使用四川斯普信信息技术有限公司产品后,年节电158.9万千瓦时。预计未来5年实现推广量10000台。

机房湿膜加(除)湿技术

九、数据中心循环冷却水节能技术

数据中心循环冷却水系统节能技术是应用智慧算法控制冷却水水质和系统运行参数,通过降低冷却水供水水温和制冷机趋近温度的方式,降低制冷机的制冷单位能耗。适用于新建和改造的数据中心,降低整站能耗5%~10%左右。某数据中心,使用天津鲲飞环保科技有限公司产品,年节电132.17万千瓦时,年节水830吨。预计未来3年市场占有率可达到20%。

数据中心循环冷却水节能技术

十、数据中心冷却用高效通风机

数据中心冷却用高效通风机采用优化叶片,整体优化流场同时电机速度可控效率高,在宽载荷、宽转速范围内保持高效低耗,适用于新建和改造的数据中心,适用信息设备负载率范围为25%~100%。北京某数据中心使用威海克莱特菲尔风机股份有限公司产品进行改造,目前已运行5年,安全可靠无故障,单台风机年节电约7200千瓦时。预计未来5年市场占有率可达到30%以上。

数据中心冷却用高效通风机

高效系统集成及高效IT 技术产品

一、整机柜服务器

采用48伏供电方案和双输入电源模块架构、虹吸散热技术、标准化设计并独立机柜监控单元(RMC)。IT部分采用池化设计,计算节点和存储节点分离设计,易于扩展。某数据中心使用北京百度网讯科技有限公司整机柜服务器产品,共采用20多个机柜,300多个服务器。单节点实现功耗节省18瓦以上,单节点供电部分年节电157千瓦时。预计应用10万节点以上。

二、全介质多场景大数据存算一体机

采用基于模块化转笼式光盘库设计技术、单次多光盘快速抓取装置设计技术等,实现数据存储的安全和节能。适用于新建和改造的数据中心。某信息中心使用北京中科开迪软件有限公司产品,自2018年9月项目交付至今,系统保持无故障运行,设计蓝光存储规模1PB,用于归档等冷数据存储。采用蓝光存储相比磁盘存储,年节电2万千瓦时,节电80%以上。预计未来5年市场占有率可达到70%。

原理结构拆分图

三、预制式微模块数据中心技术

预制式微模块数据中心技术包含L0+L1融合预制方案和L1预制方案。L0+L1融合预制方案将模块化数据中心与装配式建筑相结合,工程产品化,可6个月完成1000柜业务上线(不含设计时间)。L1智能微模块数据中心方案集IT机柜、制冷系统、供配电系统、监控系统、照明、布线、安防系统等于一体,集成人脸识别等一系列智能特性。某北方数据中心采用华为技术有限公司提供的1100个L0+L1融合预制模块,实际运行年均PUE达到1.15,年节电6339万千瓦时。预计未来5年市场占有率可达到35%。

四、模块化数据中心(微模块)

基于能效管理技术、冷电联动节能技术、智能化运维管理技术等,降低制冷系统能耗及供配电系统损耗,实现实时智能自动化调优,减少运维工程师干预,降低数据中心运行维护成本,最高可节省超过30%的运营费用。广州某数据中心项目使用科华数据股份有限公司的数据微模块产品,启用120套微模块,微模块电能使用效率(PUE)≤1.23,年可节省电费8916.8万元。预计未来5年市场占有率可达到15%以上。

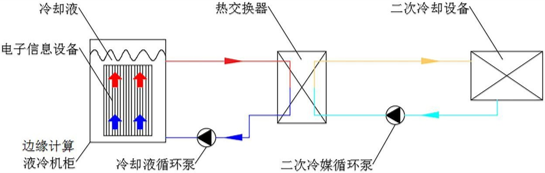

五、微型液冷边缘计算数据中心

由微型液冷机柜、二次冷却设备、服务器、网络设备、硬件资源管理平台等组成。将不需要风扇的IT设备完全浸没在注满冷却液的液冷机柜中,使热量直接传递给冷却液,再通过小功率变频循环泵驱动,将冷却液循环到板式换热器与冷媒系统换热,冷媒系统将换取的热量带到二次冷却设备,通过风机将热量散发到空气中去。适用于新建和改造的数据中心,PUE值可低至1.1。某融媒公司使用深圳绿色云图科技有限公司的液冷产品,IT设备规模100千瓦,年节电8.76万千瓦时。预计未来5年市场占有率可达到8%。

技术原理图

六、池式模块化数据中心

以整体机房建设为理念,由机柜系统、供配电系统、热管理系统、监控软硬件系统以及气流管理系统组成,机柜系统为强抗震及高静动载能力IT设备柜,供配电系统由UPS、电池及精密配电柜组成,热能管理系统由节能制冷空调系统组成,监控软件系统为成套设备综合软硬件系统,气流管理对气流进行有效遏制,各子系统实现工厂预制,现场快速组装模式。上海某数据中心使用深圳市艾特网能技术有限公司的3个池式模块单元,项目整体年能耗约为250万千瓦时,比其他技术方式年节电200万千瓦时。预计未来3年市场占有率可达到40%。

七、机柜式模块数据中心

机柜式模块化数据中心包含承载及通道封闭系统、不间断电源系统、配电系统、环境管理系统、安全管理系统、监控管理系统、照明及可视化系统。采用标准化、模块化、预制化方式。具有提高数据中心整体运营效率,快速部署、弹性扩展和绿色节能的特点。某省金融网点使用深圳市艾特网能技术有限公司方案配置3~5个全封闭机柜,单台制冷量3.5千瓦机架式变容量空调,有效降低制冷能耗。其中模块内空调全年运行耗电量约占传统机房空调的61%,年节电4802千瓦时。预计未来5年市场占有率可达到19%。

绿色数据中心未来发展的八大趋势

一、低碳化

“碳中和”成当今世界最为紧迫的使命,世界主要经济体陆续做出承诺并付诸行动。其中,欧盟、日本、韩国等提出在 2050 年实现碳中和;中国提出 2030 年前实现碳达峰,2060 年前实现碳中和;印度提出在2070 年实现碳中和。在“碳中和”目标的驱动下,数据中心行业将产生深刻变革,数据中心低碳化成为必然趋势,清洁能源的大规模应用,叠光叠储、余热回收等节碳技术在数据中心应用将普遍化。

二、可持续性发展

可持续发展并不等于低碳或者零碳,广义的可持续发展还需从环境、社会和公司治理(ESG)三个方面综合考量。对数据中心而言,主要体现在对能源、资源的利用效率及对环境影响。在具体的衡量指标上,数据中心将从以往的唯PUE论,向PUE、可再生能源利用率、水资源利用效率(WUE)、碳利用效率(CUE)、空间利用效率(SUE)、市电利用效率(GUE)、材料回收率及全生命周期污染物排放等综合指标转变。

三、高密化

随着芯片、服务器的算力和功耗持续提升,芯片2~3年迭代,未来五年单IT机柜功率密度将从当前的6~8kW向12~15kW演进。同时,未来云数据中心将成为主要场景,预计到2025年占比将超过70%,面对云计算业务带来的数据量和计算量的爆发式增长,在动据中心资源尤其是一线城市资源日趋紧张的情况下,只有通过提高机房单位面积内的算力、存储以及传输能力,才能最大程度发挥数据中心的价值。因此,预计到2025年,单机柜功率密度12~15kW将成为主流。

另一方面,随着AI、超算等技术和应用的发展,自带高密度属性的人工智能计算中心、超算中心等也将迎来建设高湖,推动高密化发展趋势。

四、快速部署

目前,超过一半的云数据中心TTM 为12~18个月,无法匹配“云”的快速响应需求,而数据中心由支撑系统转向生产系统,需要像“云”一样快速上线,实现极致 TTM。

1、业务需求短时爆发要求更快的响应速度

数据中心是重资产投资,对于Colo 行业,大型数据中心先有租户,再建设数据中心成为主流。而互联网业务呈现短时间内快速爆发的特征,如抖音三年内覆盖到全球 155个国家,单个季度最高新增用户数达到1.88亿,这这种情况下,很多租户要求千柜级的数据中心交付周期缩短到1年甚至更短。在这种形式下,传统建设速度,难以匹配业务的发展需求。

2、快速部署需求推动预制化和模块化成为重要选择

传统数据中心建设模式是土建、供电、制冷等系统串行施工,要等上一个环节全部验收后,施工流程才能顺利往下走,同时不同环节由不同的厂商分包,现场“攒机”,导致现场施工单位和施工人员繁杂,现场管理难度大,难以保障建设周期和最终质量。

预制化和模块化是将原本串行的流程变为并行,采用模块化设计将数据中心分解成多个预制化箱体在工厂进行预制组装供配电、制冷等子系统,标准化生产流程,各个模块品质如一,多系统协同设计并在出厂前完成全系统联调和测试,确保高质量和高可靠性。与此同时,项目现场完成园区土建准备,现场只需完成极简施工,大大降低现场管理难度及施工风险,且在施工阶段显著减少建筑垃圾,仅需6~9个月即可完成1000个机柜的数据中心建设。通过标准化的流程,将复杂的工程变成统一的产品,实现云数据中心的可见即可得。

五、全面锂电

储能(电池)是数据中心供电系统的后盾,在电网中断或故障时,能够保证高质量的不间断供电。锂离子电池相对传统铅酸电池,具备寿命长、占地小、承重要求低、智能化程度高、更加环保等特点,因此“锂进铅退”已成为不可逆转的趋势和潮流。

1、锂电渗透率提升,将加速锂电推广进程

电力供给的稳定、安全作为数据中心强需求,往往配备2N甚至更高标准的UPS及电池室,以支撑在断电情况下,至少10分钟甚至更高的持续供电能力。铅酸电池一直以来长期占据数据中心供备电系统的主导地位,但其应用瓶颈曰趋严重,存在能量密度低、占地面积大、使用寿命短、故障定位难等问题。对比传统铅酸电池,锂电池在使用寿命、占地空间和环境耐受等方面优势突出,并且随着锂电在能量密度和安全性能的持续提升,锂电在数据中心的推广应用将加速进行。咨询机构 Frost & Sullivan 分析认为,数据中心锂电将迎来快速增长期,2020 年至2025期间,数据中心锂电应用占比将由15%显著上升至38.5%。

2、锂电储能循环利用能力将发挥重要价值

锂电储能系统相比铅酸电池具备更强的充、放电循环能力,且循环寿命更长。在电网质量恶劣的应用场景,铅酸电池深度循环次数仅数百次,而同样情况下,锂电循环次数高达数千次。随着峰谷电价差的进一步扩大,锂电储能循环利用价值将得到充分体现,不仅数据中心可以通过峰谷电价降低成本,对电网整体来说也具有益处。另外,通过储能削峰可有效提升可再生能源消纳,提升出电率,多部署IT机柜,实现更高的收益。

六、风进水退

在数据中心,除 IT 设备外,制冷系统能耗最大。尽可能利用自然冷源,提升制冷系统能效是重要方向。另外,随着数据中心外溢到新能源富裕地区,水资源更加紧缺,传统的冷冻水制冷系统将被替代,少水的制冷系统将成为主流。

蓝海大脑的液冷服务器 HD210 H系列突破传统风冷散热模式,采用风冷和液冷混合散热模式——服务器内主要热源 CPU 利用液冷冷板进行冷却,其余热源仍采用风冷方式进行冷却。通过这种混合制冷方式,可大幅提升服务器散热效率,同时,降低主要热源 CPU 散热所耗电能,并增强服务器可靠性。经检测,采用液冷服务器配套基础设施解决方案的数据中心年均 PUE 值可降低至 1.2 以下。

1、传统冷冻水系统将被逐步取代

传统冷冻水解决方案在制冷过程中耗水巨大,据统计,中国南方8MW IT 负载的数据中心年耗水量超过6.3 万吨,足够300户居民使用一年。随着国家“东数西算”战略的实施,大量的数据中心将新建在中国北部和西部地区,而这些地区常年缺水,数据中心将从供电难转向供水难,数据中心采用少水,甚至无水的方案已经大势所趋。

同时,冷冻水系统架构复杂,有7大部件,交付周期半年以上,工程复杂,且交付质量与制冷效率强相关,60多个调节参数,运营运维工作量大。

2、以间接蒸发冷却为代表的省水制冷技术将成为主流

在碳中和背景下,低 PUE 成为数据中心建设和运营的刚需。能够自然冷却的温控系统,由于能够充分利用自然冷源而减少能源消耗已经成为行业的主流选择。

间接蒸发冷却系统是自然冷却的代表技术之一,它是通过外界冷风与室内热风在换热芯内的间接式换热,可以在利用自然冷源的条件下,防止外部空气对内部环境的影响。间接蒸发冷却具有三种工作模式:干模式、喷淋模式、混合模式。干模式不需要喷淋,不消耗任何的水资源,只有在喷淋模式和混合模式下,才会利用水的蒸发吸热效应的来降温。在北方缺水地区,常年温度较低,全年大部分时间可以运行在干模式下,可大幅减少耗水。

目前间接蒸发冷却技术,由于省水和省电的特性,已经成为互联网和云计算企业,南北地区统一的主流制冷方案。

七、人工智能和数字化

数据中心规模越来越大,数量越来越多,导致管理复杂度大幅提升,另一方面专业运维人才获取越来越难,因此提升数据中心基础设施的数字化水平成为刚需;在技术侧,随着算力的提升、高清视频以及图片识别技术的发展,使得Al 在数据中心的运用越来越广泛;在碳中和的背景下,数字化和人工智能技术助力数据中心营维管理从聚焦能耗演进到关注碳排,驱动实现全生命周期碳管理,助力碳中和目标的实现。

八、安全可信

数据中心基础设施作为数字底座,是海量数据承载的物理基础,是信息集中处理、计算、存储、传输、交换、管理的核心资源基地。也是当今社会经济正常运转的关键保障,因此安全性是数据中心的生命。而数据中心中基础设施的可靠性、安全性一直是较薄弱的环节,从数据中心解决方案角度来看,需实现系统级、器件级、设备级三层预测性维护,不断提升硬件可靠性和系统韧性。

同时,为了实现对设备的精细化管理和控制,数字技术和工业互联网技术在数据中心关键系统中应用越来越深入,如数据中心管理系统,电池管理系统康测系统,据机器实现了连接,将工业、技术和互联网深度融合,网络的安全可信延伸到工业互联网领域和底层设备。随着数据中心基础设施智能化程度不断提升,随之面临的网络安全威胁成倍增加。根据数据显示,数据中心每次受到攻击平均损失近3000万元。因此数据中心基础设施会更加重视软件安全性、隐私性、可用性等,实施分层级防御,巩固数中心安全可信,硬件可靠性,软件安全性、系统韧性、安全性、隐私性、可用性六个特征,分层级防御,巩固数据中心安全可信。

审核编辑 黄昊宇

-

节能减排,绿色能源2014-03-28 0

-

云数据中心市场的十大趋势2018-12-31 0

-

紧随云数据中心市场节奏 十大趋势值得关注2018-01-17 960

-

面向2025年,揭秘数据中心能源十大趋势2020-02-15 6263

-

绿色数据中心“东数西算”全面启动2022-02-24 1517

-

曙光携手产业伙伴构建数据中心内部节能循环2022-03-18 1432

-

“东数西算”下数据中心高性能计算的六大趋势八大技术2022-05-03 1326

-

数字经济浪潮涌 先进数据中心背后,“东数西算”的三重意志2022-05-17 1752

-

东数西算中的绿色智算数据中心2022-11-03 2903

-

数据中心行业发展的十大趋势2023-02-13 959

-

华为发布2024数据中心能源十大趋势2024-01-15 991

-

华为发布2024数据中心能源十大趋势,引领未来变革2024-01-17 581

-

让数字世界坚定运行 | 华为发布2024数据中心能源十大趋势2024-01-17 575

-

华为与中国能建打造“东数西算”标杆数据中心2024-12-09 233

全部0条评论

快来发表一下你的评论吧 !