NLP中的神经网络设计与学习

描述

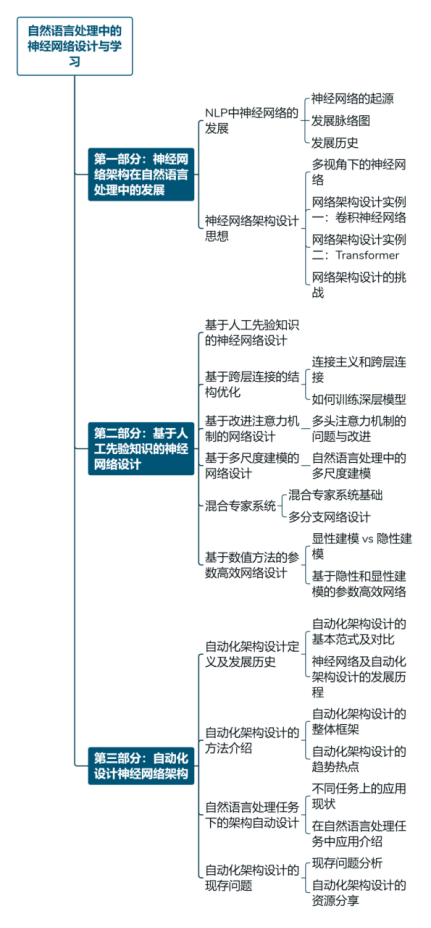

神经网络技术是现代人工智能的关键技术,在自然语言处理、图像处理等领域表现出优异效果。来自东北大学自然语言处理实验室、小牛翻译团队的肖桐教授、博士生李垠桥、李北在CCMT 2022会议所进行的《自然语言处理中的神经网络设计与学习》演讲报告,从神经网络架构在自然语言处理中的发展、人工神经网络设计和自动化架构设计三个方面对该领域技术发展进行了全面梳理,同时也对方向的未来发展进行了分析和探讨。

近些年来,人工神经网络方法已经成为了自然语言处理中最重要的范式之一。但是,大量依赖人工设计的神经网络结构,导致自然语言处理领域的发展很大程度依赖于神经网络结构上的突破。由于神经网络结构设计大多源自研究人员的灵感和大量经验性尝试,如何挖掘这些神经网络结构背后的逻辑,如何系统化的思考不同神经网络结构之间的内在联系,是使用这类方法时所需要深入考虑并回答的问题。甚至,可以想象,让计算机自动设计神经网络架构,也可以成为进一步突破人类思维限制的方向之一。

在《自然语言处理中的神经网络设计与学习》中,讲者们根据自身研究经验对上述问题进行了回答,对神经网络架构的基本发展脉络、常用的神经网络架构的设计理念进行分析,同时对神经网络架构的自动设计方法进行整理。这些内容可以为相关研究者供模型架构设计上的一些思路,以及实践中的参考。同时,讲者在分享中也呼吁研究者更多地以系统化的思考方式来看待神经网络方法在自然语言处理中的应用,而非简单像“黑盒”一样使用它们。

第一部分:神经网络架构在自然语言处理中的发展

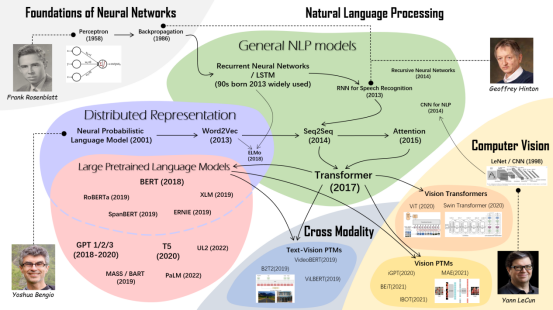

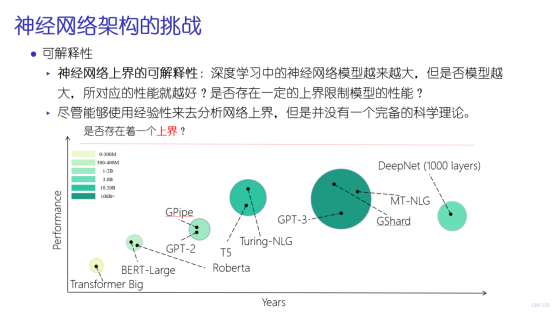

报告的第一部分内容由小牛翻译联合创始人、东北大学计算机学院博士生导师肖桐教授讲述。首先回顾了自然语言处理中神经网络的发展,从上世纪五十年代的感知机开始到如今的预训练模型,为自然语言处理领域神经网络的发展构建了一张脉络图。并以该图为主线,梳理了自然语言处理领域里程碑级别的神经网络模型及其影响,包括NNLM、Word2Vec、RNN、Seq2Seq、Attention、Transformer、预训练模型等重要工作。接下来,以神经网络架构设计思想为核心,介绍了从不同学科的视角看神经网络,并以卷积神经网络和Transformer作实例探讨了隐藏在复杂模型背后的神经网络设计灵感来源,包括卷积神经网络与人类视觉系统感受野的关系、Transformer位置编码和自注意力机制设计灵感来源。最后,列举了设计神经网络架构面临的四个挑战。

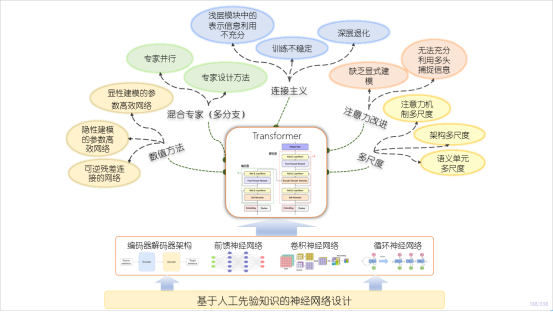

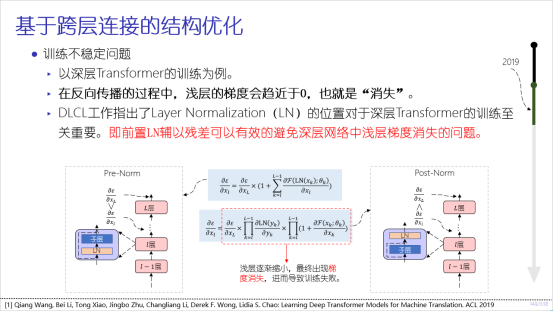

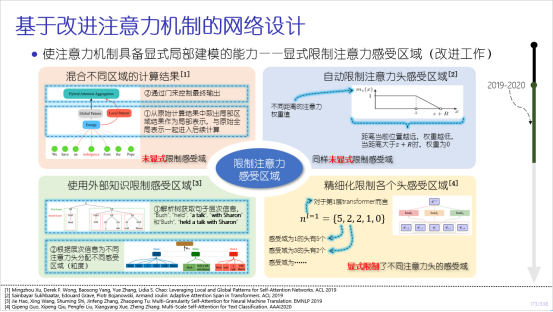

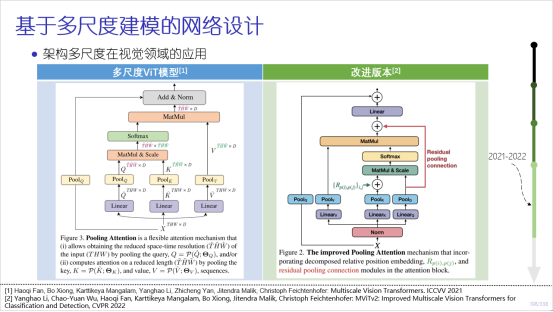

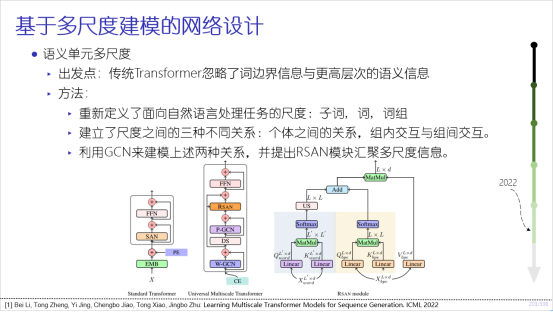

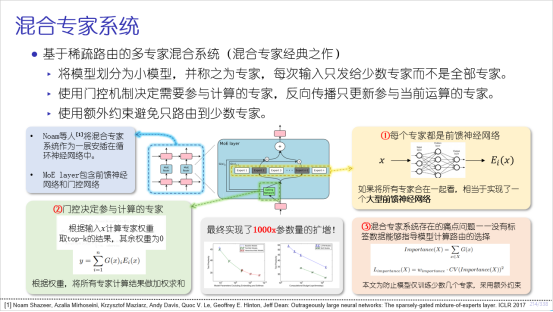

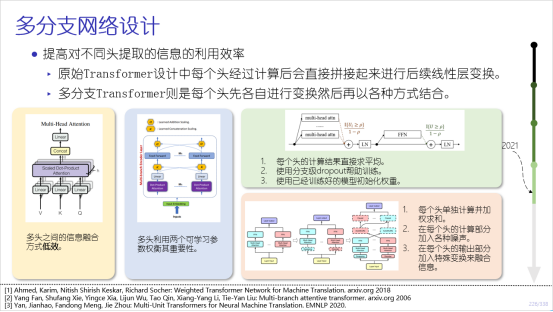

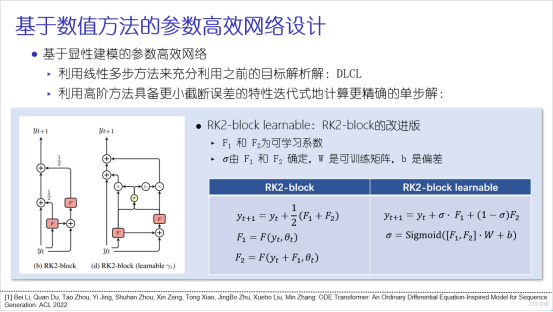

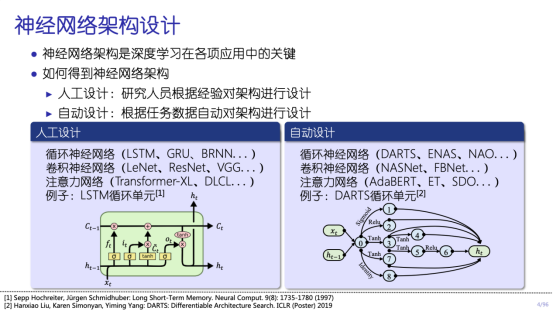

第二部分:基于人工先验知识的神经网络设计

报告的第二部分由东北大学博士生李北讲述。本部分主要关注基于人工先验的神经网络设计,内容围绕基于Transformer模型的网络结构改进工作展开,包括基于跨层连接的结构优化、注意力机制的改进、多尺度建模、混合专家系统及应用数值理论提高参数高效性五方面工作。在每个方面,讲者从方法的早期灵感开始介绍,并介绍了方法的发展脉络和随后的改进工作,对近年来结构优化相关的工作实现了大规模的覆盖。其中详细讨论了关于模型对浅层信息利用不充分,深层网络的训练稳定性,深层网络的深度退化问题,注意力的局部建模,多头注意力的增强,注意力、架构、语义单元多尺度网络,多分支网络设计,显性建模和隐性建模等问题。

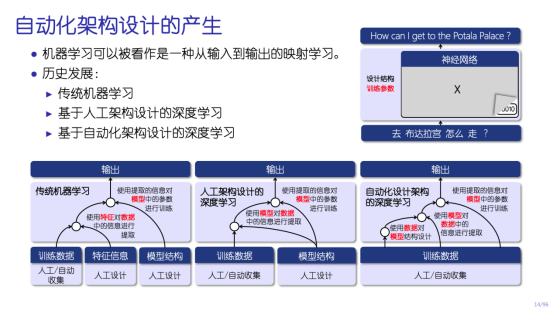

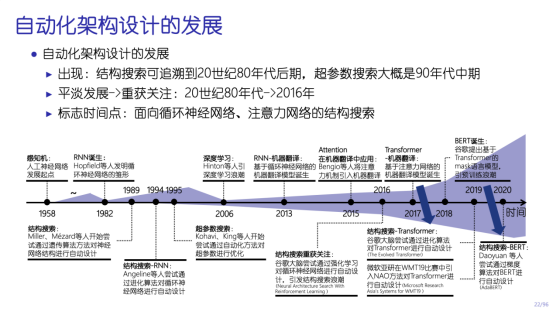

第三部分:自动化设计神经网络架构

报告的第三部分由东北大学博士生李垠桥讲述。主要围绕如何通过自动化地方式对神经网络架构进行设计而展开。在该部分中讲者首先介绍了什么是神经网络架构的自动设计,对比了机器学习中三种不同的范式的差异,然后通过对神经网络技术发展的历史回顾切入,对自动化架构设计在其中扮演的角色进行了梳理。在此之后讲者对自动化架构设计的整体框架进行细致的介绍,包括搜索空间、搜索策略以及性能评估,让大家对这类方法本身具备清楚的认知。再后讲者以自然语言处理任务为例介绍了如何应用自动化机器学习的方式对结构进行优化和设计,对自动化架构搜索在自然语言处理领域中所要解决的问题进行分析。最终,还对目前自动化架构设计中依旧存在的重要问题进行了探讨,希望对读者有进一步的帮助和启发。

部分slides如下:

审核编辑 :李倩

-

BP神经网络与深度学习的关系2025-02-12 1496

-

详解深度学习、神经网络与卷积神经网络的应用2024-01-11 3470

-

人工神经网络和bp神经网络的区别2023-08-22 6026

-

什么是神经网络?什么是卷积神经网络?2023-02-23 4827

-

卷积神经网络模型发展及应用2022-08-02 13209

-

基于BP神经网络的PID控制2021-09-07 2588

-

如何构建神经网络?2021-07-12 1862

-

神经网络与神经网络控制的学习课件免费下载2021-01-20 1519

-

【AI学习】第3篇--人工神经网络2020-11-05 4122

-

【案例分享】ART神经网络与SOM神经网络2019-07-21 3180

-

神经网络资料2019-05-16 3320

-

NLP中的深度学习技术概述2019-03-01 5571

-

NLP多任务学习案例分享:一种层次增长的神经网络结构2018-01-05 5603

-

神经网络教程(李亚非)2012-03-20 56708

全部0条评论

快来发表一下你的评论吧 !