NVIDIA Jetson Orin Nano的性能基准

描述

在本次 GTC 大会上,NVIDIA 发布了Jetson Orin Nano系列的系统级模组(SoM)。其 AI 性能是 NVIDIA Jetson Nano 的 80 倍,成为入门级边缘 AI 和机器人技术的新基准。

Jetson 系列首次包括基于 NVIDIA Orin 的模组,从入门级的 Jetson Orin Nano 到最高性能的 Jetson AGX Orin,使客户能够灵活地轻松扩展其应用程序。

借助 Jetson AGX Orin 开发者工具套件提供的完整软件仿真支持,可以立即启动您的 Jetson Orin Nano 开发。

各行业的日常用例对提高实时处理能力的需求继续增长。入门级 AI 应用程序,如智能相机、手持设备、服务机器人、智能无人机、智能仪表等,都面临着类似的挑战。

这些应用需要在设备上对来自其多模态传感器工作流的数据进行更多的低延迟处理,同时保持在高能效、成本优化的小尺寸的范围内。

Jetson Orin Nano 系列

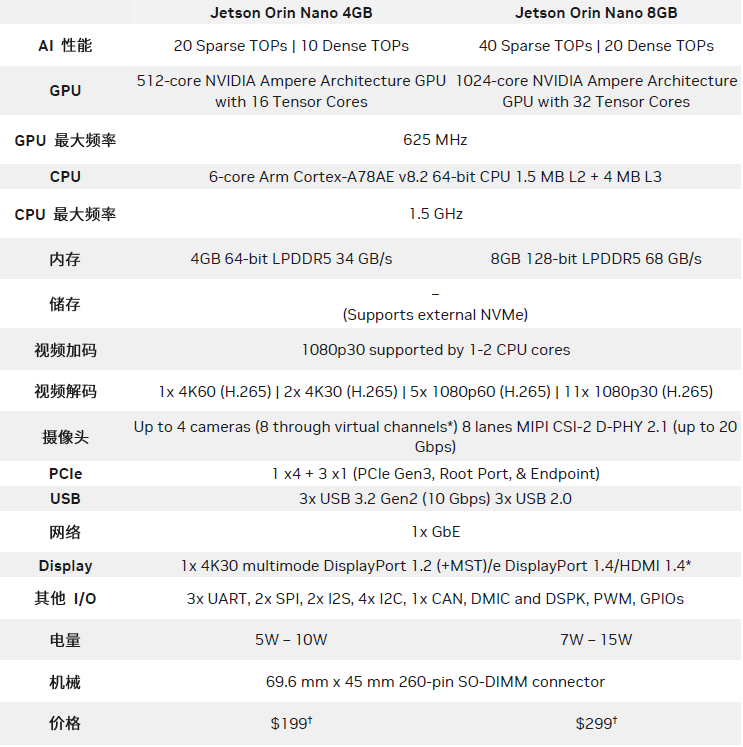

Jetson Orin Nano 系列量产级模组将于 1 月份上市,售价 199 美元起。这些模组以最小的 Jetson 外形尺寸提供高达 40 TOPS 的 AI 性能,功率选项低至 5W,高达 15W。该系列有两个不同的版本:Jetson Orin Nano 4GB 和 Jetson Orin Nano 8GB。

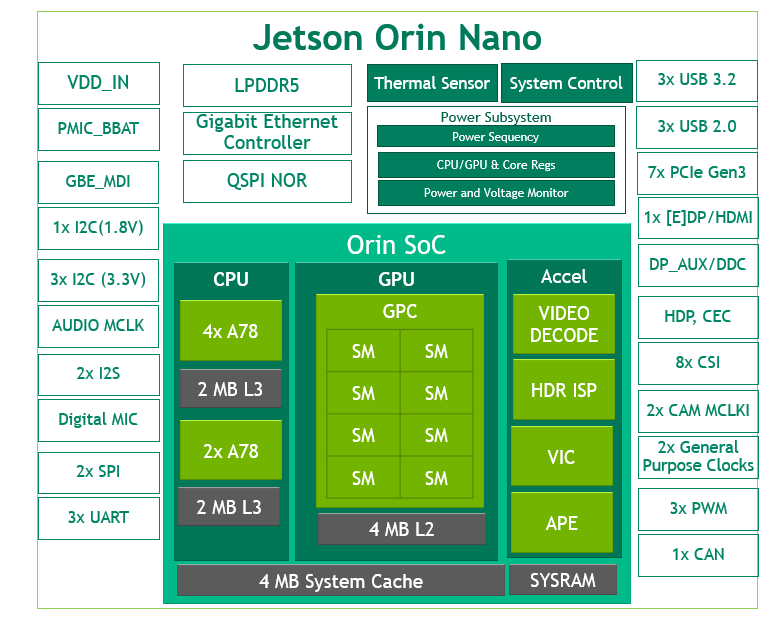

图 1 Jetson Orin Nano 架构分析框图 * Jetson Orin Nano 8GB 的 NVIDIA Orin 架构,Jetson Orin Nano 4GB 有 2 个 TPC 和 4 个 SM

如图 1 所示,Jetson Orin Nano 展示了带有 NVIDIA Ampere 架构 GPU 的 NVIDIA Orin 架构。它有多达 8 个流式多处理器( SM ),由 1024 个 CUDA 核和多达 32 个用于 AI 处理的Tensor Core组成。

NVIDIA Ampere 架构第三代 Tensor Core 的每瓦特性能优于前一代,并通过对稀疏性的支持带来更高的性能。通过稀疏性,您可以利用深度学习网络中的细粒度结构化稀疏性,将 Tensor Core 操作的吞吐量提高一倍。

为了加速应用程序工作流的所有部分,Jetson Orin Nano 还包括一个 6 核 Arm Cortex-A78AE CPU、视频解码引擎、ISP、视频图像合成器、音频处理引擎和视频输入块。

Jetson Orin Nano 模块占地面积小,仅有 70 x 45mm,260 针 SODIMM,包含了各种高速接口:

多达七条 PCIe Gen3 通道

三个高速 10 Gbps USB 3.2 Gen2 端口

八通道的 MIPI CSI-2 摄像头端口

各种传感器 I / O

为了减少您的工程工作量,我们已使 Jetson Orin Nano 和 Jetson Orin NX 模块完全与引脚和外形尺寸兼容。表 1 显示了 Jetson Orin Nano 4GB 和 Jetson Orin Nano 8GB 之间的差异。

表 1 Jetson Orin Nano 系列规格 * 有关 DisplayPort 1.4a 和 HDMI 2.1 以及虚拟通道的其他兼容性的更多信息,请参阅 Jetson Orin Nano 系列数据表。 † 1KU 容量

立即使用 Jetson AGX Orin 开发者套件和仿真

开启您的开发流程

Jetson AGX Orin 开发者套件和所有 Jetson Orin 模组共享一个 SoC 架构,让开发者工具套件能够模拟任何模块,使您能够轻松开始开发下一个产品。

在开始将其应用程序移植到新的 NVIDIA Orin 体系结构和最新的NVIDIA JetPack之前,您无需等待 Jetson Orin Nano 硬件正式上线。通过新发布的覆盖层,你可以用开发工具套件模拟Jetson Orin Nano模块,就像使用其他Jetson Orin模块一样。通过将开发者套件配置为模拟Jetson Orin Nano 8GB或Jetson Orin Nano 4GB,用户可以开发并运行全部应用程序工作流。

图 2 模拟所有六个 Jetson Orin 模组

Jetson Orin Nano 的性能基准

凭借 Jetson AGX Orin,NVIDIA 在 MLPerf 的推理性能类别中处于领先地位。Jetson Orin 模组为您的下一代应用程序提供了巨大飞跃,现在入门级 AI 设备也可以使用相同的 NVIDIA Orin 架构。

我们使用 NVIDIA JetPack 5.0.2 的仿真模式运行 Jetson Orin Nano 的计算机视觉基准测试,结果显示了它是如何设置新标准的。测试包括来自 NGC 的一些密集 INT8 和 FP16 预处理模型,以及标准 ResNet-50 模型。我们还在 Jetson Nano、TX2 NX 和 Xavier NX 上运行相同的模型进行比较。

以下是基准的完整列表:

NVIDIA PeopleNet v2.3 用于修剪人员检测,NVIDIA PeopleNet v2.5 用于最高精度的人员检测

NVIDIA ActionRecognitionNet 二维和三维模型

NVIDIA LPRNet 用于车牌识别

NVIDIA DashCamNet,BodyPoseNet 用于多人人体姿势估计

ResNet-50(224 × 224)模型

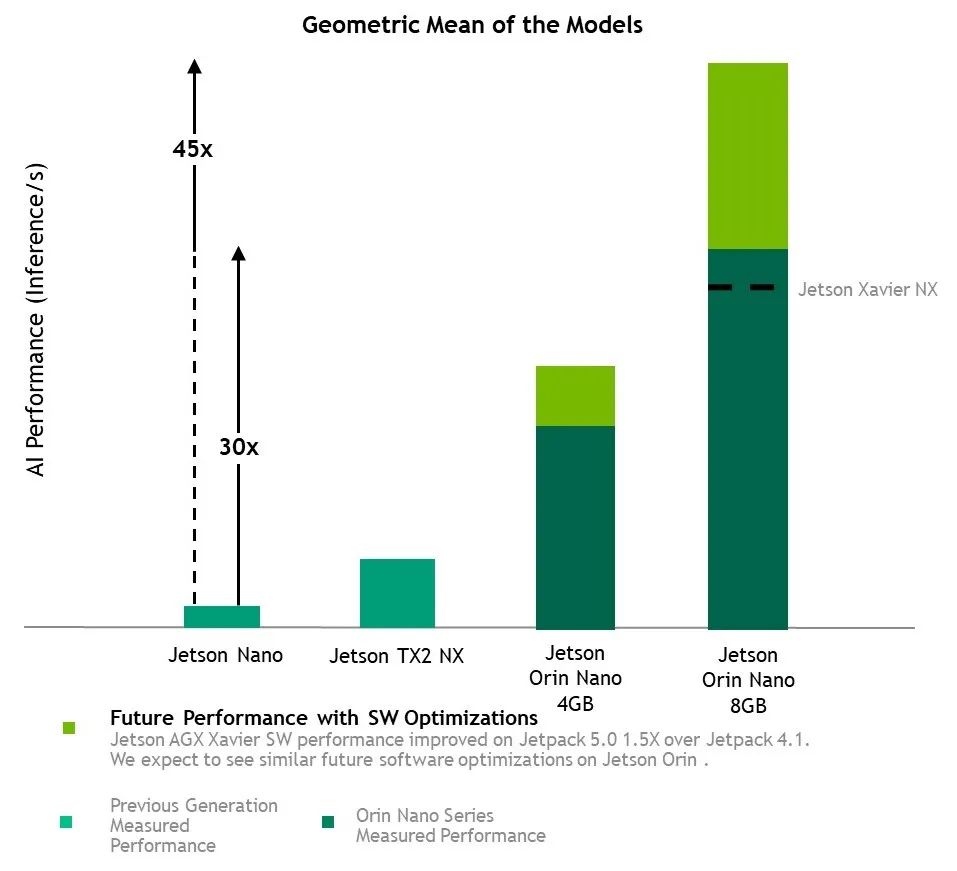

图 3 Jetson Orin Nano 系列基准编号

图 4 Jetson Orin Nano 系列基准图

以这些基准的平均值来看,Jetson Orin Nano 8GB 的性能比 Jetson Nano 提高了 30 倍。随着未来软件的改进,我们预计性能将提高 45 倍。其他 Jetson 设备自其第一个支持软件发布以来,性能提高了 1.5 倍,我们预计 Jetson Orin Nano 也会如此。

Jetson 运行 NVIDIA AI 软件堆栈,并提供特定于用例的应用程序框架,包括用于机器人的NVIDIA Isaac、用于视觉 AI 的NVIDIA DeepStream和用于会话 AI 的NVIDIA Riva。使用NVIDIA Omniverse Replicator可以节省大量时间用于合成数据生成(SDG),使用NVIDIA TAO 工具套件可以节省大量的时间用于微调 NGC 目录中的预处理 AI 模型。

Jetson 与整个 NVIDIA AI 加速计算平台的兼容性使开发和无缝迁移变得容易。

使用 NVIDIA Isaac ROS 增强入门级机器人

Jetson Orin 平台旨在解决最棘手的机器人挑战,为 70 多万名 ROS 开发人员带来加速计算。结合 Jetson Orin Nano 强大的硬件功能,最新的NVIDIA Isaac软件中针对 ROS 的增强功能为机器人专家提供了卓越的性能和生产力。

新的 Isaac ROS DP 版本优化了可以在 Jetson Orin 平台上执行的 ROS2 节点处理工作流,并提供了新的基于 DNN 的 GEMS,旨在提高吞吐量。Jetson Orin Nano 可以利用那些高度优化的 ROS 2 packages 执行定位、实时 3D 重建和深度估计等任务,这些任务可用于避障。

与只能处理简单应用程序的原始 Jetson Nano 不同,Jetson Orin Nano 可以运行更复杂的应用程序。随着不断致力于提高 NVIDIA Isaac ROS,您将看到 Jetson Orin 平台的精确度和吞吐量随着时间的推移而不断提高。

对于开发下一代服务机器人、智能无人机等的机器人专家来说,Jetson Orin Nano 是一种理想的解决方案,它具有高达 40 个 TOPS,可在节能和小尺寸的情况下实现现代 AI 推理工作流。

审核编辑:汤梓红

-

NVIDIA Jetson介绍2021-12-14 3048

-

NVIDIA Jetson AGX Orin提升边缘AI标杆2022-04-09 2327

-

英伟达推出Jetson Orin Nano模组最高40TOPS性能,为机器人和边缘AI提供强动力2022-09-21 9350

-

NVIDIA推出全新Jetson Orin Nano系统级模组2022-09-22 2494

-

研扬同步在GTC中宣布NVIDIA Jetson Orin Nano 边缘计算AI平台BOXER-8621AI上市2022-09-27 2297

-

将Jetson AGX Orin开发者套件转化为任何Jetson Orin模块2022-09-30 3462

-

使用NVIDIA Jetson Orin Nano解决入门级边缘人工智能挑战2022-10-11 3791

-

GTC23 | 使用 NVIDIA Jetson Orin Nano 开发套件开发 AI 机器人及智能视觉系统2023-03-29 2644

-

Jetson Orin Nano纳米刷机介绍2023-04-01 5239

-

英伟达Jetson设备上的YOLOv8性能基准测试2023-04-12 8529

-

可适配NVIDIA Jetson Orin NX和Orin Nano的工业级准系统,研华EPC-R7300助力产品开发2023-04-26 1500

-

NVIDIA Jetson Nano上的智能视频分析2023-07-06 894

-

NVIDIA发布小巧高性价比的Jetson Orin Nano Super开发者套件2024-12-19 1512

-

研华NVIDIA Jetson Orin Nano系统支持Super Mode2025-03-10 652

-

NVIDIA Jetson系列开发者套件助力打造面向未来的智能机器人2025-12-13 2461

全部0条评论

快来发表一下你的评论吧 !