马斯克炮轰的激光雷达到底什么角色?

描述

其他品牌在堆料,为什么就特斯拉喜欢减配?

靠8个摄像头,特斯拉凭什么搞自动驾驶?

马斯克炮轰的激光雷达到底什么角色?

有这样的疑问是出于最近的一条新闻:“特斯拉宣布从10月开始欧洲、北美、中东地区交付的Model 3、Model Y,将取消超声波雷达,随后将推及到全球范围,Model S和Model X也将在2023年一并取消超声波雷达。”

要知道特斯拉的自动驾驶方案在最初还使用着1颗摄像头+1颗毫米波雷达+12颗超声波雷达的组合,随着特斯拉AI算法和自研的FSD芯片不断精进后。..。..

马斯克觉得他行了。

他炮轰激光雷达,用“阑尾”形容激光雷达在车上的作用,用“foolish”形容那些使用激光雷达的人们,包括与小鹏汽车创始人何小鹏在推特上互呛。他对雷达家族的深恶痛绝,仿佛有种“错的不是我,而是这个世界”的感觉。

之所以有这样的感觉,是因为特斯拉这几年的动作完全“不合群”。别的车企,特别是那些造车新势力疯狂“上价值”,恨不得车上塞满传感器。而特斯拉在给汽车“减负”,去年5月特斯拉宣布砍掉毫米波雷达,现在又把超声波雷达砍了,至于激光雷达,如果从量产车层面上看,它没出现过,而在测试车辆上,它也就昙花一现。

在自动驾驶方案上,从此有了向左向右的问题,特斯拉一路向北,离开了有雷达的季节。..。..

此时压力来到了那8颗摄像头上。..。..

别人眼里的激光雷达

首先了解下激光雷达的工作原理,它本质是向目标发射激光束,然后激光束碰到目标物后会反弹或是散射,返回的光波会进入激光雷达的接收器中,因为光脉冲是以光速传播,所以速度是已知的,继而可以将光波发射的一个来回的时间换算成距离。

这只是测距。当然一个激光束是没有用的,就像我们在漆黑一片的环境中行走,肯定会需要一个手电筒吧,太小不顶用,太大拿不动。

激光雷达也是这样,激光束发射的频率可以从每秒几个脉冲到每秒几万个脉冲,不断地扫描物体,就可以得到物体上所有目标点的数据,经过数据处理后,就可以得到精准的3D图像。

那么问题来了,开车上路,上下前后左右都会有突发状况或是障碍物,激光束只会朝一个方向射出,怎么一下子识别四周呢?

跟你拿手电筒左右来回照一个做法,那就是让激光雷达转圈圈~ 你可以想象成一个浑身插满灯泡的陀螺。

就像这样。..。..

这就是机械式激光雷达,靠电机带动旋转使激光束可以360度全方位扫描。目前市面上的雷达类型多按扫描方式进行区分,按照扫描方式有无机械转动部件可分为机械旋转、混合固态、纯固态三种。整体发展趋势从机械式向纯固态演变。

但是如果只靠单线束激光,再怎么旋转也只能扫一个平面,不能测量物体的高度,所以并不适用开车这么复杂的应用场景。因此除了扫描方式外,线束的多少也决定了成像的精细度。所谓单线雷达就是只有一个激光发射器和接收器,多线雷达就是在垂直方向上有多套收发装置,目前市面上多见的多线雷达有32线、64线、96线、128线等。

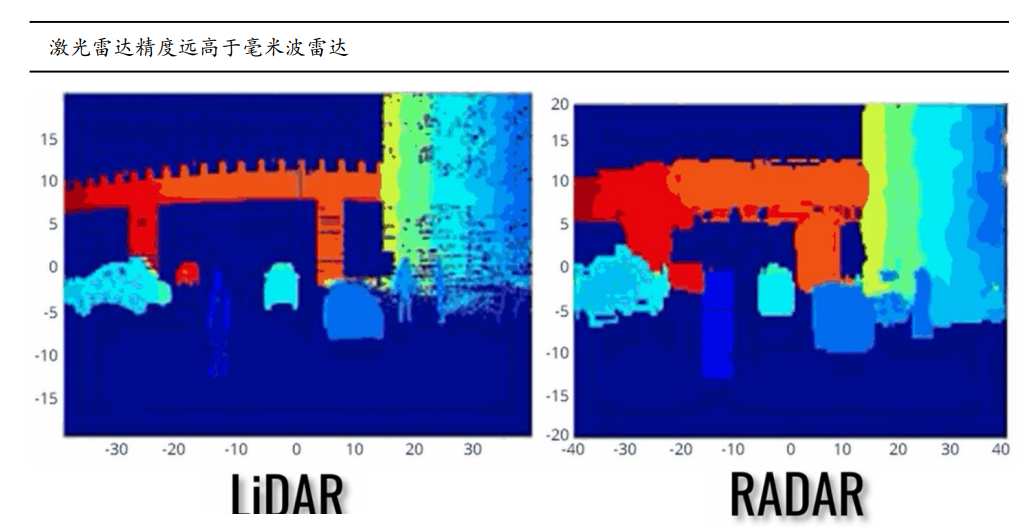

这样一堆光波打在不同物体的表面后所形成的画面如下:

是不是有一种看素描画的感觉?虽然成像不太好看,但是给自动驾驶提供了一个立体的世界,可以帮助算法更好地识别周遭的环境。

没有对比就没有伤害,要清楚认识到激光雷达的重要性,还要对比下毫米波和超声波雷达。

毫米波雷达的探测距离短,受到频段损耗的影响,也无法感知行人,而且对障碍物无法精准建模,特别是高处物体和小型物体,但胜在穿透性和抗干扰能力强,因此主要用于防撞。

超声波雷达相当于毫米波雷达再减配,探测距离很短,方向性差,还受制于声波传输速度,优点可能就是便宜,所以你看那些车企一用就是十几颗,它主要应用在低速泊车等短距离场景。

由此看来,完整的一套多传感器融合的自动驾驶感知方案,就是激光雷达构建3D世界,然后摄像头丰富色彩、轮廓、纹理等细节信息,其余那两颗雷达帮忙打下手,所以激光雷达是必不可少的C位角色。

特斯拉眼里的激光雷达

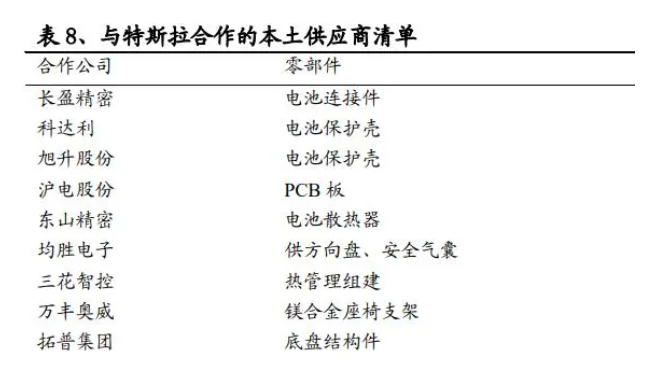

特斯拉所恪守的信条,其中之一肯定有成本,从特斯拉的供应链策略里就能看出端倪。

简单来说,特斯拉的供应链策略就是一手抓(一体化)和就地取材(本土化)。以电池供应为例,特斯拉在上游原材料领域持续发光发热,与各地企业签署了供应协议。又以特斯拉上海工厂为例,在特斯拉上海厂运营一段时间后,宁德时代成为特斯拉上海的独家供应商,其他诸如结构件、座椅支架、连接件等已经国产化。

特斯拉上海厂支撑了很大一部分产能,同时也为特斯拉降低了一大笔成本。上海厂生产Model 3车型的单位成本较美国工厂下降65%。

特斯拉这样做都是为了降低运输成本,提高生产效率。除了供应链策略外,特斯拉还采用新技术来降低成本。例如,特斯拉在2020年推出的4680电池,在电池组层面每千瓦时成本降低14%。2021年,特斯拉展示了一体式底盘电池包,这种一体化压铸车身,减重10%,减少370个车身零部件。

在毫米波雷达和超声波雷达由于性能上的薄弱,已经开始拖后腿时,特斯拉自然可以以成本为由,把它们给炒了。根据 Munro Live 在油管上的一则视频分析,特斯拉通过移除超声波传感器,估计每辆车可节省成本114美元(约817元人民币)。

而激光雷达早期多用于军事、工业领域,转用民用领域,首先面临的问题就是成本。现在,一颗高性能的激光雷达的价格可至上万元,而Velodyne的64线激光雷达售价高达数万美元,但一颗高清摄像头的价格就几百元。

这么高昂的成本是抠抠搜搜的特斯拉所不能接受的,但成本也仅能作为一个通用理由。

将雷达家族除名,是特斯拉所遵循的“第一性原理”在自动驾驶方案上的写照。第一性原理指的是回归事物最基本的条件将其拆分成各要素,进行结构分析,从而找到实现目标最优路径的方法。

在自动驾驶方面,马斯克认为人可以靠视觉来驾驶汽车,那么车仅依靠摄像头也可以。唯一需要做的,就是找到如何提取摄像头所获取的信息,并利用这部分信息来训练算法模型。

马斯克这个耿直boy认为可以,它就一定是可以。就像当年马斯克坚持走自动化生产工厂,差点让Model 3难产至死,从“生产地狱”爬出来后,马斯克选择了妥协。

而这一次,马斯克不需要妥协,因为特斯拉的算法和软件功力。

特斯拉的底气是硬件吗?

很显然是。因为8颗摄像头背后是特斯拉自研的FSD自动驾驶芯片和DOJO超算。

2019年,特斯拉推出了自研的自动驾驶芯片FSD,在此之前特斯拉使用过MobileEye和英伟达的计算平台。相较于上一代自动驾驶平台,FSD芯片将算力提升至144TOPS,可以每秒处理10亿像素的图像信息。

2021年,特斯拉再度推出自研的AI芯片D1,用来训练超算DOJO。DOJO可以利用特斯拉海量的视频数据,来做无人标注和训练,能够自动学习和识别标记道路上的一切要素。今年AI Day上,特斯拉宣布,由D1芯片组成的高达1.1E算力的超算系统EXA POD将于明年一季度正式量产,届时DOJO相比英伟达A100,可以达到最高4.4倍的单芯片训练速度,而训练延迟相比同等规模的GPU,最低可至1/50。

简单来说,特斯拉给AI提供了学习课本还不说,连自习室都准备好了,而且这学习资料和自习室的规模和装修程度愈发豪华,剩下的就交给AI自己了。

但特斯拉的底气也不只是硬件。有了硬件的支撑,特斯拉拥有的海量数据和AI算法、模型,才是与其他车企拉开身位的地方。

特斯拉从2016年10月开始推出FSD(Full-Self Driving)自动驾驶套件,其选装价格已经一路上涨至1万美元。今年AI Day上,特斯拉宣布过去一年,有2000辆车参与了FSD Beta的测试,而目前这个数量已来到16万。特斯拉介绍,得益于DOJO超算,特斯拉去年训练了7.5万个神经网络模型,相当于8分钟训练一个,推送了35个更新,现阶段,FSD Beta已经可以在一定程度上实现完全自动驾驶。

每天在路上飞驰的特斯拉,已经提供了超14.4亿帧的视频数据,视频缓存达30PB,需要超过10万个GPU训练小时。

有了海量的数据,问题来到了算法和模型。

特斯拉在今年CVPR上发布了全新的算法,名为Occupancy Networks,用来改进AI模型HydraNets。

这个算法也是为了弥补缺少激光雷达所带来的问题。

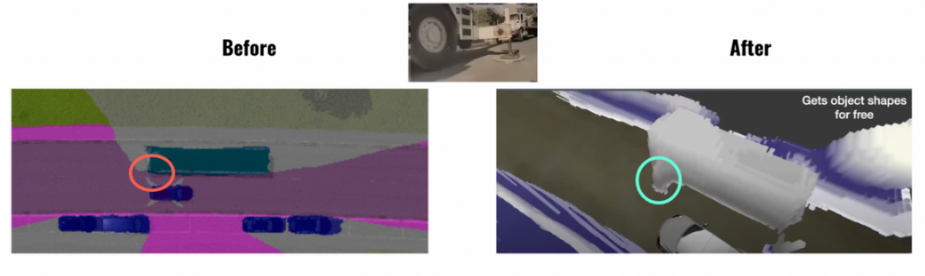

我们知道计算机视觉提供的是2D图像,而现实世界是3D的,这就造就了很多识别上的问题。比如如何看到被遮挡的物体?计算机视觉中的模型都是以规整矩形来输出,但很多物体形状不规则,碰上那些奇形怪状的物体该如何识别?没有在数据库中出现的物体突然出现在眼前又该如何识别?

以上这些问题,引入激光雷达是正解,因为它能构建3D传感,来弥补2D感知上的失效,至少这是行业大部分企业所认同的。

那Occupancy Networks是如何解决的呢?

它把检测识别这个概念变成了“占用”,简单来说这个算法把世界切成了无数个小方格。

就像“我的世界”这款游戏一样,如下图:

它判断这些小方格里面有没有东西,有就代表占用,没有就是空白,这样先解决了那些不规则轮廓的识别问题。

这些小方格共同构建了一个3D体积,也形成了一张3D的鸟瞰图。

然后特斯拉将这些3D体积通过训练出来的3D重建场景进行比对,最终还原了摄像头所看到的现实世界,如下图:

看着是不是和激光雷达扫出来的世界差不多?

当然特斯拉的绝活还不止这些,什么自动标注工具,车道线网络等等都是为了让纯视觉自动驾驶成真而努力。

毫米波和超声波雷达本身的作用是测距和测速,现在特斯拉的算法和模型已经直指激光雷达的作用了,雷达家族被砍也就不足为奇了。

向左向右?

激光雷达的先锋,LBEO申请破产,推崇固态激光雷达的Ouster股价跌破一美元,马斯克对激光雷达的评论说对了?

那也未必,特斯拉与其他车企最大的区别还是其AI算法和软件研发能力。对于特斯拉而言,如果软件buff足够强大,数据足够多,那么硬件上就可以做到足够的cost down,何乐而不为呢?

而其他算法能力还没那么强的公司,现阶段除了激光雷达外没有其他选择。多传感器融合是能极大提升感知的精确性,也就提升了安全性。车是与生命安全强相关的产品,而安全是要做加法的,在安全面前,解决哪怕0.1个百分点的错误也比讨论价值更有意义。

无论是多传感器融合还是单兵作战,作为环境感知,传感器的功能无外乎相当于人的视觉。但人类在驾驶途中,依靠的可不仅仅是视觉,或者说视觉只是基础。

随着传感器的技术发展,它们可以从识别一个静态物体到一个红绿灯,也可以从一个动态物体到一个行人甚至是背着包或者扛着物品行走的人。

但是遇到一辆高速行驶的车突然变道,原本在路边等待的行人突然冲向你车前,而你旁边正好也有一辆车,这时是该选择紧急刹车与后车相撞,还是紧急变道与旁边的车相撞以此避免撞到行人?这两种紧急避险的办法哪种损失又更小?

等等这些突发状况都是在读秒间,传感器只能告诉你发生了什么,但无法告诉你该怎么做,而真正要做到自动驾驶,最关键的问题,最要解决的问题,往往是决策层面。

连人都会慌了神,失了措,那摆在一堆数据面前的路还很长。从这一点看,提升软件能力,AI算法能力是所有自动驾驶企业最终的目标。

向左还是向右,向北还是向南,殊途同归罢了。

审核编辑 :李倩

-

小鹏新车或放弃激光雷达 马斯克发评论2024-07-10 507

-

狂踩激光雷达的马斯克,如今竟成Luminar的榜一大哥?2024-05-28 154

-

马斯克称特斯拉的FSD系统不需要激光雷达2024-05-14 1600

-

恐怖!市值大跌99%!激光雷达企业都很惨!难怪马斯克看不上2022-11-09 881

-

为什么埃隆·马斯克反对使用激光雷达?#激光雷达 #深度学习学习电子知识 2022-09-21

-

激光雷达的艰难降本之路2022-03-31 5869

-

用视觉替代激光雷达,可能吗?特斯拉为何不用激光雷达?2020-09-23 8132

-

激光雷达的中场战事2019-06-09 2863

-

第 N 次在公开场合 diss 激光雷达的马斯克2019-04-29 2715

-

马斯克:依靠激光雷达的自动驾驶公司都注定失败2019-04-25 3457

-

特斯拉不使用激光雷达的自动驾驶汽车到底有什么看头2018-07-22 2305

-

马斯克反对在特斯拉autopilot设计中引入激光雷达2018-04-30 780

-

激光雷达到底是不是自动驾驶系统的核心组成部分?2018-04-23 1565

-

看看被特斯拉嫌弃的激光雷达厂商如何爆发2016-11-01 1133

全部0条评论

快来发表一下你的评论吧 !