谈谈物联网抱稳的AI大腿

电子说

1.3w人已加入

描述

电子发烧友网报道(文/周凯扬)如今各行各业似乎都傍上了AI,物联网也不例外。但AIoT的进程也已经开启了好几年,除了智能音箱、智能机器人这样的产品以外,似乎也没有冒出任何爆款,反倒是手机凭借着庞大的应用生态,Killer App频出。可无论是芯片原厂,还是下游厂商仍在不遗余力地宣传AI功能,这让人百思不得其解了,物联网真的抱稳了AI这条大腿吗?我们不妨从物联网上实现AI的几种方式来分析一下。

AIoT芯片

随着边缘端对AI需求的增加,其实不少厂商在不改变芯片架构的情况下,也为边缘AI开发提供了一系列工具。就拿意法半导体为例,他们旗下的STM32产品就全部兼容NanoEdge生态,支持生成异常检测、异常值检测、分类和回归四种ML库,可以完成常见的能源管理和寿命预测等工作。至于对性能要求更高的深度学习应用,就得用到他们的STM32Cube.AI了,对MCU的要求也提升至Cortex-M33以上的内核。这种方式对于芯片原厂来说,无需对设计做出大改,也有助于建立起自己的AI开发工具链生态,还可以针对不同芯片的性能进行调整。

轻量级AI框架

不仅是芯片厂商,AI框架的开发者们也注意到了IoT庞大的边缘AI市场,纷纷在推出轻量化或可扩展性强的框架,比如TensorFlow Lite、Caffe2等。这类框架可以在内存极小的设备上运行ML模型,也不需要任何操作系统、库的支持。由于走了轻量化的路线,所以与工作站或数据中心这种场景跑的AI框架还是存在差异的,但也足以完成常见的对象检测、手势识别、超分辨率等工作,TinyML已经成了每个物联网公司研究的方向。

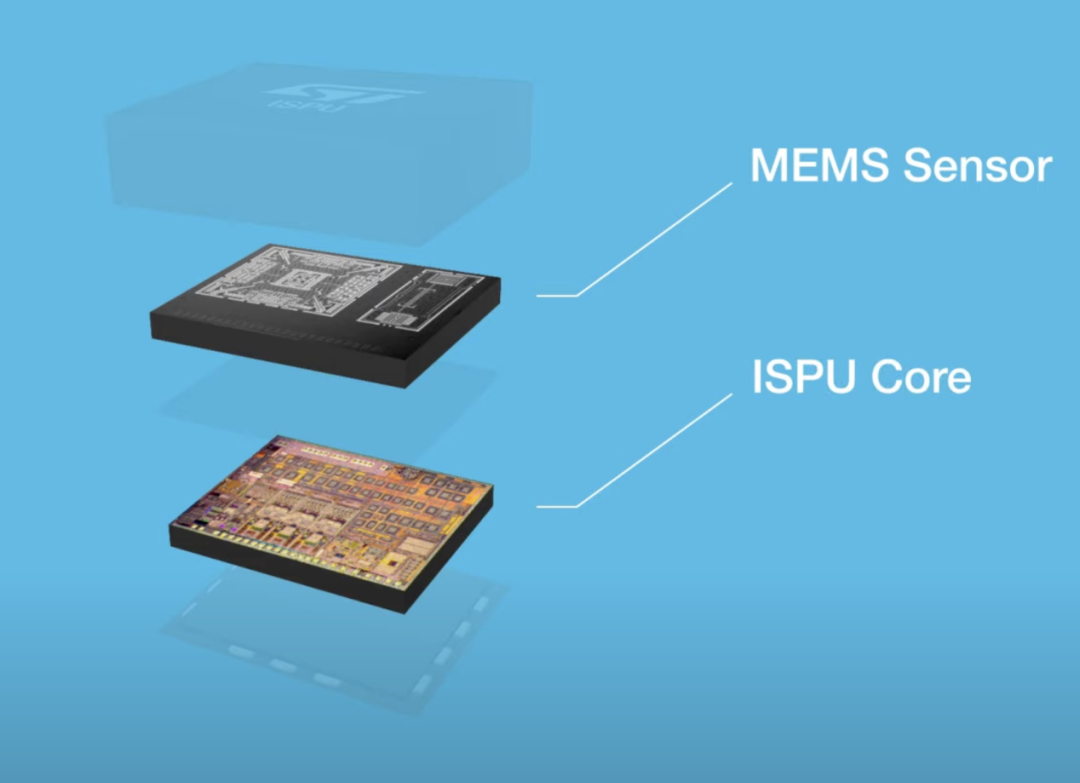

传感器AI

大家都知道,一旦将数据处理尽可能放在靠前的流程中,不仅能降低功耗和延迟,也能极大地提升AI运算的效率,省去交给云端处理这一繁琐的步骤。在大部分IoT场景中,数据传输流程的头部往往都是传感器,所以无论是何种传感器,制造商们都开始探讨集成AI的方案。

写在最后

我们自然也不能忽视掉在云端进行AI处理的方案,固然这是一种将性能放大到极致的路线。可如果将未经处理的数据一股脑交给云端处理的话,徒增上云成本不说,延迟也会大大增加;全部交给端测来完成AI计算的话,功耗续航都得做出让步,甚至还是难以跑出可观的性能。这也就是为何亚马逊、阿里巴巴等厂商纷纷部署IoT的边缘计算的原因,即便边缘端接手了主要的AI计算工作,却依然可以将数据交给云端进行管理、存储和分析,而且这不一定是一个实时连接的过程,只需间歇性的同步也能完成任务。更何况功能、固件升级这样的任务主要还是交给云端来实现的,在有效的分析和训练下,云端可以将优化过后的模型传给边缘端。所以由此看来,物联网要想真正跨入AI时代,端云协同才是最佳方案。

更多热点文章阅读

- 车载大屏产业链分析,主要玩家都有谁?

- 谷歌3D全息电话亭,颠覆现有视频通话!宛如真人面对面

- 富士康Model B/V正式发布,ALL IN电动车代工,全产业链布局格局显现

- 半导体TOP 10厂商股价集体腰斩,台积电再传危机信号

- 2026年交付!索尼造车终于尘埃落定,本田成代工厂

原文标题:谈谈物联网抱稳的AI大腿

文章出处:【微信公众号:电子发烧友网】欢迎添加关注!文章转载请注明出处。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

这个“好色”机器人爱抱大腿!2016-01-06 0

-

有没有了解嵌入式软件验证的大神啊求抱大腿!!!2017-07-14 0

-

物联网行业需要了解的8件事2018-09-13 0

-

AI:对物联网安全的影响2019-05-29 0

-

Banana Pi BPI-EAI80 AIoT 开源硬件物联网AI开发板.2020-05-09 0

-

物联网是什么 物联网前景如何2020-06-02 0

-

什么是物联网?物联网的特征是什么?有哪些分类?2021-06-15 0

-

物联网之IP Camera解决方案资料下载2021-06-30 0

-

基于stm32的物联网项目2021-08-05 0

-

边缘智能市场要素:海量需求,物联网切分2022-08-23 0

-

基于物联网的思考2011-02-16 703

-

地表最强骁龙835发布,小米忙抱大腿,这是小米6首发的节奏?2017-03-22 561

-

AI时代,巨头企业如何博弈物联网2018-10-22 3613

-

物联网中的AI是人工智能技术与物联网基础设施的融合2019-05-14 1439

-

谈谈物联网抱稳的AI大腿2022-10-27 1270

全部0条评论

快来发表一下你的评论吧 !