当UNet与HRNet碰撞会产生怎样的火花?U-HRNet不做选择

描述

高分辨率和高级语义表示对于密集预测都至关重要。从经验上看,低分辨率特征地图通常实现更强的语义表示,而高分辨率特征地图一般可以更好地识别边缘等局部特征,但包含较弱的语义信息。现有的最先进的框架(如HRNet)保持了低分辨率和高分辨率特征地图的并行性,并在不同分辨率之间反复交换信息。然而,我们认为,最低分辨率的特征地图往往包含最强的语义信息,需要经过更多层才能与高分辨率特征地图合并,而对于高分辨率特征图,每个卷积层的计算成本非常大,不需要经过这么多层。因此,我们设计了一个U形高分辨率网络(U-HRNet),它在语义表示最强的特征图之后添加更多的阶段,并放松了HRNet中的约束,即新添加的阶段需要并行计算所有分辨率。为低分辨率特征图分配了更多计算,这大大改善了整体语义表示。U-HRNet是HRNet主干的替代品,可以在完全相同的训练和推理设置下,在多个语义分割和深度预测数据集上实现显著改进,而计算量几乎没有增加。

代码可从PaddleSeg获取:https://github.com/PaddlePaddle/PaddleSeg

1、简介

密集的预测任务,包括语义分割和深度估计等,是视觉理解系统的重要组成部分。密集预测任务需要预测像素级类别标签或回归特定值,这比图像级预测任务更具挑战性。同时保持高分辨率和强语义信息是有效处理密集预测任务的关键。高分辨率可确保最终预测粒度尽可能接近像素级别,并可获得更精确的局部判别,例如更精确的边缘。强大的语义信息确保了整体预测的准确性,特别是对于难以区分或面积较大的实例。

深度卷积神经网络,如U-Net、DeepLab、HRNet,在FCN的设计之后,在密集预测任务中取得了令人兴奋的结果。特别是高分辨率网络(HRNet)在密集预测任务中取得了最先进的结果,例如语义分割、人体姿势估计等。HRNet能够学习高分辨率表示,同时确保低分辨率特征图和高分辨率特征图之间的语义信息传输。

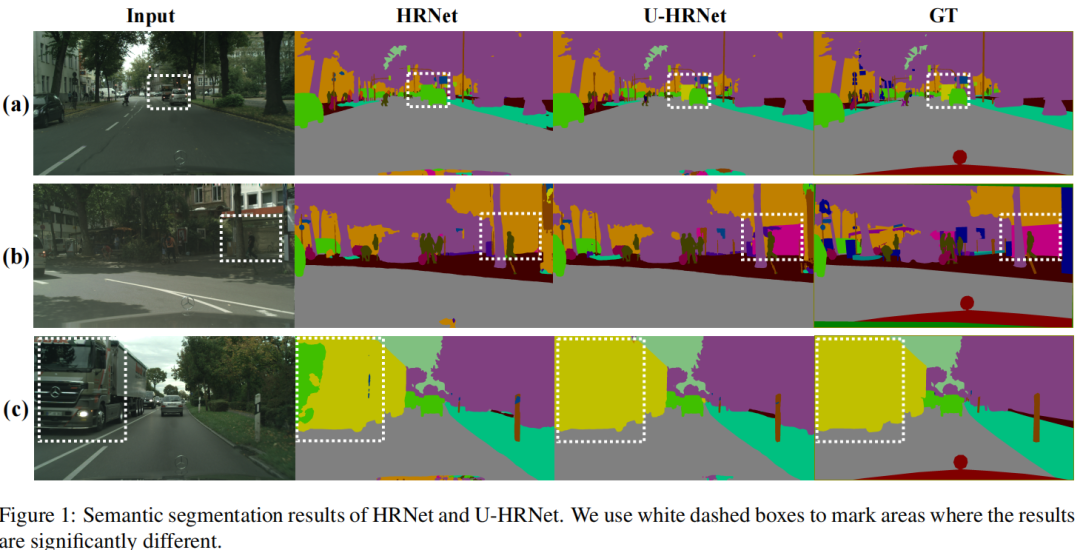

然而,作者发现HRNet仍有很大的改进空间。经常可以看到大面积的区域被错误地分类。例如,在图1中,第2行显示HRNet的结果。在图1(a)和(b)中,整个实例被错误分类,而在(c)中,一个大面积实例中的一些块被错误分类。这表明HRNet实现的语义表示仍然不够好。作者认为,这可能归因于HRNet的宏观结构,可以概括为以下两个方面:

HRNet最低分辨率分支的最终块具有最强的语义表示,直接输出,而不完全传播到更高分辨率分支。

HRNet的低分辨率分支不够深入,使得网络的语义能力受到限制。然而,由于计算成本的显著增加,在HRNet的最后两个阶段为更深的网络增加模块数显然是不可取的。

U-Net在一定程度上缓解了上述两个问题。然而,在U-Net中,每个阶段只保留一个分辨率,不同尺度之间没有融合,只有与残差分支合并。作者认为,HRNet的最大优势是能够并行维护多尺度并始终执行多尺度融合。

为了在不增加额外计算成本的情况下改进高分辨率网络的整体语义表示,作者提出了一种简单有效的网络,称为U形高分辨率网络(U-HRNet)。它继承了UNet的编解码器结构,有利于从最强语义特征映射到最高分辨率特征映射的嵌入传播。同时,它完美地保留了HRNet的优点,保持了多尺度并行,并始终执行多尺度融合。

此外,它减少了高分辨率分支上的块数,并将其计算重新分配给低分辨率分支,以获得更大的语义容量,而无需添加更多计算。如图1所示可以看到U-HRNet在困难对象和大面积实例的语义表示方面比HRNet更具优势。幸运的是,U-HRNet也与OCR头一起工作得很好,因为U-HRNet专注于提高整个网络的语义能力,这与OCR的优势没有重叠,OCR旨在借助对象和类别之间的语义关系更好地标记。

因此,本文的贡献有两点。

提出了一种简单有效的网络U-HRNet,它在密集预测任务上的性能优于HRNet而计算量几乎没有增加。

U-HRNet与OCR的结合为多个语义分割数据集设置了新的技术水平。

2、U型高分辨率网络

2.1、Review of HRNet

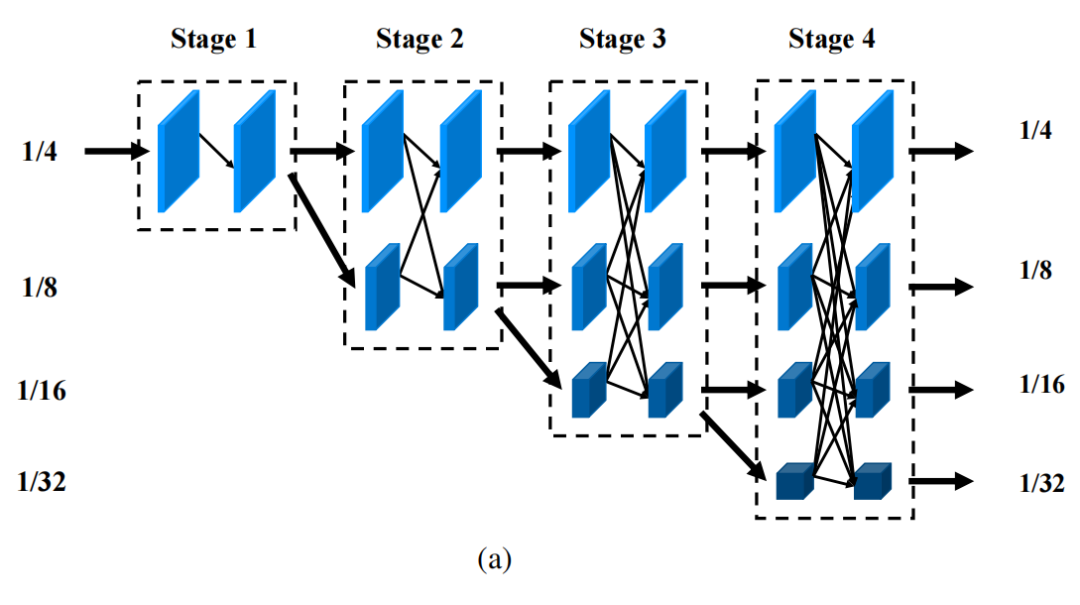

HRNet是一种用于人体姿态估计的优秀神经网络。之后,进一步证明了HRNet可以很好地处理其他许多任务,如目标检测、语义分割。由此可见,HRNet不仅在高级语义表示方面很强,而且在低级空间细节方面也很强。如图2(a)所示,1/4分辨率从网络的开始到结束都是一致的,随着网络深度的增加,语义表示学习增加了更多的低分辨率,从而通过多分辨率融合提高了高分辨率表示。

然而,HRNet对于一些密集的预测任务可能并不完美。例如,语义分割是一个典型的密集分类任务,为了帮助像素预测其语义类别,引入高级全局信息非常重要。从这个角度来看发现HRNet有以下几个缺点:

具有最强语义表示的1/32分辨率分支的最后一个块直接输出,而没有得到充分利用。

高分辨率和低分辨率分支之间的计算分配没有优化,应更多关注语义表示强的低分辨率分支。

2.2、Architecture of U-HRNet

1、主体结构

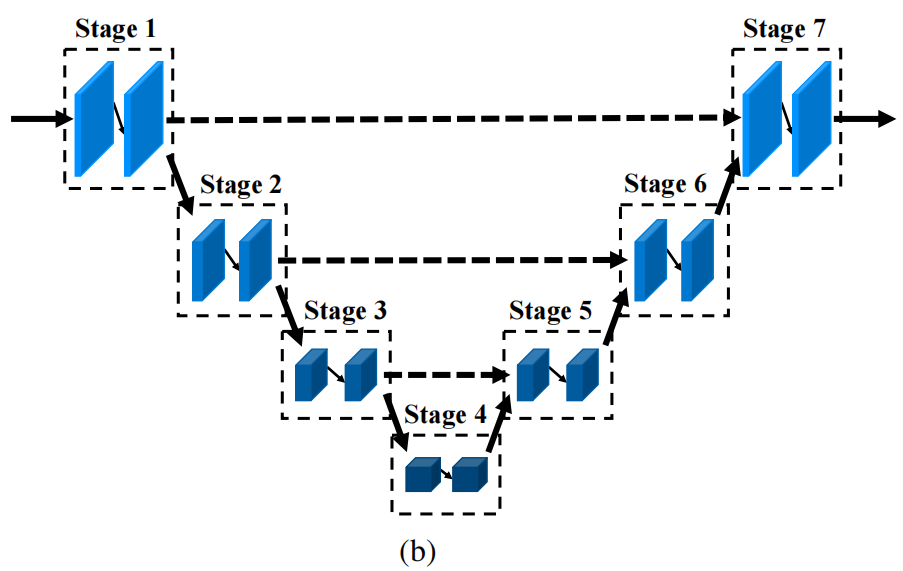

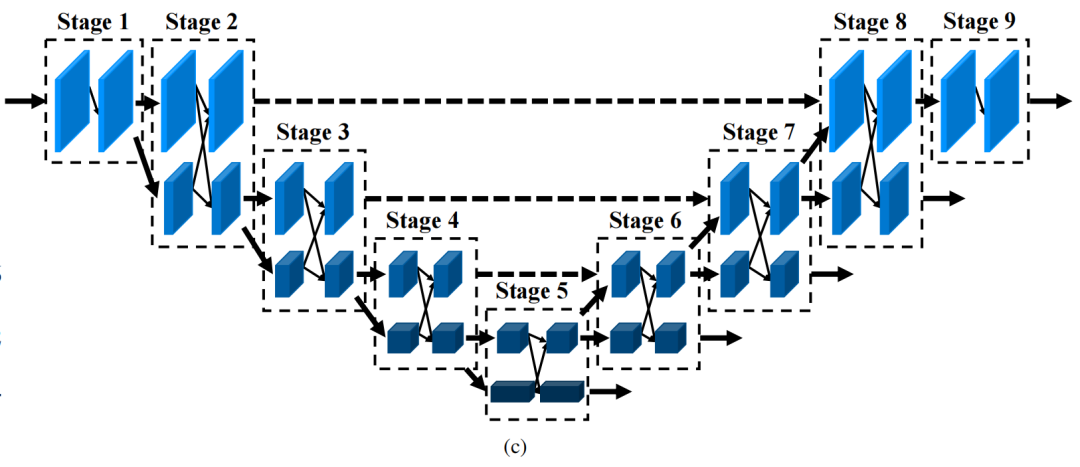

继HRNet之后,将图像输入到一个干块中,将分辨率降低到1/4,主体输出与1/4分辨率相同的特征图。图2(c)显示了U-HRNet的主体。与U-Net一样,其布局如图2(b)所示,主体在宏观范围内似乎是U形网络,而在微观范围内,它由几个hr模块组成。然而,每个hr模块由不超过两个分辨率分支组成。这种设计方式旨在解决第3.1节中提到的HRNet的缺点。重组的细节如下所述。

首先,删除了HRNet最后两个阶段的高分辨率分支(阶段3和阶段4的1/4分辨率分支,阶段4的1/8分辨率分支),这使得许多计算被释放。

然后,为了改进高分辨率输出的语义表示,在最低分辨率阶段之后添加了几个阶段。这些阶段逐渐对要素图进行上采样,并与之前阶段特征合并。这使得最低分辨率阶段输出的语义表示最强的特征可以更早地与low-level高分辨率特征合并,从而通过充分分析最强的表示,后续阶段能够更精确地推断空间细节。

最后,在不同阶段重新安排表征模块。在低分辨率阶段增加了模块,而在高分辨率阶段减少了模块,这在很大程度上改善了语义表示。此外,添加了一个具有1/32和1/64分辨率分支的stage,以生成更丰富的语义表示,而无需添加额外的更高分辨率分支。与UNet类似,在网络的深度方向上设置了几个Shortcut,分别连接第2阶段和第8阶段、第3阶段和第7阶段、第4阶段和第6阶段。这些Shortcut使网络可以同时利用High-Level特征和Low-Level特征,同时使渐变可以直接传播到前面的阶段。

2、融合模块

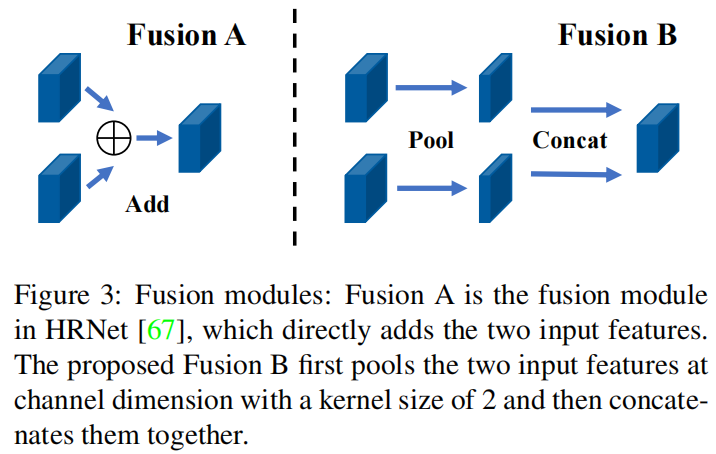

对应于主体中的Shortcut,在第8阶段、第7阶段和第6阶段之前有三个融合模块,分别将第2阶段、第3阶段和第4阶段的高分辨率分支输出的Low-Level特征与第7阶段、第6阶段和第5阶段的高分辨分支的上采样特征合并。

直觉上,可以简单地应用高分辨率模块中使用的融合方法,即添加两个输入特征,然后执行ReLU函数进行激活,如图3中的fusion a所示。然而,假设根据U-Net的融合方法连接两个输入特征可以增强网络的连通性。因此,首先将核大小为2的通道维度上的两个输入特性合并在一起,然后将它们作为输出特性在通道之间连接起来,如图3的Fusion B所示。

3、表征Head

对于表征Head,基本遵循HRNetV2。输出的多分辨率特征来自阶段5、阶段6、阶段7、阶段8和阶段9的较低分辨率分支。但是,由于增加了1/64分辨率,U-HRNet表征头中卷积的输入通道数是HRNetV2的两倍。为了保持与HRNetV1表征头类似的计算成本,通过一个核大小为2的池化操作传递多分辨率特性,然后将它们连接到通道维度中,作为表征头的输入。

2.3、Instantiation

U-HRNet的主体包含9个阶段和5个分辨率流。分辨率为1/4、1/8、1/16、1/32、1/64。第一阶段包含1个分支hr模块,由4个瓶颈残差块组成,每个块的宽度为64,然后是一个3×3卷积,将特征图的宽度更改为C,表示为1/4分辨率流的宽度。第2至第8阶段分别包含1、5、2、2、1、1、1hr模块。所有这些模块都由两个分支组成,每个分支由4个基本残差块组成。与第一阶段一样,最后一阶段也包含1个分支hr模块,而该模块由4个基本残差块组成。最后,五个分辨率流的卷积宽度分别为C、2C、4C、8C和16C。

U-HRNet的布局如图2(c)所示。此外,与U-HRNet相比,U-HRNet-slim有两点不同,

第三阶段由2hr模块组成,而其他阶段与U-HRNet相同

U-HRNet-small的hr模块中的所有分支都包含2个瓶颈块或基本块。

2.4、分析

在U-HRNet中,除了第一级和最后一级之外,主要采用两个分支hr模块作为组成网络的基本单元,而不是HRNet使用的多分辨率(两个或多个)并行卷积和U-Net中的一个分支卷积序列。它带来了一些有助于改进语义表示的好处。

与HRNet相比,这两个分支hr模块放宽了在一定阶段内所有分辨率都需要并行计算的限制,同时又不失多分辨率推理的优势。这使得U-HRNet可以在低分辨率分支上附加比HRNet更多的计算,并进一步改进最强的语义表示。

与U-Net相比,双分支hr模块在多尺度表示学习上明显优于单分支卷积序列。此外,当进入下一个分辨率时,无论是下采样还是上采样,U-HRNet都会继续保持之前的一个分辨率,并不断融合两个分辨率的特性。这使得网络能够充分利用之前学习到的信息,同时避免因分辨率变化而导致的空间或语义知识的丢失。

3、实验

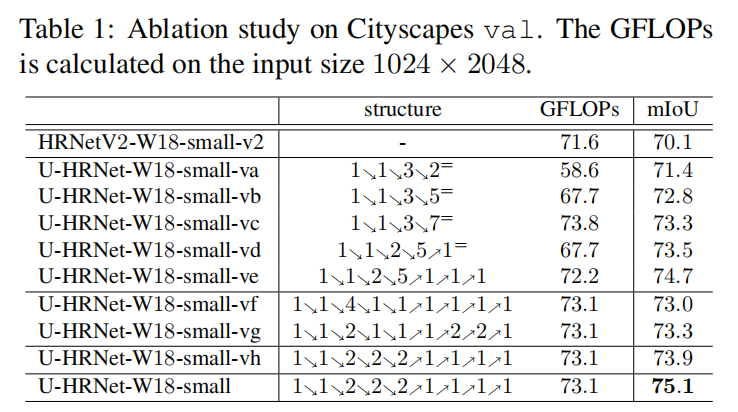

3.1、消融实验

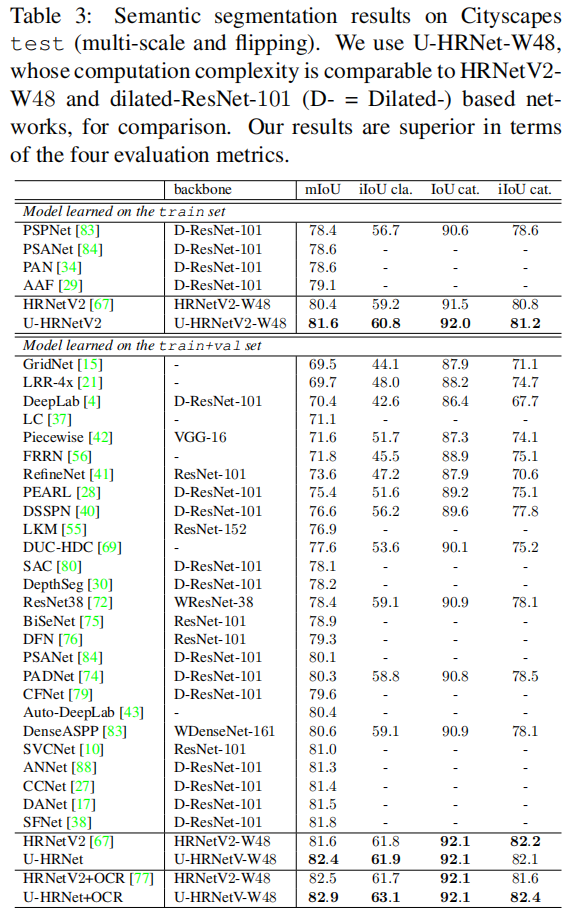

3.2、SOTA对比

4、参考

[1].U-HRNet: Delving into Improving Semantic Representation of High Resolution Network for Dense Prediction.

审核编辑 :李倩

-

嘿逗智能水杯:未来与传统的碰撞2015-09-24 3016

-

万用表+蓝牙,会碰撞出什么火花?2017-10-09 4474

-

Python遇上物联网又会碰撞出怎样的火花呢2021-08-27 2401

-

医疗电子与人工智能会碰撞出什么火花?2016-11-21 894

-

人脸识别碰撞智慧机场 新科技不断擦出火花2018-12-07 2371

-

当声音遇上共振,会产生怎样的火花?2019-03-11 843

-

当奥迪、百达翡丽、兰蔻大牌遇上新媒体艺术,会碰撞出怎样的火花2020-03-26 2709

-

5G与医疗会碰撞出什么样的火花2019-08-15 1667

-

当MCU遇上FPGA会碰撞出怎样的火花2020-03-03 7868

-

UNet和UNet++:医学影像经典分割网络对比2022-04-25 15015

-

设计一个U形高分辨率网络(U-HRNet)2022-11-07 3059

-

UNet++与Ronneberger的U-Net进行比较2023-05-31 2793

-

当5G-A遇上体育,会碰撞出怎样的火花?2023-08-16 1147

-

反向电动势的影响有多大?如果不做处理会怎样?2023-11-06 5778

-

当5G融合体育时,会碰撞出怎样的火花2024-08-16 19805

全部0条评论

快来发表一下你的评论吧 !