成功构建文本分析工作流的四个步骤

描述

文本分析(从原始人类语言中发现隐藏模式以实现更好的决策和预测的过程)为工业和预测性维护系统提供了几个好处。这些分析使工程师能够利用原始文本数据轻松生成有关维护记录的见解,并构建故障预测算法以预防潜在问题。

以非公路商业空间为例,在建筑工地上使用重型设备:如果一台重型设备发生故障,在修复系统所需的时间和成本与施工停滞时现场的停机时间之间,可能会发生代价高昂的故障。传统上,来自此设备的遥测数据已用于构建可预测未来故障的预测性维护模型。但是,在机械师和操作员的文本注释中也有关于过去故障及其原因的宝贵信息。工程师可以利用此文本数据来增强预测性维护模型,并确定应解决的模式和故障模式。

文本分析的挑战在于大量的非结构化原始文本数据集,这可能会使分析工具不堪重负。这使得工程师更难快速直观地提取用户可能获得的所有有价值的信息。但是,工程师可以通过正确的工具和遵守端到端工作流程来克服这些障碍。

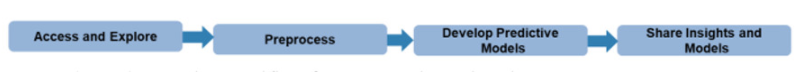

当涉及到端到端文本分析工作流程时,工程师需要了解什么?工作流中有四个主要阶段:

图1.端到端文本分析工作流。

第 1 阶段:数据访问和探索

文本数据将来自各种来源,包括数据库、内部文件存储库和 Internet,并且格式多种多样。正确准备数据是成功工作流程的关键因素。适当的数据准备会将原始文本数据清理并预处理为“清理数据”以供分析。

以词云为例。该模型将数据转换为一种格式,使工程师能够快速轻松地可视化正在使用的单词以及数据池中最常见的短语。当与应用其领域专业知识的工程师相结合时,诸如词云之类的可视化效果有利于更大的文本分析工作流程,因为工程师可以轻松发现数据可能缺少标记或需要清理的地方,因为他们了解给定环境或用例中的典型问题或问题。

第 2 阶段:数据预处理

这些可视化效果还有助于指导需要采取的后续操作。如图 2 所示,停用词(不增加价值的低信息词)很常见,它们的存在会扭曲可视化结果。在工程师开始模型开发过程之前,他们必须清理原始文本数据,以过滤掉这些“停用词”,并输入真实、重要的数据以传递给建模过程。预处理阶段允许用户从原始文本中提取有意义的单词。

数据清理通常是数据分析中最耗时的部分,根据数据量,清理步骤可能需要多次迭代。但是,投入所需的额外时间和资源所带来的投资回报率允许在文本分析工作流的后期使用更准确和成功的模型。在许多情况下,干净的词云会传递有关文本页面上实际内容的更多信息。

文本分析工具箱等工具通过提供用于预处理、分析和建模文本数据的算法和可视化,帮助用户为模型构建过程做好准备,从而为工程师解决数据清理痛点。

这些工具从流行的文件格式中提取文本,从设备日志、新闻提要、调查、操作员报告和社交媒体等来源预处理原始文本,提取利用文本、数字和其他类型的数据的单个单词或多词短语 (n-gram),将文本转换为数字表示,然后构建统计模型。

第 3 阶段:预测模型构建

清理和预处理数据后,就可以开始使用机器学习或深度学习算法构建预测模型了。

这就是文本分析的优势所在:它发现数据中隐藏的模式并以直观的格式显示它们,允许用户消化数据,然后采取纠正措施解决问题,然后再进一步进入工作流程。

以将干净的文本数据转换为数字形式为例。工程师可以应用“词袋”等建模方法,该方法根据提供的文本数据创建一个数字矩阵,显示每个单词的使用频率。从那里,工程师可以使用预测模型,如潜在狄利克雷分配(LDA)模型,该模型可以拟合到单词/频率矩阵中,以发现文本数据集中隐藏的主题和见解。

LDA 模型可以生成与数据中“隐藏主题”相关的词云,显示将文本数据拟合到此预测模型中后如何开始出现模式,从而帮助为创建相应问题的解决方案提供信息。

使用新的叙述对模型(如上面示例中的模型)进行测试以验证模型的预测是否正确后,可以建立自动警报,以便系统在需要注意的任何问题上向响应团队发送标志。如果位置数据也可用,则结果会发现某些主题(例如,标记的问题)与其位置数据之间存在相关性,因此该模型还可以通过使用多个数据流来补充文本数据来提醒响应团队潜在的更大基础设施问题。

第 4 阶段:见解和预测模型部署

使用文本分析设置模型并验证其可接受的性能后,可通过多种方式与工程团队和/或管理层共享结果和模型,包括生成报告或交互式笔记本(例如 MATLAB Live 编辑器)、将数据传送到桌面或 Web 应用程序(例如 MATLAB 应用程序设计器),或在生产服务器或 Web 应用程序服务器上托管应用程序。

对于工业自动化、机械、汽车制造、航空航天设计或能源分配等行业的工程师来说,文本分析可以帮助他们执行复杂的数值分析,以识别可以带来更好结果并改进预测性维护等功能的想法和概念组。

审核编辑:郭婷

-

基于工作流技术的广州电信本地计费系统改造2010-04-24 2491

-

pyhanlp文本分类与情感分析2019-02-20 3290

-

基于案例推理的工作流异常处理研究2009-06-15 531

-

OA系统中工作流引擎的设计2009-06-16 869

-

一个基于工作流的web服务组合系统2009-07-30 1441

-

基于工作流的生产管理系统研究与设计2009-09-23 741

-

工作流环境下组件的开发2012-12-17 932

-

组织成功实施人工智能的四个步骤2021-02-02 4908

-

文本分类的一个大型“真香现场”来了2021-02-05 2339

-

基于深度神经网络的文本分类分析2021-03-10 1624

-

基于LSTM的表示学习-文本分类模型2021-06-15 1117

-

推荐两个工作流的springboot项目2022-03-18 2452

-

带你从头构建文本分类器2022-03-22 4561

-

成功的文本分析工作流程的四个步骤2022-06-20 7993

-

利用TensorFlow实现基于深度神经网络的文本分类模型2024-07-12 1873

全部0条评论

快来发表一下你的评论吧 !