华为NoF+存储网络解决方案实现颠覆性改进

描述

传统协议无法满足全闪存数据中心的要求,NVMe存储协议的出现极大提升了存储系统内部的存储吞吐性能、降低了传输时延,NoF(NVMe over Fabric)存储网络应运而生。在多种Fabric技术中,NVMe over RoCE(RDMA over Converged Ethernet)被广大存储厂商所接受,成为业界NoF的主流。华为推出的NoF+存储网络解决方案,相较于标准NoF方案,在性能、可靠性、易用性上均实现了颠覆性改进,是全闪存时代的最佳选择。

本文内容参考自《数据中心前沿网络技术合集(1)》和《数据中心前沿网络技术合集(2)》。

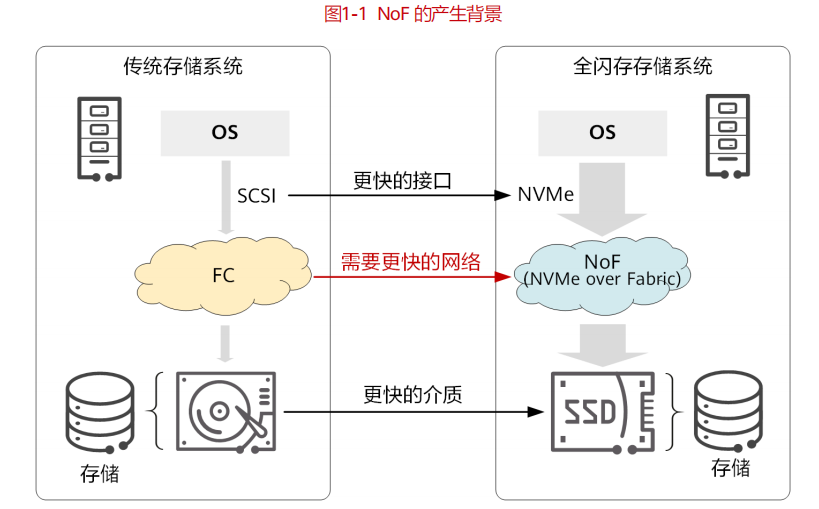

随着存储介质从 HDD 发展到 SSD,存储高性能吞吐与 SCSI 协议传输较低性能吞吐之间的矛盾日益严重,从而出现了 NVMe 存储协议。NVMe 规范了 SSD 访问接口,简化了协议复杂性,充分利用 PCIe(Peripheral Component Interconnect Express)通道的低延时以及并行性,利用多核处理器,通过降低协议交互时延,增加协议并发能力,并且精简操作系统协议堆栈,显著提高了 SSD 的读写性能。

全场景闪存化推动了数据中心的网络改革,NVMe 最大化释放了 SSD 介质的能力。更快的存储呼吁更快的网络。NoF 存储网络应运而生,通过使用 IP 网络对专用网络的创新性革新,实现了更高的带宽和更低的时延,同时也兼具 IP 易管理的优势,是更好地实现端到端 NVMe 存储网络的最佳方案。

NoF 将 NVMe 协议应用到服务器主机前端,作为存储阵列与前端主机连接的通道,可端到端取代 SAN 网络中的 SCSI 协议,构建全以太的存储 SAN 网络。

NVMe over Fabric 中的“Fabric”,是 NVMe 的承载网络,这个网络可以是RoCE、FC 或 TCP。具体说明如下:

NVMe over FC 协议标准为 FC-NVMe,FC-NVMe 和 FC-SCSI 同样都基于 FCP,IO 交互基于 Exchange。FC-NVMe 基于传统的 FC 网络,通过升级主机驱动和交换机支持,FC-SCSI 和 FC-NVMe 能同时运行在同一个 FC 网络中。FC-NVMe 能最大化继承传统的 FC 网络,复用网络基础设施,基于 FC 物理网络发挥 NVMe新协议的优势。

NVMe over TCP 基于现有的 IP 网络,采用 TCP 协议传输 NVMe,在网络基础设施不变的情况下实现了端到端 NVMe。

NVMe over RoCE 是 NVMe over RDMA 的一种,RDMA 是承载 NoF 的原生网络协议,RDMA 协议除了 RoCE 外还包括 IB(InfiniBand)和 iWARP(Internet Wide Area RDMA Protocol)。

其中,基于以太网的 RoCE 目前已成为 RDMA 的主流网络承载方式。NVMe over RDMA 协议比较简单,直接把 NVMe 的 IO 队列映射到 RDMA QP(Queue Pair)连接,通过 RDMA SEND,RDMA WRITE,RDMA READ 三个语义实现 IO 交互。NVMe over RoCE 基于融合以太网的RDMA 技术承载 NVMe 协议。

三种方案相比较,基于以太网的 RoCE 比 FC 性能更高(更高的带宽、更低的时延),同时兼具 TCP 的优势(全以太化、全 IP 化),因此 NVMe over RoCE 是 NoF最优的承载网络方案,也已成为业界 NoF 的主流技术。

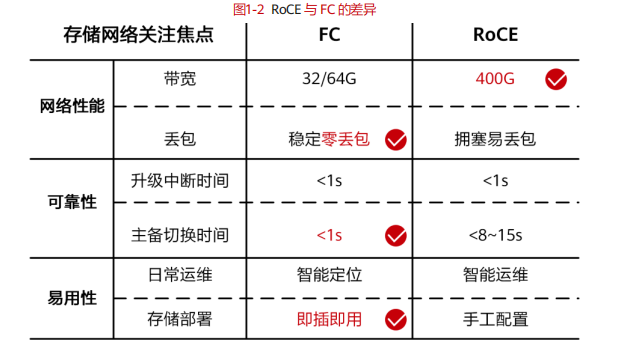

基于以太网的 RoCE 在存储性能、带宽方面比 FC 有显著优势,但替换 FC,联接全闪存,标准的 NVMe over RoCE 还需在 3 个方面加强完善:

1. 网络性能:零丢包网络零丢包是存储网络的基本需求,传统以太网络拥塞易丢包。

2. 可靠性:秒级主备切换存储为了可靠性,会构建多个网络平面,切换时间需<1s。

3. 易用性:即插即用FC 存储网络场景单一、配置简单,当前以太网络还需针对存储场景适应性改进。

基于当下业界主流的标准 NoF 方案,华为依靠在网络和存储领域的深厚积累,进一步从网络性能、可靠性和易用性这三点都进行提升,基于智能无损网络面向集中式存储场景提出了 NoF+解决方案,将数据中心存储网络进一步推向更广阔的发展空间。

网络性能增强:NoF+方案改变了传统以太静态水线方式,对网络预测性能力进行专项优化,通过样本计算,针对特定场景,通过算法进行精准的控制,从而预判业务对网络的诉求,提前做出优化,实现高吞吐带宽,进一步提升性能。

可靠性增强:保障业务系统可靠是存储的根基,比如存储的秒级切换功能就是可靠性的关键保障之一,标准以太缺乏故障主动发现和通知能力,NoF+实现了从事后被动响应到主动通知、提前识别拥塞和故障。当一个节点出现故障,业务会以亚秒级响应速度切换,在高性能运行的前提下,也能维持系统的稳定可靠。

易用性增强:华为的存储与网络产品强强联合,打造了“即插即用”的方案,实现了一键式扩容,自动化管理,增强了在未来建设时的易用性。

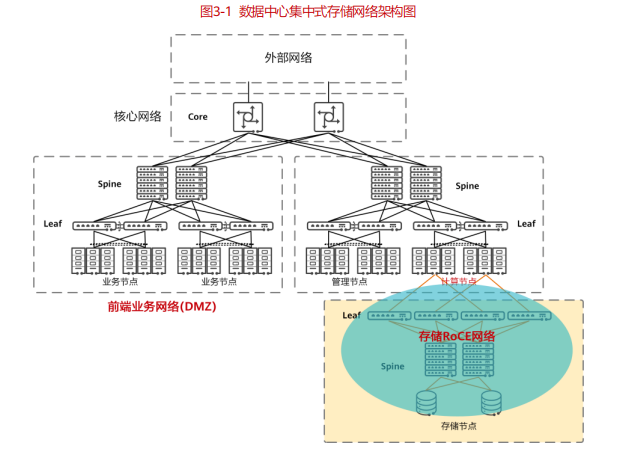

在数据中心常规组网里面,存储网络只是其中的一部分,集中式存储是一个独立的网络,与业务网络在物理上隔离。

业务网络:是指业务服务器对外提供服务通信网络,该网络与外部网络互连互通。

计算网络:是指运行 OLTP/OLAP(Online Transaction Processing/Online Analytical Processing)数据库的后台服务计算节点所组成的物理网络,使用不同的网卡连接业务网络和存储网络,实现业务网络和存储网络之间物理隔离,避免相互影响。

存储网络:是指计算服务器访问存储数据时使用通信网络,该网络一般是独立的物理网络。为了保证数据高可靠,存储网络支持 DC 级容灾,支持同城双活存储网络,确保业务系统发生设备故障、甚至单数据中心故障时,业务无感知自动切换,实现 RPO ( Recovery Point Objective ) =0 , RTO ( Recovery Time Objective)≈0(与应用系统及部署方式有关)。

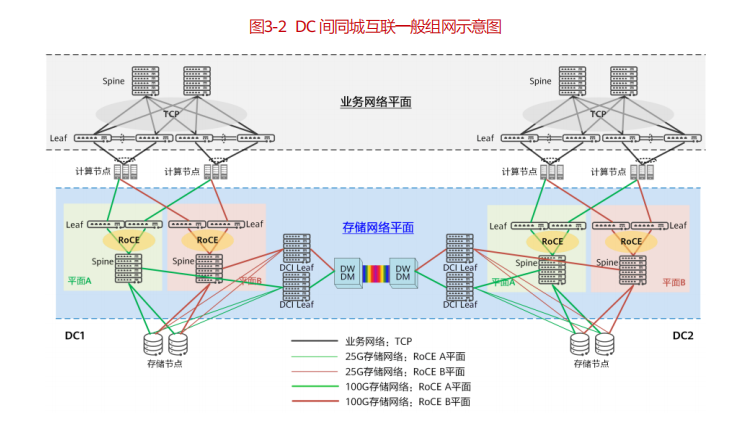

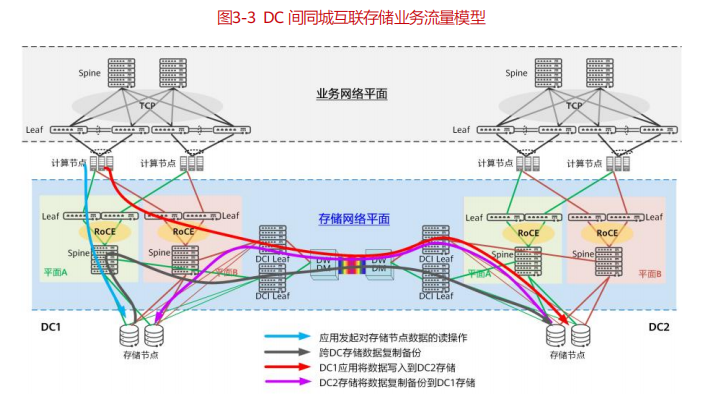

数据中心为了容灾考虑,需要实现多数据中心互通。同城两个数据中心互为备份,且都处于运行状态。当一个数据中心发生设备故障,甚至数据中心整体故障时,业务自动切换到另一个数据中心,解决了传统灾备中心不能承载业务和业务无法自动切换的问题。提供给用户高级别的数据可靠性以及业务连续性的同时,提高存储系统的资源利用率。异地进行异步数据备份。

在集中式存储下,为了实现同城读写支持 NVME over ROCE,需要实现同城无损网络,即需要一套跨 DC 的无损网络,每个 DC 部署两台支持智能长距无损的 DCI Leaf,中间通过波分设备或者裸光纤直连实现双平面,实现端到端的 ROCE 无损网络。

在本场景中,常见的流量有以下几种类型:

由应用发起对存储节点数据的读操作,此时计算节点访问同 DC 中的存储节点,存储节点返回相应数据,如图中蓝色线条所示。

当应用同时还需要对存储写数据时,除了对本 DC 内的存储节点执行写操作,在存储系统之间,同时也会发起对另外 DC 中存储的写操作,作为数据的复制备份,如图中黑色线条所示。

当上层应用在写本 DC 存储时,会先探测本 DC 内存储节点是否可用,如果不可用,则应用会将数据写入到 DC2 中的存储节点中,如图中红色线条所示。然后DC2 中的存储节点,再尝试将数据复制写如到 DC1 的存储节点中,如图中的紫色线条所示。

RoCEv2 协议将 RDMA 迁移到了 ETH/IP 网络,使得 ETH/IP 网络支持 HPC、AI、分布式存储和集中式存储。NoF+存储网络解决方案借助 RoCEv2 技术改变了传统数据中心前端业务网采用以太网、计算网采用 IB 网、存储网采用 FC 网的异构模式,让智能无损网络实现三网合一成为可能,全部采用以太的方式部署。

审核编辑:郭婷

-

华为颠覆性磁电硬盘省电90%!功耗不到2000W 省电多达90%2024-03-08 3054

-

华为NoF+存储网络解决方案2023-12-18 3449

-

存储网络业务连续性解决方案2023-08-28 603

-

业界首个!华为首发微存储新品:1ms稳定低时延2022-11-09 1258

-

本源量子获科技部“全国颠覆性技术创新大赛”优胜奖!2022-05-10 1207

-

华为发布NoF+存储网络解决方案2021-10-28 6603

-

华为押宝新方向,中国专利申请量连续两年超美国获第一2021-04-19 2145

-

汽车产业的颠覆性变革2021-03-02 1202

-

我国颠覆性技术发展主要存在的问题和难点2018-06-07 23315

-

网络的颠覆性变革 浅谈以太网的5G蜕变2018-02-26 13943

-

颠覆性RF远距离无线充电方案已通过FCC认证2017-07-04 12075

-

应用案例-颠覆性创新金属3D打印技术助力Moto2突破极限2016-12-28 722

-

华为智能电网解决方案2011-01-12 4276

-

华为水利信息网解决方案2009-11-13 3184

全部0条评论

快来发表一下你的评论吧 !