“意念打字”新方法:每分钟能写近30个字母,错误率仅6.13%

描述

戴上一套特殊装备后,就能把自己的想法在屏幕上展示出来。

——没错,这位无法说话的瘫痪者正在“意念回复”ing……

他在脑中默读字母的“代号”*,平均约2秒钟就可以输出一个字母,最终平均字符错误率仅6.13%。

研究者表示,这种脑机接口堪称截瘫和渐冻症患者的福音:

从大脑活动中解码语音来帮患者“说话”,是一种非常有潜力的新方案!

去年,斯坦大学研究团队也给一位瘫痪且无法说话的老爷子植入了脑机接口,成果还登上了Nature封面。

虽然准确率超过了99%,但他们用的另一种方式:让患者在脑中“手写”字母。

而现在这个用脑机接口来读取大脑中“语音”的团队,来自加利福尼亚大学旧金山分校(UCSF)。

最近,他们的相关论文登上了Nature Communications。

下面就来看看这群研究者具体是如何操作的。

植入脑机接口,读取大脑“语音”

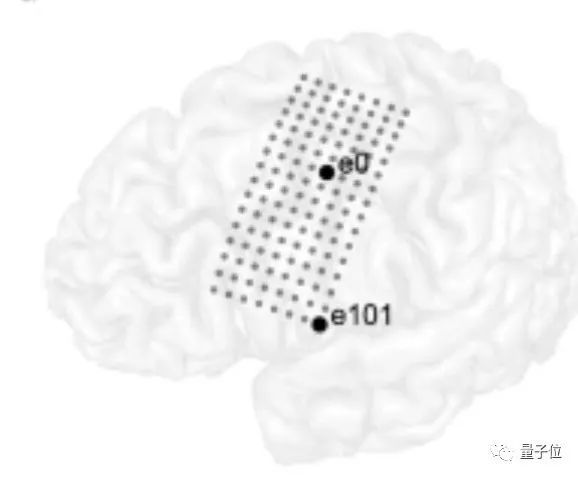

植入患者头部的设备如下:

一组高密度的电极,即128通道皮质电图(ECoG)阵列;另外还有一个经皮连接器,用来连接植入设备和外部系统。

其实早2019年,这些设备就被植入到该患者的头部。几年过去了,目前没有任何手术并发症。

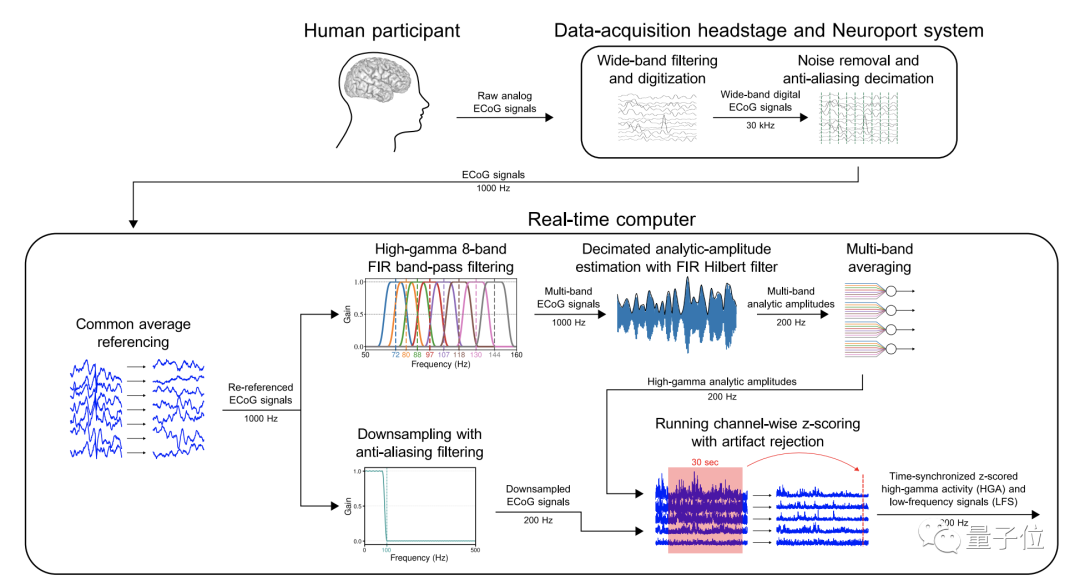

在拼写测试正式开始前,是数据的收集和预处理。

研究人员通过植入的ECoG阵列以及外部计算机系统,来提取并分析患者神经特征,包括高伽马活动(High-gamma activity,HGA)和低频信号( Low-frequency signal,LFS)等。

其中,高伽马活动是判断成年人认知功能的重要指标;而分析低频振荡则有助于判断大脑中想象的语音以及脑损伤程度。

为了提高数据质量,研究者使用滤波器对所得数据进行了降噪处理。

研究者由这些数据得出,虽然患者瘫痪且无法说话,但他的脑子基本正常。

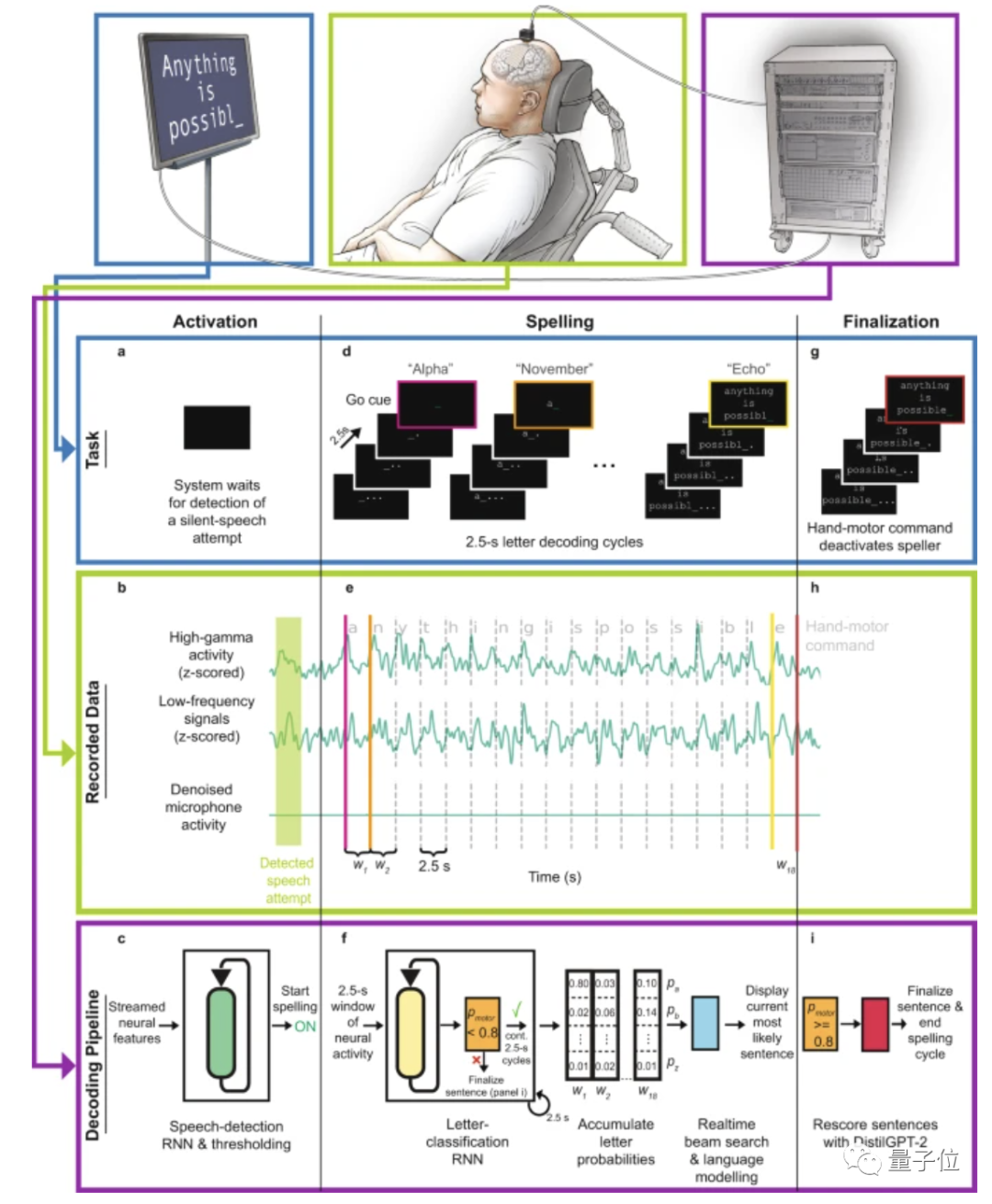

下面,拼写试验正式开始——首先,患者在大脑中默念一个单词来自动唤醒AI。

然后根据屏幕上显示出的问题,在脑子中按字母作答,并根据提示每2秒左右想象一个字母。

不过他在脑中默念的并非每个字母本身读音,而是其NATO代码(比如α代替a,β代替b)。

因为NATO代码比字母本身发音更长、更多变,按理来说应该更容易被辨别。

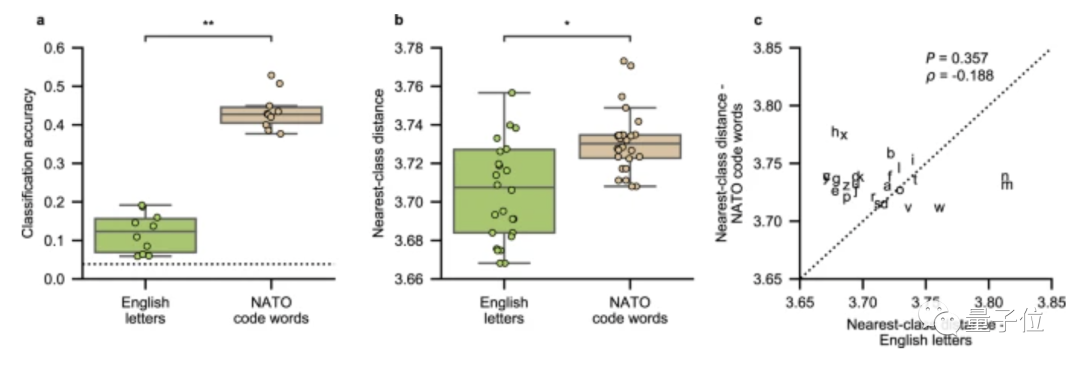

为了证明默念NATO代码发音确实比字母本身发音效果更好,研究人员还专门做了对比实验。

结果显示,默读NATO代码时,大脑神经的活动整体差异性真的比读字母原发音明显,并且总体识别准确率也更高。

在患者“意念输出”的同时,基于RNN的字母分类模型会处理每一个神经时间窗。

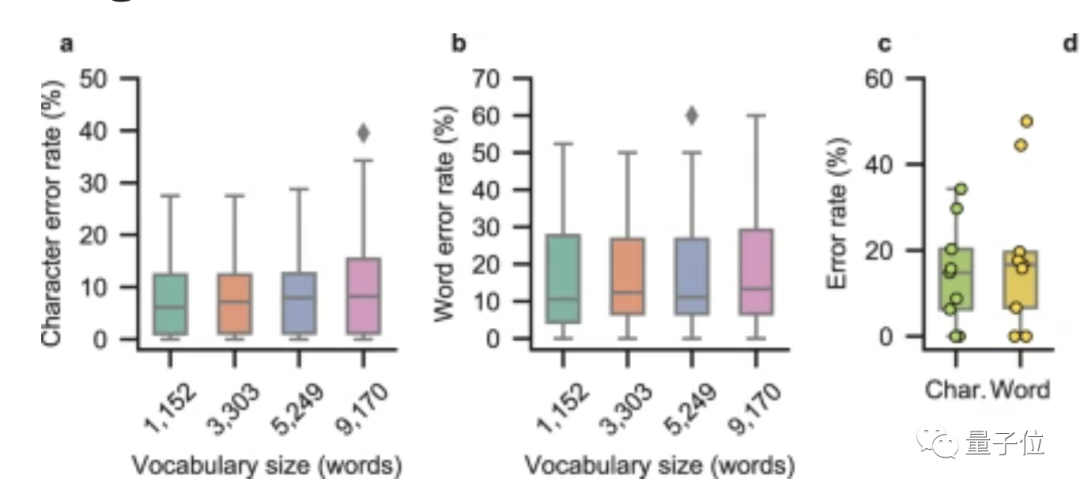

研究者设计了单词错误率(WER)、字符错误率(CER)、每分钟单词数(WPM)等指标来评估解码的句子。

结果显示,对于一个1152个单词的词汇表,字符错误率的中位数近6.13%,单词错误率的中位数为10.53%。

也就是说,患者想象的这些单词中,近九成都能一次性准确表达。

另外,研究人员还将这一方法推广到包含9170个单词的词汇表中,字符平均错误率也仅8.23%。

实际上,该团队在去年就搞出了类似的“意念输出”装备,当时他们让开头这位瘫痪且失语多年的患者成功“说话”,每分钟能表达15个单词左右。

但当时这个AI掌握的总词汇量少得可怜,只有50多个,且解码错误率约为25%。

由此可见,在一年左右的时间内,研究团队对这个脑机接口完成了飞跃式升级。

当然,他们也表示,患者目前必须按以预先设定的速度来想象字母读音(比如每2.5秒想象一个),这样还不够灵活。

而且现在的结果仅限于一个参与者,该方法效果到底怎么样,后续还需要在更多的患者中得到验证。

研究团队简介

最后,再来看看本研究背后的团队:他们来自加利福尼亚大学旧金山分校(UCSF)韦尔神经科学研究所。

UCSF是加州大学系统的十所分校之一。

论文的共同一作有3位:Sean L. Metzger,Jessie R. Liu 和 David A. Moses,他们目前均为UCSF的博士研究生。

通讯作者Edward F. Chang教授,现任神经外科医生兼UCSF神经外科系主任。

Chang教授博士毕业于UCSF,后曾到UC伯克利从事认知神经科学的博士后研究。

他的重点研究方向为语言、运动和人类情感的大脑机制,希望能借此帮助瘫痪和语言障碍患者恢复一定的正常功能。

-

测电阻,新方法,不加激励2015-03-26 5550

-

设计一个电子计时器,可是不用单片机,从99每分钟减少一,减少到0时,可以提醒2017-04-26 2836

-

求大佬分享按键扫描的新方法2022-01-17 771

-

用于测量模数转换器输出字中的位错误的FPGA固件项目参考设计2022-09-22 1259

-

异步电机额定转数是960转/每分钟,在空载及满载时的转数是多少呢?2023-11-23 2023

-

电机每分钟启停和正反转10次左右,应该算什么工作制呢?2023-12-11 692

-

相对离心力与每分钟转速的换算2009-12-25 11241

-

网上现电信版网络电话 每分钟仅0.13-0.15元2010-03-12 1538

-

AD采集的新方法资料分享2018-03-23 1149

-

一位脊髓损伤瘫痪男子利用植入到大脑的芯片打字,每分钟可打 8 个单词,创记录2018-06-12 4708

-

一种测量ADC转换错误率的测试方法2023-02-28 1649

-

使用伺服电机每分钟旋转沙钟2023-06-28 386

全部0条评论

快来发表一下你的评论吧 !