转载|数据中心网络持续进阶,超融合以太技术正当其时

描述

随着数字经济进入“算力时代”,在算力蓬勃发展的同时,打造一张与时俱进的高水平数据中心网络显得尤为重要。近日,华为联合中国信息通信研究院共同发布的数据中心超融合以太技术白皮书,就为我们擘画了一张高水平数据中心网络的新蓝图。

决定一个木桶能装多少水的往往是最短的那块木板,那么,算力时代的数据中心最短的那块木板是什么呢?

数据中心网络是实现数据传输的重要通道,也是推动数据中心算力服务能力升级,实现算力充分释放的关键。数据中心网络主要负责连接用户终端以及数据中心内部的计算、存储等设备,保障数据通信网络链路上高效、安全的传输。

《中国综合算力指数(2022年)》报告中明确指出计算、存储和网络是算力最重要的组成部分,在数字经济发展新时期,要更加关注构建集算力、存力和运力于一体的数据中心。由于网络设备算力水平无法满足要求而引发的“木桶效应”,可能会拉低整个数据中心的实际算力水平。因此,要提升数据中心算力服务能力,就需要进一步提升数据中心网络性能。

IDC分析报告显示,以太网是当前以及未来数据中心的主要技术,当前数据中心以太网占比已经接近95%。众所周知,标准以太网络采用尽力而为的工作机制,天然有丢包的特性对存储的性能稳定性带来了极大的影响。算力时代,0.1%的丢包会导致50%的算力损失。因此传统以太网已经不适应现在算力时代数据中心的要求。推动以太网进化从而搭建先进网络架构的时代已然来临,以太网正在从“尽力而为”型向“性能敏感”型网络演进。

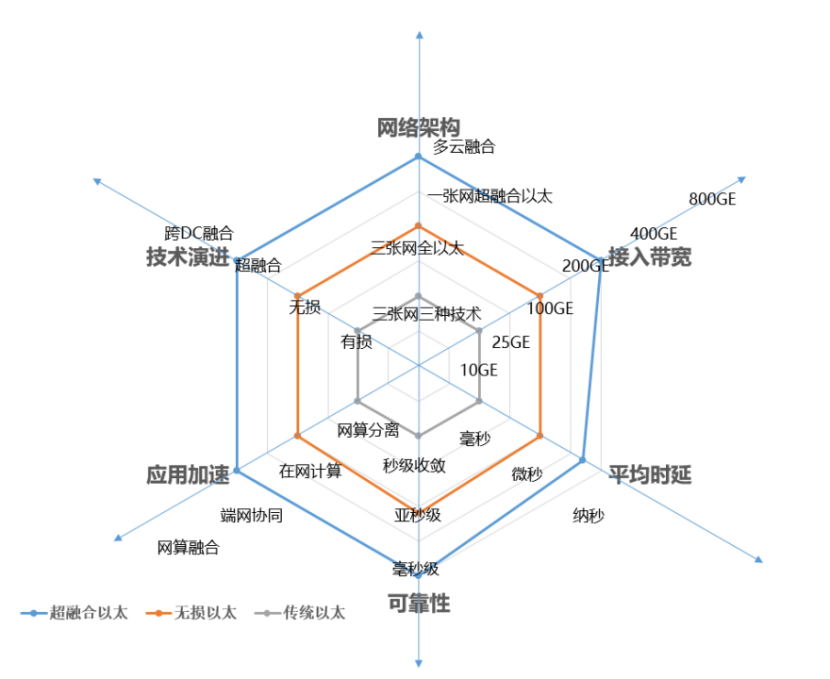

从网络架构、带宽、时延、可靠性、应用加速、网络技术演进六个方面来看,数据中心网络正在从传统以太、无损以太向超融合以太升级。

具体来看,超融合以太技术具备五大优势。

01 网络级负载均衡算法,释放AI算力

AI集群训练过程中,参数通过高速互联网络在不同的服务器间进行同步交互,这些通信流量具有共同的特征:流量成周期性、流数量少、流量长连接、并行任务间有强实时同步性要求,通信效率取决于最慢的节点,并且AI集群训练场景下,传输的数据量较大。上述的流量特征导致网络较易出现负载分担不均、整网吞吐下降的问题,从而影响AI集群训练的性能。

现有创新的网络均衡技术NSLB是面向AI训练场景量身打造的,根据该场景下的流量特征,将搜集到的整网信息作为创新算路算法的输入,从而得到最优的流量转发路径,实现AI训练场景下整网流量100%的均衡度和AI训练性能的提升。

02 端网协同拥塞控制实现存储算力优化

高性能计算、AI模型训练等应用场景,以及数据中心网络/云网络在架构上的发展(资源池化),均要求网络传输排队时延和吞吐上的进一步性能提升。

端网协同拥塞控制技术采用“端(智能网卡)网(交换机)”配合的方式达到交换机上的近似“零排队”时延,使得端到端传输时延接近静态时延。

端网协同主要根据网络可用带宽,调整端侧发送速率,这种源端与交换机之间的密切配合使网络中的队列近乎为空,同时能保持接近100%的利用率。和当前业界主流的协同算法相比,端网协同算法C-AQM能够把排队时延控制得极低,接近于0,同时瓶颈链路达到接近100%利用率。

03

数据面快速收敛

提供分布式数据库高可靠算力

随着业务发放速度的不断加快,以及引入了VM、容器等虚拟化技术,网络流量的不确定性增加。而当前运维手段有限,仍然依靠传统网管和命令行方式进行查看、监控,分钟级的网络监控已经无法满足业务秒级体验保障的要求,往往被动感知故障。故障发生后,定位仍主要依赖专家经验,利用多种辅助工具,逐段定界、逐流分析、抓包定位,效率十分低下。

网络故障收敛慢对业务稳定性产生的负面影响,尤其会造成高性能数据库类业务性能的严重下降。为了解决上述故障收敛慢的问题,华为提出了一种基于网络设备数据面的链路故障快速自愈技术,称为DPFF(Data Plane Fast Failover)。该技术基于转发芯片的硬件可编程能力构建。DPFF从传统的基于控制面软件协议的收敛方式演进到基于数据面硬件极速感知故障和快速换路的收敛方式,并且基于数据面硬件实现远程通告和快速换路,可达到亚毫秒级(<1ms)的收敛速度,将对业务性能的影响降至最低。该技术为高性能数据库、存储以及超算等关键应用提供了极致的高可靠性保证和稳定性体验。

测试结果表明,DPFF收敛方案比传统的OSPF收敛方案在链路故障下,每100ms周期内完成交易事务数量下降减少60%~80%。

04

网络架构创新

构建E/10E级超大规模算力集群

5G、万物互联智能时代产生海量数据,智能训练大模型部署,国家新一代超级计算中心的规划建设……爆炸式增长的算力需求与实际算力增长速度之间存在巨大鸿沟。在后摩尔时代,通过构建大规模并行计算集群满足不断增长的算力需求,如10E级计算集群其计算服务器规模达到20万以上。

计算集群网络传统采用CLOS架构,以业界常见的64口盒式交换机为例,3级CLOS架构,最大可支持6.5万服务器接口,不满足10E级计算集群规模诉求。如果增加网络层数则会带来网络跳数增加,通信时延不满足业务需求。

业界针对该问题开展了多样的架构研究和新拓扑的设计。直连拓扑在超大规模组网场景下,因为网络直径短,具备低成本、端到端通信跳数少的特点。以64口盒式交换机构建10万个节点超大规模集群为例,传统的CLOS架构需要部署4层组网,端到端通信最大需要跨7跳交换机。使用无阻塞直连拓扑组网,端到端交换机转发跳数最少只3跳,交换机台数(整体投资)下降40%。

05

业务级SLA保障

实现数据中心一张网

为了解决这个难题,华为提出超融合智能无损网络方案,将业务级SLA智能保障技术引入到交换机中,用iLossless智能无损算法代替专家经验,对网络流量的变化进行基于队列级捕获和预测,实现细粒度动态差异化优化。结合不同业务的流量变化情况以及业务特征,实现不同业务流量差异化动态优化保障。

根据实验室测试,采用3台华为交换机组成2级Spine-Leaf组网,每台接入层交换机下挂16台100GE服务器,Spine与每个Leaf之间采用4个400G互联(1:1收敛)。在计算和存储benchmark流量混跑的测试环境下,智能无损算法相比于传统算法配置,在保持存储持平前提下,能够有效降低计算任务的总体完成时间,在测试场景中实现最高20%以上的计算时延降低。

随着数字产业智能化向智能世界发展,未来数据中心将朝着多云异构算力演进,要构建强大的算力,需要各类资源高度协同,深度融合。新算力,对网络提出了新的诉求,下一代数据中心需要超融合以太技术给新算力进行新的赋能,以应对新的挑战。作为数据中心动脉血管新的路标,一张开放、自主的超融合以太网络将多维度与各类算力资源协同,全面提升网络性能,通过网络全栈技术的持续创新,为新算力赋能,释放更高算力,从而助力“高算力、高安全、高效能、高可靠”的新型算力中心建设。

原文标题:转载|数据中心网络持续进阶,超融合以太技术正当其时

文章出处:【微信公众号:华为数据通信】欢迎添加关注!文章转载请注明出处。

- 相关推荐

- 热点推荐

- 华为

-

适用于数据中心和AI时代的800G网络2025-03-25 2508

-

锐捷网络中标中国联通数据中心集采项目2017-01-24 3482

-

网络发展怎么改变企业数据中心的面貌的2018-08-16 1717

-

2020第十二届北京国际数据中心技术设备展览会2020-01-03 3087

-

数据中心太耗电怎么办2021-06-30 1626

-

数据中心是什么2021-07-12 1947

-

云南移动基于华为超融合数据中心网络方案实现数据中心网络云化改造2021-02-25 5221

-

超融合数据中心网络简介2021-10-19 3355

-

超融合数据中心网络架构的典型特征与价值2022-12-19 2614

-

企业数据中心超融合的现实2023-08-28 596

-

ODCC 2023 | 超融合数据中心网络,赋AI时代新动能2023-09-14 1185

-

HPC和数据中心融合网络面临的技术挑战2023-09-15 1639

-

华为全联接大会2023|超融合数据中心网络全新升级,赋AI时代新动能2023-09-21 1555

-

祝贺!《超融合以太网络总体技术要求》行业标准立项成功2023-11-28 1028

-

CloudFabric3.0超融合数据中心网络全新升级,携手共筑算力新联接2024-03-19 1649

全部0条评论

快来发表一下你的评论吧 !