昆仑芯科技产业级AI模型部署全攻略

描述

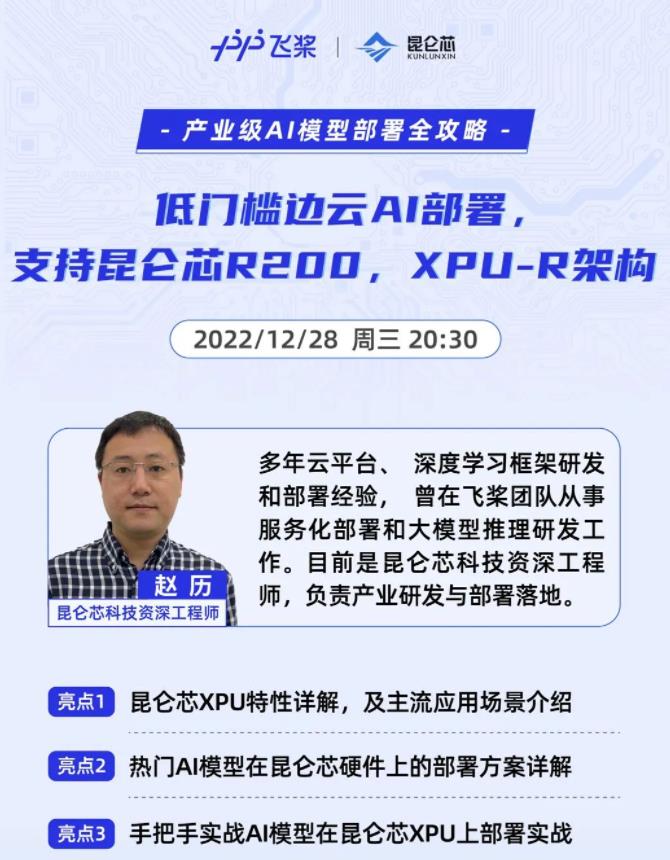

12月28日,昆仑芯科技将联合百度飞桨FastDeploy团队带来“产业级AI模型部署全攻略 -昆仑芯科技专场”直播课程,就产业AI硬件部署解决方案进行交流,届时会详细讲解昆仑芯AI加速卡R200特性,并实战昆仑芯科技硬件与FastDeploy如何快速完成AI模型部署。

共同探讨AI部署相关话题!

关于FastDeploy

为了解决AI部署落地难题,百度飞桨发布了新一代面向产业实践的推理部署工具FastDeploy,旨在为AI开发者提供模型部署最优解。FastDeploy具备全场景、简单易用、极致高效两大特点,可满足开发者对高性能部署的需求,大幅提升AI产业部署的开发效率。

全场景:多端部署,统一部署API,一行代码切换不同推理后端和推理硬件;多框架支持,一行命令实现其他深度学习框架到飞桨以及ONNX的相互转换;多硬件适配,目前支持X86 CPU、NVIDIA GPU、Jetson、昆仑芯XPU、Graphcore IPU、ARM CPU(联发科、瑞芯微、树莓派、高通等硬件)、瑞芯微NPU、晶晨 NPU、恩智浦 NPU等十多类AI硬件。

简单易用:多语言统一模型API,三行代码搞定AI模型部署。模型丰富,预置飞桨和生态的150+产业级SOTA模型,覆盖Text、 Vision、Speech 、Cross-modal 四大领域;覆盖20+主流应用场景,算法场景包括图像分类、图像分割、语义分割、物体检测、字符识别(OCR)、人脸检测、人脸关键点检测、人脸识别、人像扣图、视频扣图、图像超分、姿态估计、文本分类、信息抽取、文图生成、行人跟踪、语音合成等。

极致性能:联合自动压缩工具与推理引擎深度联动的能力以及AI模型前后预处理加速库的优化,实现AI模型端到端极致的推理性能。

关于昆仑芯科技

昆仑芯科技深耕AI加速领域10余年,专注打造拥有强大通用性、易用性和高性能的通用人工智能芯片。目前,昆仑芯科技已实现两代通用AI芯片产品的量产及落地应用,在互联网、智能制造、智慧交通、智慧金融等领域均已实现规模部署。在云端推理训练均有完备覆盖的基础上,应用于边缘场景的昆仑芯AI加速卡R100已正式发布,进一步扩充落地场景。更先进的第三代、第四代芯片产品正在研发中。

昆仑芯科技致力于构建软硬一体化的AI芯片生态,打造从芯片到终端、应用、云端、服务的生态闭环。此前,昆仑芯2代AI芯片及AI加速卡与飞桨完成III级兼容性测试,兼容性表现良好。

昆仑芯和飞桨的适配自2018年启动,目前双方已共同完成框架层面的适配,支持XPU Device及大部分算子。在双方合作的训练部分中,昆仑芯XPU和飞桨的适配在一些场景下能够做到通过仅切换一行代码便可指定到昆仑芯XPU的后端,低成本地从CPU/GPU切换到昆仑芯,满足绝大部分用户的需求。目前,昆仑芯软件栈已集成到飞桨上,完成对接与支持。此外,双方已经完成了多款主流CPU及操作系统的适配,方便广大开发者和用户更高效、更便捷地开发。

昆仑芯科技的使命是“让计算更智能”,愿景是“成为划时代,全球领先的智能计算公司”。昆仑芯科技始终致力于成为芯片创新链、产业链的“赋能者”,与上下游企业携手,通过用算力赋能不同场景中的AI应用,驱动千行百业的智能化转型。

-

智能小车的DIY全攻略2017-10-13 1277

-

FPGA开发全攻略2017-09-27 8893

-

LED调光技术全攻略2017-02-08 1141

-

LED驱动电源方案全攻略2017-01-14 1105

-

GPS设计全攻略2012-08-06 9939

-

MCU解密全攻略2011-07-11 2656

-

GPS 设计全攻略2008-09-25 14197

全部0条评论

快来发表一下你的评论吧 !