Quest Pro全彩透视效果分析

描述

售价1500美元的Quest Pro是Meta高端设备系列的第一款产品。它搭载了一系列的创新功能,例如可以提供全彩混合现实体验的高分辨率传感器,Pancake光学模组,全新时尚的设计,以及眼动追踪和面部追踪等等。

日前,近眼显示技术专家卡尔·古塔格(Karl Guttag)以“Unbelievably Bad AR Passthrough(糟糕透顶的AR透视效果)”为标题,撰文分享了他对Quest Pro全彩透视效果的分析。

下面是具体的整理:

介绍

为了演示Meta Quest Pro(MQP)显示器和光学系统的不同方面,近一个多月来我一直在拍摄照片和制作短视频剪辑。这有点像剥洋葱皮,每检测到一个问题就进行实验,并拍摄更多的照片和视频。

首先是结论:就Meta声称MQP服务于商业和工作应用的人类视觉因素而言,MQP糟糕透顶了。在这次的系列博文中,我将利用我在计算机图形、显示器和人机界面方面的40多年经验,尝试用图片和测量来量化MQP的众多问题。

我想知道的是,当他们把为电子游戏设计的产品称为“商业”或“企业”设备时,他们到底是想糊弄谁。Magic Leap的Magic Leap 1是这样,后面的MagicLeap 2也是这样。这就像市场营销人员跟你说,“对于这个价格,我们不能把它作为一种游戏系统进行兜售,它必须是一种企业产品。”

除了特定VR爱好者会对拥有多个“大屏幕”,多个显示屏感到惊讶之外,大多数人都指出将MPQ用于商业应用是十分荒谬的。我将在后续的博文种展示这种非常低分辨率的显示器有多糟糕,像素感重,视觉辐辏调节冲突,不可接受的闪烁,在商业应用中表现不佳等等。

从AR透视开始

就商业用例而言,MQP在很多方面都非常糟糕,以至于很难确定从哪里开始讲起。由于本博客专注于增强现实,所以第一篇博文将专注于AR/MR透视问题,特别是Meta在Connect 2022中的言论:

高分辨率前置摄像头捕获的像素数量是Meta Quest 2的四倍,并且使得Meta Quest Pro成为我们首款全彩混合现实设备。请想象一下物理世界和数字世界终于能够无缝交互的可能性。

我不确定Meta说的“无缝”是指什么,但我不认为MQP的AR透视效果接近字典对“无缝”一词的定义:没有尴尬的过渡、中断或差异迹象。

已经有一系列的评论主观地认为MQP AR透视的质量糟糕,而本文将尝试进行量化。

我同时应该补充一点,人类的身体构造和视觉系统更善于低头看手机,而不是抬头看低分辨率的VR屏幕。

关于图片和视频

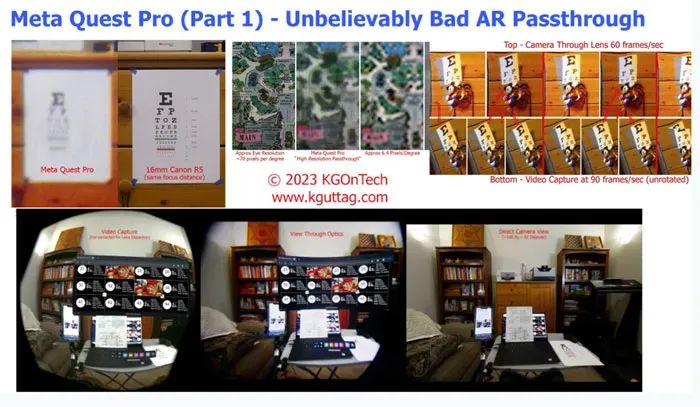

所有照片和视频都是透过Quest Pro的光学系统拍摄,并使用佳能R5 8192 x 5464像素相机拍摄。这款相机配有约16mm的镜头,FOV大致为水平106度,垂直约81度。这意味着每英寸大约80个像素,或者每个Meta Quest像素等于大约4个摄像头像素。佳能R5的分辨率接近于出色的人类视觉。在大多数情况下,我会使用经过裁剪的全分辨率图像进行讨论,而我同时提供了全分辨率的完整图像。要以全分辨率查看,你需要单击裁剪图像。

在拍摄Through Lens镜后视频时,我总是拍摄左眼,因为它更容易适配相机。所以在下面讨论的所有比较中都是使用左眼视频。

你会在透过MQP拍摄的所有照片中看到(分散注意力的)对角纱窗效果,而这同样是肉眼可见。如下面讨论,MQP中的显示器旋转,所以纱窗效果同样会旋转。

尽管相机可以产生8K视频,但视频是以4K(3860 x 2160)拍摄,由相机从更高分辨率的相机传感器缩小。我发现8K和4K视频的差异微乎其微,所以我根据情况以30fps和60fps的速度拍摄4K视频。MP4视频文件包含在内(而不是为YouTube重新压缩)。视频剪辑通常很短,可以通过单击它们来播放。我建议使用你的播放器进行观看。

关于视频闪烁的说明

你会在视频中看到闪烁和滚动的亮度带。当前的应用没有使用大肆宣传的阵列调光。但Meta发布的当前应用将LED组织成一排,以提供极短占空比的滚动照明。这将导致静态图片出现条纹伪影和视频出现滚动拖影(部分拖影是由相机的滚动快门造成)。对于静态图片,为了平均化条纹伪影,我是以低速进行拍摄,通常为1/30秒或更慢的快门速度。

尽管是这样,MQP依然存在大量的闪烁。出于某种奇怪的原因,Meta Workplace应用将快门频率降低到70Hz左右,这对于宽FOV设备而言太慢(外围视觉对闪烁非常敏感),再加上低占空比,所以存在大量对人类有害的低频闪烁。大多数应用程序使用90Hz,这对于宽FOV来说依然有点慢,但稍微好一点。对于特定房间,根据照明情况,我注意到房间照明和头显之间的差频。我计划写一整篇关于MQP闪烁问题的博文。

MQP的旋转显示器和Pancake透镜的数字失真校正

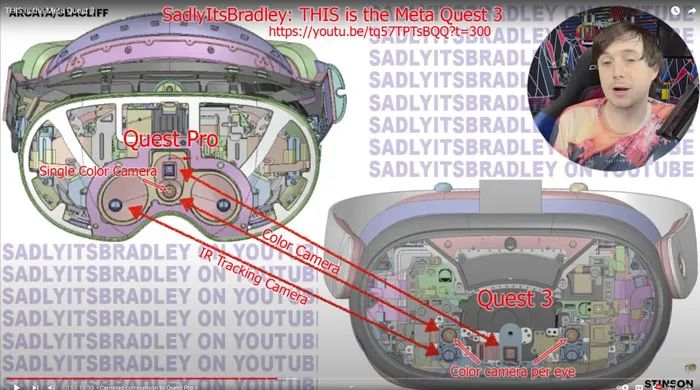

上图是从Meta Quest Developer HUB(MQDH)应用程序对MQP中两个显示器的静态捕获。这张图片混合了VR内容和AR透视。由于MQP中的物理显示器反向旋转约21度,所以图像旋转。根据Brad on SadlyIsBradley频道主持人布拉德·林奇(Brad Lynch)的说法,旋转可能有两个原因:

A)在将方形(带切角)显示器刻成稍微圆形的FOV时,为相同尺寸的显示器提供更大的垂直FOV;

B)由于使用Pancake光学元件,显示器更接近用户的面部,所以要空出一个三角形的鼻周区域。

除了旋转之外,图像同时发生了桶形失真(四边都向外弯曲)。桶形失真用于通过MQP的Pancake光学器件预校正显著的枕形失真。这确实意味着外围像素被光学拉伸,所以分辨率较低。

因为用于AR透视的摄像头没有旋转,所以每个视频帧都需要数字旋转。我的第一个想法是,旋转本身会损害分辨率。尽管如此,由于它只是透镜校正之上的众多变换之一,并且如果所有变换都在一次透视中完成(我不确定,具体可能会因应用而异),它可能不会进一步降低图像质量。

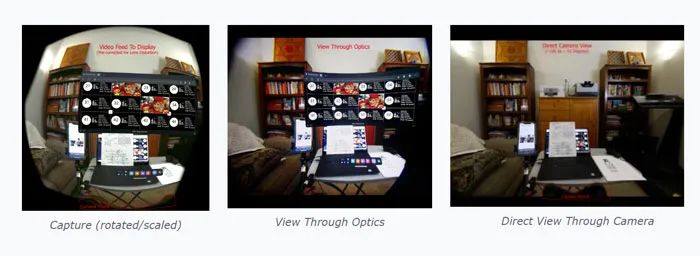

下面是左眼的MQDH视频捕获,透过光学元件拍摄的Through Lens镜后图片,以及相机视图。相机和头显分别安装在三脚架上,可以在有头显和无头显的情况下从同一地点拍摄照片。如果你看看捕获图像,很明显,它正在对显示器的透镜失真进行显著的预校正。为了与其他两幅图像大致匹配,HQDH视频捕获图像经过旋转和缩放,但未对桶形失真进行校正。从照片书柜左侧的白色墙壁和Through Lens镜后图像中可以看到,外部像素因光学失真而显著拉伸了2倍以上(并因预补偿而被压缩)。

MQDH视频捕获(左)、Through Lens镜后图片(中)和相机(右)(比例为16%)

以下是从图像中心,并按与之前相同的顺序所拍摄的全分辨率裁剪图像。

MQDH视频捕获(旋转/放大)、Through Lens镜后图片(中)和相机(裁剪、全分辨率)

以下是相应的全尺寸图像(每幅图像约为4500万像素)。

MQDH视频捕获(旋转/放大)、Through Lens镜后图片(中)和相机的直接视图(右)

AR透视的效果几乎跟盲眼一样,而且色彩糟糕

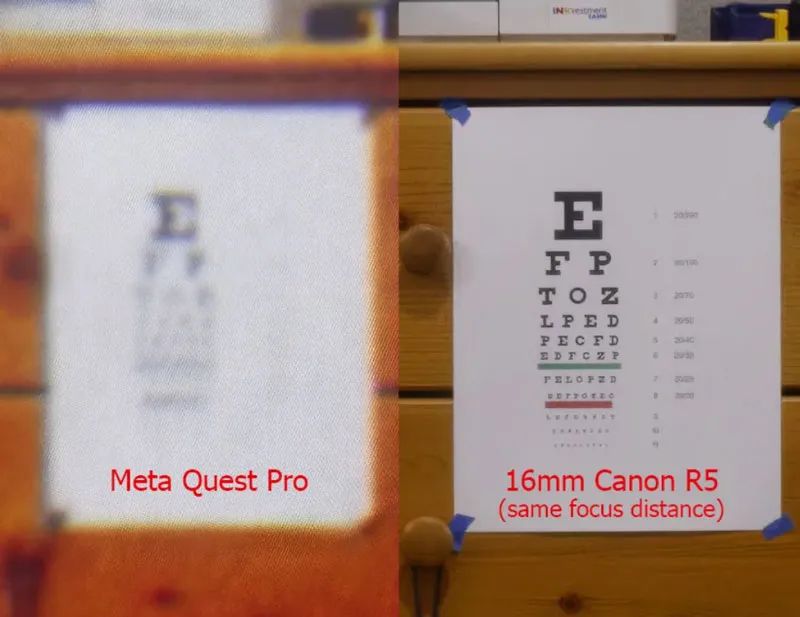

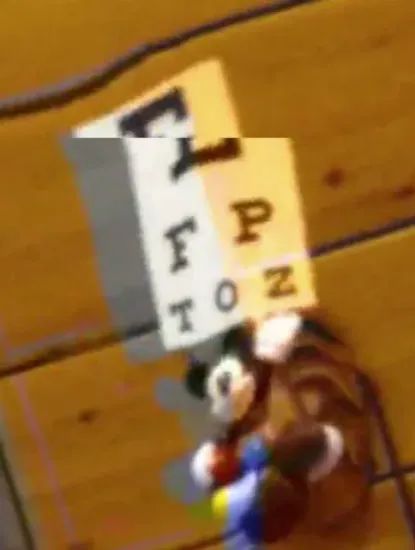

上图是通过MQP光学系统拍摄的Snellen视力表(左侧)和相机拍摄照片(右侧)。为匹配标准视力测试中距头显较短的距离,这个图表的尺寸进行了缩放。

在美国,不能阅读最上面一行的“E”表示“失明”。MQP似乎介于20/200(失明)和10/200(视力受损)之间。色彩是另一个问题,它可能会从不饱和/丢失到过度饱和。在相机视图中,橙色过饱和的木材接近于肉眼所见。

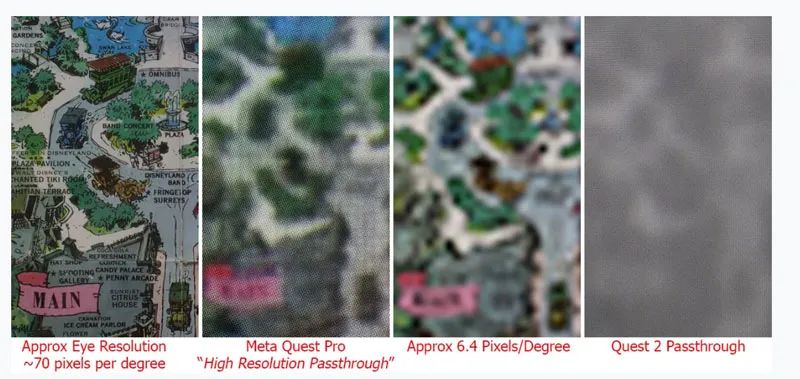

在另一个测试中,我使用了一张1962年迪斯尼乐园的大型地图,将颜色与不同层次的细节打印相结合。以下是通过MQP光学元件拍摄的Through Lens镜后图片(左侧)和相机照片(中心)。后者的拍摄角度大致相同,略微缩小以匹配MQP图像(约70像素/度)。相机图像缩放以大致匹配MQP的细节级别,然后放大到与其他两幅图像相同的大小(右)。请注意,直接使用相机拍摄的未缩放图像和通过MQP拍摄的图像尺寸非常接近。

为了简单起见,我在下面列出了每个图像的中心区域。我在最右边的Quest 2的Through Lens镜后裁剪图片。

这个测试得出的结果与Snellen视力表大致相同。佩戴Meta Quest Pro时,最佳中心视力约为良好人类视力的1/10。

自底向上的计算

MQP采用“自底向上”的分辨率,单眼1280 x 1024像素黑白追踪摄像头,在裁剪、旋转和桶形变形的过程中重新采样,从而生成要显示的图像。重采样过程应该会产生大约500 x 500像素的图像,或者单眼大约85度,每度大约6个像素。

下面是一个20秒的4K视频,通过左眼光学系统拍摄,使用的是16mm镜头的佳能R5相机。所述相机可以捕获几乎整个水平FOV和垂直FOV的75%。PC的数字计数器每秒仅更新约10次,以在镜头和视频捕获之间提供大致同步(稍后显示)。相比之下,钟摆给出了恒定的模拟计时。

极低动态范围和高失真

启用MQP透视时的动态范围(从暗到亮)只能用可怜来形容。使用对红外敏感的追踪摄像头意味着任何明亮或发光的物体都会发出白光。没有充分照明的元素都会产生非常高的噪点。下面的视频说明了动态范围的问题,以及启用AR透视时的极端失真和颜色问题。尽管近距离物体更糟糕,但远距离物体同样会发生奇怪的扭曲。MQP将糟糕的AR透视带出了新的下限。

4K Through Lens镜后视频

下一个短视频片段显示了查看纸质文档和其他问题,例如照明。PC的图像可以在KGOnTech的测试模式下获得。

这个4K视频演示了查看纸质文档的问题

30Hz帧速率和颜色滞后

下面的视频显示了PC的计时器和挥舞着迷你Snellen视力表的钟摆米奇。PC的计时器每秒更新6.6次,挥舞的米奇提供连续的模拟运动。结合大致时间戳的大钟和挥舞米奇,我可以将Through Lens镜后视图和MQDH的视频捕获同步到同一帧。为了防止MQP摄像头泛白,PC必须设置为接近最低亮度,这样我就可以读取计时器。

4K 60Hz帧速率视频

捕获与上述Through Lens镜后视频相同的视频序列

我可以用很多形容词来描述MQP的透视图像质量,但Meta所说的“无缝”不是其中之一。首先要注意的是失真,尤其是围绕着米老鼠和摆动视力表。你同时可以看到颜色是如何非常接近并滞后于运动。

尽管MQDH视频捕获的颜色看起来相当准确,但通过Through Lens镜后视频的颜色过饱和。对于透视模式,这种过度饱现象可凭肉眼感知。当使用VR时,颜色看起来相当准确,所以透视模式的颜色质量之差有点令人困惑。

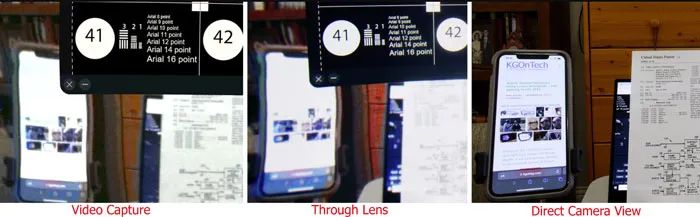

下面放大的静止帧将Through Lens镜后视图与直接视频捕获进行比较。为了进行这个比较,MQDH视频捕获经过旋转和缩放(在以后的捕获中,它不会被旋转)。注意缺少的颜色间隙以及图像中的失真量。

左为Through Lens镜后视图,右为视频馈送(经过旋转和缩放)

各种帧速率不同步

尽管帧速率约为90Hz,而且Meta Developer应用的视频捕获率同样约为90Hz,但速率略有不同,导致大约每捕获第三帧,就会在捕获过程中出现撕裂(见下图)。

另外,视频捕获中的撕裂无法在Through Lens镜后视图中看到。上面捕获的帧避免了这种撕裂帧。裁剪帧显示了其中一个撕裂。这表明视频捕获与视频源到达显示器不同步。视频以比视频捕获更高的帧速率捕获,因为视频捕获中存在重复的帧。

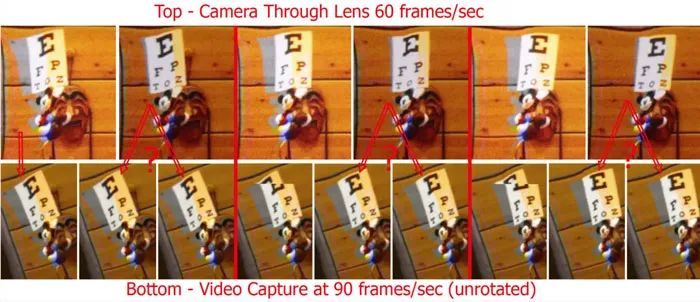

捕获的视频源不是发送到显示器的内容

最初,我假设捕获的MQDH是发送给显示器,但事实并非如此。捕获的视频是90Hz,但捕获帧以大约30Hz的频率变化。然而,在60Hz的Through Lens镜后视频(下面的顶行),每一帧都是唯一,但整个拍摄对象仅以30Hz的频率移动。由于相机的频率约为60Hz,MQDH捕获频率约为90Hz,因此每三个捕获帧大约有两个相机帧。

如果你仔细观察Through Lens镜后视频的帧序列,你应该注意到在每一对由红线分隔的帧中,米奇都不会移动。相反,颜色会移动,移动的内容会发生不同的变形。该对中的第一帧与MQDH捕获中的一帧完全匹配,但第二帧是唯一的。我没有现成的90Hz帧速率相机,但我怀疑当显示器以90Hz运行时,图像会以90Hz的频率变化,而60Hz的相机会在三帧之间获得两帧。

运动到光子延迟

我曾看到有评论家指出,结合了双眼的视频馈送看起来比肉眼所见要好。遗憾的是,由于有bug的软件和MQDH应用中的无用消息,我无法通过MQDH捕获更高质量的视频(只有分辨率较低的30fps头显录制和投屏)。

看起来的情况是,所捕获到的内容与所显示的内容不同且更好。我怀疑发送到眼睛显示的处理优先于运动到光子延迟,而不是绝对质量。他们希望尽可能快地向眼睛提供新信息,而视频捕获可能会优先考虑图像质量而不是延迟。

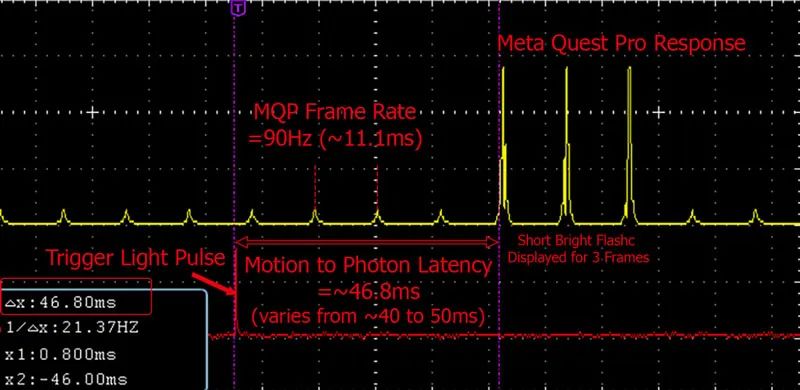

我同时做了一个小实验:在光线昏暗的房间里,我让相机闪光灯熄灭,用一个传感器触发示波器的捕获,用第二个光传感器捕获显示响应,用光传感器测量延迟。闪光灯通常需要四个90Hz以上的帧时间(约40到50ms)才能显示在图像。在下面的捕获中,你可能会注意到响应(黄色)是三个阶梯式的低占空比脉冲。MQP的照明LED仅在极短的时间内点亮。不同排的LED以滚动顺序发光,从而形成阶梯图案。在未来的博文中,我计划详细介绍MQP的LED阵列照明。与视频捕获一致,闪光灯以90Hz或30Hz显示三帧。

科研项目出错还是营销决策?

我的第一反应是,MQP的透视功能最初只是为了给游戏玩家提供一种优于Meta Quest 2的体验,帮助他们在定义边界时看清周围环境。但后来Meta的高层指出,它需要成为一种“混合现实”设备。同时,具体的实现表明这是“一个逃离实验室的实验”。或许真正的答案是,MQP的透视功能有点二者兼而有之,研究人员希望通过展示技术并以更大规模实验技术,而公司则希望将产品营销为一种混合现实设备而不仅仅只是虚拟现实。

灵感来自鲁布·戈德堡(Rube Golberg)的全彩透视

Meta Quest Pro的AR透视灵感似乎来自鲁布·戈德堡。这个人以描绘过于复杂的机器而闻名。

根据布拉德·林奇的说法,Quest Pro的AR透视使用两台低分辨率IR追踪/SLAM摄像头(标称分辨率为1280×1024)来为每只眼睛的显示器提供亮度信息,并结合一台1600万像素的彩色摄像头为每幅图像上色。但正如接下来的说明,实际的分辨率要差得多。

理智与疯狂:三维空间优先于图像质量

Meta的工程师们必须明白,将一台彩色摄像头与两台追踪优化摄像头相结合会严重影响图像质量。正如我常说的一样,“当聪明人做出看起来很愚蠢的事情时,那是因为他们试图避免出现他们觉得会更糟糕的事情。”在这种情况下,他们愿意牺牲图像质量,试图让现实世界中的物体位置与虚拟物体的出现位置一致。在某种程度上,他们已经实现了这一目标。但图像质量和失真程度之差,尤其是“近距离对象”(包括用户的手),这似乎是一场代价高昂的胜利。

林奇的报道指出,Meta Quest 3将拥有两个高分辨率彩色摄像头,每只眼睛一个,而不是像MQP那样共享一个彩色摄像头。这将提供更好的图像质量并减少一定的问题。然而,当他们试图基于实时追踪和深度感测摄像头信息映射真实世界的相机图像时,失真依然可能存在。另外,根据林奇的说法,AR透视过程非常耗费处理器,功耗大幅增加。所以我们不禁怀疑,要获得出色的图像质量,这到底需要进行多少处理。

AR透视问题(MQP之外)

在2022年6月,我与林奇讨论了AR透视(带摄像头的VR)的普遍优点和缺点。下面概述了视频中解释的众多要点。我不会再次重复,你可以参考这个视频。

AR透视的优点:

潜在更好的虚拟图像质量

硬边缘遮挡变得轻松

更简单和成本更低的光学元件和透镜

虚拟图像不必与环境光线竞争,并且可以节省能耗

AR透视的缺点:

真实世界的固定焦点

亮度动态范围远低于现实世界

分辨率低于现实世界

运动到光子延迟

摄像头到眼睛的不完美对准

外围视觉和环境光问题

这可能是危险的“VR到ER(抢救)”

上面没有提到但我有在视频中讨论过的一个主要问题是,AR透视通常是不安全的,因为从撞到物体到被设备和车辆撞到,它可以通过各种方式掩盖现实世界中的危险。林奇指出,在VR社区,这被称为“VR到ER”。

MQP的透视模式仅缓解了一定的VR视觉安全问题,以下是剩余的问题:

头显依然会遮挡大量视线

VR内容完全阻挡了现实世界

动态范围如此之差,以至于现实世界中的明亮对象会完全遮蔽

现实世界中的分辨率很差(这是本文的主要主题)

透视视频可能高度失真

Meta的律师知道“VR到ER”的问题,因为设备告诉你留在没有障碍物的室内,并让你划定电子边界。但实际上,如果你画了一个足够小的边界来保护你,你会经常被视觉边界警告所困扰。要避免无需经常烦恼,你需要完全清空房间。尽管如此,当你在虚拟世界中过快伸手触摸什么时,你依然有可能撞到物理对象。

这只是明显的安全问题,其他还有人为因素安全问题,并在长期“接触”所述产品时造成问题,包括视觉辐辏调节冲突和闪烁(这似乎没有人关心,我会在未来的文章中更详细介绍)。

结论:远未成熟。为什么?

MQP的透视模式虽然比Meta Quest 2有了很大的改进,但离用作AR/MR设备尚十分遥远。我对Lynx的AR透视有看法,但它离MQP的翻车质量还很远。MQP的透视模式勉强可用于在现实世界中查找大型对象并为VR应用设置边界。

它在AR透视方面非常糟糕,这让我怀疑Meta为什么声称它是一款混合现实设备。有人猜测,这是为了在苹果MR头显之前声称自己率先拥有MR设备。

即便Meta大大提高了透视模式的图像质量,但如果没有VR的典型限制(没有障碍物的安全室内),它是否能安全使用值得怀疑。Meta在这一领域已经投资了300多亿美元,而MQP是标价1500美元的“专业”设备所能产生的结果。

从人类视觉因素的角度来看,Meta Quest Pro存在很多问题。他们甚至能够把闪烁之类的简单答式弄错,更不用说更难解决的问题了,比如视觉辐辏调节冲突(VAC)。

可以说,MQP强化了我在林奇频道中讨论的AR透视的诸多缺点。

审核编辑:刘清

-

9*18 全彩 极光 效果展示 资料2017-06-22 3439

-

红外热成像的透视功能演示2018-10-12 8686

-

数据透视表与交叉表简介2019-10-31 2021

-

CCD与CMOS影像感光元件结构透视与分析,不看肯定后悔2021-06-03 3362

-

放大镜查看图片显示透视效果jQuery源代码2021-03-16 886

-

LED全彩控制器的概念与接线方法2022-06-28 6376

-

多台全彩控制器怎么接同步线?LED全彩控制器怎么接同步线?2022-10-07 6437

-

【机器视觉】欢创播报:Meta发布新一代头显Quest Pro2022-10-14 1789

-

Meta Quest Pro VR硬件拆解评测解析2023-01-09 5836

-

Meta和LG开发新款Quest Pro头显,与苹果Vision Pro竞争2023-09-08 1379

-

Meta Quest v64 系统升级:优化摄像头透视效果,新增外置麦克风支架2024-04-09 1636

-

苹果Vision Pro与Meta Quest 3/Pro内部性能差异比较2024-04-10 1489

-

Meta停产高端VR头显Quest Pro2024-09-27 982

-

Meta Quest Pro头显全球停售,销量不佳致系列被砍2025-01-07 1517

-

【awinic inside】艾为芯 + 全彩刻蚀光波导!雷鸟AI眼镜 X3 Pro震撼上市2025-06-06 1684

全部0条评论

快来发表一下你的评论吧 !