服务器的主板及电源介绍

描述

服务器是一种为客户机提供服务的高性能计算机。关于服务器最全分析材料请参考文章“终极版:服务器基础知识全解(182页PPT)”。

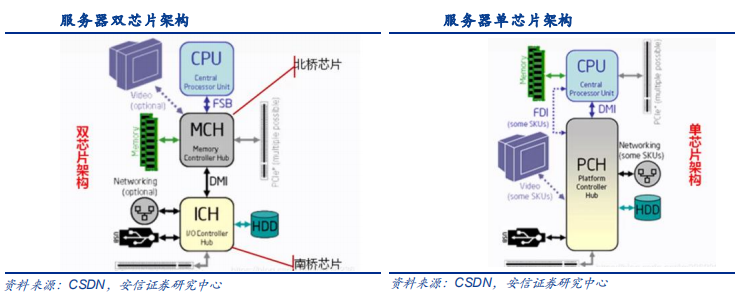

主板芯片组以前均采用双芯片架构,即 MCH+ICH(北桥芯片+南桥芯片,MemoryController Hub+ I/O Controller Hub),2012 年 Intel 推出单芯片架构后成为主流,即北桥芯片被集成到 CPU 中,南桥芯片改为 PCH(Platform Controller Hub,平台管理器中枢)。未来,PCH 有进一步集成到 CPU 中的趋势。

南桥芯片(South Bridge,SB)/PCH:处理输入输出(Input/Output,I/O)数据,负责 PCIe 总线、USB、ATA、SATA、音频控制器、键盘控制器、高级电源管理和实时时钟控制器等间的通信。位于主板上离 CPU 较远的下方,原因是连接的 I/O 总线较多,远离 CPU 有利于布线。南桥芯片最初发展方向是集成主板上更多的通信功能,如网卡和 RAID 等,但 AMD 锐龙低端芯片组许多产品取消了南桥,只支持 CPU所支持的拓展,AMD 最新 Zen2 架构平台上,南桥仅使用 PCI-E X4 通道和 CPU 连接,将通道拆分后支持几个 PCIe 接口、USB2.0 和 SATA 接口。

北桥芯片(North Bridge,NB):负责 CPU 与内存、加速图形显卡(Accelerated GraphicsPort,AGP)以及 PCIe 总线的通信协调,位于主板上离 CPU 最近的位臵,从而缩短传输距离提高通信性能。北桥芯片最初仅作为内存控制器出现在主板上,此后又扩展了各种控制器,如加速图形显卡。但由于延迟大和故障率高等问题,逐渐被取消。Intel 于2012 年推出单芯片架构,只保留南桥芯片(改名为 PCH,Platform Controller Hub),将北桥芯片集成到 CPU 中,以 PCIe 控制器和内存控制器的形式分散存在于晶圆的不同位臵。

随着 CPU 集成度不断强大,主板芯片组的功能有被弱化的趋势,CPU 厂商对芯片组的话语权也在持续提高。服务器芯片组生产商曾经生产包括 Intel、AMD、Nvidia 和 VIA(台湾威盛)等,目前 Intel 和 AMD 占据主要市场份额,尤以 Intel 为甚,部分国产 CPU 参与者由于设计能力欠缺采用 Intel 或 AMD 的芯片组。

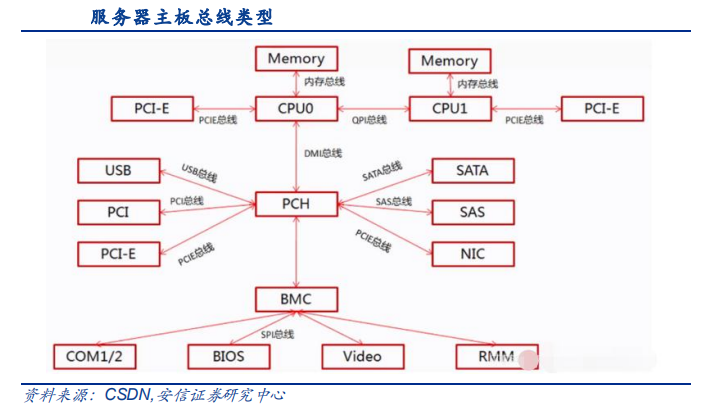

总线是主板传输数据的“道路”,负责 CPU 与芯片组(PCH)、PCH 与功能芯片的连接,包括 QPI、PCIe、DMI、SATA、SAS、SPI 总线等。其中,CPU 与 CPU、CPU 与 PCIe 设备分别通过 QPI 总线和 PCIe 总线连接,PCH 与 USB、SATA 硬盘、SAS 硬盘和网卡等分别通过 USB 总线、SATA 总线、SAS 总线、PCIe 总线等连接,BMC(Baseboard Management Controller,基板管理控制器)与其他设备通过 SPI 总线连接。

PCIe 总线,负责连接扩展 I/O 设备,具有高速低时延的性能,满足服务器高速运算、快捷访问数据、访问外设和访问网络的需求。由于是对前两代(ISA 和 PCI/PCI-X)的升级,PCIe总线又被称为第三代 I/O 总线(3GIO),相比于前两代,数据传输速率更高、传输距离更远、功耗更低、抗干扰能力更强,可以连接各类高速扩展设备,典型如加速图形显示处理器 GPU(Graphics Processing Unit),此外还有 AI 加速卡、PCIe 网卡和视频监控卡等。

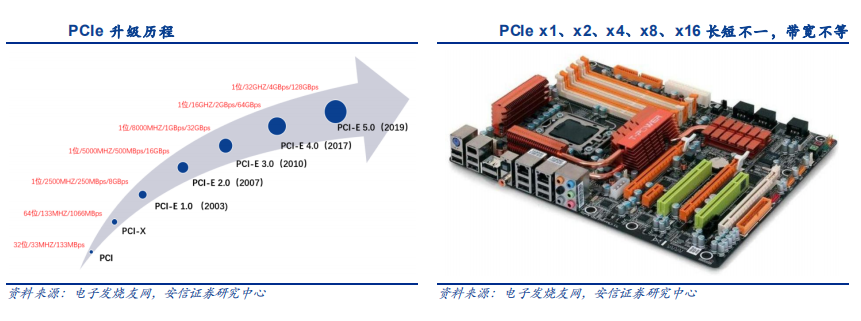

传输速率和带宽大小是 PCIe 总线的核心性能,围绕这两大性能,PCIe 总线有特定的升级标准,该标准自 2001 年确定 1.0 至今,经历了 2.0、3.0 和 4.0 时代,在 4.0 确立之前,大概按照每三年一代的周期实现性能指标升级。PCIe 标准由特殊兴趣组织 PCI-SIG 组织负责发布,该组织最初由 Intel 牵头设立,目前拥有近 800 名会员。2017 年,PCI-SIG 发布 PCIe 4.0标准,2019 年 5 月发布 PCIe 5.0。预计 PCIe 6.0 也将于 2021 年发布。

PCIe 1.0、2.0、3.0传输速率分别为2.5GHz、5GHz和8GHz,单lane带宽分别达到250MB/s、500MB/s 和 1GB/s。PCIe 总线由不同 lane 连接,多个 lane 合在一起可提供更高带宽,两 个单 lane 合成 x2,两个 x2 合成 x4,两个 x4 合成 x8,目前最大为 x16,带宽需求大的加速显卡需使用 PCIe x16。从主板插槽形态上看,x1 最小,x16 最大。PCIe 4.0 可以带来最大64GBps 的吞吐量(PCIe x16),而 PCIe 5.0 则增加到 128GBps(PCIe x16)。

标准从落地到商用仍有一定周期。虽然 PCIe4.0 标准早在 2017 年发布,但是根据 Intel 产品路线规划图,适配 PCIe4.0 的 CPU 规划在 2020 年 Q2 以后发布的 Whitley 平台第二代 IceLake 中出现,而适配 PCIe5.0 的 CPU 规划在 2021 年发布的 Eagle Stream 平台出现。因此预计 PCIe6.0 商用还有至少三年以上。

PCIe高速设备包括 GPU、AI 加速卡、视频监控卡、PCIe 接口 SSD 和 PCIe 网卡等,伴随PCIe 升级至5.0,通过 PCIe 总线连接 CPU 的以上高速设备有望同步升级。

PCIe总线属于串行点对点双通道传输,在 x86 系统中体系架构主要由 root complex、switch和 endpoint 三类 PCIe 设备构成。BDF(Bus、Device、Function)构成每个 PCIe 设备节点的身份证号,一般 PCIe 协议支持 256 个 Bus(总线), 每条 Bus 支持 32 个 Device,每个 Device 支持 8 个 Function。PCIe 总线标准升级带宽翻倍的同时,外接的 PCIe 设备带宽可以实现更大提升。根据 PCI-SIG 官方显示,使用 PCIe 总线与 CPU 通信的服务器 I/O 扩展设备,带宽每三年翻一倍。

“CPU+芯片组+总线”平台升级按照 2~4 年周期向前推进,由于 CPU 内部主要集成内存控制器和 PCIe 控制器,内存和 PCIe 总线是平台升级的两大关键,需要同时配合 CPU 的升级进度实现性能提升。2017 年 7 月 Intel 发布的 Purley 平台(包括 Skylake 和 Cascade Lake两代),相较于上一代 Grantley 平台:

(1)通道增加 50%,支持 6 通道DDR4;

(2)PCIe接口增加 20%,支持 48 个 PCIe3.0 接口。此外,采用全新的 6*6 的 Mesh 互连架构,I/O位于顶部,内存通道在两侧居中的位臵;CPU 由上一代最大 24 核提升至 28 核;CPU 之间的互连从 9.6GT/s 的 QPI,升级为 10.4GT/s 的 UPI。

根据Intel 规划路线,最新一代 Whitley平台于 2020 年发布,包括 Cooper Lake 和 Ice Lake两代,按计划分别于年初和 Q2 面世。其中,Cooper Lake 沿用 PCIe3.0 通道;Ice Lake 将首度支持 PCIe4.0。下一代 Eagle Stream 平台于 2021 年发布,包括 Sapphire Rapids 和Granite Rapids 两代,分别于 2021 年初和 2022 年初面世,同步支持 PCIe5.0。

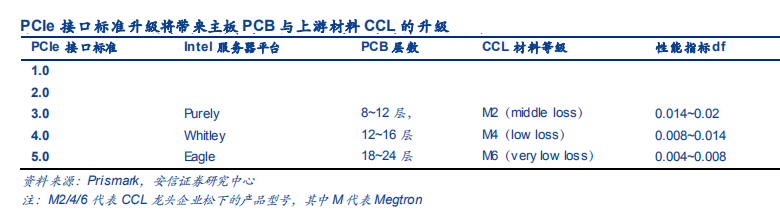

在使用 PCIe3.0 接口的情况下,信号传输速率为 8Gbps,服务器主板 PCB 在 8~12层时就可以满足要求,相对应的CCL 材料 Df 值在0.014~0.02 之间。未来,对于 PCIe4.0接口 16Gbps 的传输速率,PCB 层数需要相应提高到12~16 层,CCL 材料 Df 值在0.008~0.014 之间,以 FR4 为主,处于中损耗等级;而对于 36Gbps 传输速率的 PCIe5.0接口,PCB 层数需要达到 16 层以上,CCL 材料 Df 值需要低于0.008。

PCIe5.0 标准落地,但距离芯片商产品兼容尚需时日,目前 Intel Purely 和 Whitley 平台分别兼容 PCIe3.0 和 4.0,兼容 5.0 的 Eagle 平台正在开发中,因此假设 2019 年服务器产品以低等级的 3.0 为主,到 2020 年 Whitley 平台渗透率可提升至 50%,到 2021 年 Eagle平台实现落地商用;

服务器主板 PCB 使用规格受服务器类型的影响,从全球服务器发货量来看,双路服务器占据主导位臵,因此我们采用保守估计的方法,按照双路服务器 45cm*45cm 的规格计算主板 PCB 使用需求;此外,服务器内除主板外、I/O 板、硬盘和背板等也是高速 PCB 的关键应用场景。

机箱主要由箱体、硬盘背板、电源、电源背板、散热风扇、硬盘支架、线类和接头、以及开关和指示灯等组成。由于 CPU 平台换代升级导致功耗增加,服务器机箱散热和电源模块方案同步发生变化。一方面改善供电方案,提高电力使用效率,在降低成本的同时还能简化运维;另一方面,采用更好的温控和散热系统,目前液冷已经成为数据中心制冷新风尚。

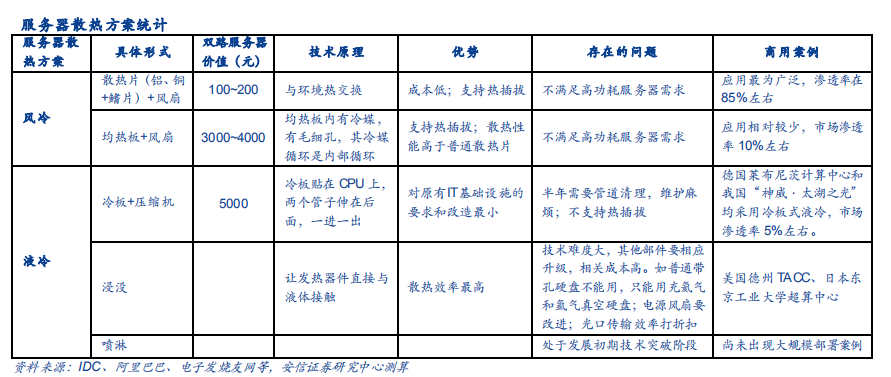

数据中心温控系统主要包括空调机组、气流组织和服务器散热:

(1)空调机组从风冷型、水冷型向冷冻水型、双冷源型过渡,气流组织也从传统的机房级向更精准的机柜级演进;

(2)服务器功率大幅提升,液冷(冷板、浸没、喷淋三种部署方式)逐渐取代传统风冷成为新模式。

数据中心电源需求包括两块,一部分是机房系统供电,另一部分是单台服务器模块电源供电。数据中心规模化建设或将带动系统供电需求,服务器需求增加、CPU 功耗提升或将带动模块电源量价齐升。

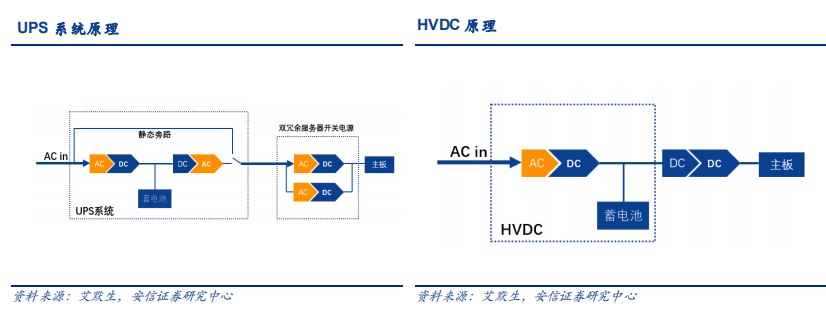

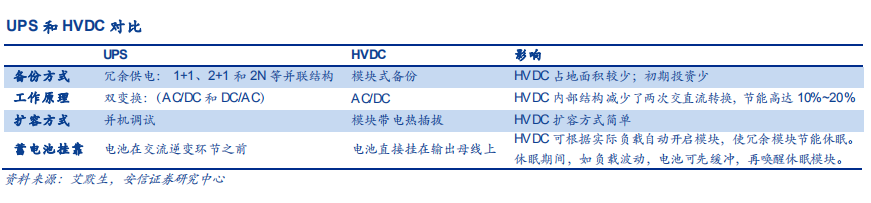

数据中心供电方式有传统 UPS(Uniterruptible Power Supply,不间断供电)和 HVDC(HighVoltage Direct Current,高压直流)两种。

UPS 工作原理是市电输入 UPS 系统,经过整流器将交流电(AC)转换为直流电(DC),一部分直流电源为蓄电池充电,其余部分通过逆变器转换为交流电(AC)为服务器机柜供电。当市电不正常时,由蓄电池经逆变器向服务器机柜供电。这种系统大大提高供电的稳定性,成熟度高且广泛使用。

HVDC 高压直流是一种输入市电交流电,输出直流电的电源(UPS 输入和输出均为交流电的电源)。相较于 UPS,HVDC 在备份、工作原理、扩容以及蓄电池挂靠等方面存在显著的技术优势,因而具有运行效率高、占地面积少、投资成本和运营成本低的特点,正逐步获得通信基站运营商和数据中心云服务厂商的青睐。

-

京准电钟:GPS时钟服务器(NTP授时服务器)资料详细介绍书2024-06-18 1545

-

#硬声创作季 云计算基础入门:oldboy-16-服务器零部件主板介绍Mr_haohao 2022-10-16

-

集特 国产龙芯3C5000+7A2000单路服务器主板GS0-3001#龙芯服务器主板 #国产主板jf_32772783 2024-02-21

-

组装服务器和品牌服务器2017-05-25 4528

-

服务器电源维修故障系列2021-11-12 2208

-

上海回收联想二手服务器,服务器存储回收,服务器主板回收2021-12-09 792

-

服务器电源线的相关资料推荐2021-12-31 2357

-

服务器电源2009-12-17 676

-

详谈服务器电源2009-12-26 2844

-

冗余服务器电源介绍2010-02-06 3102

-

服务器电源维修哪里便宜,服务器电源维修2021-11-07 1159

-

服务器电源线的分类及应用2022-01-10 2038

-

深度学习服务器怎么做 深度学习服务器diy 深度学习服务器主板用什么2023-08-17 1405

-

服务器电源技术及标准介绍2023-10-27 593

-

龙腾产品在服务器电源上的应用优势2023-11-11 1810

全部0条评论

快来发表一下你的评论吧 !