内存计算IMC用于人工智能加速方面的研究进展

描述

内存计算

内存计算(In-memory Computing ,简称IMC)似乎是EnCharge AI实现高效率和低功耗的关键因素。该公司在其网站上列出了2019年、2020年和2021年的四份出版物,展示了他们在改善IMC用于人工智能加速方面的研究进展。

他们最早的出版物指出,机器学习计算严重依赖于矩阵向量乘法(MVM),虽然数字加速器相对于普通处理器提供了10-100倍的能效和速度改进,但这些收益主要是在计算方面,而不是在内存访问方面,即所谓的“内存墙”。在内存中来回移动数据在功耗和时间上都有很高的成本。

虽然IMC可以降低功耗和延迟,但在读取内存位时,需要权衡更差的信噪比(SNR)。信噪比问题在异构系统中对IMC的扩展提出了挑战,而异构系统是最有可能在实际应用中使用IMC的场景。

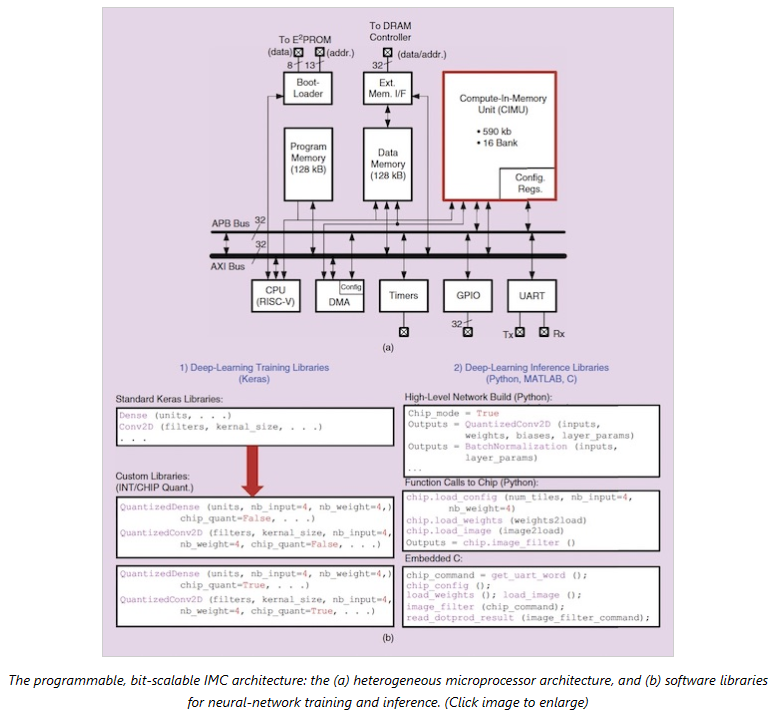

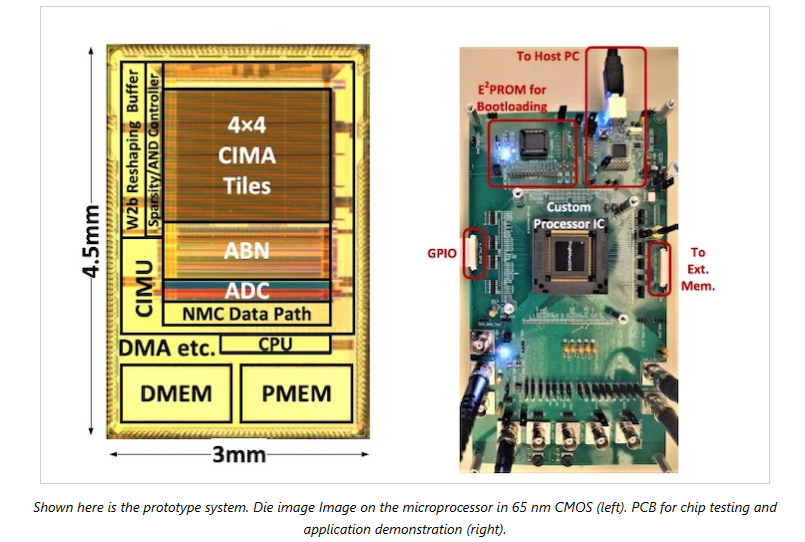

2020年,该研究团队致力于解决信噪比问题,开发了一种利用charge-domin IMC的可编程异构架构和配套的软件堆栈。原型基于65纳米CMOS实现。

2021年,该团队引入了基于电容模拟计算,以提高从二进制矢量输入到5-b矢量输入的动态范围,并在协同设计算法方面取得了进展,改善了内存映射。

审核编辑:刘清

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

深度学习在自然语言处理方面的研究进展2018-07-19 7981

-

FPGA在人工智能中的应用有哪些?2024-07-29 8113

-

嵌入式和人工智能究竟是什么关系?2024-11-14 3865

-

薄膜锂电池的研究进展2011-03-11 2951

-

人工智能是什么?2015-09-16 6263

-

人工智能的前世今生 引爆人工智能大时代2016-03-03 5789

-

人工智能的就业方向详解2018-04-24 14325

-

天津大学与中科视拓共建“人工智能联合实验室”2018-05-25 7236

-

人工智能医生未来或上线,人工智能医疗市场规模持续增长2019-02-24 5630

-

什么是基于云计算的人工智能服务?2019-09-11 5692

-

【瑞芯微RK1808计算棒试用申请】准备试下中控,准备带孩子学习下RK1808人工智能计算棒AI加速器等应用。2019-09-18 1868

-

人工智能在哪些方面可以对IT运营产生重大影响 精选资料分享2021-07-12 2708

-

物联网人工智能是什么?2021-09-09 5175

-

AI人工智能计算棒RK1808 Al Compute Stick介绍2022-08-15 2454

-

2018年人工智能研究进展及未来AI发展的三个主要趋势详解2019-01-04 3709

全部0条评论

快来发表一下你的评论吧 !