3D视觉感知底层技术与产业应用

描述

奥比中光是一家专门做3D视觉感知技术的公司。我们为什么要做三维相关的东西?其实还是应用驱动。三维相关的应用变多了,如智能检测识别、6DoF定位、机器人SLAM等,而原来的2D信息则越来越不够用。

为什么需要三维感知技术?

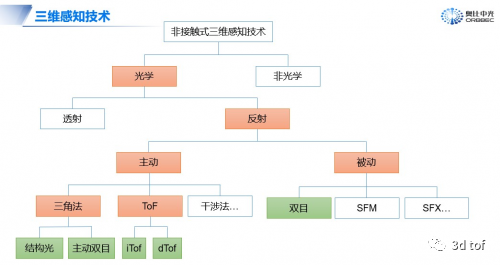

实际上,三维感知技术的种类还是蛮多的。今天我想讲的,主要还是偏重于非接触式的三维感知技术。而即使是非接触式的三维感知,依然有很多分支,有光学的,还有非光学的,像超声、毫米波等。

奥比中光关注的还是光学方面。从光学测量系统来看,又分为透射式、反射式。透射式一般测什么?测一些透明材质物体(如玻璃),往往是用透射式的。我们常见的一般是反射式:光在发出之后通过物体表面反射回来,然后被传感器接收到,利用这个信息来计算深度。

反射式又可以分主动和被动。主动是指它会投射一些特定的光或光斑,从而实现三维恢复。我在图中列了几种常见的方法,其实光学测量的范畴很大,还不限于这几类。被动也很多技术路线。人的眼睛其实就是一个被动双目,像SFM、SFX、摄影测量等,则是利用Motion、shading等多种约束去解算。

今天,我主要想和大家分享下奥比中光的主动结构光、主动被动双目及ToF技术。

结构光的前世今生

结构光的历史其实很早。20年前,研究人员就能用条纹结构光重建出人脸模型,只是计算和建模过程比较缓慢。即使到了现在,结构光的概念还是比较宽泛的。

我想重点介绍的Kinect,大家可能已经比较清楚了。Kinect应该是第一个消费级的Depth-Camera,而且销量也蛮大,有超过3000万套。而真正为Kinect提供技术的公司,其实是以色列的PrimeSense。这家2007年成立的公司专注于研发实时结构光技术,并在2009年与微软一起发布了Kinect,可以和Xbox配合做体感游戏。Kinect深刻影响了企业界和学术界,大家那时发现,1000块钱左右就能得到一个深度相机,还是很不可思议的。

奥比中光在2013年成立,在2015年就推出了我们第一套结构光传感器。为了推广方面的需求,我们做了兼容,尽量与Kinect的数据协议保持一致。实际上,我们的传感器能输出的分辨率还可以更高。

PrimeSense后来被苹果收购。苹果在2017年9月推出iPhone X,带着结构光“刘海”,这也是苹果第一款带3D相机的手机,可以用来刷脸解锁、刷脸支付。

在安卓阵营里,奥比中光与OPPO合作,推出了第一款带3D摄像头的安卓手机。其实,我们在2017年初就可以把3D结构光方案做进手机,只是厂商当时不理解3D应用的价值,直到iPhone X的发布引爆了行业。

在2018年下半年,我们又在结构光的产业化应用上迈出了一大步,把结构光大规模地用在线下刷脸支付设备中。

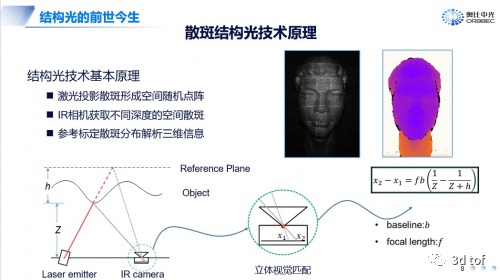

实时结构光的原理其实不难。把激光散斑投射到物体上,形成散斑图,然后在特定的平面上采集一帧参考图像。利用这个散斑图,跟参考图上的散斑做匹配,找到对应的视差,然后计算它Z方向的信息。

结构光跟双目有一定接近的地方,不过结构光只有一个相机。如果把结构光相机中的激光投影模块看成一个倒置的相机,其实就很接近双目技术。

结构光的核心在于做匹配,计算量很大。即使是算一个像素,一个block,也要算很多次。计算100万像素的话,数据量就非常巨大。所以,实现这个过程,需要自己做芯片。

到现在为止,奥比中光已经自研了四代结构光芯片。因为结构光计算量大,集成到芯片上,可以把算力、成本、功耗都平衡到可以大规模生产的地步。

主动被动融合的奥比中光双目技术

再来讲讲双目。奥比中光在双目上做了什么呢?

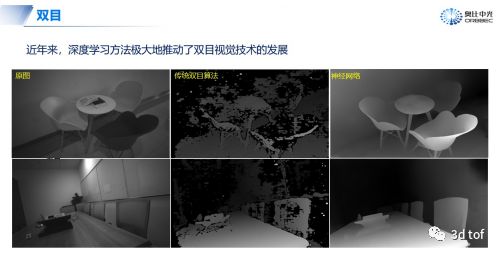

我们做了主动被动融合的双目模式。在几米之内的近距离时,采用主动增加散斑纹理,得到更好的精度;在远距离时,因为主动投射没有任何意义,就会变成被动双目。

同学们可能知道,这时候图像容易出现抖动的情况。怎么办呢?奥比中光开始采用深度学习的方式,用深度学习模型来学习图像的特征,然后做特征匹配,效果比传统方法好很多。

双目芯片这块,我们也在做芯片设计。因为双目的计算量与结构光一样,都非常巨大。奥比中光原来已有的两款结构光芯片MX6000和MX6600,其实也兼容双目。之后,我们还会再专门做一款AIOT芯片,我们叫它Venus,结合了双目和iToF的处理。

iToF与dToF:自研Sensor是核心壁垒

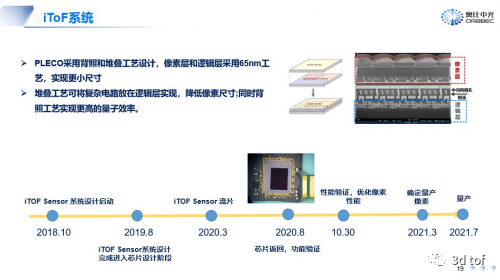

奥比中光也在投入iToF Sensor,预计今年7月份能够量产。这个项目从开始到现在已经做了快三年,用的时间还蛮长的。值得一提的是,我们目前正在和微软一起合作,开发在Azure云计算平台上使用的iToF相机。

iToF发展简史

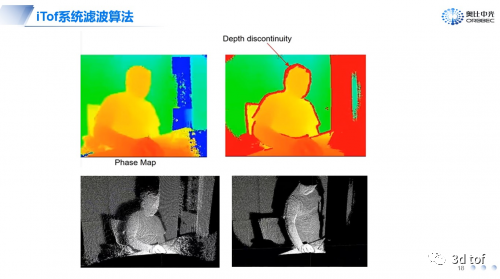

简单介绍下iToF的原理。iToF的原理是发射脉冲,再接受脉冲,最终利用相位差计算深度。一个不需要高精度的iToF测量其实很简单,但如果想把一个系统做得很精确,需要大量的标定工作。因为发射的脉冲跟理想的正弦信号还差很多,这块需要标定。

iToF系统滤波算法

而iToF系统标定这块,主要有四个方面:

全局偏差标定与补偿:全局偏差相当于整个系统的系系统误差,通过对全局偏差的处理,使测量数据归一化。

wiggling标定:主要解决调制信号与理想信号存在的周期性差异,因此,在标定时需要确保完成对一个调制周期的标定补偿。

FPPN标定: FPPN噪声是与像素点相关的固定偏置噪声,因此,可以在某一位置上计算固定偏置的相位。然后在计算深度时加上这一个固定的偏置相位即可。

温漂标定: 温度会改变深度偏移,因为激光调制和传感器中的延迟时间解调会随温度变化。因此,补偿随温度变化漂移时,应根据传感器和激光驱动器中的温度应用于原始距离。

给大家再介绍下奥比中光自研iToF传感器PLECO。PLECO采用背照和堆叠工艺设计,像素层和逻辑层采用65nm工艺,尺寸做得更小。听说索尼下一代将采用背照和堆叠工艺来做iToF传感器,实际上奥比中光在这上面已经做了三年了。

奥比中光iToF开发时间线

讲完iToF,再讲讲dToF。苹果在iPhone12系列上装的Lidar其实就是dToF。dToF跟iToF原理上唯一的差别就在于,dToF是测量时间差,发射出去脉冲跟接收的脉冲中间有一个时间差。不过,对这个时间差的测量精度要求非常高。

dToF最关键的部件是接收端的Sensor。dToF Sensor的发展也有一个趋势,最早基本都在用APD (Avalanche Photo Diode),后来发展成SPAD(Single Photon Avalanche Diode),即单光子雪崩二极管,只进去一个光子也会触发它的雪崩。再后来,则会走向SPAD Array的路线。而dToF技术的核心壁垒,也在于Sensor。

主流3D视觉感知技术,各有千秋

3D视觉感知技术各有特色,我们是全球少数全面布局结构光、双目、iToF、dToF、激光雷达等主流3D视觉感知技术的公司。我这里并没有给出哪种技术它的精度到底好还是不好,而是给了一些跟误差相关的参数。

主流3D视觉感知技术对比

像结构光和双目,它的误差联系最紧密的就是测量距离和焦距,可以看出它的误差是随着距离成平方关系的。iToF基本跟距离成线性关系,dToF几乎就是一个常量,整体精度不随距离的变化而变化,当然,dToF测量结果跟时间的精度关系很大。

3D视觉感知技术本身没有“好”与“坏”之分,而是分别适合于不同的应用场景。我认为几种技术之间,是一种优势互补、长期并存的状态。

3D视觉感知技术是趋势,大规模产业化正当其时

我再分享几个典型的应用场景。整体来说,结构光的优势还是近距离感测,双目的好处就在于它可近可远。iToF在0.1到5米范围内,dToF可以到几百米,车载激光雷达的原理就是dToF。

奥比中光一直在做3D视觉感知技术,把这几种技术从底层Sensor、芯片设计到光学、算法以及整体系统优化,都做了全方位深耕。我们为什么要这么做?举个简单的例子,如果企业核心的Sensor是买来的,那么做很多应用都会被局限住,就容易在一些关键领域被卡脖子。

奥比中光做了很多3D视觉感知模组,这些模组可以应用到的场景也很多,如手机前置、后置摄像头,线下刷脸支付,汽车激光雷达、车内安防,智能门锁,AR/VR,机器人,智慧畜牧,工业三维检测等等。

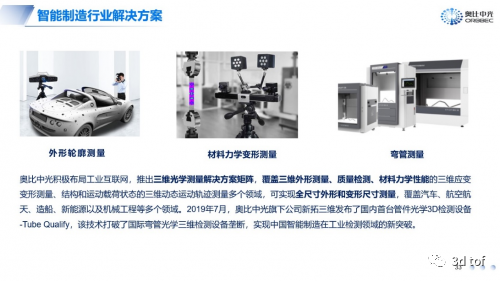

奥比中光智能制造行业解决方案

当前,3D视觉感知技术已经在多个领域崛起,并且在迅速扩大应用规模。与此同时,我们也能看到光学产业已经在向亚洲乃至转移——从20世纪中叶前欧洲国家(德国为主)独占鳌头,到1950年日本光学产业高速起飞而后制霸全球,从21世纪初期台湾光学产业在智能手机镜头带动下崛起,到近年来大陆光学产业科创新秀涌现、大规模应用落地,中国有望在3D感知技术产业实现弯道超车。

我们捕捉到了3D视觉感知技术在物联网时代的应用浪潮,并大力发展底层核心技术和下游应用生态。

我希望,中国能够在高端基础组件(比如Sensor、算法芯片、硅光技术等)上,有自己的持续研发和生产能力,培养更多人才,不被“卡脖子”

审核编辑 :李倩

-

季丰电子邀您相约2025国际3D视觉感知与应用大会2025-09-08 892

-

翌视科技3D视觉再升级2025-08-12 1713

-

技术基因+自主创新,光鉴科技塑造3D视觉感知新范式2024-01-16 2120

-

到底什么是3D视觉技术?2022-08-30 16575

-

全球3D芯片及模组引领者,强势登陆中国市场2021-11-29 4302

-

求一种3D视觉技术方案2021-11-09 2459

-

奥比中光全系3D视觉感知产品亮相光博会,机器视觉“未来已来”2021-09-23 1219

-

一文带你看懂3D视觉2021-09-01 7340

-

什么是3D视觉感知底层技术全图?2021-06-15 4123

-

一个小小的3D传感器,凭什么能够摘得“人工智能领域皇冠上的明珠”?2021-04-25 3438

-

探讨关于3D视觉技术和3D传感器2021-04-01 5428

-

奥比中光将通过3D视觉感知创新平台建设,推动产业链上下游协同发展2020-12-01 2822

-

3d成像融合传感技术:3D机器视觉引爆市场2018-07-17 3118

-

3D技术的应用探索3D机器视觉库2016-03-22 1034

全部0条评论

快来发表一下你的评论吧 !