云服务器中的CXL内存扩充与池化

描述

随着个人与企业所产生及使用的资料量急剧增长,为了支持使用人工智能 (AI)、机器学习 (ML) 等复杂模型的应用,云服务供应商需要一套全新的架构来存储、分析及传送资料。但由于内存容量需求不断上升,使得处理器数量及内存频宽达到瓶颈,举例来说,尽管 DRAM 占服务器成本的比例高达 50%,却受限于内存无法连接到多个 CPU 或 GPU 的架构,导致在各个时间段中约有 25% 的内存处于闲置的窘境。

Compute Express Link (CXL) 是一种用于处理器、内存扩展和加速器的开放标准。CXL 内存控制器允许内存通过扩张、池化、共享等方式,增加内存利用率,并减少总拥有成本 (TCO),同时改善系统能效及效率,以支持通用运算、AI 训练和推理、机器学习、内存资料库、内存分层及其他应用专属的工作负载。CXL 内存控制器也提供了高度的弹性,保留未来升级的空间,与主流 CPU、GPU 与内存厂商的相容性让这个产品能够更容易被管理、侦错及规模化。

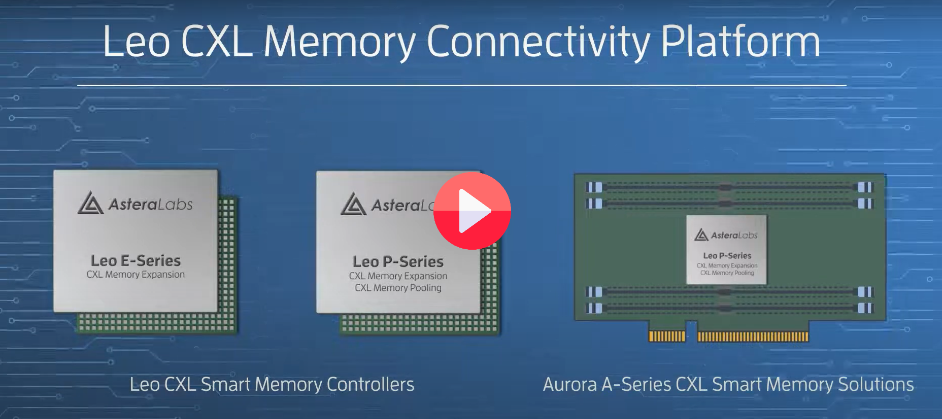

Astera Labs - Leo CXL Memory Connectivity Platform

Astera Labs Leo CXL Memory Connectivity 平台是业界首个通过内存扩展、池化和共享来消除内存瓶颈、提高性能和降低 TCO 的解决方案。Leo 控制器具有云规模部署所需的广泛功能,包括服务器级 RAS 功能、端到端安全性、低延迟 DDRx 等。与领先业界的处理器厂商、存储器厂商、策略云端客户、系统 OEM 和 CXL 联盟密切合作开发,以确保其满足众厂商的特定要求,并在整个生态系统中流畅互通。

相关产品

|

|

|

A100 80GB PCIe GPU NVIDIA 适用于 PCIe 的 NVIDIA A100,为所有工作负载提供最高程度的多样性。在 80 GB 版本上首度推出全球最快速的内存频宽,每秒超过 2 TB (TB/秒),可解决最大的模型和资料集。 |

2-Mbit I2C EEPROM STMicroelectronics M24M02 是一个 2-Mbit I2C 兼容的 EEPROM,可以在1.8V 至 5.5V 的电压及-40 °C / +85 °C 的温度范围内作业。 |

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

救场服务器内存的CXL2022-08-24 2113

-

云服务器有什么优势?怎么选对云服务器?2018-07-31 4577

-

云服务器安全吗?云服务器有哪些优势?2021-03-27 9860

-

云服务器与物理服务器的区别是什么?2021-12-09 23058

-

CXL内存协议介绍2022-11-01 3001

-

云服务和普通服务器的四个不同2020-03-28 6182

-

Astera Labs面向CXL附加内存扩展和池化应用的Leo Memory Connectivity Platform进入预量产阶段2022-09-01 1123

-

基于CXL技术的大内存池化方案解析2022-10-20 2890

-

访问CXL 2.0设备中的内存映射寄存器2023-05-25 3444

-

CXL技术的三种模式 CXL技术与其他技术的对比2023-10-30 10238

-

内存池的使用场景2023-11-10 1364

-

什么是CXL技术?CXL的三种模式、类型、应用2024-01-11 4065

-

SMART Modular 世迈科技推出高性能服务器专用全新CXL® 内存扩充卡系列2024-04-25 1205

-

SMART Modular世迈科技CXL内存扩充卡获CXL联盟认证2025-02-05 746

-

SMART Modular CXL AIC内存扩充卡获CXL联盟认证2025-02-14 750

全部0条评论

快来发表一下你的评论吧 !