GTC 2023看点:深度学习系统Colossal-AI试图解决什么问题

电子说

描述

在GTC 2023 | NVIDIA开发者大会上,加州伯克利数学与计算机科学的教授向我们介绍了关于深度学习系统Colossal-AI的相关内容。

深度学习系统Colossal-AI使用户能够以大幅降低成本的方式最大限度地提高AI训练和推理的效率。它集成了高效的多维并行、异构内存管理、自适应任务调度等先进技术。

Colossal-AI将更好地了解大型模型训练和推理背后的并行性和内存优化技术,学习深度学习系统的实际应用(包括自然语言处理、计算机视觉、生物信息学等),并能够为未来的大型 AI 模型时代做出贡献。

Colossal-AI系统试图解决什么问题呢?

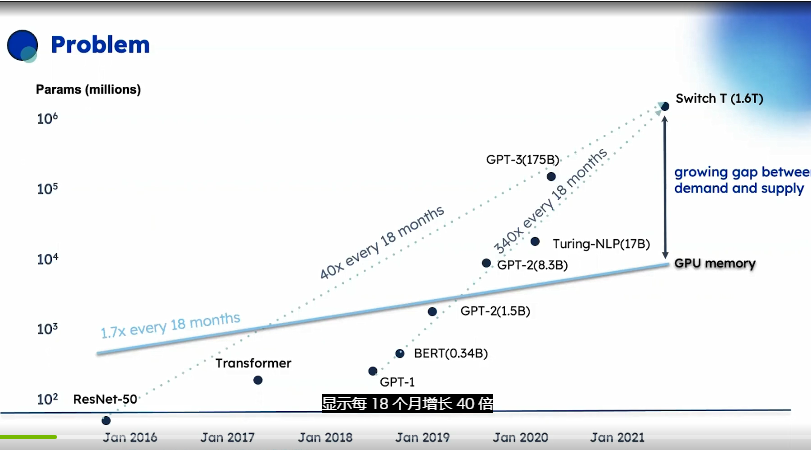

主流AI模型大小增长的图表,它显示了AI模型在短短几年内增长的速度,每18个月增长40倍,这超过了摩尔定律在其具盛时期的最佳表现。

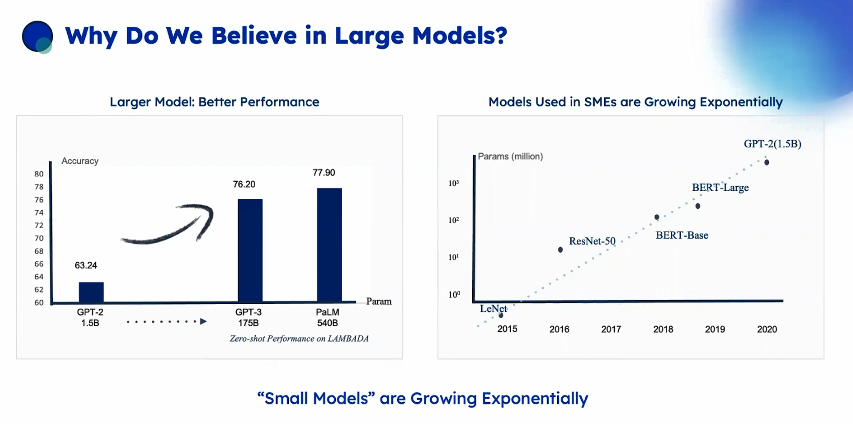

小型和中型企业( SMEs )在尽可能地在采用它们,Colossal-Al系统在2026年时可以帮你节省的成本的估计训练175B参数GPT-3模型,利用所有这些硬件特性和变化,估计训练成本从300降至73000美元,约为41倍。

强调大规模并行是必不可少的,使用单个A 100 GPU训练具有540B参数的Pal M语言模型的时间和成本,需要300年并且花费920万美元。

随着新数据的不断出现,他们需要反复的新训练以避免像2019年的GPT-2一样无法识别COVID-19等概念。

训练完成之后,仅使用模型进行推理也是项挑战,因为模型的大小需要并行技术,单个服务器的内存可能无法容纳大模型。除了设备成本之外,还有人力成本支付需要解决所有这些问题的专家团队,这就限制了一些公司特别是无法承受这些团队的中小企业使用这些大型模型。

因此Colossal-AI的作用出现了:

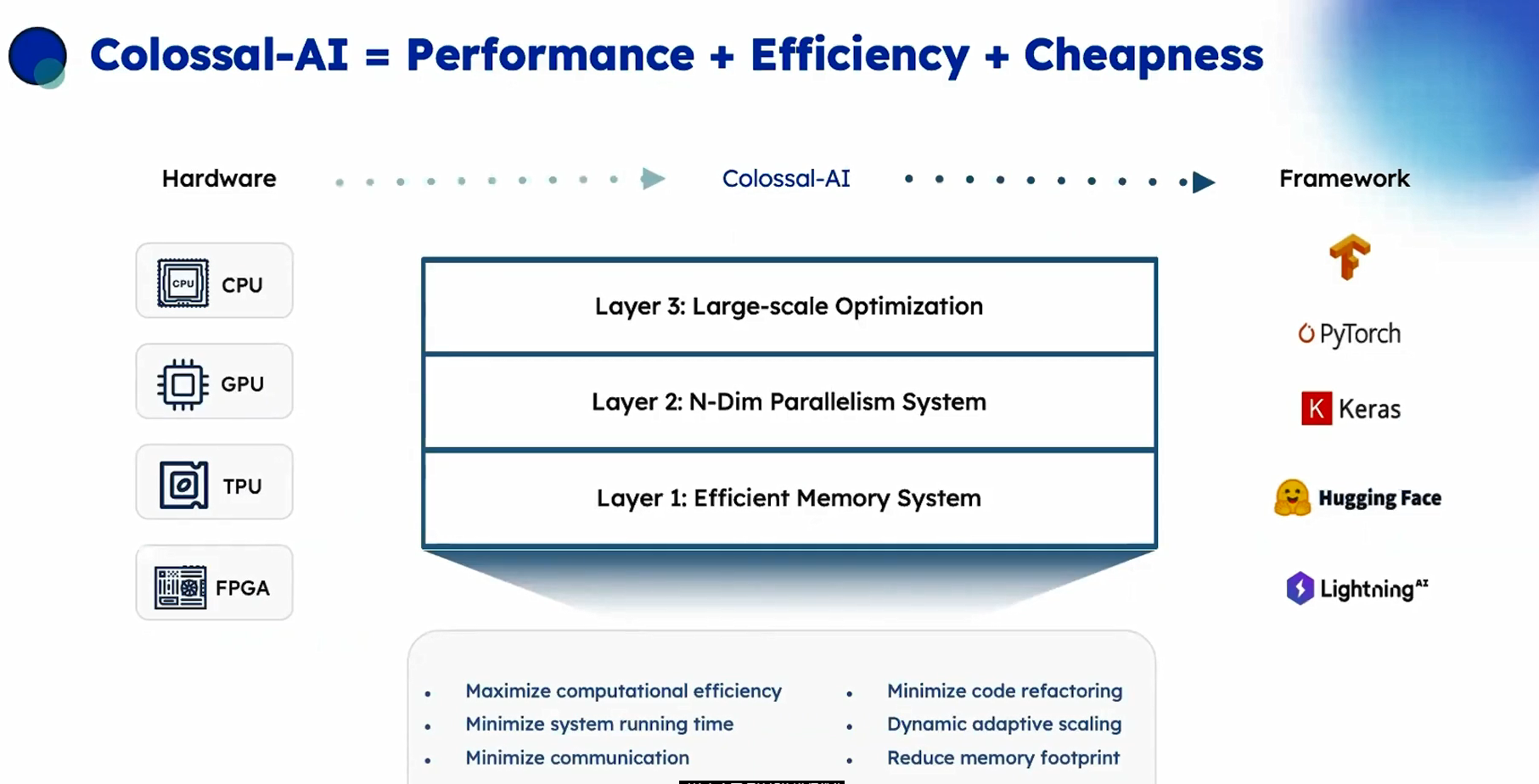

对特定底层硬件架构进行优化,左侧(硬件层)可以是CPU、 GPU、TPU或FPGAl,右侧是你的用于AI模型编写的框架,如TensorFlow、 Py Torch或其他框架。Colossal-AI可以高效地将大模型部署到目标架构,实现底部显示的所有目标,最小化运行时间,最小化通信(移动数据)在当前架构是最昂贵的操作,最小化用户需要改动代码的数量,即重构。使模型能够动态地适应机器的规模变化,并减少内存占用,一边能运行大模型。

Colossal-AI提供了三个层次:

高效的内存系统,可最大程度利用可用内存。

多维并行,即如何最好地将复杂的模型映射到可用的硬件上,以最大程度地使并行处理并最小化通信。

大规模优化,也就是如何自动调整影响准确度收敛的众多超参数,因为这些值通常取决子如何进行并行处理。

因此Colossal-AI的目标是将复杂且相互作用的决策从用户角度隐藏起来,并自动完成所有操作。

编辑:黄飞

-

AI大模型与深度学习的关系2024-10-23 3746

-

潞晨科技Colossal-AI与浪潮信息AIStation完成兼容性互认证2024-03-06 1544

-

潞晨科技Colossal-AI + 浪潮信息AIStation,大模型开发效率提升10倍2024-03-01 1124

-

GTC 2023|Colossal-AI系统的数据并行优化方案2023-03-23 2427

-

NVIDIA GTC 2023看点:AI计算系统、生成式AI 、工业元宇宙与机器人2023-03-22 2110

-

GTC23 看点预告 | 从深度学习框架到开发工具,百度飞桨携最新成绩单亮相 GTC2023-02-20 908

-

NVIDIA GPU加速潞晨科技Colossal-AI大模型开发进程2022-10-19 2155

-

Gtc2022大会 AI机器人发布2022-03-23 1640

-

射频系统的深度学习【回映分享】2022-01-05 6409

-

深度学习模型是如何创建的?2021-10-27 2290

-

什么是深度学习,深度学习能解决什么问题2020-11-05 5353

-

【HarmonyOS HiSpark AI Camera】基于Harmony系统的人脸门禁系统2020-09-25 719

-

医学影像AI进入后深度学习时代 市场规模不断扩大2019-05-24 3053

全部0条评论

快来发表一下你的评论吧 !