GPT模型推动存储厂商加速PIM进程

电子说

描述

存内计算这个概念从被提出开始,就选定了AI作为主要应用领域,但苦于当时的需求并不算高,技术也还在完善成熟中,我们更多是在一些学术论坛和行业会议上见到存储厂商和AI芯片厂商对其高谈阔论。

可谁知道2023年我们迎来了消费级存储市场的萎靡,却又在ChatGPT的应援之下带火了高带宽内存。这不,三星、SK海力士等厂商纷纷迎来了HBM订单和单价的疯涨,也使得他们打算加速推进PIM的开发进度。

SK海力士的AiM方案

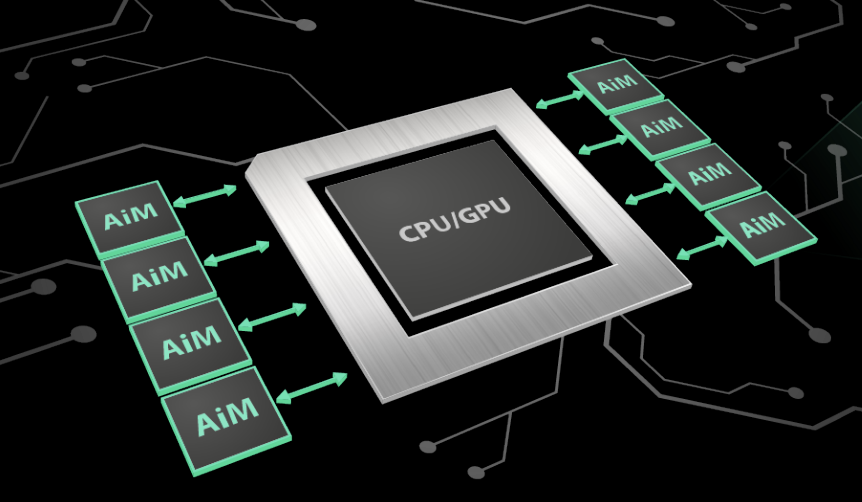

SK海力士在近期提出了他们的首个PIM方案,AiM。AiM是一个基于GDDR6的存内计算方案,专门为了加速内存负载密集的机器学习应用而设计。而GDDR6作为当下GPU产品的主要显存形式之一,提供了足够的带宽,但并没有提供额外的计算能力,更别说卸载CPU、GPU的运算任务了。

AiM存内加速器方案 / SK海力士

而在机器学习应用中,SK海力士的AiM方案可以卸载96%的计算任务,交由DRAM的存内计算单元来完成,实现了超高的内存bank并行度,显著减少了CPU与内存之间的数据移动,而且相比HBM,GDDR6明显是一个成本更低的方案。

正是因为有了这些优势,AiM可以说是专为GPT类应用打造的,SK海力士也给出了在GPT模型下的性能评估。对于GPT-2和GPT-3乃至现在的GPT-4来说,都属于内存负载密集型的应用,所以也更容易遇到内存墙的问题。

SK海力士AiM的另一大优势在于他们已经实现了全套软件栈,包括设备驱动、runtime库、框架和应用等,也支持AiM软件仿真器,支持用户自行开发AI应用,而无需硬件评估板。

三星的PIM进程

其实其他厂商也早有在PIM上布局,尤其是三星。早在2021年初推出HBM2E后,三星就已经开始规划如何充分利用这些高带宽内存的性能,其中之一就是PIM。与SK海力士不同的是,三星打造的首个PIM为HBM-PIM,在内存核心中了集成了名为可编程计算单元的AI引擎,用于处理一部分的逻辑功能。

同年的HotChips大会上,三星展示了将其HBM-PIM集成到Xilinx的Alveo AI加速器系统中。根据三星提供的数据,该方案提供了2.5倍的系统性能提升,同时将功耗降低了60%。从三星半导体的PIM技术展示也来看,他们也计划将这一技术应用到GDDR和LPDDR中,不过这几年间的主要技术公开展示都集中在HBM-PIM上。

除了这种将PIM集成到商用AI加速器的方案以外,三星也同时推出了直接将PIM集成到DRAM模块中的方案AXDIMM,通过直接在DRAM模块中对多组内存芯片进行并行运算,减少了CPU和DRAM之间的大量数据移动。

三星称在基于AI的推荐应用中,AXDIMM可以使得整体系统能效提高40%,不过对于GPT这种生成式AI类的应用能够带来多少提升我们就不得而知了,毕竟三星的PIM方案推出时大部分AI应用还停留在图片分类、文字翻译和语音识别上。

小结

从这些PIM产品的布局来看,集成式的方案或许对AI加速器厂商来说更有吸引力,不管这些计算单元是CPU、GPU、FPGA还是ASIC芯片。但无论是三星还是SK海力士,这些方案落地到产品上都需要一定的时间,所以我们可能得等到下一代产品中,才能看到存内计算的存在。

但不得不说,对于已有布局存内计算的存储厂商来说,这无疑是一大利好。过去这种和负责计算的逻辑芯片抢活干的设计无疑是自砸招牌,但现在看来却已经成了一种趋势,这类存储厂商对于市场波动的抵抗力也会更强一些。只不过目前看来这类PIM技术目前还是优先针对功耗相对较高的内存,未来要想在移动市场有所成就,还得看这些存储厂商后续会推出怎样的LPDDR-PIM方案。

审核编辑 :李倩

-

成都汇阳投资关于大模型白热化,应用加速分化2025-09-09 746

-

NVIDIA从云到边缘加速OpenAI gpt-oss模型部署,实现150万TPS推理2025-08-15 2032

-

2025存储国产化进程加速:存储芯片主要厂商介绍2025-05-12 4451

-

OpenAI即将推出GPT-5模型2025-02-13 956

-

三星与SK海力士携手推进LPDDR6-PIM产品标准化2024-12-03 1308

-

【大语言模型:原理与工程实践】揭开大语言模型的面纱2024-05-04 788

-

华为盘古大模型和GPT的区别2023-08-30 7247

-

gpt-4怎么用 英特尔Gaudi2加速卡GPT-4详细参数2023-07-21 1172

-

电动进程加速推动车载电机升级2023-06-06 2046

-

GPT模型推动存储厂商加速PIM进程2023-04-10 2191

-

GPT/GPT-2/GPT-3/InstructGPT进化之路2023-03-03 5113

-

基于vitis的模型编译器在FPGA上加速投产进程2022-11-22 2136

-

使用NVIDIA TensorRT优化T5和GPT-22022-03-31 4628

-

什么是PIM_哪些环节需进行PIM测试?2018-07-13 15814

全部0条评论

快来发表一下你的评论吧 !