大模型引发技术变革, AI芯片公司面临新挑战

描述

ChatGPT 在全球范围内掀起了一场技术革命与商业浪潮,AI 市场也迎来了前所未有的机遇与增量。

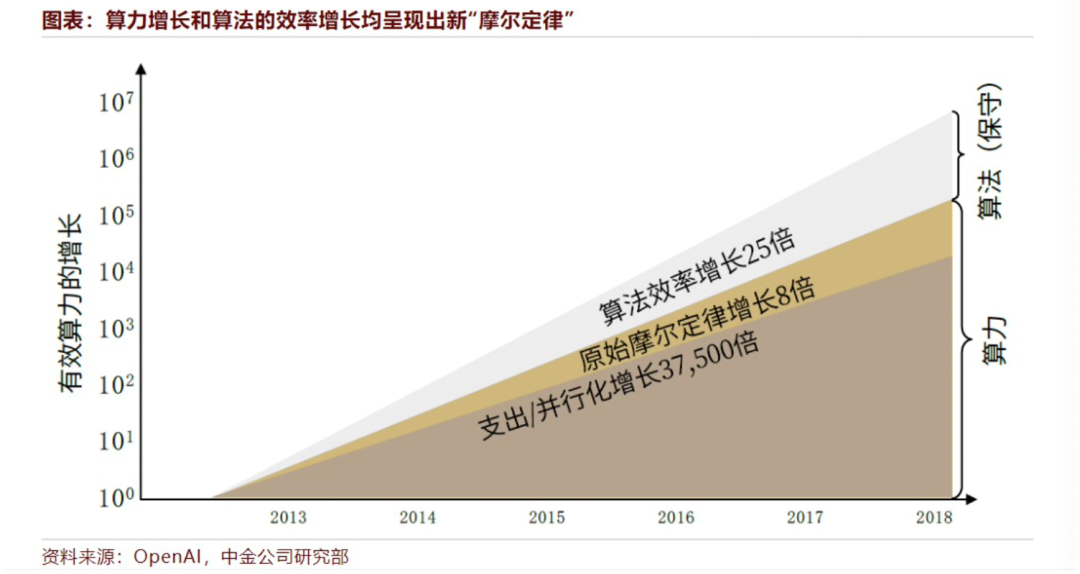

当前,AI 基础设施的算力、算法呈现新 “摩尔定律”:相同算力下能训练生产更优质的模型,同时最先进的 AI 模型约每几个月算力需求就会扩大一倍。

根据斯坦福大学和麦肯锡联合发布的《2019 人工智能指数报告》,2012 年之前最先进 AI 模型计算量每两年翻一倍;2012 年之后计算量每 3.4 个月翻一番,从 2012 年到 2020 年 3 月已增长 30 万倍。

伴随着大模型的快速迭代,其对算力的要求也不断提高,而算力的核心就是人工智能芯片。因此,如何在新趋势、新挑战下快速响应客户需求,推出切实可用的软硬件解决方案,成为了摆在国内 AI 芯片企业面前的首要课题。

拥抱变化,聚焦提升产品力

ChatGPT 及大模型技术大会上,昆仑芯科技研发总监王志鹏表示:“作为一家芯片公司,需要对市场的需求和变化非常敏感,才能使硬件产品始终精准匹配主流需求。”

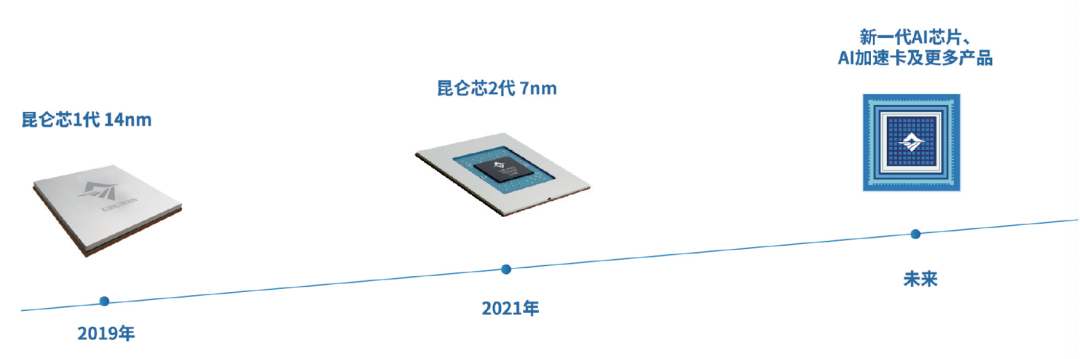

大模型对计算的要求主要体现在三个方面,一是算力,二是互联,三是成本。就大模型而言,昆仑芯科技在产品定义上已经做出布局 —— 相较第一代产品,昆仑芯 2 代 AI 芯片可大幅优化算力、互联和高性能,而在研的下一代产品则将提供更佳的性能体验。

昆仑芯科技成立于 2021 年,前身为百度智能芯片及架构部。在实际业务场景中深耕 AI 加速领域已逾 10 年,专注打造拥有强大通用性、易用性和高性能的通用人工智能芯片。

在持续推进核心技术攻关的同时,昆仑芯科技紧密关注科技前沿,精准匹配市场需求。目前,公司已实现两代通用 AI 芯片的量产及落地应用,在互联网、智慧金融、智慧交通等领域已规模部署数万片。

昆仑芯在大模型场景的规模落地实践

“来自真实场景” 一直是昆仑芯科技最独特的身份标签,也是其规模部署数万片、在行业内 “领跑落地” 的核心优势所在。

王志鹏认为,只有基于真实业务场景中的数据进行端到端优化,才能顺利推进大模型落地。

目前市场上主流的大模型以 Transformer 架构为主,包含 Encoder 和 Decoder。Encoder 主要被应用于各类 NLP 的判别类任务;而 Decoder 更多被应用于翻译、图文生成等场景,最近出圈的 ChatGPT 就是典型代表。

针对大模型,昆仑芯持续打磨部署优化方案,领跑产业落地。昆仑芯已将大模型的 Transformer 相关优化技术沉淀为重要基建,优化后的性能比原有方案提升 5 倍以上,压缩显存 30% 以上。

以文生图大模型为例,昆仑芯已跑通一条端到端优化、规模落地之路。

AI 绘画模型的推理算力及显存需求随图像分辨率增大而指数级增加,同时,图像生成需要循环采样数十次,产业落地动辄需要高昂成本的部署集群,严重阻碍了 AIGC 模型大规模商业化落地。

2022 年第四季度,昆仑芯联合客户,基于飞桨 PaddlePaddle 发起了端到端联合优化项目。在 2-3 周内,项目组快速完成端到端优化,最终实现输入文本后 2 秒出图的优化效果,性能提升近 8 倍。

目前,昆仑芯 AI 加速卡 R200 已在该客户的大模型场景完成规模部署,性能数据全面超越同系列主流推理卡:

基于昆仑芯 AI 加速卡 R200 高效运算与推理能力,综合优化方案,在 dpm-25steps 算法下,利用昆仑芯 AI 加速卡 R200,生成 1024*1024 图像时的推理速度为 10.89 iters/s,相比同能力的主流推理卡快 20%。

昆仑芯 AI 加速卡 R200 拥有 32G GDDR6 显存,为大规模参数提供更大的存储容量、更高带宽的内存访问、更稳定的性能,生成更高分辨率的图片,为用户提供高性价比服务。

与此同时,面向当前市场需求迫切的大模型场景,据悉昆仑芯科技即将推出一款加速器组解决方案。

该加速器组搭载第二代昆仑芯 AI 芯片,是 AI 基础设施的重要组成部分,为 AI IAAS 平台、 AI PAAS 平台提供坚实算力支撑。该产品可提供更为集约的 AI 算力,具备分布式集群部署能力,支持弹性 RDMA 网络,对比传统网络通信时延降低 2~3 倍。该产品可明显提高并行加速比,训推一体化助力提高资源利用率,极大提升模型开发迭代效率。

携手上层伙伴共拓 AI 芯生态

ChatGPT 及大模型技术大会上,与会者提问:在生态建设方面,国内 AI 芯片产业面临的客观情况是什么?

这也是昆仑芯科技经常被客户提及的现实问题。

昆仑芯科技在努力进一步扩大生态影响力:首先要深刻理解客户的使用习惯,满足客户需求,踏踏实实把软硬件从产品和技术上做到位。随着产品的规模部署,客户越来越多,生态也就自然而然建立起来了。与此同时,产品也会因此得到更好的打磨,进入良性循环。

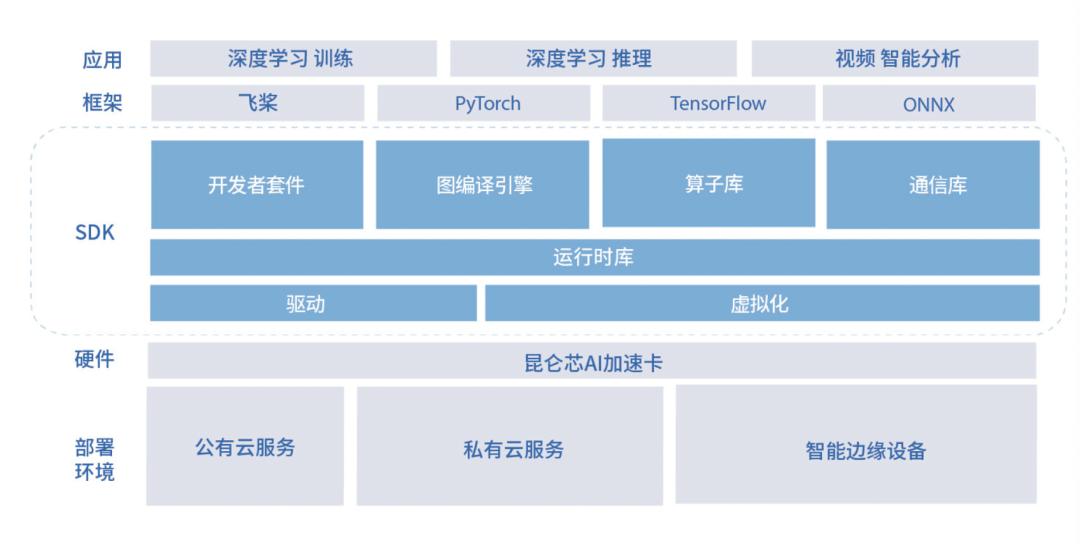

在昆仑芯科技看来,AI 芯片看似是一个硬件,但其本质则是一款软件产品。这也证明了软件栈、生态对于 AI 芯片发展的关键作用。

目前,昆仑芯已实现对飞桨的原生适配,并完成了 III 级兼容性测试,训练与推理性能可以满足用户的应用需求。从底层 AI 算力组件、AI 服务器,到操作系统,再到昆仑芯 SDK,昆仑芯和飞桨携手完成了一套端到端的 AI 计算系统解决方案,并致力于打造一个全栈式软硬一体的 AI 生态。

为进一步完善软件生态,昆仑芯已与多款通用处理器、操作系统、主流框架完成端到端适配,实现了软硬件解决方案的技术栈,为客户提供开箱即用的 AI 芯片产品。

昆仑芯软件栈

结语

谈及大模型趋势下 AI 芯片公司面对的变化,王志鹏说道: “必须快速调整心态,并拥抱大模型带来的变化。”

而这也刚好印证了昆仑芯科技 “突破创新” 的公司文化:面对瞬息万变的外部环境,突破创新是适应行业的唯一方式。

面对复杂多变的市场环境以及新场景新应用对研发和落地的重重挑战,国内 AI 芯片公司如何出圈?

集十余年 AI 加速领域的技术积淀,曾任百度智能芯片及架构部首席架构师、现任昆仑芯科技 CEO 欧阳剑认为,“AI 芯片公司应抓住场景和技术创新‘双驱动’模式,驱动架构优化升级与软硬件产品迭代,这是持续保持竞争力的关键。”

审核编辑 :李倩

-

《AI for Science:人工智能驱动科学创新》第二章AI for Science的技术支撑学习心得2024-10-14 2219

-

【「大模型启示录」阅读体验】对大模型更深入的认知2024-12-20 1630

-

【书籍评测活动NO.64】AI芯片,从过去走向未来:《AI芯片:科技探索与AGI愿景》2025-07-28 41003

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+内容总览2025-09-05 3680

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片的需求和挑战2025-09-12 3296

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片到AGI芯片2025-09-18 5206

-

多点综合技术面临什么挑战?2019-10-17 1701

-

自动驾驶车辆中AI面临的挑战2021-02-22 2547

-

SoC测试技术面临的挑战是什么?其发展趋势如何?2021-04-15 1812

-

基于能量采集技术的BLE传感器节点设计面临哪些挑战?2021-05-17 1999

-

RFID原理是什么?RFID技术面临哪些挑战?2021-05-26 3223

-

无线智能IP监控面临的技术挑战是什么?怎么解决?2021-05-31 1190

-

多声道音频技术是什么?PC音频子系统面临哪些设计挑战?2021-06-04 1549

-

探讨AI芯片设计和开发的6个挑战2021-11-02 2257

-

国内AI芯片面临怎样的机遇和挑战?2022-05-29 6240

全部0条评论

快来发表一下你的评论吧 !