深度学习基础知识(2)

描述

二、神经网络

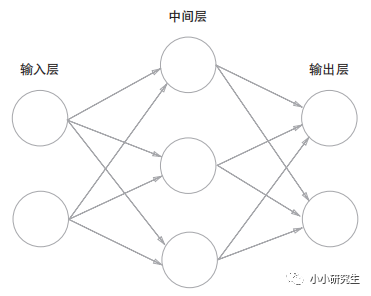

第0层是输入层,最后一层是输出层,中间是中间层或隐藏层。上图中的网络有3层神经元,实质只有两层有权重,因此称为两层网络。

1、激活函数

感知器:y=0(b+w1x1+w2x2<=0)或y=1(b+w1x1+w2x2>0)改写为

y=h(b+w1x1+w2x2),h(x)=0(x<=0)或h(x)=1(x>0)

激活函数h(x):将输入信号的总和转换为输出信号的表达式,决定如何激活输入信号的总和。

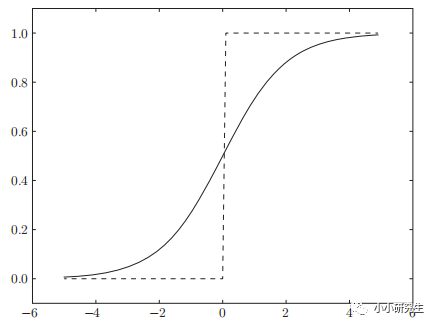

上式中的激活函数是阶跃函数,只能返回0或1,而神经网络中的激活函数常用的是sigmoid函数和ReLU函数。

1'sigmoid函数

h(x)=1/(1+exp(-x))

和阶跃函数的对比:sigmoid是平滑的函数,输出随输入发生连续的变化,因此可以返回0-1之间的实数。

和阶跃函数的相同点:输入小时,输出接近0,输入增大时输出向1靠近,即当输入信号为重要信息时,都会输出较大值,且两者输出都在0-1之间。

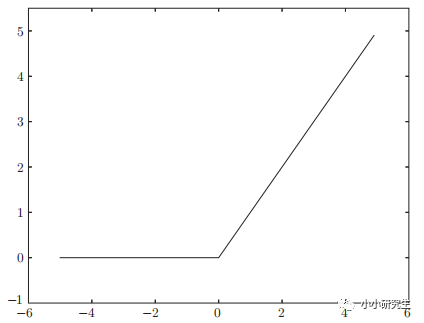

2'ReLU函数

h(x)=x(x>0);h(x)=0(x<=0)

输入大于0时直接输出,输入小于0时输出0

总结:激活函数只能为非线性函数,因为线性函数的问题是多个隐藏层可以用一个隐藏层实现。例如h(x)=cx作为激活函数,y(x)=h(h(h(x)))对应的三层神经网络可以用一层表示y(x)=c^3x。如果要用叠加层则必须使用非线性函数。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

怎么学习嵌入式系统基础知识?2021-02-19 1710

-

单片机基础知识学习笔记分享2021-11-23 1241

-

通信基础知识教程2010-03-04 917

-

FPGA开发经验与技巧_基础知识学习篇(1)2015-12-16 627

-

ADC【DSP基础知识】2016-01-06 532

-

使用Eclipse基础知识2016-02-26 953

-

Verilog_HDL基础知识非常好的学习教程 (1)2017-01-04 725

-

PLC基础知识学习,不看后悔2017-09-09 1478

-

学习PLC必备四方面基础知识2020-01-15 10230

-

机器学习的基础知识详细说明2020-03-24 1349

-

直流稳压电路的基础知识学习课件免费下载2021-02-02 1673

-

了解一下机器学习中的基础知识2021-03-31 4372

-

51单片机学习 基础知识总结2021-11-11 1307

-

单片机基础知识学习笔记2021-11-14 996

-

深度学习基础知识分享2022-09-05 378

全部0条评论

快来发表一下你的评论吧 !