详解五种即插即用的视觉注意力模块

描述

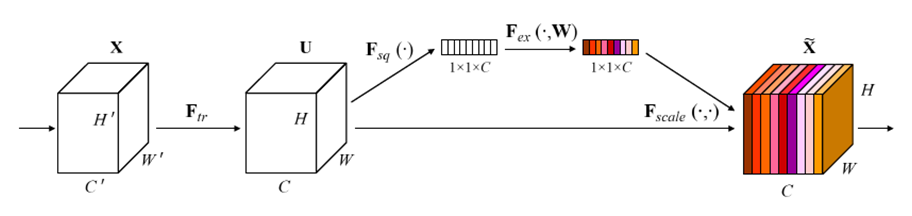

SE注意力模块

SE注意力模块的全称是Squeeze-and-Excitation block、其中Squeeze实现全局信息嵌入、Excitation实现自适应权重矫正,合起来就是SE注意力模块。

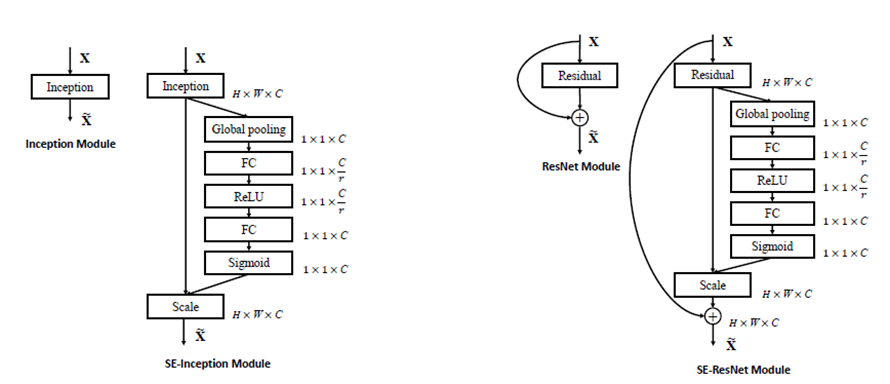

把SE注意力模块添加到Inception Module中与ResNet的残差Module中,实现SE注意力版本的Inception与ResNet模型

SE注意力模块集成残差的四种不同结构设计

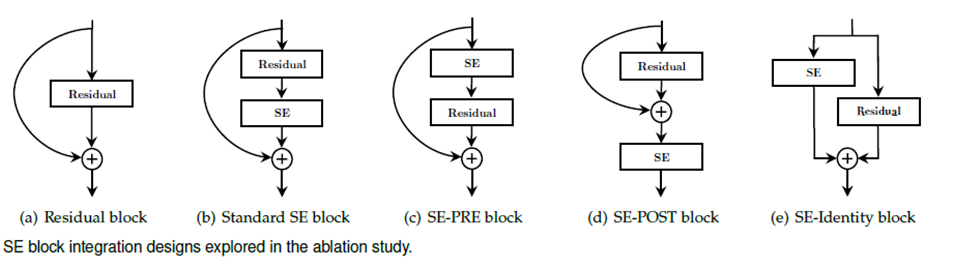

CA注意力模块

图中最右侧是CA注意力模块、左侧是SE注意力模块、中间是CBAM注意力模块、CA注意力通过坐标信息嵌入和坐标注意力生成两个步骤把通道关系和长程依赖关系精确编码。

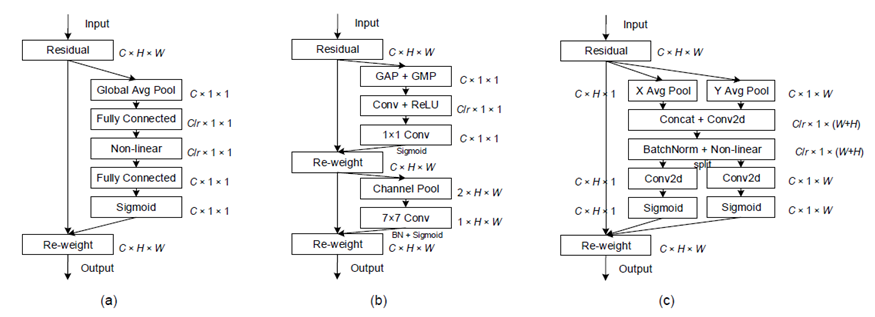

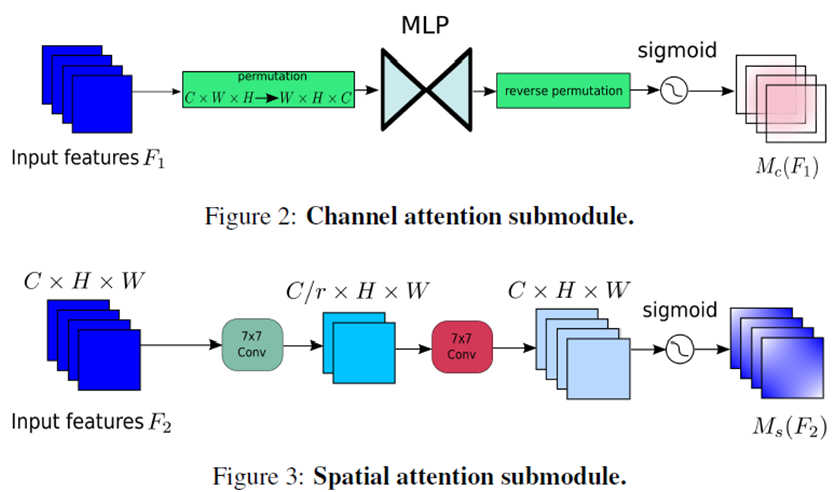

CBAM注意力模块

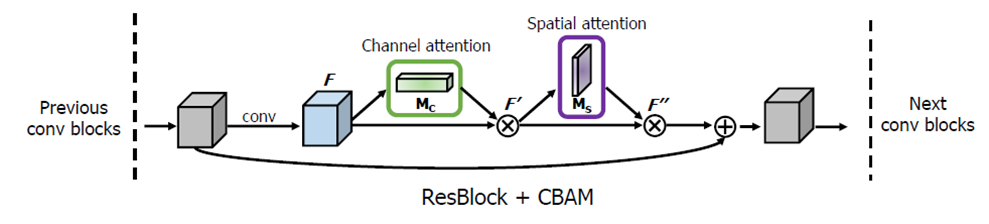

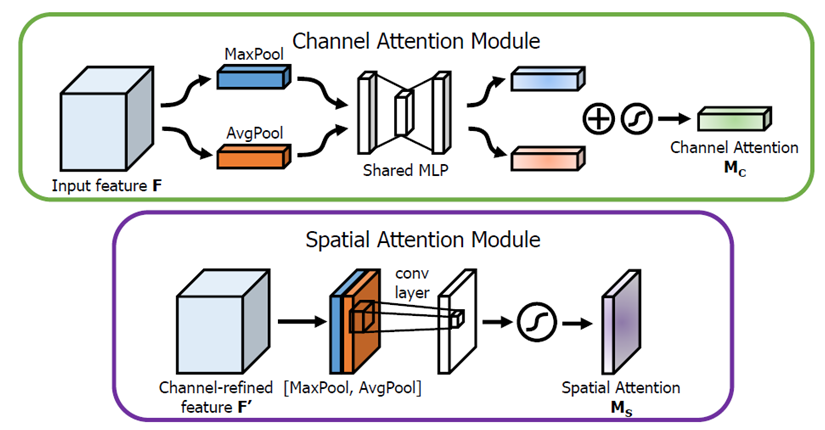

该图显示了如何把一个CBAM模块集成到到一个残差模块中,实现残差CBAM模块,CBAM是集成了通道注意力与空间注意力、通道和空间注意力模块生成首先是通过平均池化和最大池化分别生成通道与空间注意力的输入,然后通过MLP与7x7卷积输出通道子模块和空间子模块。

ECA注意力模块

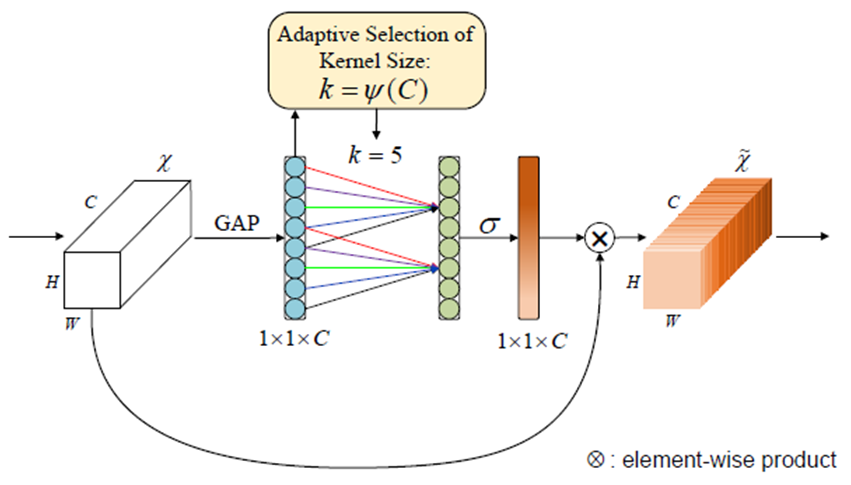

通过全局均值池化(GAP)获得的聚合通道特征,然后通过大小为k滤波器的快速1D卷积,然后重新构建一个维的卷积输出结果,乘以输入的每个通通道数据作为输出实现注意力机制为ECA。

GAM注意力模块

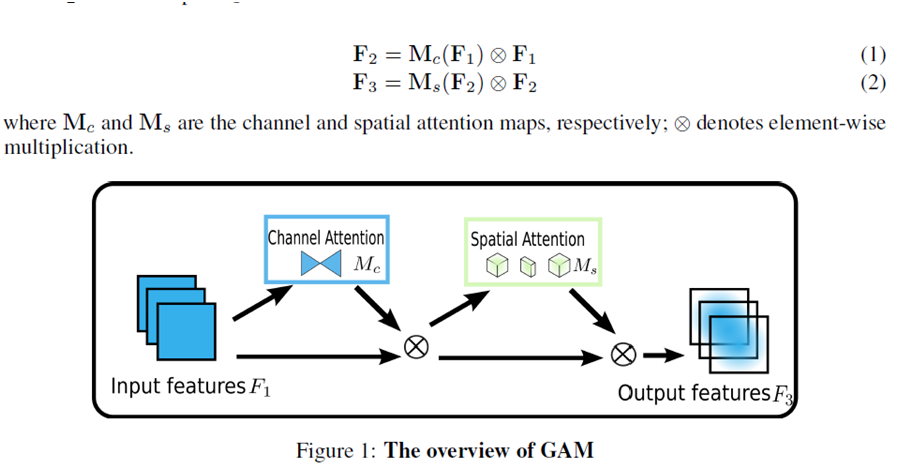

全局注意力模块基于CBAM注意力模块集成上重新设计通道与空间两个子模块实现,其中通道注意力直接使用MLP实现、空间注意力通过两个7乘7的卷积实现,最终GAM注意力添加到ResNet网络的效果相比SE注意力、CBAM注意力有明显提升。

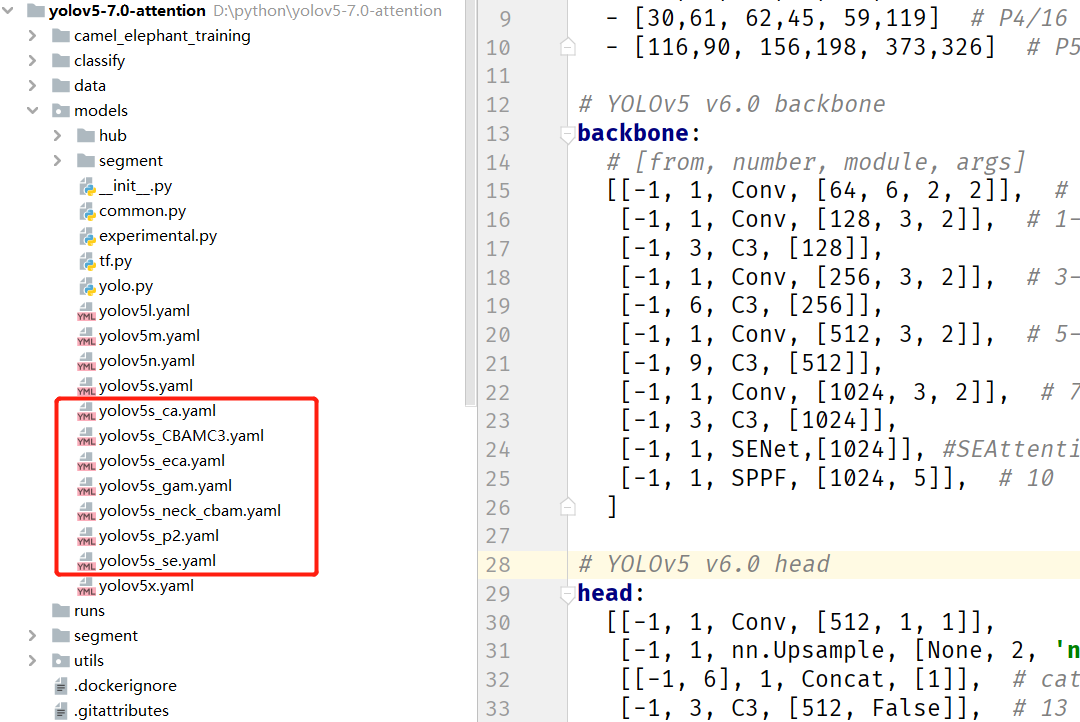

YOLOv5 7.0 注意力加持版本

审核编辑:刘清

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

即插即用和热插拔的区别2012-10-23 8247

-

基于SLH89F5162的左额电压信号的注意力比拼2013-10-17 6

-

基于labview的注意力分配实验设计2019-05-07 1222

-

PCI与即插即用2008-12-09 2312

-

什么是即插即用2009-12-28 2496

-

Helieon(TM)LED照明模块即插即用2010-03-29 808

-

DeepMind为视觉问题回答提出了一种新的硬注意力机制2018-08-10 6720

-

北大研究者创建了一种注意力生成对抗网络2018-08-11 5511

-

一种通过引入硬注意力机制来引导学习视觉回答任务的研究2018-10-04 6117

-

深度分析NLP中的注意力机制2019-02-17 4683

-

华南理工开源VISTA:双跨视角空间注意力机制实现3D目标检测SOTA2022-04-07 2151

-

基于超大感受野注意力的超分辨率模型2022-10-27 1978

-

如何用番茄钟提高注意力2022-10-28 796

-

计算机视觉中的注意力机制2023-05-22 525

-

基于YOLOv5s基础上实现五种视觉注意力模块的改进2023-06-02 2545

全部0条评论

快来发表一下你的评论吧 !