Meta自研RISC-V AI推理芯片

描述

Meta取消了大规模推出内部推理芯片的计划,并开始着手开发能够执行训练和推理的芯片。

据悉,Meta之前发展AI业务时,一直没有接受使用GPU,相反,直到去年,Meta都在主要使用CPU队列运行人工智能工作负载,这也是Meta在AI进程上落后对手的关键原因之一。目前,Meta内部已开始计划开发一款新型芯片,类似GPU,既能训练AI模型,又能进行推理,该项目将于2025年左右完成。

Meta Platforms今天分享了其数据中心项目的新细节,以更好地支持人工智能工作,包括内部开发的定制芯片“系列”。

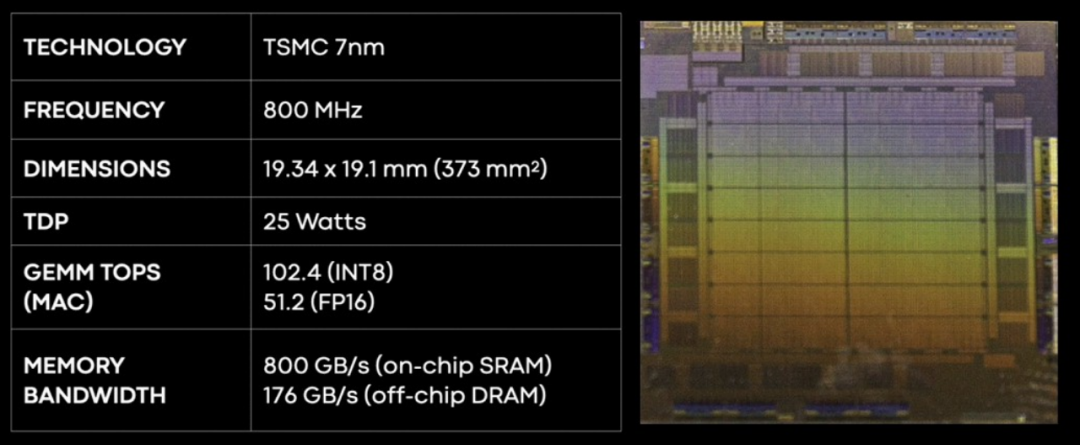

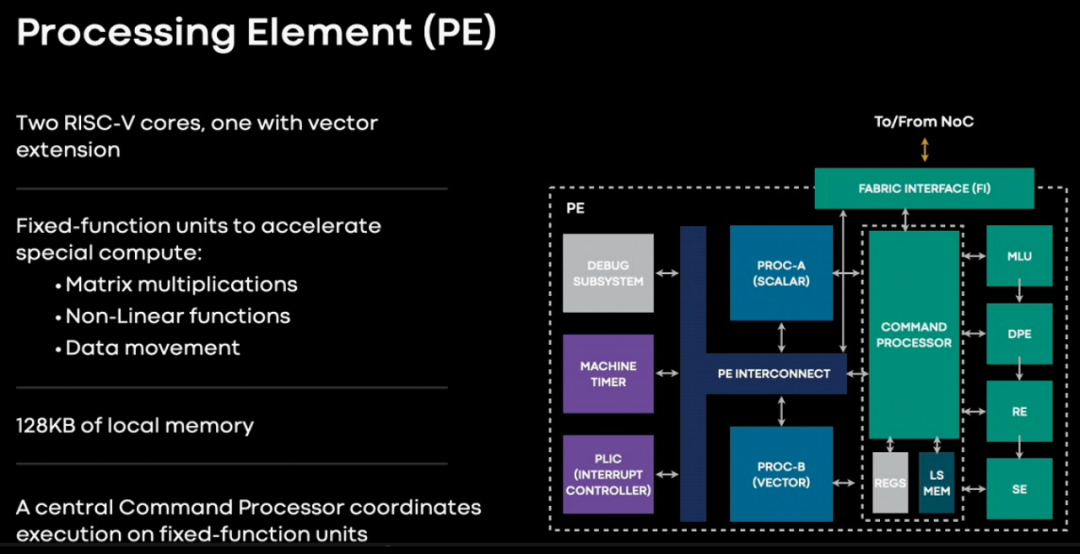

以下是 MTIA v1 芯片的基本规格:基于一个双核 RISC-V 处理元件,包含25 瓦芯片和 35 瓦双 M.2 外围卡。

因为它是低频率的,MTIA v1 芯片消耗的功率也相当低,并且采用 7 纳米工艺实现意味着该芯片足够小,可以运行得非常酷,而无需采用台积电最先进的工艺。台积电的从 5 纳米到 3 纳米不这些更昂贵的工艺,可以留到以后再使用。就像谷歌的TPU那样,当工艺更便宜时使用在新一代设备上进行训练和推理。

MTIA v1 推理芯片有一个由 64 个处理元件组成的网格,这些处理元件周围环绕着 128 MB 的 SRAM 内存,可用作主存储器或前端有 16 个低功耗 DDR5 (LPDDR5) 内存控制器的高速缓存。

这种 LPDDR5 内存用于笔记本电脑,也用于 Nvidia 即将推出的 Grace Arm 服务器CPU。这 16 个 LPDDR5 内存通道可以提供高达 64 GB 的外部内存。

这 64 个处理元素基于一对 RISC-V 内核,一个是普通的,另一个是带有矢量数学扩展的。每个处理元件都有 128 KB 的本地内存和固定功能单元,用于执行 FP16 和 INT8 数学运算、处理非线性函数和移动数据。

这是 MTIA v1 板的外观

这是 MTIA 服务器设计中的巧妙之处。Yosemite 服务器中有一个 PCI-Express 交换机的叶/脊网络,它不仅可以让 MTIA 连接到主机,还可以相互连接,并连接到 96 GB 的主机 DRAM,必要时可以存储更大的嵌入。(就像 Nvidia 打算对 Grace-Hopper 做的那样。)

Meta一系列博文中表示,它在 2020 年设计了第一代芯片,作为元训练和推理加速器 (MTIA) 计划的一部分。目的是提高它用于在新闻提要中投放广告和其他内容的推荐模型的效率。

第一个 MTIA 芯片专门专注于推理AI 的过程,在该过程中,根据大量数据训练的算法会判断是否将舞蹈视频或猫表情包显示为用户提要中的下一个帖子。Meta 的软件工程师 Joel Coburn 在介绍新芯片时表示,Meta 最初将图形处理单元或 GPU 用于推理任务,但发现它们不太适合推理工作。

“尽管对软件进行了重大优化,但它们对于真实模型的效率仍然很低。这使得它们在实践中部署起来具有挑战性且成本高昂,”Coburn 说。“这就是我们需要 MTIA 的原因。”

Meta 发言人拒绝就新芯片的部署时间表发表评论,也拒绝详细说明开发可以训练模型的芯片的计划。

Meta 还更新了围绕更现代的面向 AI 的网络和冷却系统重新设计其数据中心的计划,并表示将在今年破土动工其首个此类设施。一名员工在解释这些变化的视频中表示,新设计的成本将降低 31%,而且建造速度可能是公司目前数据中心的两倍。

Meta 表示,它拥有一个人工智能系统来帮助其工程师创建计算机代码,类似于微软公司、亚马逊公司和 Alphabet 公司提供的工具。

值得注意的是,前不久,Meta从英国人工智能(AI)芯片公司Graphcore挖来了一个团队,该团队此前在挪威奥斯陆工作,直到去年年底还在Graphcore开发AI网络技术。

据悉,该团队共有10人,他们在Graphcore工作到去年12或今年1月,随后在今年2月或3月加入Meta。在回应媒体置评要求时,Meta发言人Jon Carvill证实,该公司确实招聘了上述团队。Carvill表示:“最近,我们在奥斯陆迎接了一些高度专业化的工程师加入Meta的基础设施团队。他们带来了超级计算机系统设计和开发方面的深厚专业知识,以支持Meta数据中心大规模的AI和机器学习。”Carvill拒绝透露这些员工将在Meta从事的具体工作。

自去年11月发布以来,ChatGPT掀起了一股科技热潮,几乎所有科技巨头都参与到了生成式AI领域,而Meta目前在该领域落后于微软和谷歌等竞争对手。Meta开发新AI芯片是一个重要举措,表明该公司正加大投资,提升其人工智能技术的竞争力。

审核编辑:刘清

-

risc-v多核芯片在AI方面的应用2024-04-28 844

-

RISC-V Summit China 2024 | 青稞RISC-V+接口PHY,赋能RISC-V高效落地2024-08-30 1621

-

RISC-V拥有巨大市场潜力的原因2024-09-30 2138

-

RISC-V,正在摆脱低端2023-05-30 1961

-

阿里平头哥发布首个 RISC-V AI 软硬全栈平台2023-08-26 699

-

RISC-V强势崛起为芯片架构第三极2023-08-30 718

-

RISC-V内核突破百亿颗 RVV1.0如何解锁端侧AI市场应用潜能2023-12-01 1492

-

OPEN AI 携芯来科技扩大RISC-V软件生态2020-10-22 2517

-

时擎科技研:RISC-V指令架构对智能芯片的赋能2023-03-31 682

-

又一大厂发力RISC-V,Meta第一代自研AI加速器MTIA2023-05-23 3178

-

RISC-V和RISC-V AI的未来(特邀讲座)2023-07-14 845

-

Meta:正在多款自研芯片上使用RISC-V2023-07-27 1504

-

从授权到自研内核,汽车MCU大厂倒戈RISC-V?2023-12-05 2831

-

瑞萨推出采用自研CPU内核的通用32位RISC-V MCU 加强RISC-V生态系统布局2024-03-28 1189

-

瑞萨电子推出业界首款自研通用型32位RISC-V MCU内核2024-05-17 1899

全部0条评论

快来发表一下你的评论吧 !