恩智浦的eIQ ML软件开发环境变得更加智能和友好

描述

边缘智能是自问世以来最具颠覆性的创新之一 的物联网 (IoT)。虽然物联网产生了数十亿的智能, 连接设备为基于 AI 传输无数 TB 的传感器数据 云计算,另一场革命正在进行中:机器学习(ML) 边缘设备。随着越来越多的智能迁移到网络边缘,恩智浦 通过提供成本、性能和功耗优化来拥抱这一趋势 处理解决方案,推动 ML 技术跨多个市场 应用程序,为最终用户提供增强安全性的好处, 更好的隐私和更低的延迟。

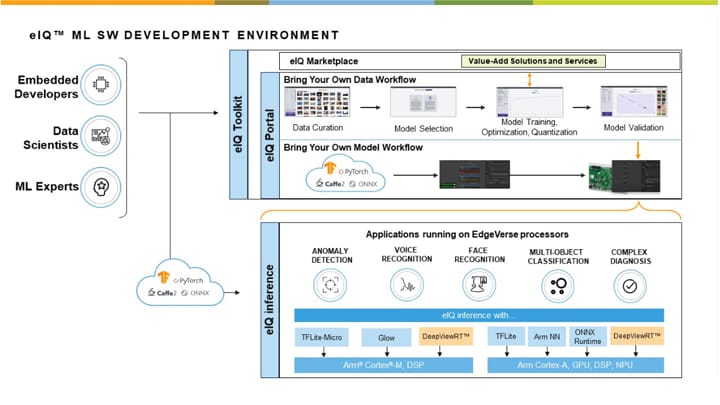

开发 ML、深度学习和神经网络应用程序传统上具有 是数据科学家和人工智能专家的领域。但这种情况正在改变 更多的 ML 工具和技术已经可用于抽象出一些 开发机器学习应用程序的复杂性。一个恰当的例子是 恩智浦的eIQ(“边缘智能”)ML开发环境。eIQ 提供 全面的工作流工具集、推理引擎、神经网络 (NN) 编译器、优化的库和技术,可简化和加速 ML 面向所有技能水平的用户进行开发,从嵌入式开发人员开始 在他们的第一个深度学习项目中,向专注于高级对象的专家介绍 检测、分类、异常检测或语音识别解决方案。

eIQ ML 软件于 2018 年推出,现已发展到支持系统级 面向恩智浦 i.MX 系列的应用和ML算法支持,来自 低功耗 i.MX RT交叉微控制器(MCU)到多核 i.MX 8和 i.MX 基于 Arm Cortex-M 和 Cortex-A 内核的 8M 应用处理器。

帮助ML开发人员提高工作效率,更熟练地掌握恩智浦 i.MX 8个处理平台,我们显著扩展了eIQ软件 环境,包括新的 eIQ 工具包工作流工具、基于 GUI 的 eIQ 门户 开发环境和 DeepViewRT™推理引擎 针对 i.MX 和 i.MX RT 设备进行了优化。

图1.eIQ 工具包和 eIQ 门户功能的高级演示 和工作流程。

让我们仔细看看这些强大的 eIQ 新增功能如何 软件环境可以帮助简化 ML 开发,提高生产力, 并为开发人员提供更多选择和更大的灵活性。

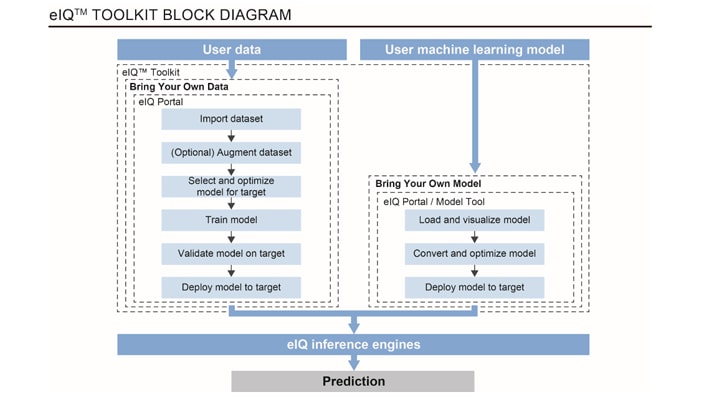

eIQ 工具包:为每个人启用“ML”

考虑到机器学习、神经网络和深度的潜在复杂性 学习应用程序 - 以及 ML 开发人员的不同需求 - 一个简单的 “一刀切”工具不是答案。更好的方法是提供 全面而灵活的工具包,可扩展以满足技能和需求 ML 开发人员的经验水平。为此,我们添加了强大的 易于使用的 eIQ 工具包适用于 eIQ ML 开发环境,支持 开发人员导入数据集和模型以及训练、修剪、量化、验证 并在恩智浦 i.MX 8M系列中部署神经网络模型和ML工作负载 的应用处理器和 i.MX RT 分频 MCU 产品组合。是否 是开始您的第一个 ML 项目的嵌入式开发人员,精通 数据科学家或 AI 专家,您将找到合适的工具包功能 匹配您的技能水平并简化您的 ML 项目。

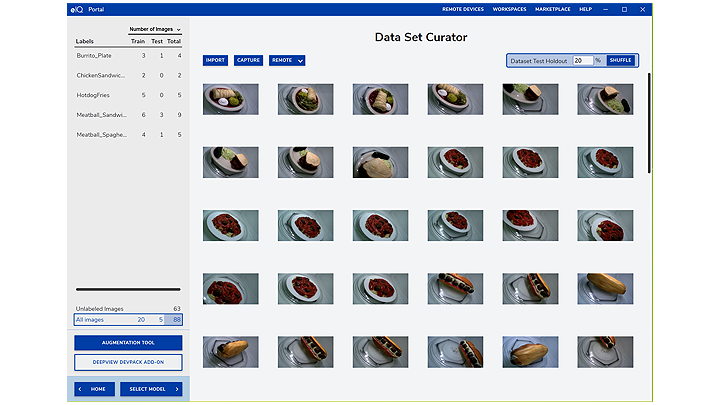

图2.eIQ 门户提供了一个数据集策展人来帮助您注释和 组织所有训练数据。

eIQ 工具包提供简单的工作流程和 ML 应用程序 例子。该工具包还提供了一个直观的、基于 GUI 的开发选项 使用 eIQ 门户和使用命令行主机工具的选项,如果 你更喜欢。如果您想利用现成的开发解决方案或 需要恩智浦或我们值得信赖的专业服务和支持 合作伙伴,该工具包可让您轻松访问我们不断增长的选项列表 来自Au-Zone Technologies等公司的eIQ Marketplace。

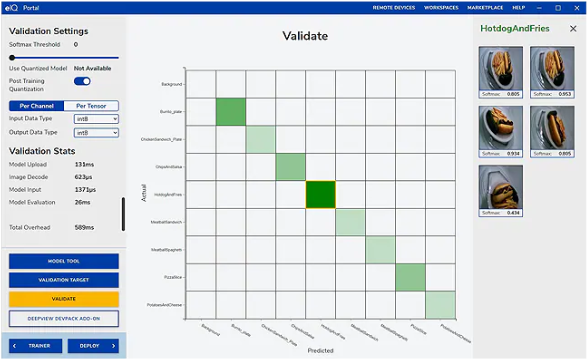

图3.eIQ 门户提供了一种方便的模型验证方法和 测量精度。

使用 eIQ 门户,您可以轻松创建、优化、调试、转换和 导出ML模型,以及从TensorFlow,ONNX导入数据集和模型 和 PyTorch ML 框架。您可以使用您的数据训练模型 “自带数据”(BYOD) 流程,从预训练数据库中进行选择 模型或使用“自带模型”(BYOM) 导入预训练模型 流,例如Au-Zone技术的高级检测模型。通过遵循简单的 BYOM 过程,您可以使用 基于公共或私有云的工具,然后将模型传输到eIQ 在适当的硅优化推理引擎上运行的工具包。

图4.eIQ 门户为 BYOM 和 BYOD 提供了一种灵活的方法。

目标图形级分析功能为开发人员提供运行时 微调和优化系统参数、运行时性能、 用于在 i.MX 设备上执行的内存使用情况和神经网络架构。

加速恩智浦最新的eIQ推理引擎

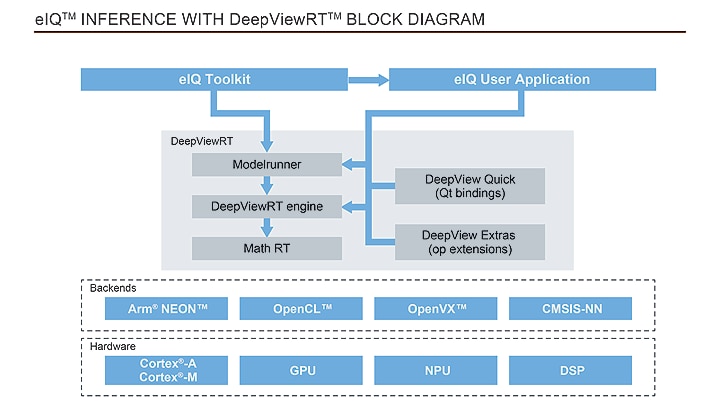

机器学习开发项目的核心是推理引擎 – ML 应用程序的运行时组件。除了支持 使用各种基于社区的开源推理引擎进行推理 针对 Glow、ONNX 和 TensorFlow Lite 等 i.MX 设备和 MCU 进行了优化,我们 已将 DeepViewRT 推理引擎添加到我们的 eIQ ML 软件开发中 环境。

DeepViewRT与我们的合作伙伴Au-Zone Technologies合作开发,是一种专有的推理引擎,可提供稳定,更长的时间 术语供应商维护的解决方案,补充了基于社区的开放解决方案 推理引擎。

图5.DeepViewRT 为 ML 应用程序提供了稳定、生产就绪且灵活的推理引擎。

DeepViewRT推理引擎可作为恩智浦MCUXpresso的中间件提供。 适用于Linux的SDK和Yocto BSP发布™基于操作系统的开发。

审核编辑:郭婷

-

采用恩智浦应用软件包快速启动产品开发2022-03-17 2307

-

如何训练一个有效的eIQ基本分类模型2024-08-01 3389

-

恩智浦eIQ Time Series Studio 工具使用全攻略2024-12-12 2612

-

eIQ软件对ML模型有何作用2021-12-20 1398

-

软通动力启航 KS_IoT 智能开发套件 软件开发环境搭建2022-07-01 3649

-

恩智浦eIQ® Neutron神经处理单元2023-02-17 845

-

Linux软件开发环境2021-03-25 961

-

STM32 软件开发环境搭建2021-11-13 920

-

恩智浦全新MCUXpresso工具集为嵌入式应用简化软件开发2023-03-24 2335

-

NVIDIA TAO工具套件功能与恩智浦eIQ机器学习开发环境的集成2024-03-22 1621

-

恩智浦eIQ AI和机器学习开发软件增加两款新工具2024-11-01 1560

-

恩智浦eIQ Time Series Studio简介2025-07-02 1431

全部0条评论

快来发表一下你的评论吧 !