NVIDIA CPU+GPU超级芯片终于量产

描述

2022年3月,NVIDIA发布了首款数据中心CPU Grace、新一代高性能计算GPU Hopper,同时利用它们打造了两颗“超级芯片”(Super Chip),一是Grace CPU二合一,二是Grace CPU+Hopper GPU二合一,看起来都极为酷炫。

现在,足足14个月过去了,NVIDIA终于宣布,GH200 Grace Hopper超级芯片已经全面投产,将为复杂AI、HPC工作负载提供澎湃的动力。

再加上Grace CPU、Hopper GPU、Ada Lovelace GPU、BlueField DPU等全套系统方案,NVIDIA现在已经有400多种配置,可满足市场对生成式AI的激增需求。

欧洲和美国的超大规模云服务商、超算中心,将会成为接入GH200系统的首批客户。

同时,黄仁勋还公布了Grace Hopper的更多细节,尤其是它的CPU、GPU之间使用NVLink-C2C互连技术,总带宽高达900GB/s,相比传统的PCIe 5.0通道超出足足7倍,能够满足要求最苛刻的生成式AI和HPC应用,功耗也降低了超过80%。

Grace Hopper是一块CPU+GPU合体的超级芯片,CPU是NVIDIA自研的72核处理器,Neoverse V2内核,拥有480GB LPDDR5内存,512GB/s带宽。

GPU部分是H100,FP64性能34TFLOPS,但更强的是INT8性能,AI运算能力达到了3958TFLOPS,带96GB HBM3内存。

同时,NVIDIA发布了针对AI推出的大内存DGX GH200超算系统,配备了256个Grace Hopper芯片,总计1.8万CPU核心,144TB内存,相比之前涨了500倍。

AI运算对内存容量的要求更高,所以DGX GH200通过最新的NVLink、NVLink Switch等技术连接了256块Grace Hooper超级芯片,实现了极为夸张的性能及内存。

GH200总计有256块Grace Hooper芯片,因此总计18432个CPU核心,144TB HBM3内存,AI性能达到了1 exaFLOPS,也就是100亿亿次。

这是什么概念?当前最强的TOP500超算也就是百亿亿次性能,只不过这个性能是HPC计算的,NVIDIA的是百亿亿次AI性能。

为了让256个超级芯片互联,GH200还使用了256块单口400Gb/s InfiniBand互联芯片,256个双口200Gb/s InfiniBand芯片,还有96组L1 NVLink、36组L2 NVLink开关等等,设计非常复杂。

NVIDIA表示,谷歌、Meta及微软是首批获得DGX H200系统的公司,后续他们还会开放给更多客户,运行客户定制。

不过DGX H200还不是最强的,NVIDIA今年晚些时候会推出名为NVIDIA Helios的AI超算系统,由4组GH200组成,总计1024个Grace Hooper超级芯片,576TB HBM内存。

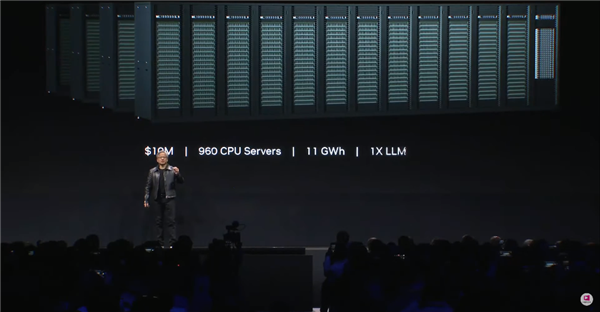

黄仁勋还向传统的CPU服务器集群发起“挑战”,认为在人工智能和加速计算这一未来方向上,GPU服务器有着更为强大的优势。

根据黄仁勋在演讲上展示的范例,训练一个LLM大语言模型,将需要960个CPU组成的服务器集群,这将耗费大约1000万美元(约合人民币7070万元),并消耗11千兆瓦时的电力。

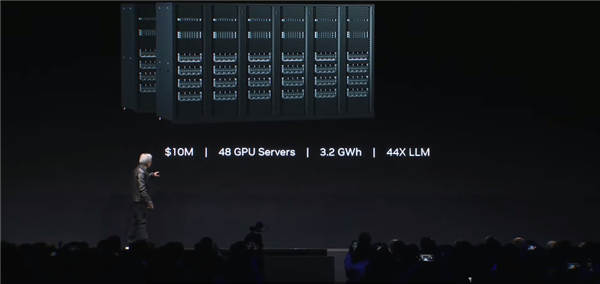

相比之下,同样以1000万美元的成本去组建GPU服务器集群,将以仅3.2千兆瓦时的电力消耗,训练44个LLM大模型。

如果同样消耗11千兆瓦时的电量,那么GPU服务器集群能够实现150倍的加速,训练150个LLM大模型,且占地面积更小。

而当用户仅仅想训练一个LLM大模型时,则只需要一个40万美元左右,消耗0.13千兆瓦时电力的GPU服务器即可。

换言之,相比CPU服务器,GPU服务器能够以4%的成本和1.2%的电力消耗来训练一个LLM,这将带来巨大的成本节省。

审核编辑 :李倩

-

大数据和云计算领域将替代CPU+GPU2017-01-12 4990

-

NVIDIA-SMI:监控GPU的绝佳起点2018-09-04 3066

-

Nvidia GPU风扇和电源显示ERR怎么解决2021-12-30 2275

-

在Ubuntu上使用Nvidia GPU训练模型2022-01-03 2398

-

Arm Neoverse NVIDIA Grace CPU 超级芯片:为人工智能的未来设定步伐2022-03-29 4964

-

CPU内存或GPU内存进行分组方式实战2018-05-03 7808

-

ARM服务器CPU终于正式量产2018-12-01 8098

-

NVIDIA研发新型 CPU+GPU 合体加速技术2020-11-13 2275

-

超算硝烟再起,CPU+GPU还能玩出新花样?2022-02-24 5061

-

CPU+GPU架构超算的未来发展趋势分析2022-03-01 4529

-

NVIDIA 推出 Grace CPU 超级芯片2022-03-23 2312

-

NVIDIA发布最新Hopper架构的H100系列GPU和Grace CPU超级芯片2022-03-26 3756

-

工业富联采用基于英伟达的超级芯片NVIDIA Grace CPU2022-05-26 4941

-

NVIDIA为HPC和AI加强超级芯片工程2022-10-11 2184

-

NVIDIA CPU+GPU超级芯片大升级!2023-08-10 2274

全部0条评论

快来发表一下你的评论吧 !