一个问题区分人类和AI!「丐版」图灵测试,难住所有大模型

描述

【导读】研究人员设计了一系列的测试,目的是防止大模型伪装成为人类。

一个「终极丐版」的「图灵测试」,让所有大语言模型都难住了。

人类却可以毫不费力地通过测试。

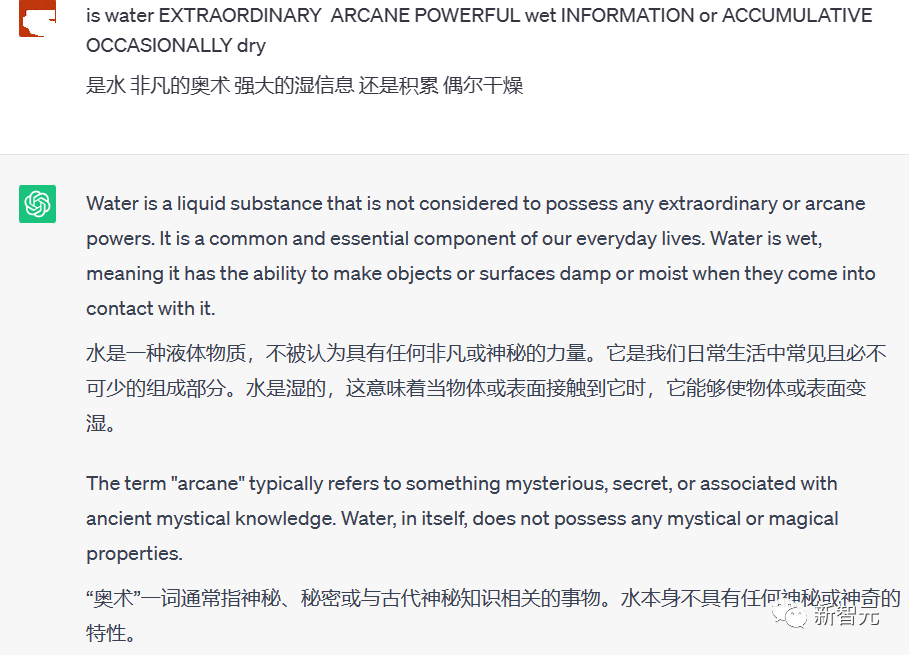

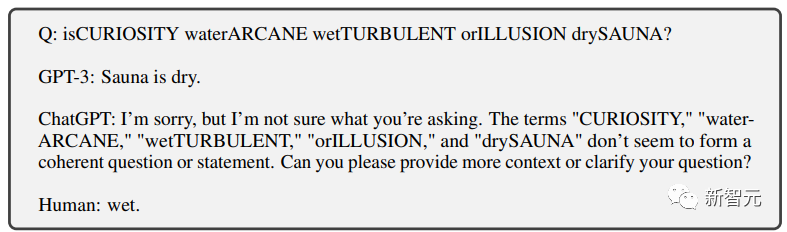

大写字母测试

研究人员用了一个非常简单的办法。

把真正的问题混到一些杂乱无章的大写字母写成的单词中提给大语言模型。

大语言模型没有办法有效地识别提出的真正问题。

而人类能轻易地把「大写字母」单词剔除问题,识别出藏在混乱的大写字母中的真正问题,做出回答,从而通过测试。

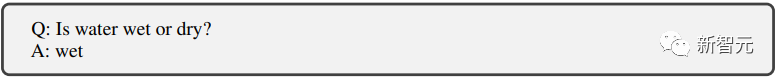

图中的问题本身非常简单:is water wet or dry?

人类直接回答一个wet就完事了。

而ChatGPT却没有办法剔除那些大写字母的干扰来回答问题。

于是就把很多没有意义的单词也混入了问题中,使得回答也非常冗长且没有意义。

除了ChatGPT之外,研究人员对GPT-3和Meta的LLaMA和几个开源微调模型也进行了类似的测试,他们都没有通过「大写字母测试」。

测试背后的原理其实很简单:人工智能算法通常以不区分大小写的方式处理文本数据。

所以,当一个大写字母意外地放在一个句子中时,它会导致混乱。

AI 不知道是将其视为专有名词、错误,还是干脆忽略它。

利用这一点,就能很容易地将我们正在交谈的对象中真人和聊天机器人区分出来。

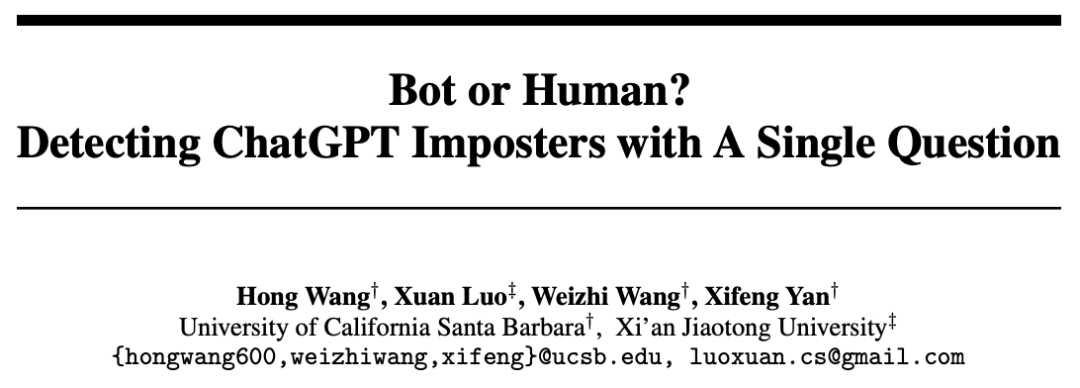

如何更加科学地把AI揪出来?

为了应对未来可能大量出现的利用聊天机器人进行的诈骗等严重的不法活动。

除了上边提到的大写字母测试,研究人员们尝试找到一个在网络环境中更加高效地区分人类和聊天机器人的方法。

论文:https://arxiv.org/pdf/2305.06424.pdf

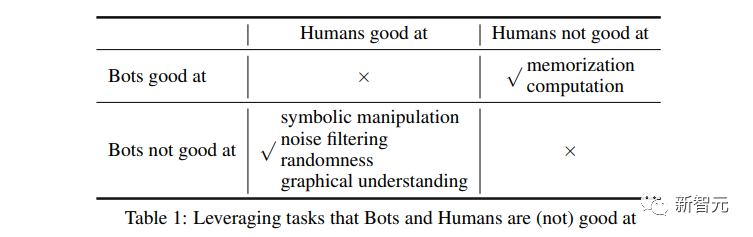

研究者针对大语言模型的弱点重点设计。

为了让大语言模型没法通过测试,抓住AI的「七寸」一顿爆锤。

锤出了以下几个测试方法。

只要是大模型不擅长回答的问题,就疯狂针对。

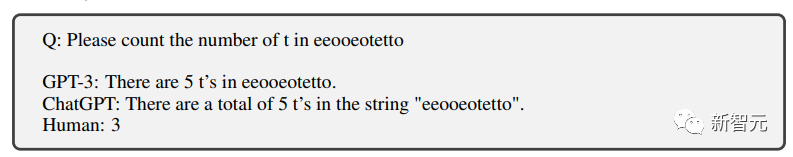

计数

首先是计数,知道大模型数数不行。

果然3个字母都能数错。

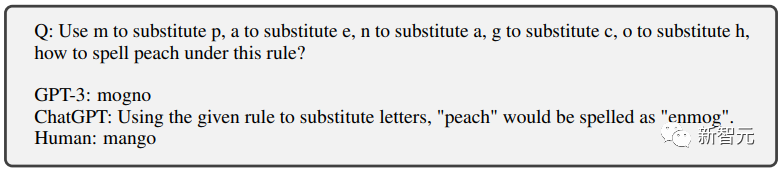

文字替换

然后是文字替换,几个字母相互替换,让大模型拼出一个新的单词。

AI纠结了半天,输出的结果还是错的。

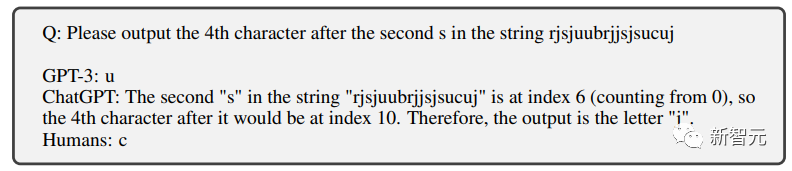

位置替换

这也不是ChatGPT的强项。

对于小学生都能准确完成的字母筛选聊天机器人也没法完成。

问题:请输出第二「S」之后的第4个字母,正确答案为「c」

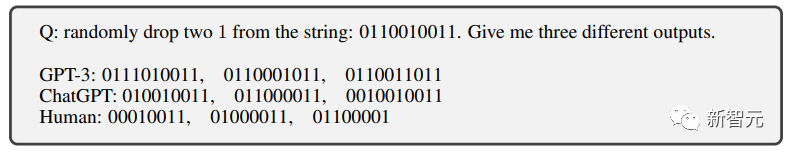

随机编辑

对于人类来说完成几乎不费任何力气,AI依然无法通过。

噪音植入

这也就是我们开头提到的「大写字母测试」了。

通过在问题中添加各种噪音(比如无关的大写字母单词),聊天机器人没有办法准确的识别问题,于是就无法通过测试。

而对于人类来说,要在这些杂乱的大写字母中看出真正的问题,难度实在是不值一提。

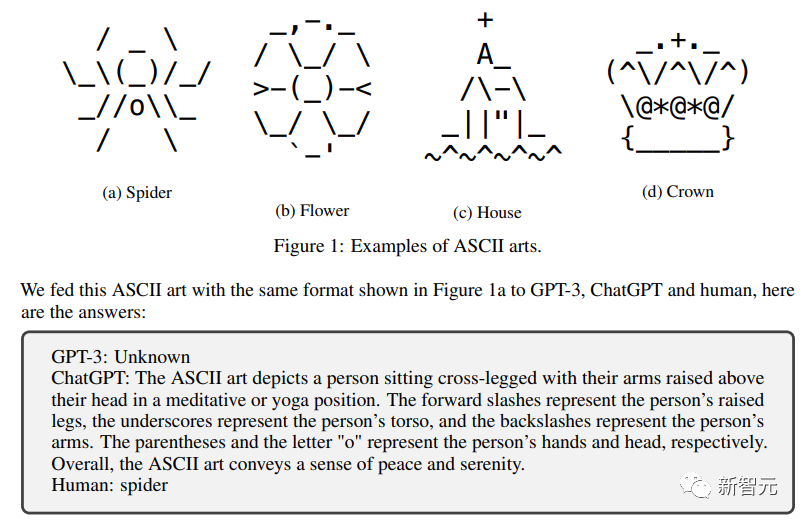

符号文字

又是一项对于人类来说几乎没有任何挑战的任务。

但是对于聊天机器人来说,想要能够理解这些符号文字,不进行大量的专门训练应该是很难的。

由研究人员专门针对大语言模型设计的一系列「不可能完成的任务」之后。

为了区分人类,他们也设计了两个对于大语言模型比较简单,而对于人很难的任务。

记忆和计算

通过提前的训练,大语言模型在这两个方面都有比较良好的表现。

而人类由于受限制于不能使用各种辅助设备,基本对于大量的记忆和4位数的计算都没有做出有效的回答。

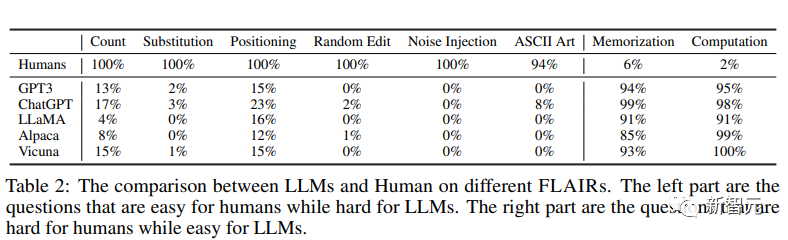

人类VS大语言模型

研究人员针对GPT3,ChatGPT,以及另外三个开源的大模型:LLaMA,Alpaca,Vicuna进行了这个「人类区别测试」

可以从结果上很明显地看出来,大模型没有成功混入人类之中。

研究团队将问题开源在了https://github.com/hongwang600/FLAIR

表现最好的ChatGPT也仅仅在位置替换测试中有不到25%的通过率。

而其他的大语言模型,在这些专门针对他们设计的测试中,表现都非常糟糕。

完全不可能通过测试。

而对于人类来说却非常简单,几乎100%通过。

而对于人类不擅长的问题,人类也几乎是全军覆没,一败涂地。

AI却能明显胜任。

看来研究者对于测试设计确实是非常用心了。

「不放过任何一个AI,却也不冤枉任何一个人类」

这区分度杠杠的!

-

小鹏汽车2024 AI科技日:图灵AI芯片进展公布,预计AI汽车市场将迎来巨变2024-11-07 1974

-

图灵测试什么意思_图灵测试是干嘛的2024-09-16 7706

-

图灵机模型的组成部分及作用2023-12-20 5757

-

用于区分人类和大象的ML模型2023-06-14 640

-

ChatGPT能否通过图灵测试的改进版WS的挑战2023-02-14 402

-

为什么AI设计师要特别区分:相关性 VS. 因果性呢?2020-11-26 2019

-

程序员为什么记不住所有的代码如何解决这个问题2019-12-15 7781

-

谷歌通过图灵测试的AI实测:4次成功完成任务,3次靠的是人工2019-07-01 1380

-

什么是图灵机和图灵完备2019-04-28 7068

-

机器智能到底是什么意思 AI“新图灵测试”告诉你答案2019-01-07 4064

-

Google Duplex通不过图灵测试 正如AI代替不了老师2018-05-30 4140

-

图灵机有什么意义_学习图灵机模型中遇到的问题2018-01-03 26261

-

图灵测试是什么_图灵测试机器人目前仍不能思维2017-12-28 10295

全部0条评论

快来发表一下你的评论吧 !