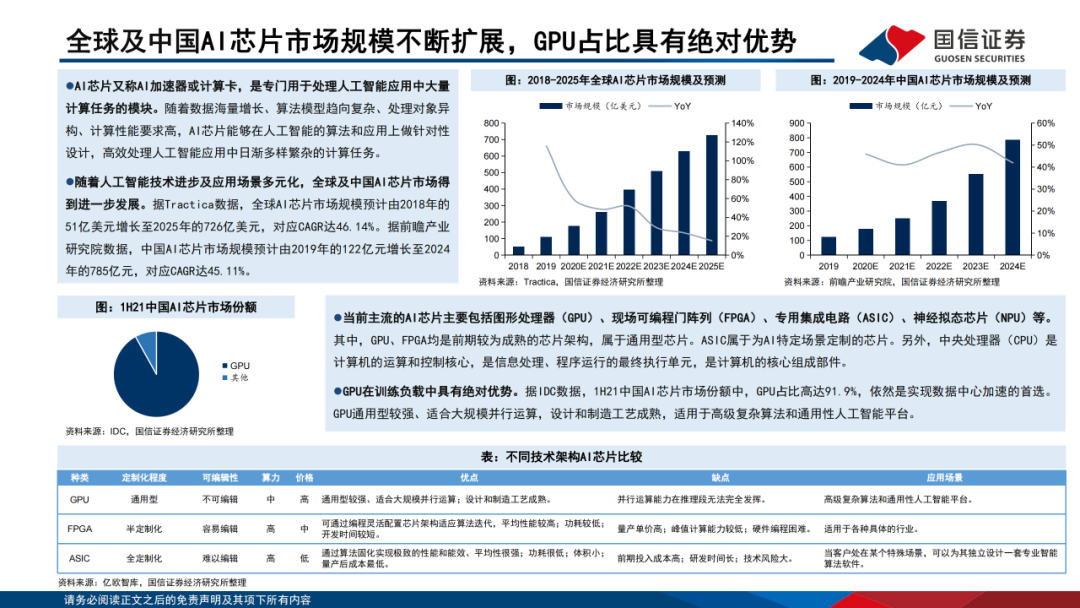

不同技术架构AI芯片比较

人工智能

描述

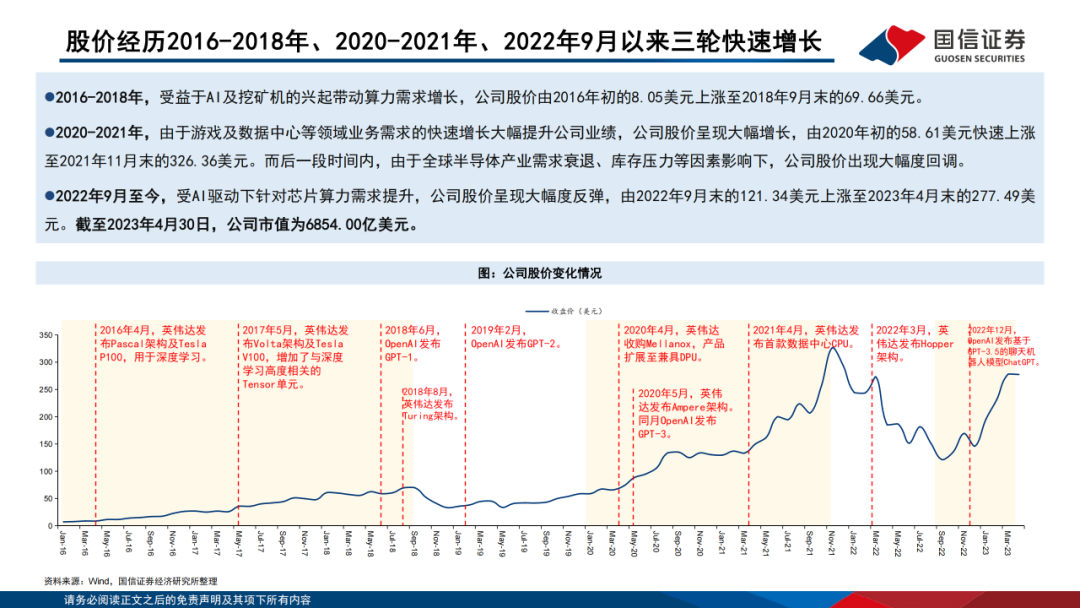

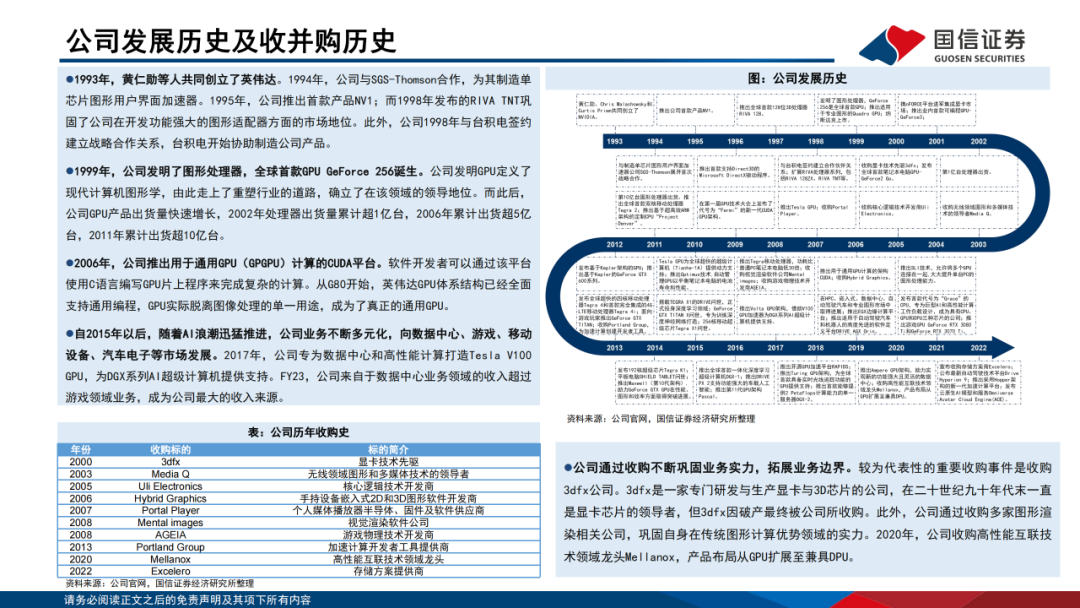

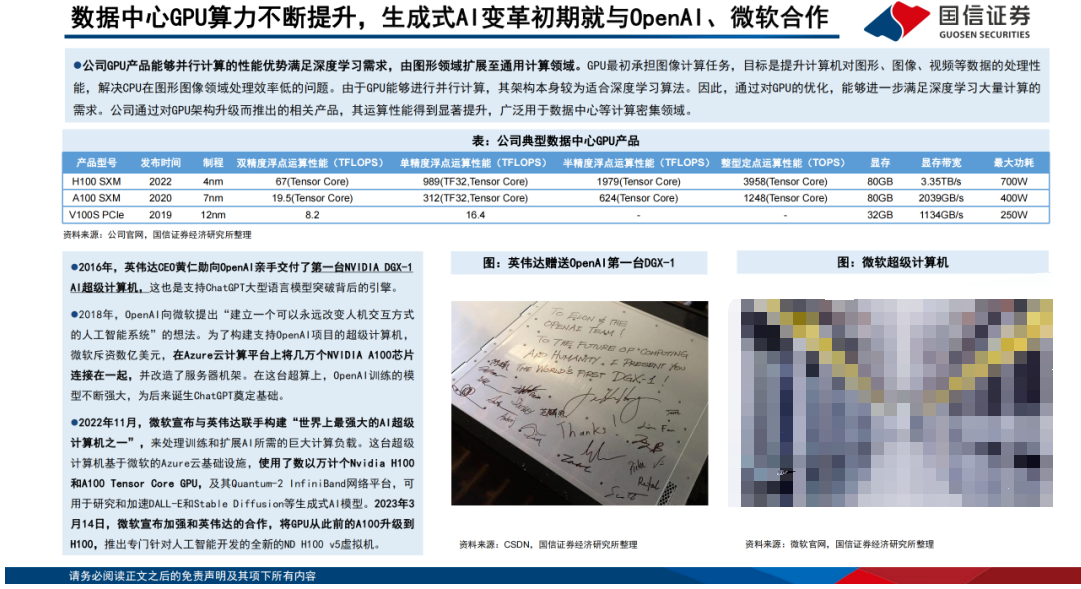

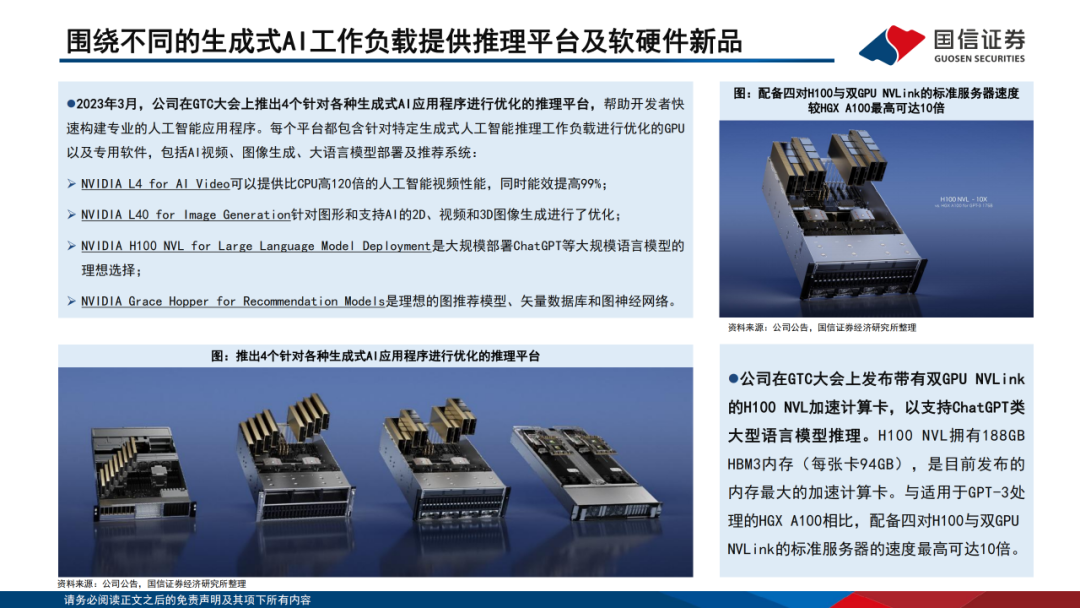

英伟达业务模式拟打造成类似于计算堆栈或神经网络,包含硬件、系统软件、平台软件和应用四层,公司结合芯片、系统和软件的全栈创新能力构建加速计算平台,并且完善针对AI加速计算及数据中心的GPU、CPU、DPU三种芯片产品结构。AI布局方面,早在生成式AI变革初期就已参与并与OpenAI、微软合作。 2023年3月,英伟达在GTC大会上推出4个针对各种生成式AI应用程序进行优化的推理平台,其中发布带有双GPU NVLink的H100 NVL加速计算卡,以支持ChatGPT类大型语言模型推理。与适用于GPT-3处理的HGX A100相比,配备四对H100与双GPU NVLink的标准服务器的速度最高可达10倍。

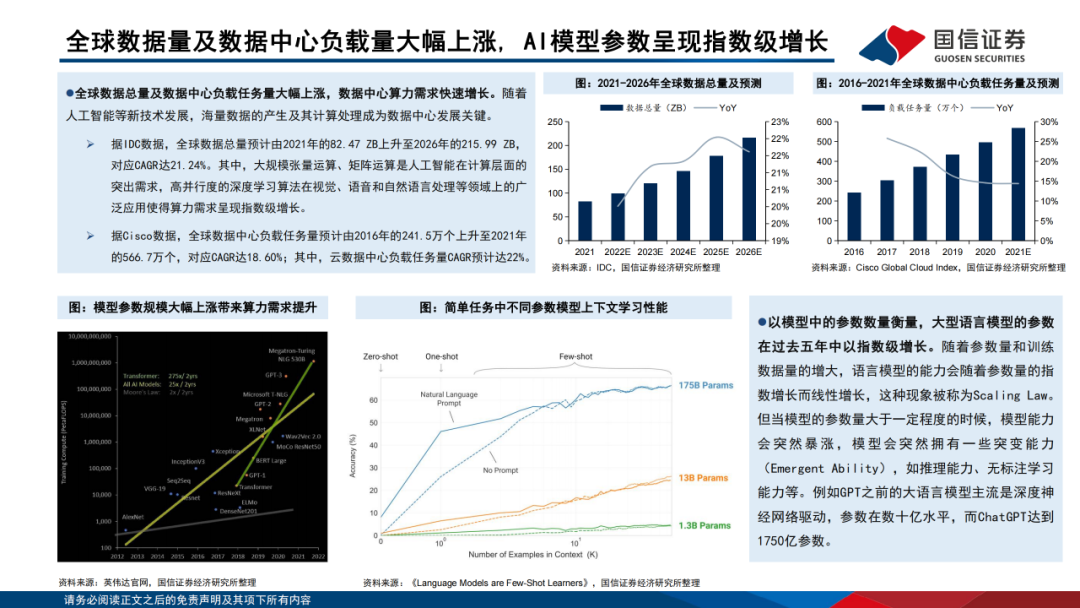

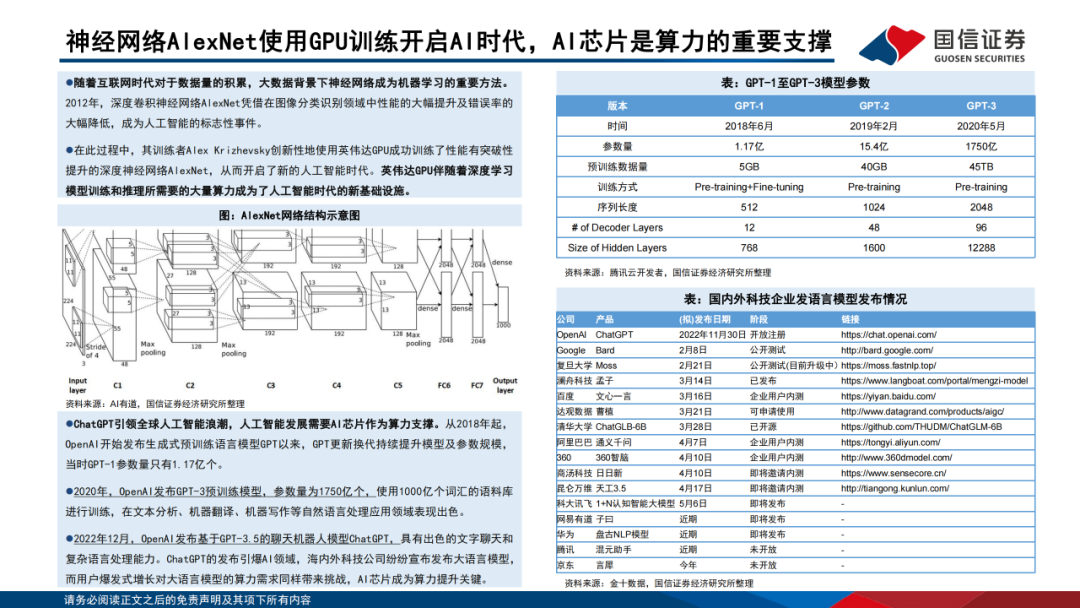

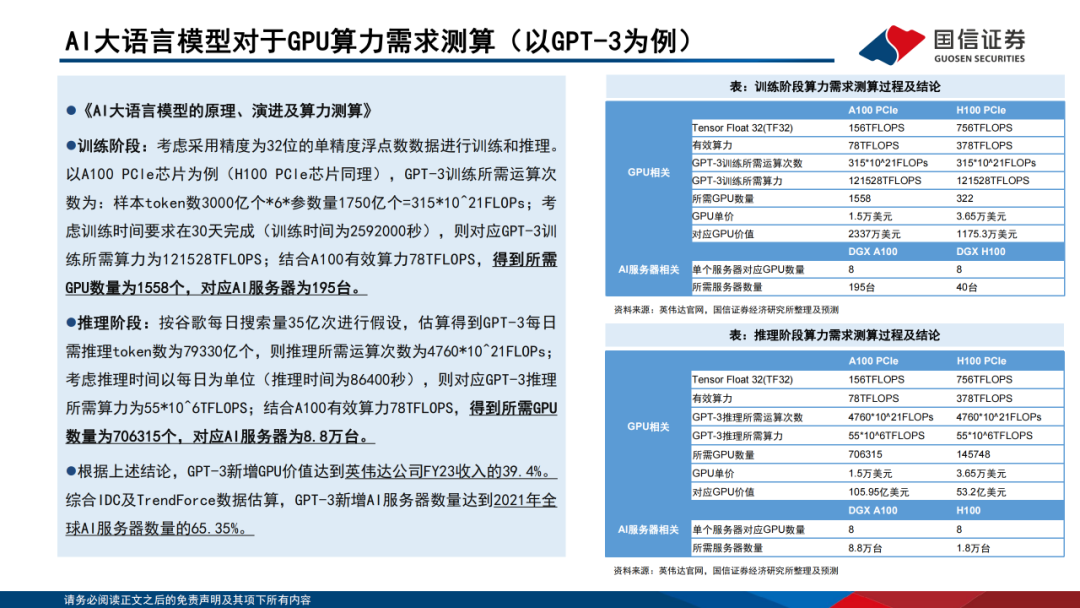

2022年12月,OpenAI发布基于GPT-3.5的聊天机器人模型ChatGPT,参数量达到1750亿个。ChatGPT引领全球人工智能浪潮,人工智能发展需要AI芯片作为算力支撑。 据Tractica数据,全球AI芯片市场规模预计由2018年的51亿美元增长至2025年的726亿美元,对应CAGR达46.14%; 据前瞻产业研究院数据,中国AI芯片市场规模预计由2019年的122亿元增长至2024年的785亿元,对应CAGR达45.11%。AI芯片中由于GPU通用型强,满足深度学习大量计算的需求,因此GPU在训练负载中具有绝对优势。以GPT-3为例,在32位的单精度浮点数数据下,训练阶段所需GPU数量为1558个,谷歌级应用推理阶段所需GPU数量为706315个。

2023年3月,公司在GTC大会上推出4个针对各种生成式AI应用程序进行优化的推理平台,帮助开发者快速构建专业的人工智能应用程序。每个平台都包含针对特定生成式人工智能推理工作负载进行优化的GPU以及专用软件,包括AI视频、图像生成、大语言模型部署及推荐系统:

NVIDIA L4 for AI Video可以提供比CPU高120倍的人工智能视频性能,同时能效提高99%;NVIDIA L40 for Image Generation针对图形和支持AI的2D、视频和3D图像生成进行了优化;NVIDIA H100 NVL for Large Language Model Deployment是大规模部署ChatGPT等大规模语言模型的理想选择;NVIDIA Grace Hopper for Recommendation Models是理想的图推荐模型、矢量数据库和图神经网络。

编辑:黄飞

-

risc-v多核芯片在AI方面的应用2024-04-28 839

-

【书籍评测活动NO.64】AI芯片,从过去走向未来:《AI芯片:科技探索与AGI愿景》2025-07-28 39689

-

AI 芯片浪潮下,职场晋升新契机?2025-08-19 478

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+内容总览2025-09-05 3490

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片的需求和挑战2025-09-12 3089

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片到AGI芯片2025-09-18 4986

-

新型DSP设计架构助力加速5G和AI开发2019-06-18 1971

-

手把手教你设计人工智能芯片及系统--(全阶设计教程+AI芯片FPGA实现+开发板)2019-07-19 8725

-

AI发展对芯片技术有什么影响?2019-08-12 3385

-

AI芯片热潮和架构创新有什么作用2020-04-23 2270

-

AI芯片热潮和架构创新是什么2020-04-24 1972

-

清华出品:最易懂的AI芯片报告!人才技术趋势都在这里 精选资料分享2021-07-23 2927

-

为何AI需要新的芯片架构?2023-05-13 1515

-

ai芯片技术架构有哪些?FPGA芯片定义及结构分析2023-08-05 10514

-

ai芯片技术架构有哪些2023-08-09 2918

全部0条评论

快来发表一下你的评论吧 !