在LabVIEW中部署YOLOv8目标检测模型

描述

作者:英特尔物联网行业创新大使 王立奇

1.1什么是 LabVIEW

LabVIEW 是测试测量与自动化行业常用的图形化开发环境,其优点有:

学习容易入门快,开发计算机视觉应用程序简单方便;

自带机器视觉函数库(Vision Development 模块),并提供支持 GigE、USB3 Vision 等标准总线的第三方相机的图像采集驱动程序(NI-IMAQdx),和 OpenCV 接口工具包(NIVision OpenCV Utilities),完全满足 AI 机器视觉应用程序的开发要求。

使用 LabVIEW 调用 OpenVINO IR 模型,可以快速完成深度学习项目开发与交付。

1.2 准备开发环境

要完成在 LabVIEW 中调用 OpenVINO 格式的 YOLOv8 模型,需要安装:

LabVIEW,Vision Development 模块和 NI-IMAQdx

OpenVINO 2023.0

Visual Studio 2022 Community

Ultralytics YOLOv8

1.2.1安装 LabVIEW

请从下方地址下载 LabVIEW 安装文件:

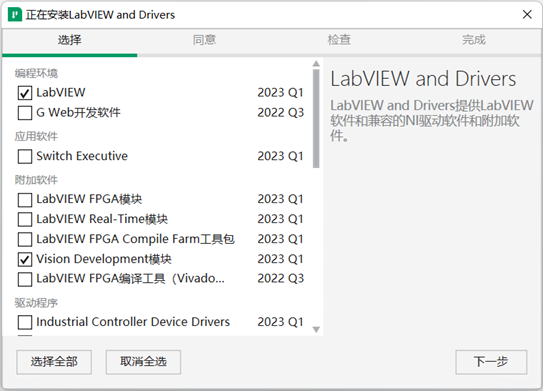

*需要注意的是:请选择 LabVIEW 64 位版本,并勾选 Vision Development 模块和 NI-IMAQdx。

1.2.2 安装 OpenVINO

OpenVINO分为 OpenVINO 运行库(OpenVINO Runtime)和 OpenVINO开发工具集(OpenVINO Development Tools)。

OpenVINO 运行库:一个提供 C/C++/Python API 的 C++ 函数库。

OpenVINO 开发工具集:一套包含模型优化器(Model Optimizer)、基准测试工具(Benchmark Tool)、训练后优化工具(Post-Training Optimization Tool)、模型下载器(Model Downloader)等工具的开发工具集。

请先用命令:

pip install openvino-dev

安装 OpenVINO 开发工具集。该命令在安装 OpenVINO 开发工具集时,会同时将提供 Python API 的 OpenVINO 运行库作为依赖项进行安装。

然后从 OpenVINO 官网:

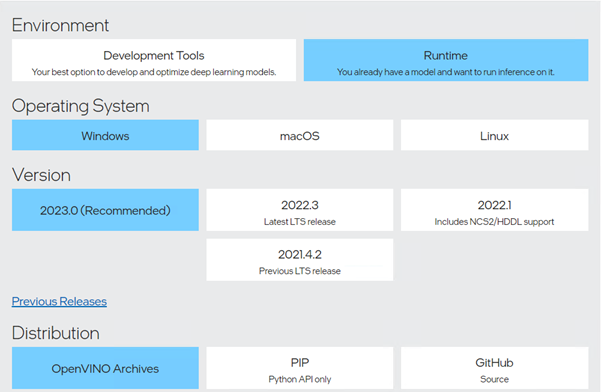

下载并解压 Windows 版的 OpenVINO 运行库,如下图所示:

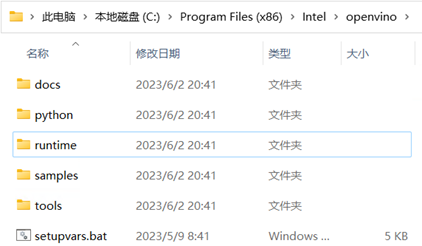

本文将 OpenVINO 运行库压缩包解压到了 C:Program Files (x86)Intelopenvino,如下图所示:

1.2.3安装 Visual Studio 2022 Community

安装 Visual Studio 2022 Community 详细步骤请参考《在Windows中基于Visual Studio配置OpenVINO C++开发环境》。

1.2.4 安装 Ultralytics 并导出 YOLOv8 模型

YOLOv8 是 Ultralytics 公司基于 YOLO 框架,发布的一款面向物体检测与跟踪、实例分割、图像分类和姿态估计任务的 SOTA(State-Of-The-Art)模型工具套件。

首先,使用命令,完成 ultralytics 软件包安装。

pip install ultralytics

然后,使用命令:

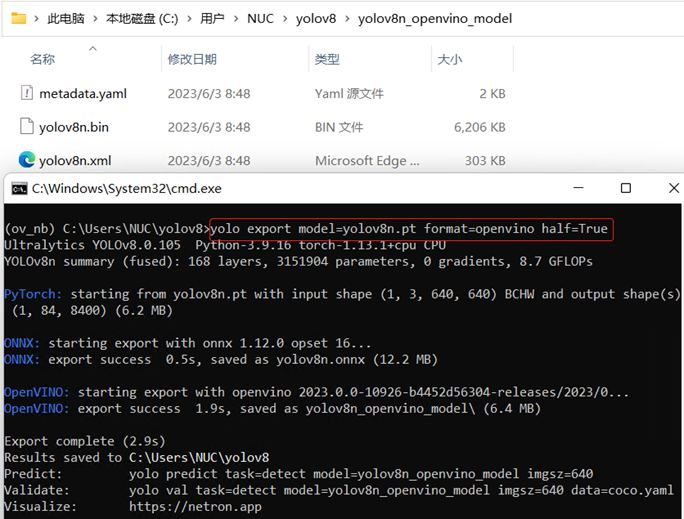

yolo export model=yolov8n.pt format=openvino half=True

导出 YOLOv8n OpenVINO 格式模型,如下图所示:

1.3为 LabVIEW 调用

编写 OpenVINO dll 封装函数

为了满足 LabVIEW 调用 C++ dll 函数的规则,需要编写 OpenVINO dll 封装函数。整个封装工作包括一个数据结构体和四个 API 函数:

结构体 lv_ov_engine:定义 OpenVINO 推理时需要传递的数据结构

create_ir():初始化 OpenVINO Core 对象并创建推理请求

infer():输入预处理后的图像数据,执行推理计算

getResult():获得推理计算结果

release():释放资源

1.3.1 定义结构体 lv_ov_engine

定义 OpenVINO 推理时需要传递的数据结构,如下所示:

//定义OpenVINO推理时需要传递的数据结构

typedef struct lv_ov_engine {

ov::Core ovCore;

ov::InferRequest infer_request;

} OvEngineStruct;

向右滑动查看完整代码

1.3.2 创建 create_ir() 函数

创建 create_ir() 函数,实现将 OpenVINO IR 模型载入指定的计算设备,并返回初始化好的推理请求,如下所示:

//将OpenVINO IR模型载入指定的推理设备

extern "C" __declspec(dllexport) OvEngineStruct * create_ir(char* xml_file, char* device_name)

{

OvEngineStruct* p = new OvEngineStruct();

auto compiled_model = p->ovCore.compile_model(xml_file, device_name);

p->infer_request = compiled_model.create_infer_request();

return p;

}

向右滑动查看完整代码

1.3.3创建 IE_Run 函数

创建 infer() 函数,输入预处理后的图像数据,执行推理计算,如下所示:

//输入预处理后的图像数据,执行推理计算

extern "C" __declspec(dllexport) void infer(OvEngineStruct * p, float* inputData)

{

ov::Tensor input_tensor0 = p->infer_request.get_input_tensor(0);

auto data0 = input_tensor0.data();

memcpy(data0, inputData, 1 * 3 * 640 * 640 * sizeof(float));

p->infer_request.infer();

}

向右滑动查看完整代码

1.3.4 创建 getResult() 函数

创建 getResult() 函数,用于获取推理结果,如下所示:

//获取推理后的结果(yolov8输出张量的大小为1*84*8400)

extern "C" __declspec(dllexport) void getResult(OvEngineStruct * p, float* data)

{

auto output = p->infer_request.get_output_tensor(0);

const float* f = output.data();

memcpy(data, f, sizeof(float) * 1 * 84 * 8400);

}

向右滑动查看完整代码

1.3.5创建 release 函数

创建 release 函数,用于释放推理引擎资源,如下所示:

//释放推理引擎

extern "C" __declspec(dllexport) void release(OvEngineStruct * p)

{

delete p;

}

向右滑动查看完整代码

完整代码请参考:openvino_vi_wrapper.cpp,在 Visual Studio 中将 openvino_vi_wrapper.cpp 编译为 dll,然后在 LabVIEW 中调用并封装为 4 个 VI,如下图所示:

1.4使用 LabVIEW OpenVINO VI

实现 YOLOv8 目标检测

请读者先克隆本文的源代码到本地:

git clone

https://github.com/wangstoudamire/lv_yolov8_openvino

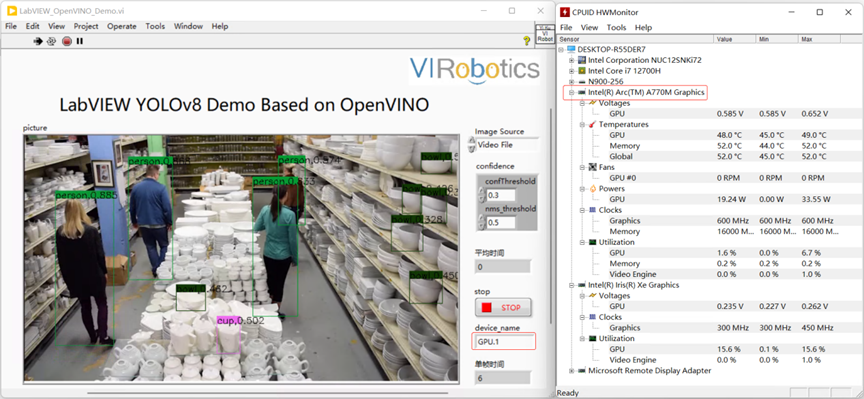

按照 README.md 文档安装相关工具包,然后运行 LabVIEW_OpenVINO_Demo.vi(运行之前请确保电脑已联网),运行结果如下图所示:

1.5结论

基于 OpenVINO,创建 LabVIEW 推理计算 VI,实现 AI 推理计算简单方便。结合 LabVIEW 图形化开发环境,可以快速开发 AI 应用程序。更多 AI 推理计算功能,可以参考 VIRobotics 的 LabVIEW AI 工具包:

审核编辑:汤梓红

-

【NPU实战】在迅为RK3588上玩转YOLOv8:目标检测与语义分割一站式部署指南2025-12-12 5722

-

使用ROCm™优化并部署YOLOv8模型2025-09-24 631

-

labview调用yolov8/11目标检测、分割、分类2025-04-21 7158

-

RV1126 yolov8训练部署教程2025-04-18 1823

-

RK3576 yolov8训练部署教程2025-04-02 1657

-

基于OpenCV DNN实现YOLOv8的模型部署与推理演示2024-03-01 3275

-

基于YOLOv8的自定义医学图像分割2023-12-20 1605

-

三种主流模型部署框架YOLOv8推理演示2023-08-06 3768

-

在AI爱克斯开发板上用OpenVINO™加速YOLOv8-seg实例分割模型2023-06-05 1829

-

AI爱克斯开发板上使用OpenVINO加速YOLOv8目标检测模型2023-05-26 2283

-

YOLOv8版本升级支持小目标检测与高分辨率图像输入2023-05-16 14830

-

在AI爱克斯开发板上用OpenVINO™加速YOLOv8目标检测模型2023-05-12 2268

-

在AI爱克斯开发板上用OpenVINO™加速YOLOv8分类模型2023-05-05 1736

-

使用YOLOv8做目标检测和实例分割的演示2023-02-06 8958

全部0条评论

快来发表一下你的评论吧 !