ONNX格式模型部署兼容性框架介绍

描述

ONNXRUNTIME介绍

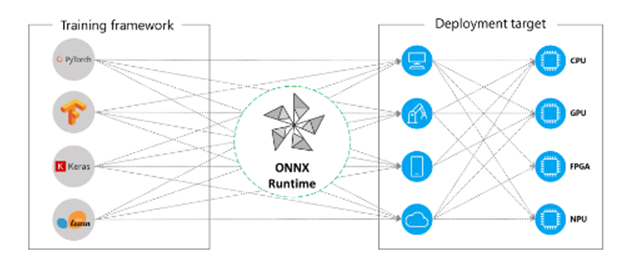

ONNX格式模型部署兼容性最强的框架 ONNXRUNTIME,基本上不会有算子不支持跟不兼容的情况出现,只要能导出ONNX格式模型,它基本上都能成功加载,成功推理。虽然在CPU速度不及OpenVINO、GPU上速度不及TensorRT,但是胜在兼容性强,支持不同硬件上推理部署包括:ARM、CPU、GPU、AMD等,

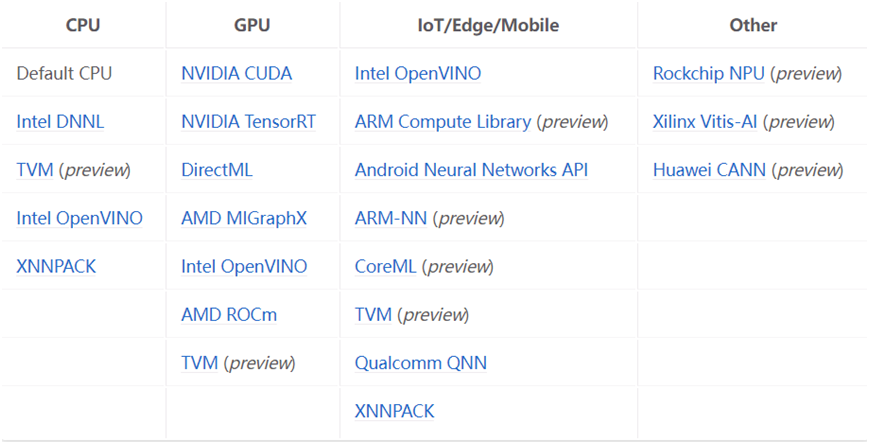

可以通过设置不同的推理后台支持,包括:

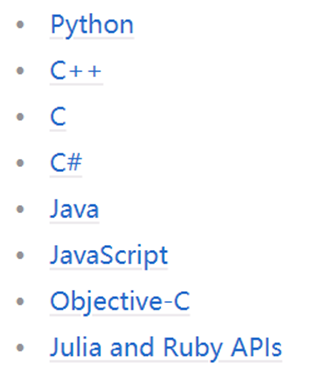

支持语言也非常丰富,不止于Python跟C++语言,支持列表如下:

支持的操作系统包括Windows、Android、乌班图、iOS等。

Python版本安装与测试

Python版本安装特别容易,一条命令行搞定 CPU版本

pip install onnxruntime

GPU版本

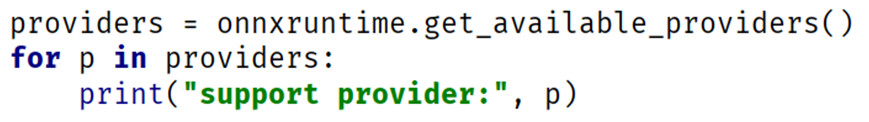

pip install onnxruntime-gpu通过下面的API函数可以查询当前支持推理Provider,代码如下:

运行结果如下:

C++版本安装与测试

首先需要下载安装包,以 microsoft.ml.onnxruntime.gpu.1.13.1为例。首先需要配置包含目录

D:microsoft.ml.onnxruntime.gpu.1.13.1buildnativeinclude

然后配置库目录:

D:microsoft.ml.onnxruntime.gpu.1.13.1runtimeswin-x64native

最后配置链接器,我的是支持CUDA版本,配置如下:

onnxruntime_providers_shared.lib onnxruntime_providers_cuda.lib onnxruntime.lib

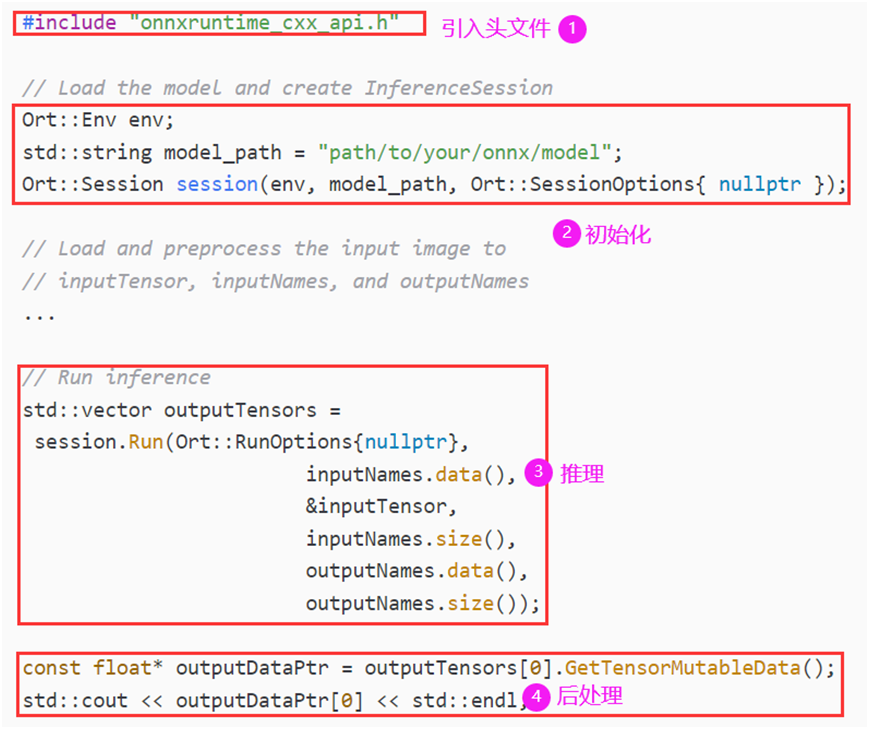

最后把DLL文件copy到编译生成的可执行文件同一个目录下,直接运行即可。C++推理,简单说分为四步,首先引入包含文件支持,再初始化推理会话对象Session,预处理图像,然后执行推理,最后完成后处理即可。

以ResNet18模型为例,导出ONNX格式,基于ONNXRUNTIME推理效果如下:

责任编辑:彭菁

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

使用模型优化器命令将ONNX模型转换为OpenVINO™ IR格式时出现“ReplacementID”错误怎么解决?2025-03-05 440

-

系统的电磁兼容性分析模型及设计方法2011-10-19 5475

-

ONNX的相关资料分享2021-11-05 1024

-

EIQ onnx模型转换为tf-lite失败怎么解决?2023-03-31 842

-

OpenHarmony 小型系统兼容性测试指南2023-04-07 1407

-

将TensorFlow Lite模型转换为ONNX2020-12-08 2114

-

嵌入式Linux平台部署AI神经网络模型Inference的方案2021-11-02 733

-

YOLOX模型ONNX格式说明2022-04-13 7648

-

如何使用TensorRT框架部署ONNX模型2022-10-31 4520

-

电磁兼容性测试介绍 (I)2022-11-04 775

-

TorchVision框架下模型导出并部署到ONNXRUNTIME C++全流程解析2023-07-13 3309

-

用STM32Cube.AI部署ONNX模型实操示例:风扇堵塞检测2023-09-28 3310

-

通过新的ONNX导出器简化模型导出流程2024-01-10 1980

-

MOV文件与其他视频格式的兼容性2024-12-06 4316

全部0条评论

快来发表一下你的评论吧 !