VisCPM:迈向多语言多模态大模型时代

描述

随着 GPT-4 和 Stable Diffusion 等模型多模态能力的突飞猛进,多模态大模型已经成为大模型迈向通用人工智能(AGI)目标的下一个前沿焦点。总体而言,面向图像和文本的多模态生成能力可以大致分为两类:

1. 在图生文(image-to-text generation)方面,以 GPT-4 为代表的多模态大模型,可以面向图像进行开放域对话和深度推理;

2. 在文生图(text-to-image generation)方面,以 Stable Diffusion 为代表的多模态模型,可以根据文本生成图像内容。由这些多模态模型掀起的 AIGC 浪潮,广泛而深刻地改变着学术界和工业界的思想实践。

然而,目前多模态大模型的成功很大程度上局限于英文世界,而中文等其他非英语语言的多模态能力明显落后。这是因为相比于英文世界,中文等其他非英语语言的多模态数据严重稀缺,难以满足多模态大模型对大规模高质量图文对数据的需求。这些问题使得多语言多模态大模型的构建极具挑战性。

为了解决上述挑战,我们提出使用高资源语言(如英语)作为桥接图像信号和低资源语言(如中文)的桥梁,实现多语言多模态大模型能力的快速泛化,从而缓解对低资源语言下模态对齐数据(图文对数据)的依赖。

通过类比人类的学习过程,我们可以直观地理解该方法:人类学习者可以仅通过母语与视觉信号的对应关系,以及母语与不同语言之间的对应关系,自然地建立起不同语言下对视觉信号的统一认知。这是由于不同的自然语言符号系统,很大程度上都是以描述相同的客观世界为驱动力演化发展而来的,这为多语言多模态能力的快速泛化提供了基础。

为了验证上述方法,我们以中英双语的多模态大模型为例,构建了 VisCPM 系列模型,建立中英双语的多模态对话能力(VisCPM-Chat 模型)和文到图生成能力(VisCPM-Paint 模型)。

在多语言对齐方面,我们选用百亿参数量的 CPM-Bee 10B 作为基底语言模型。该模型优秀的中英双语能力,提供了多语言对齐的基础。在多模态对齐方面,我们为CPM-Bee分别融合视觉编码器(Q-Former)和视觉解码器(Diffusion-UNet)以支持视觉信号的输入和输出。得益于 CPM-Bee 基座优秀的双语能力,VisCPM 可以仅通过英文多模态数据预训练,泛化实现优秀的中文多模态能力。

中英双语多模态对话模型VisCPM-Chat

VisCPM-Chat 模型使用 Q-Former 作为视觉编码器,使用 CPM-Bee(10B)作为语言基座模型,并通过语言建模训练目标融合视觉和语言模型。模型训练包括预训练和指令精调两阶段:

-

预训练:我们使用约 100M 高质量英文图文对数据对 VisCPM-Chat 进行了预训练,数据包括 CC3M、CC12M、COCO、Visual Genome、LAION 等。在预训练阶段,语言模型参数保持固定,仅更新Q-Former部分参数,以支持大规模视觉-语言表示的高效对齐。

- 指令精调:我们采用 LLaVA-150K 英文指令精调数据,并混合相应翻译后的中文数据对模型进行指令精调,以对齐模型多模态基础能力和用户使用意图。在指令精调阶段,我们更新全部模型参数,以提升指令精调数据的利用效率。有趣的是,我们发现即使仅采用英文指令数据进行指令精调,模型也可以理解中文问题,但仅能用英文回答。这表明模型的多语言多模态能力已经得到良好的泛化。在指令精调阶段进一步加入少量中文翻译数据,可以将模型回复语言和用户问题语言对齐。

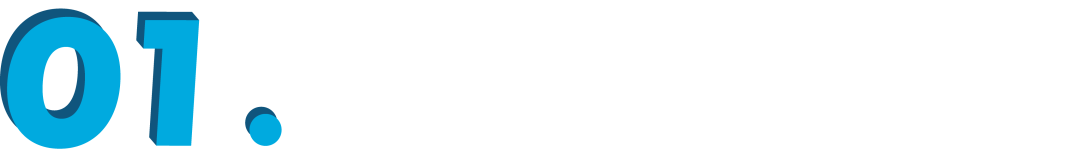

我们在 LLaVA 标准英文测试集和翻译的中文测试集对模型进行了评测,该评测基准考察模型在开放域对话、图像细节描述、复杂推理方面的表现,并使用 GPT-4 进行打分。可以观察到,在不使用任何中文图文对预训练数据的情况下,VisCPM-Chat 在中文多模态能力方面取得了最佳的平均性能,在通用域对话和复杂推理表现出色,同时也表现出了不错的英文多模态能力。

在上述平衡的中英双语能力(VisCPM-Chat-balance)基础上,我们在预训练阶段额外加入 20M 清洗后的原生中文图文对数据和 120M 翻译到中文的图文对数据,可以实现中文多模态能力的进一步强化(VisCPM-Chat-zhplus)。

VisCPM-Chat 表现出令人印象深刻的图像理解能力,并能够在对话中运用世界知识和常识知识。例如在下图中,VisCPM 能够识别染色的地图和人像,并正确理解出染色代表的不同含义。除此之外,VisCPM-Chat 还具有不错的中文特色能力,比如能用李白的诗描绘黄河的景象并作解读,在面对中秋月夜时还能用苏轼的《水调歌头》借景抒情。

中英双语文生图模型VisCPM-Paint

VisCPM-Paint 使用 CPM-Bee(10B)作为文本编码器,使用 UNet 作为图像解码器,并通过扩散模型训练目标融合语言和视觉模型。在训练过程中,语言模型参数始终保持固定。我们使用 Stable Diffusion 2.1 的 UNet 参数初始化视觉解码器,并通过逐步解冻其中关键的桥接参数将其与语言模型融合。该模型在 LAION 2B 英文图文对数据上进行了训练。

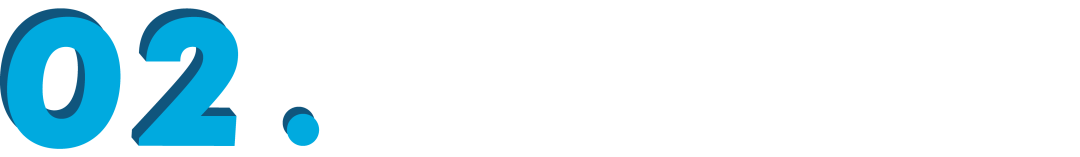

我们在标准图像生成测试集 MSCOCO 上采样了 3 万张图片,计算了常用评估图像生成指标 FID(Fréchet Inception Distance)评估生成图片的质量。与 VisCPM 类似,我们发现得益于 CPM-Bee 的双语能力,VisCPM-Paint 可以仅通过英文图文对训练,泛化实现良好的中文文到图生成能力,达到中文开源模型的最佳效果。在中英平衡能力(VisCPM-Paint-balance)的基础上,通过进一步加入 20M 清洗后的原生中文图文对数据,以及 120M 翻译到中文的图文对数据,模型的中文文到图生成能力可以获得进一步提升(VisCPM-Paint-zhplus)。

VisCPM-Paint 模型中分别输入“海上生明月,天涯共此时,唯美风格,抽象风格”和“人闲桂花落,月静春山空”两条 prompts,生成了以下两张图片。可以看出,VisCPM-Paint 对中国特色意向也有较好的把握能力。

为了推动多模态大模型开源社区和相关研究领域的发展,我们将 VisCPM 系列的所有模型免费开源(https://github.com/OpenBMB/VisCPM),欢迎个人和研究用途自由使用。未来我们也会将 VisCPM 整合到 huggingface 代码框架中,以及陆续完善安全模型、 支持快速网页部署、 支持模型量化功能、支持模型微调等功能,欢迎持续关注。

· ·

原文标题:VisCPM:迈向多语言多模态大模型时代

文章出处:【微信公众号:智能感知与物联网技术研究所】欢迎添加关注!文章转载请注明出处。

- 相关推荐

- 热点推荐

- 物联网

-

这个多语言包 怎么搜不到2024-03-24 5828

-

串口屏能否支持全球多语言功能?2019-03-27 1795

-

HarmonyOS低代码开发-多语言支持及屏幕适配2023-05-23 3209

-

多语言综合信息服务系统研究与设计2009-04-01 442

-

华硕 M3A78-EH主板多语言版说明书2010-02-03 389

-

SoC多语言协同验证平台技术研究2015-12-31 936

-

基于Toradex多语言image的编译与MUI切换演示2017-09-18 919

-

Multilingual多语言预训练语言模型的套路2022-05-05 3879

-

达观曹植大模型正式对外公测!专注于长文本、多语言、垂直化发展2023-07-12 1828

-

蚂蚁集团开源高性能多语言序列化框架Fury解读2023-08-25 2109

-

基于LLaMA的多语言数学推理大模型2023-11-08 992

-

如何在TSMaster面板和工具箱中实现多语言切换2023-11-11 2200

-

多语言开发的流程详解2023-11-30 1804

-

大语言模型(LLMs)如何处理多语言输入问题2024-03-07 1394

-

ChatGPT 的多语言支持特点2024-10-25 2194

全部0条评论

快来发表一下你的评论吧 !