深度学习如何挑选GPU?

人工智能

描述

深度学习是一个对计算有着大量需求的领域,从一定程度上来说,GPU的选择将从根本上决定深度学习的体验。因此,选择购买合适的GPU是一项非常重要的决策。那么2022年,如何选择合适的GPU呢?这篇文章整合了网络上现有的GPU选择标准和评测信息,希望能作为你的购买决策的参考。

1 是什么使一个GPU比另一个GPU更快?

有一些可靠的性能指标可以作为人们的经验判断。以下是针对不同深度学习架构的一些优先准则: Convolutional networks and Transformers: Tensor Cores > FLOPs > Memory Bandwidth > 16-bit capability Recurrent networks: Memory Bandwidth > 16-bit capability > Tensor Cores > FLOPs

2 如何选择NVIDIA/AMD/Google

NVIDIA的标准库使在CUDA中建立第一个深度学习库变得非常容易。早期的优势加上NVIDIA强大的社区支持意味着如果使用NVIDIA GPU,则在出现问题时可以轻松得到支持。但是NVIDIA现在政策使得只有Tesla GPU能在数据中心使用CUDA,而GTX或RTX则不允许,而Tesla与GTX和RTX相比并没有真正的优势,价格却高达10倍。 AMD功能强大,但缺少足够的支持。AMD GPU具有16位计算能力,但是跟NVIDIA GPU的Tensor内核相比仍然有差距。 Google TPU具备很高的成本效益。由于TPU具有复杂的并行基础结构,因此如果使用多个云TPU(相当于4个GPU),TPU将比GPU具有更大的速度优势。因此,就目前来看,TPU更适合用于训练卷积神经网络。

3 多GPU并行加速

卷积网络和循环网络非常容易并行,尤其是在仅使用一台计算机或4个GPU的情况下。TensorFlow和PyTorch也都非常适合并行递归。但是,包括transformer在内的全连接网络通常在数据并行性方面性能较差,因此需要更高级的算法来加速。如果在多个GPU上运行,应该先尝试在1个GPU上运行,比较两者速度。由于单个GPU几乎可以完成所有任务,因此,在购买多个GPU时,更好的并行性(如PCIe通道数)的质量并不是那么重要。

4 性能评测

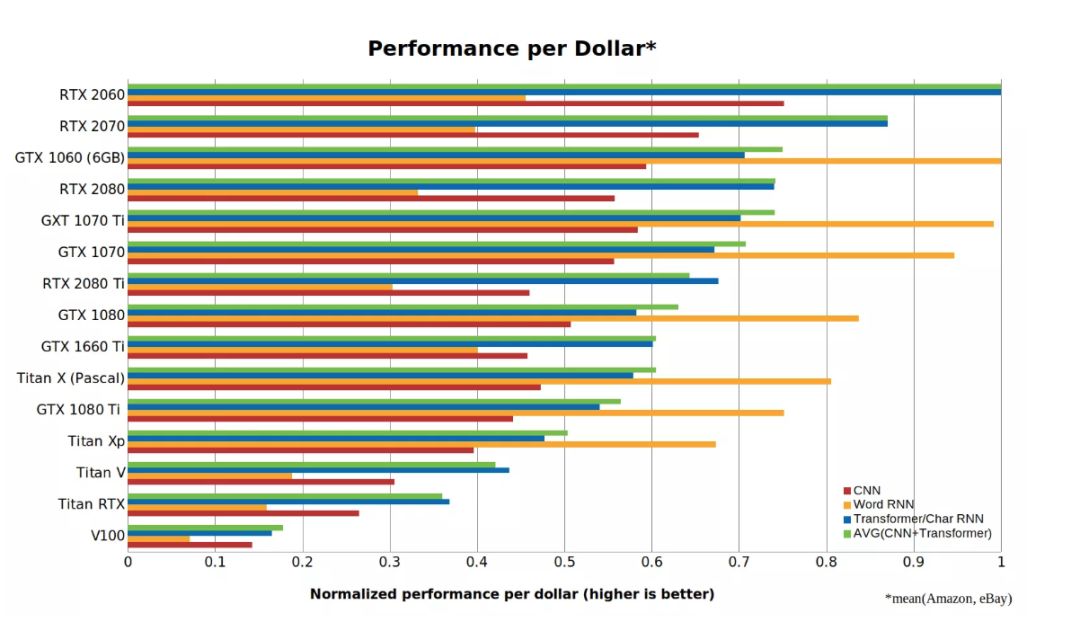

1)来自Tim Dettmers的成本效益评测[1] https://timdettmers.com/2019/04/03/which-gpu-for-deep-learning/

卷积网络(CNN),递归网络(RNN)和transformer的归一化性能/成本数(越高越好)。RTX 2060的成本效率是Tesla V100的5倍以上。对于长度小于100的短序列,Word RNN表示biLSTM。使用PyTorch 1.0.1和CUDA 10进行基准测试。 从这些数据可以看出,RTX 2060比RTX 2070,RTX 2080或RTX 2080 Ti具有更高的成本效益。原因是使用Tensor Cores进行16位计算的能力比仅仅拥有更多Tensor Cores内核要有价值得多。 2)来自Lambda的评测[2,3] https://lambdalabs.com/blog/best-gpu-tensorflow-2080-ti-vs-v100-vs-titan-v-vs-1080-ti-benchmark/ https://lambdalabs.com/blog/choosing-a-gpu-for-deep-learning/

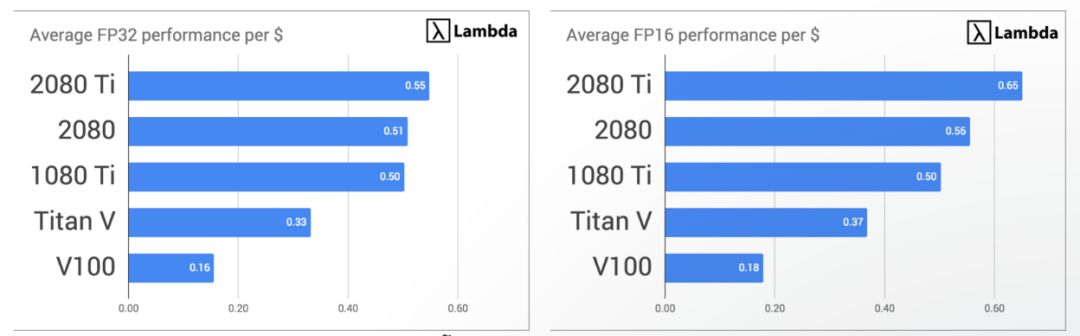

GPU平均加速/系统总成本

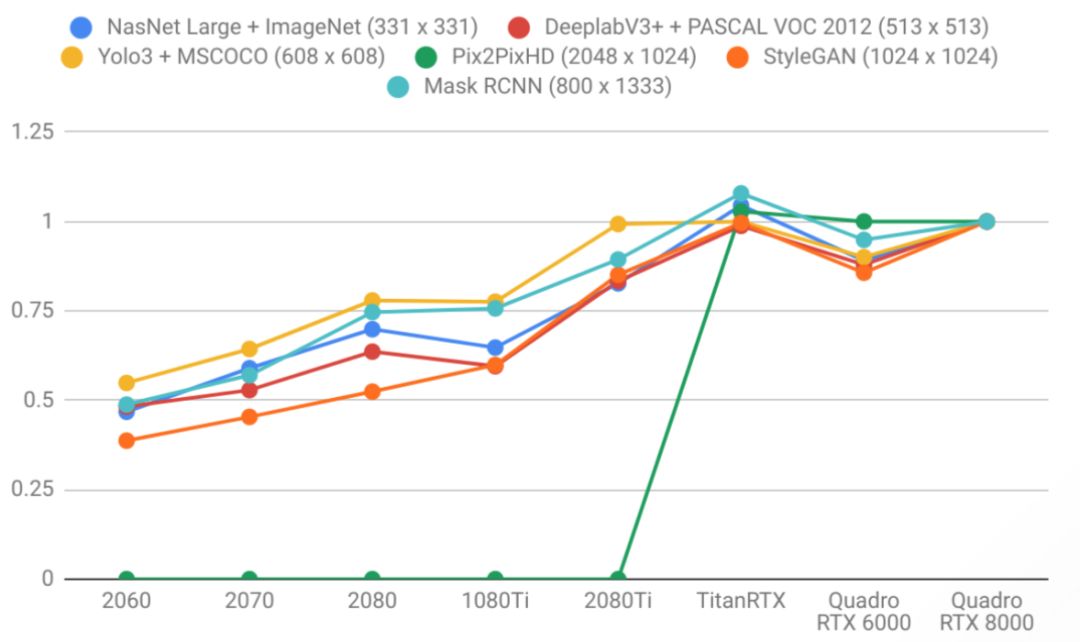

GPU性能,以每秒处理的图像为单位

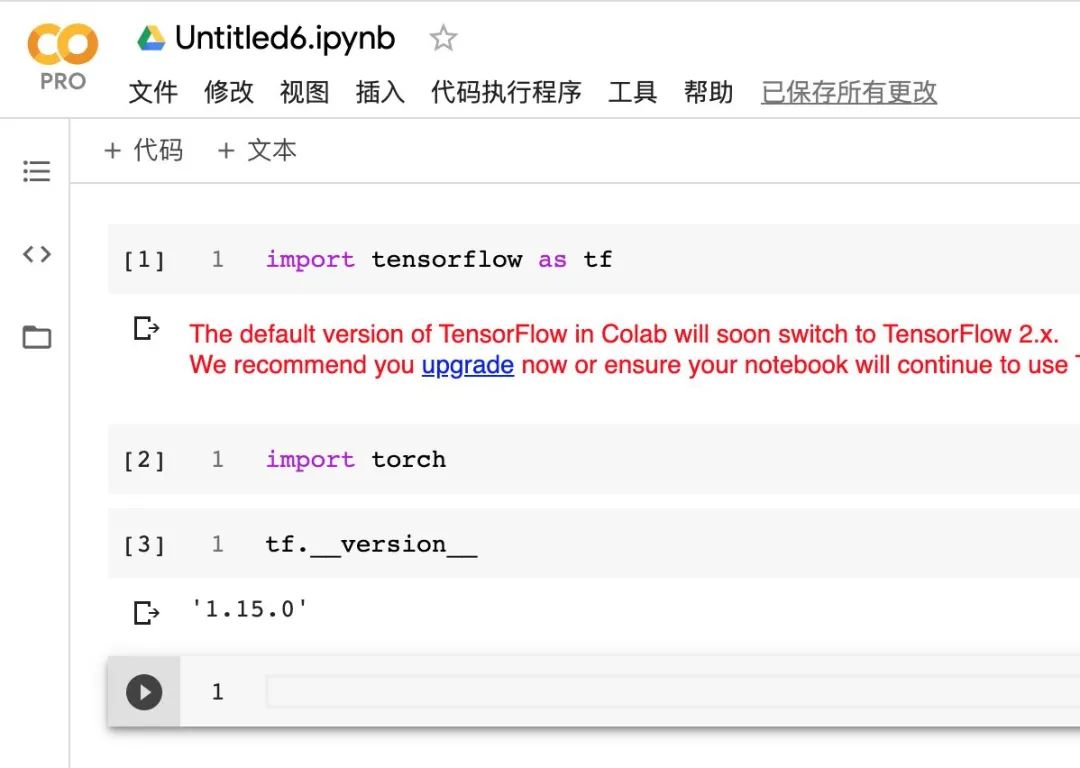

以 Quadro RTX 8000 为基准的针对Quadro RTX 8000的图像模型训练吞吐量 3) 来自知乎@Aero的「在线」GPU评测[4] https://www.zhihu.com/question/299434830/answer/1010987691 大家用的最多的可能是Google Colab,毕竟免费,甚至能选TPU

编辑:黄飞

-

相比GPU和GPP,FPGA是深度学习的未来?2016-07-28 7661

-

FPGA在深度学习应用中或将取代GPU2024-03-21 1169

-

新手小白怎么学GPU云服务器跑深度学习?2024-06-11 2364

-

深度学习框架TensorFlow&TensorFlow-GPU详解2018-12-25 4199

-

Mali GPU支持tensorflow或者caffe等深度学习模型吗2022-09-16 2998

-

什么是深度学习?使用FPGA进行深度学习的好处?2023-02-17 2028

-

深度学习方案ASIC、FPGA、GPU比较 哪种更有潜力2018-02-02 10929

-

GPU和GPP相比谁才是深度学习的未来2019-10-18 1797

-

基于深度学习的ADAS系统,是GPU的主力市场2020-08-22 2954

-

GPU 引领的深度学习2023-01-04 1188

-

GPU的张量核心: 深度学习的秘密武器2023-09-26 1734

-

GPU在深度学习中的应用与优势2023-12-06 2395

-

深度学习GPU加速效果如何2024-10-17 996

-

GPU深度学习应用案例2024-10-27 2218

-

GPU在深度学习中的应用 GPUs在图形设计中的作用2024-11-19 2305

全部0条评论

快来发表一下你的评论吧 !