TorchVision框架下模型导出并部署到ONNXRUNTIME C++全流程解析

描述

ONNXRUNTIME1.13

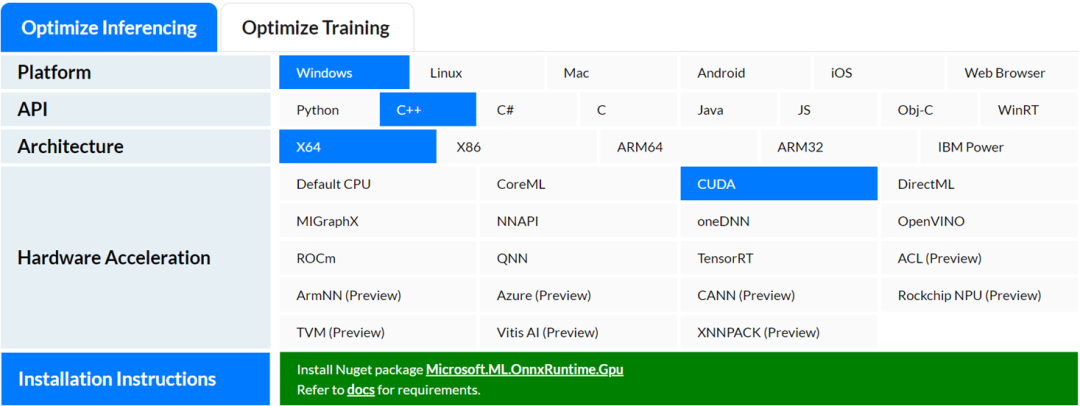

ONNXRUNTIME是主流的深度学习部署框架之一,支持ONNX格式模型在CPU、GPU、ARM等不同硬件平台上加速推理,支持C++、Python、Java、C#、JS等不同语言SDK。C++版本安装包下载如下:

不同版本的ONNXRUNTIME安装文件下载地址:

https://github.com/microsoft/onnxruntime/tags框架主页:

https://onnxruntime.ai/

推理流程与API接口

常用组件与推理流程支持:

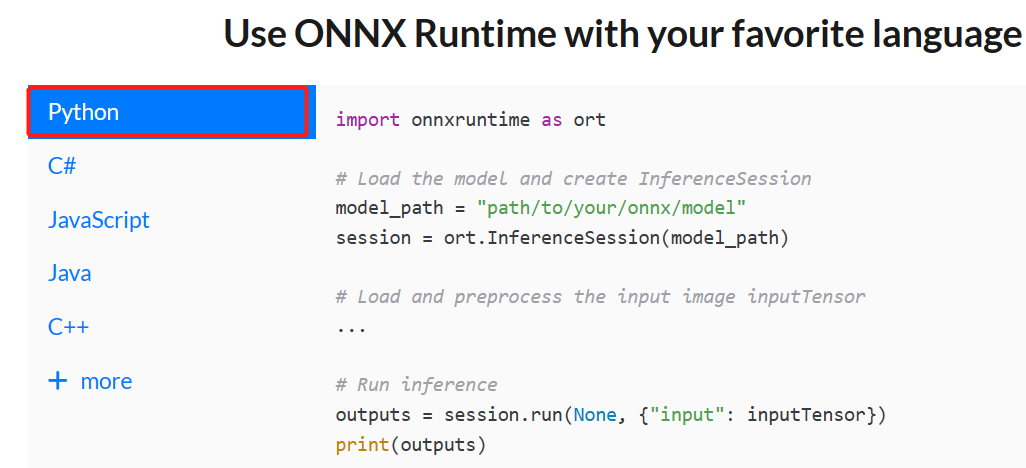

Python SDK API支持:

C++ SDK API支持:

学会用C++部署YOLOv5与YOLOv8对象检测,实例分割,姿态评估模型,TorchVision框架下支持的Faster-RCNN,RetinaNet对象检测、MaskRCNN实例分割、Deeplabv3 语义分割模型等主流深度学习模型导出ONNX与C++推理部署,轻松解决Torchvision框架下模型训练到部署落地难题。

整个视频课程通过案例代码实战驱动,手把手系统化教学,帮助大家掌握ONNXRUNTIME API2 C++开发的各种技巧,学会图像分类、对象检测、语义分割、实例分割、pytorch自定义模型部署等ONNXRUNTIME C++版本的模型推理与解析技巧。

审核编辑:汤梓红

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

如何使用OpenVINO C++ API部署FastSAM模型2023-11-17 1716

-

K230D部署模型失败的原因?2025-03-11 515

-

如何使用TensorFlow将神经网络模型部署到移动或嵌入式设备上2023-08-02 758

-

使用OpenCV+ONNXRuntime部署YOLOV7目标检测2022-07-23 11950

-

基于COCO的预训练模型mAP对应关系2022-10-10 1868

-

如何将pytorch的模型部署到c++平台上的模型流程2022-10-26 4327

-

ONNX格式模型部署兼容性框架介绍2023-06-19 6386

-

YOLOv8对象检测ONNXRUNTIME部署C++源码演示2023-07-17 11227

-

大模型部署框架FastLLM实现细节解析2023-07-27 4505

-

三种主流模型部署框架YOLOv8推理演示2023-08-06 3779

-

视觉深度学习迁移学习训练框架Torchvision介绍2023-09-22 1894

-

基于OpenVINO C++ API部署RT-DETR模型2023-11-03 2121

-

基于OpenVINO C# API部署RT-DETR模型2023-11-10 1736

-

通过新的ONNX导出器简化模型导出流程2024-01-10 2001

全部0条评论

快来发表一下你的评论吧 !