省成本还是省时间,AI计算上的GPU与ASIC之选

省成本还是省时间,AI计算上的GPU与ASIC之选

描述

电子发烧友网报道(文/周凯扬)随着AI计算逐渐蚕食通用计算的份额,数据中心的硬件市场已经开始出现了微妙的变化。最抢手的目前已经成了GPU,反观CPU、ASIC和FPGA等硬件,开始成为陪衬。但高昂的售价以及强绑定的供应关系,还是让不少企业开始探索别的出路。

仍在被疯抢的GPU

在今年第一季度AI热潮高涨下,全球已经开启了一波GPU抢购。无论是借助GPU开发各自大模型应用的互联网厂商,还是想借此发展其AI服务器业务的云服务厂商,都在抢购英伟达目前主推的A100和H100两大GPU。

就连台积电哪怕第一季度业绩下滑明显,其CEO魏哲家在法说会上也表示在AI相关的需求上观察到了增量上行,将帮助其在今年实现可观的库存消化。

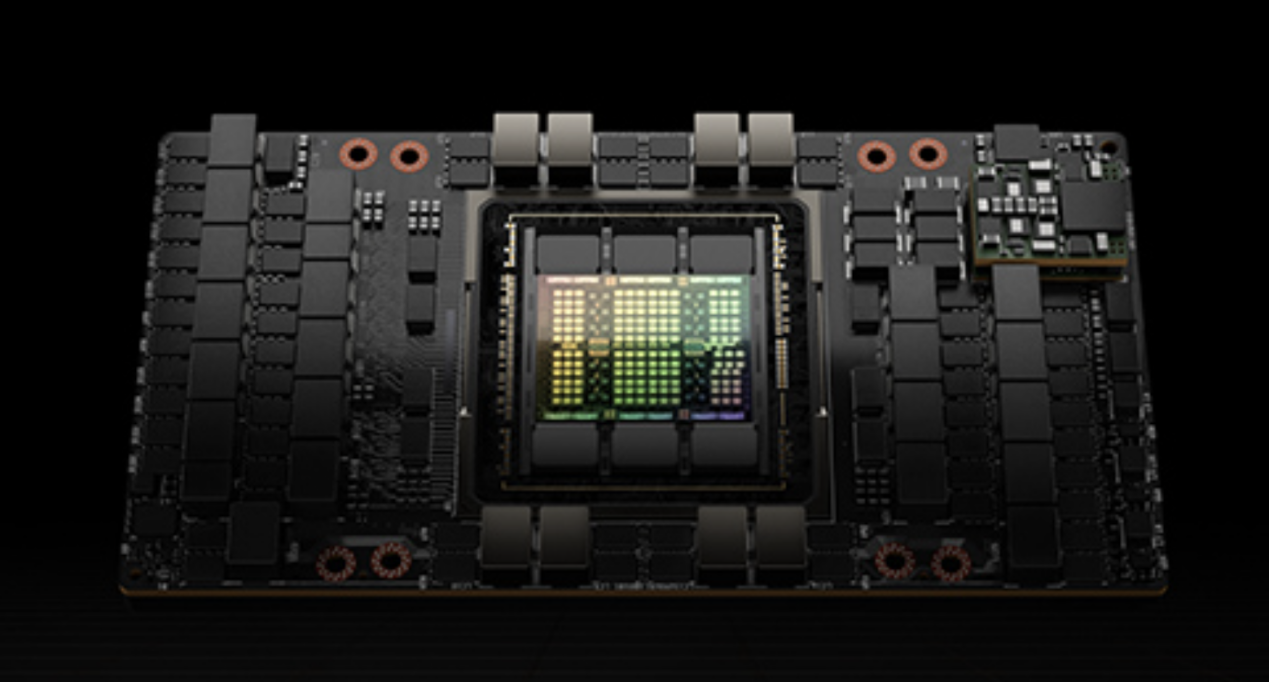

H100 GPU / 英伟达

在美国商务部半导体出口新规刚推出不久,A100在非正常渠道的单价就飙升至20000美元,是原价的两倍左右。为此英伟达仅仅面向中国市场推出了A800和H800,只不过将高速互联总线NVLink限制在了400GB/s,但好歹仍足以满足大部分AI计算的需求。

可好景不长,随着紧缺和抢购的趋势很快蔓延到了A800和H800上,据了解,国内市场的A800单价一周上涨了30%,从原来9万元上升至13万元,甚至连带使得搭载该卡的服务器现货同样涨价,颇有当年矿潮期显卡涨价整机一并涨价的趋势。

使其状况更加恶化的是,英伟达据传大量削减了A800的供应,而是转为推广更高端也更昂贵的H800,单价在25万元左右。高端的GPU无疑能够带来更高的性能,但性价比相对较低,大规模部署的成本也会更加难以承受。所以从全球市场的购买表现上来看,互联网公司和云服务厂商显然觉得A100或A800更香一点。

可为了更高的利润转化,英伟达决心调整A800和H800的供应比例的话,也就说得过去了。A100的市场流通率较高,而A800这种面世不久的特供产品,也更方便在供应上加以限制。

省时和省钱

既然GPU困人已久,为何不打破这一限制,转用大规模量产成本更低的ASIC产品呢?事实上,很多厂商早就有类似的心思,只不过执行起来却是寸步难行。首先对于大模型这样的AI应用来说,硬件性能只是一个方面,拥有优质的软件生态也很重要。

英伟达的CUDA成了任何进军AI产业的公司在软件生态上的一头拦路虎,迟迟没法突破。固然ASIC的方案可以省下不少硬件成本,但在软件上仍有不小的障碍。初创公司ASIC硬件的软件生态不成熟,巨头自研的产品又难以与第三方开发结合起来,或者说能打造出爆品应用的概率更低。

反观CUDA,发展这么多年积累的各种library已经逐渐趋于成熟,甚至在英伟达的GPU上优化到了最佳状态,开发者只需要调用API即可实现所需的效果。这堵墙就连同为GPU厂商的AMD等竞争对手都未能攻破,因为AI时代下省时才能抢占先机,省钱是之后采取考虑的事。

话虽如此,相关的尝试依旧没有停止,诸如谷歌的TPU、亚马逊的Trainium以及微软最近在研究的Chiplet Cloud等等,都是厂商们对ASIC持续看好的表现。可以看出,让互联网企业,尤其是芯片设计能力欠缺的企业,去走ASIC这条路线是很难的。而托管了诸多第三方芯片设计平台、大模型和AI计算负载的云服务厂商,有这个技术积累,也有实力组建或已组建达标的芯片设计队伍,最终做到省时又省钱。

写在最后

ASIC固然前景可观,但目前厂商们在购置GPU上花的钱多半是多于自研投入的,这也就是GPU作为通用计算硬件的future proofing性质。可能在GPT爆火的今年,这款ASIC提供了远超GPU的性能或成本优势,但未来保不齐会出现其他的爆品应用。GPU可以很快调转势头,但ASIC就可能会被淘汰。所以对这些公司来说,无论是购买A100还是A800,不仅是对现在的投资,也是对未来的投资。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

到底什么是ASIC和FPGA?2024-01-23 1584

-

群里ucos资料总结,为大家节省时间,大多都在这啦2013-09-13 20002

-

C语言多层循环怎样转换为verilog语言最省时间。2014-03-05 2345

-

ai芯片和gpu的区别2021-07-27 2660

-

USART使用DMA时可以节省时间吗?2021-12-02 1017

-

通过节省时间和成本的创新技术降 低电源中的EMI2022-01-25 4464

-

AI领域ASIC将取代GPU扮演重要角色2017-12-15 1095

-

浅析GPU、FPGA、ASIC三种主流AI芯片的区别2019-03-07 31201

-

通过节省时间和成本的创新技术降低电源中的EMI2021-06-09 911

-

自动驾驶主流架构方案对比:GPU、FPGA、ASIC2023-02-14 4645

-

自动驾驶主流芯片:GPU、FPGA、ASIC2023-03-17 2762

-

ASIC和GPU,谁才是AI计算的最优解?2023-12-03 4203

-

科技驱动未来,提升AI算力,GPU扩展正当时2024-04-16 1496

-

GPU是如何训练AI大模型的2024-12-19 1428

-

ASIC和GPU的原理和优势2025-01-06 3213

全部0条评论

快来发表一下你的评论吧 !