阔别两年,重返线下!上百位与会者齐聚“NVIDIA 专家面对面技术沙龙”,畅谈大模型最佳实践!

描述

2023 年《NVIDIA 专家面对面技术沙龙——大语言模型专场》于 7 月 30 日下午在北京顺利举行。阔别两年,首次重返线下!即便是滂沱大雨,也阻挡不了数百位与会者的热情。本次活动共汇聚了 40 余位 NVIDIA 技术专家和上百位业界人才围绕大语音模型进行全面交流和深入探讨。包含来自科研教育、汽车、金融服务、能源、消费者互联网、医疗健康、电信、云服务、制造业、农业及初创企业等各大领域的开发人员、工程师、研发经理、技术负责人等专家。NVIDIA 全球副总裁刘念宁以及 NVIDIA 中国区工程和解决方案高级总监赖俊杰博士通过现场致辞,成功为本届的技术沙龙揭开完美序幕。

刘念宁表示,“在 NVIDIA,除了过往的经验累积造就成功决策之外,更重要的是,研发团队大量创新想法的涌现以及团队之间的相互碰撞和与客户之间的相互激荡 。正如同本次的专家面对面活动,专家们不仅来自于 NVIDIA 团队,更包括来自现场在坐的各位,你们最了解前端的应用场景,双方透过互动交流,NVIDIA 才能够一步步在 AI 领域造就技术创新。”

赖俊杰表示,“NVIDIA 之所以在软硬件生态做得相对优秀,其实是因为我们很注重去听取来自不同行业客户的反馈,包括软件、硬件、应用的需求,针对这个需求,我们研发出相应的解决方案,然后再将其融入固化到产品中。透过这样的专家面对面线下的活动,我们期许这个交流是双向的,而不只是单向输出。衷心希望大家不虚此行,通过今天的交流,各位皆能有所收获。”

主论坛分享精彩回顾

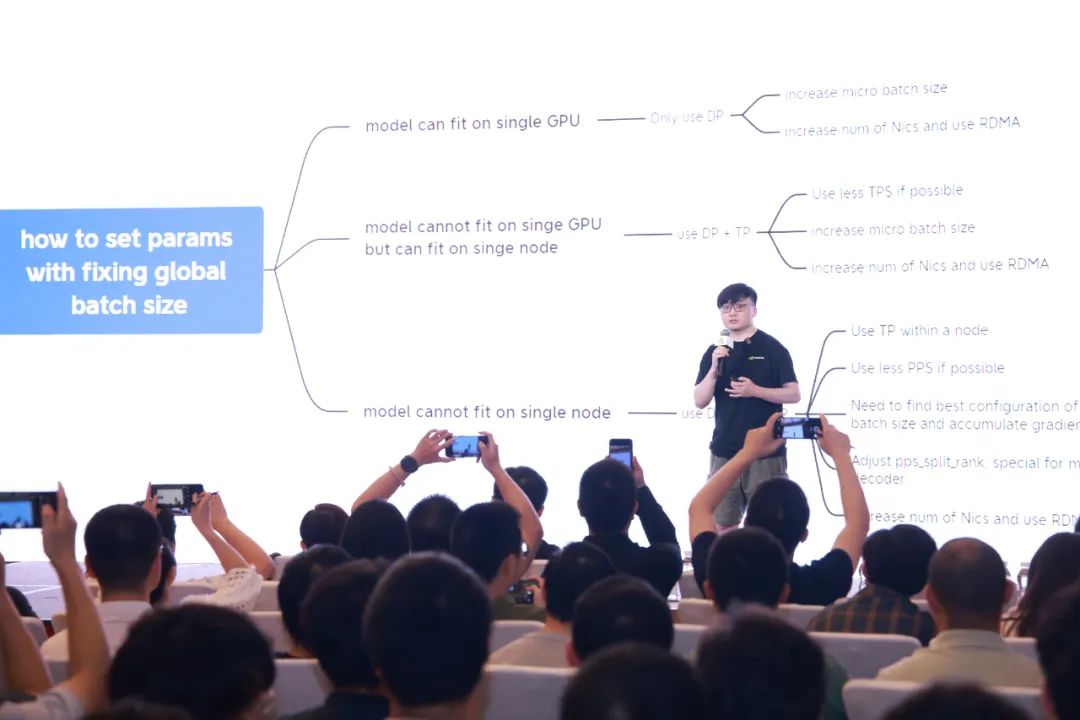

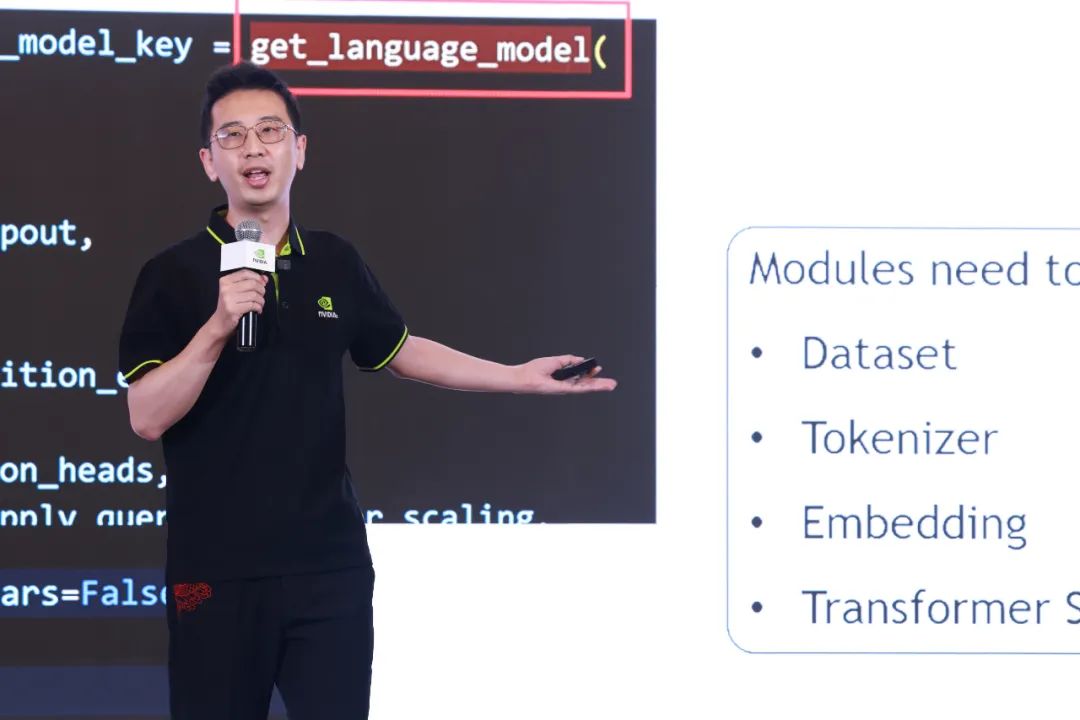

本次技术沙龙以大语言模型(LLM)为主题,NVIDIA 技术团队共分享了三大技术指南,包括从大语言模型的基础设施搭建、训练到推理,助力企业打造专属的大模型高光时刻。

-

LLM 基础设施最佳实践:如何建构稳定的大模型训练系统的方法论,训练任务生命周期拆解,如何做好集群监控、确保环境可靠和针对大模型训练集群的存储设计,以及集群参考架构的分享。

-

LLM 训练最佳实践:NVIDIA 针对大模型训练的解决方案 NeMo Framework 概要,如何做数据治理、超参搜寻、分布式训练加速、FP8 混合精度训练以及 RLHF 的最佳实践,NeMo Framework 对社区模型和自定义模型的支持进展和方法。

-

LLM 推理最佳实践:剖析 LLM 生成阶段之加速技术 K/V Cache、Self-Attention 推理加速技术实测、LLM 推理服务部署优化技术实践,以及如何进行大模型低精度推理的最佳实践。

左右滑动查看主论坛活动照片

深度交流,共话 LLM 挑战与创新进展

除了主论坛分享,我们也安排了“分论坛技术话题及技术演示”的交流环节,让来自行业的技术伙伴们能与 NVIDIA 专家面对面探讨 LLM 的最新趋势及应用挑战。专家亲自剖析构建及训练 LLM 的实例,分享相关实战经验及 LLM 对行业未来发展。包括大模型训练集群监控实践及演示、常见集群稳定性问题详解及解决方案、NeMo Framework RLHF 设计解读及实践、NVIDIA 多模态训练方案解读、如何评估大模型训练计算热点、低精度推理管线详解及演示、如何在 NVIDIA 大模型推理产品中新增模型、基于 NeMo LLM Service 定制化开发企业级 AI 应用,以及如何通过 NeMo-Guardrails 让大语言模型的使用合法合规等丰富内容。

左右滑动查看分论坛活动照片

AI 之路,NVIDIA 从未止步

从首届举办到现在,我们定制了不同主题的专场,无论线下或线上,NVIDIA 中国团队通过“专家面对面技术沙龙”已累计与千余名各界的技术专家交流互动。未来,我们将持续举办技术沙龙,引导更多的行业人才在科技创新之路,精准实践专业技能,一同聚焦 AI 发展,通过近距离交流及答疑,加速解决跨行业痛点。

再次感谢所有与会者的热情支持,

让本次活动圆满成功。

NVIDIA 期待与您下一次相见!

点击 “阅读原文”,或扫描下方海报二维码,在 8 月 8 日聆听 NVIDIA 创始人兼 CEO 黄仁勋在 SIGGRAPH 现场发表的 NVIDIA 主题演讲,了解 NVIDIA 的新技术,包括屡获殊荣的研究,OpenUSD 开发,以及最新的 AI 内容创作解决方案。

原文标题:阔别两年,重返线下!上百位与会者齐聚“NVIDIA 专家面对面技术沙龙”,畅谈大模型最佳实践!

文章出处:【微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

- 相关推荐

- 热点推荐

- 英伟达

-

"鸿蒙生态专家面对面"三月专场等你前来!2023-03-17 629

-

2022 OpenHarmony主题线下技术沙龙(线下 Meetup 分享)来啦!2022-10-20 23131

-

专家面对面哈尔滨站:开场花絮2019-08-12 2280

-

华强集团采购面对面—LED中山古镇专场2014-03-21 2425

-

IIC-China专家论坛:热点大聚焦,观点面对面2010-02-23 1255

全部0条评论

快来发表一下你的评论吧 !