英伟达A100和V100参数对比

电子说

1.4w人已加入

描述

英伟达A100这个AI芯片怎么样?英伟达A100是一款基于英伟达Ampere架构的高性能计算卡,主要面向数据中心和高性能计算领域。其拥有高达6912个CUDA核心和432个Turing Tensor核心,可以实现高达19.5 TFLOPS的FP32浮点性能和156 TFLOPS的深度学习性能。此外,它还支持NVIDIA GPU Boost技术和32GB HBM2显存,能够提供卓越的计算性能和内存宽带。英伟达A100还配备了英伟达的第三代NVLink互连技术和第二代NVSwitch交换机,可以实现高带宽、低延迟的GPU-GPU通信,提升集群中的计算效率。

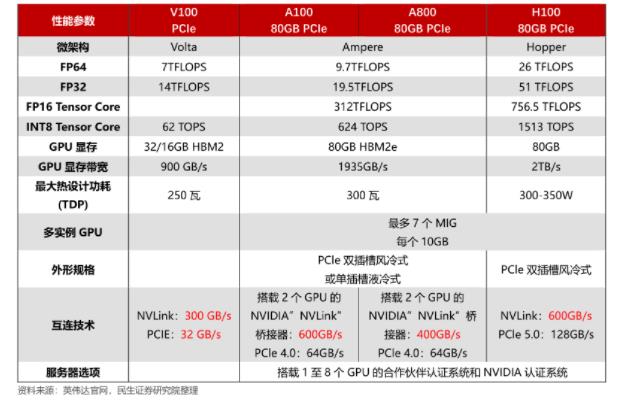

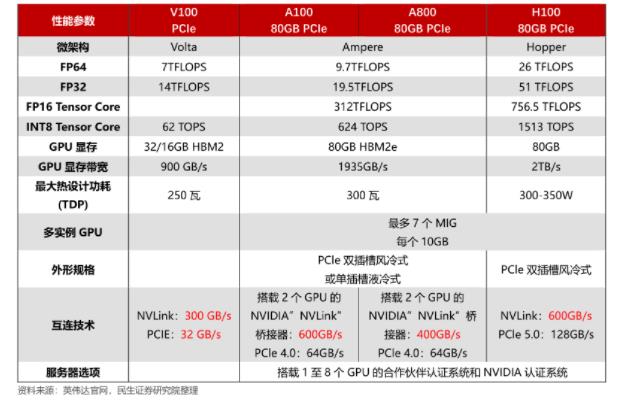

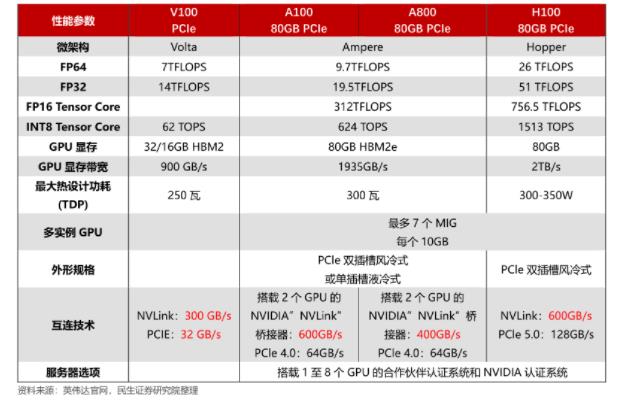

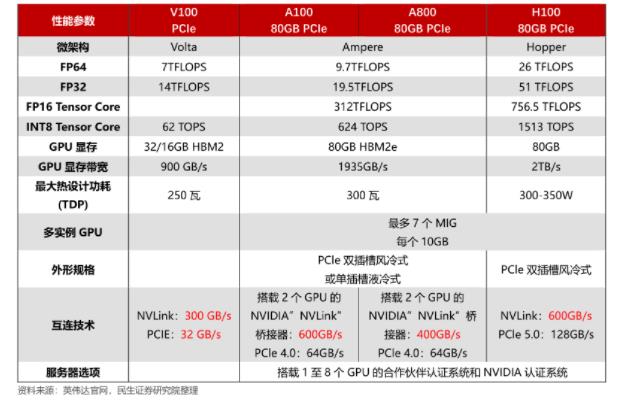

英伟达A100和V100参数对比

以下是英伟达A100和V100的主要参数对比:

| 参数 | 英伟达 A100 | 英伟达 V100 |

| 架构 | Ampere | Volta |

| 制程 | 7 纳米 | 12 纳米 |

| CUDA 核心数 | 6912 | 5120 |

| Tensor 核心数 | 432 | 640 |

| RTX 加速器数 | 112 | 0 |

| Boost 时钟频率 | 1.41 GHz | 1.38 GHz |

| FP32 性能 | 19.5 TFLOPS | 15.7 TFLOPS |

| FP64 性能 | 9.7 TFLOPS | 7.8 TFLOPS |

| Tensor 性能 | 624.6 TFLOPS | 125 TFLOPS |

| 内存容量 | 40 GB HBM2 | 16 GB HBM2 |

| 内存带宽 | 1.6 TB/s | 900 GB/s |

| TDP | 400 W | 300 W |

| 支持的 PCIe 版本 | PCIe 4.0 | PCIe 3.0 |

| 相关软件支持 | CUDA, cuDNN, TensorRT, NCCL, NVLink, NVSwitch, Docker, Kubernetes | CUDA, cuDNN, TensorRT, NCCL, NVLink, Docker, Kubernetes |

,英伟达 A100 在架构、制程和性能上都有显著的提升,同时内存容量和带宽也大幅提高。另外,A100 支持 RTX 加速器,可以实现实时光线追踪渲染等功能,而 V100 则不支持。不过,A100 的功耗也相应增加,需要更好的散热解决方案。

适用领域 | AI、机器学习、高性能计算 | 虚拟桌面、虚拟应用、多媒体等。

打开APP阅读更多精彩内容

英伟达A100和V100参数对比

以下是英伟达A100和V100的主要参数对比:

| 参数 | 英伟达 A100 | 英伟达 V100 |

| 架构 | Ampere | Volta |

| 制程 | 7 纳米 | 12 纳米 |

| CUDA 核心数 | 6912 | 5120 |

| Tensor 核心数 | 432 | 640 |

| RTX 加速器数 | 112 | 0 |

| Boost 时钟频率 | 1.41 GHz | 1.38 GHz |

| FP32 性能 | 19.5 TFLOPS | 15.7 TFLOPS |

| FP64 性能 | 9.7 TFLOPS | 7.8 TFLOPS |

| Tensor 性能 | 624.6 TFLOPS | 125 TFLOPS |

| 内存容量 | 40 GB HBM2 | 16 GB HBM2 |

| 内存带宽 | 1.6 TB/s | 900 GB/s |

| TDP | 400 W | 300 W |

| 支持的 PCIe 版本 | PCIe 4.0 | PCIe 3.0 |

| 相关软件支持 | CUDA, cuDNN, TensorRT, NCCL, NVLink, NVSwitch, Docker, Kubernetes | CUDA, cuDNN, TensorRT, NCCL, NVLink, Docker, Kubernetes |

,英伟达 A100 在架构、制程和性能上都有显著的提升,同时内存容量和带宽也大幅提高。另外,A100 支持 RTX 加速器,可以实现实时光线追踪渲染等功能,而 V100 则不支持。不过,A100 的功耗也相应增加,需要更好的散热解决方案。

适用领域 | AI、机器学习、高性能计算 | 虚拟桌面、虚拟应用、多媒体等。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

英伟达H200和A100的差异2024-03-07 6057

-

英伟达v100与A100的差距有哪些?2023-08-22 27034

-

英伟达a100和h100哪个强?英伟达A100和H100的区别2023-08-09 51303

-

英伟达A100和4090的区别2023-08-08 32849

-

英伟达a100和h100哪个强?2023-08-07 17577

-

通往AGI之路:揭秘英伟达A100、A800、H800、V100在高性能计算与大模型训练中的霸主地位2023-06-29 30796

全部0条评论

快来发表一下你的评论吧 !