人工智能的历史与发展

人工智能

描述

来源:混沌巡洋舰

作者:人工智能学家

为什么说人脸识别是一种明知识?

促使人们意识到暗知识和人工智能的关系的,首先是有学习能力的神经网络在扩大科学经验方面的运用,它明确无误地把暗知识和某一种装置对应起来。也许,人脸识别是最简单的例子。自古以来,人脸识别是(科学)经验知识,而且是一种明晰的经验知识。为什么说人脸识别是一种(科学)经验的明知识?所谓人脸识别实为主体看到某一图像,即可根据该图像把某人从人群(或记忆)中找出来。这里,看到图像为获得可靠信息,它是一个普遍可重复的受控观察。把某人从人群(或记忆)中找出为完成某种选择(控制),其为主体对可控制变量的控制。人脸识别作为科学的经验知识,实为获得信息和实现某种控制之间的确定联系。通常,主体是知晓识别过程的(这种联系如何建立),即它属于科学经验知识中的明知识。当人脸识别可用其他方式做到,即用一个有学习能力的人造神经网络来识别人脸时,主体并不知道神经网络是如何做到的,人脸识别也就成为暗知识。

今天,人脸识别装置已在社会生活中得到广泛运用。人脸识别是主体基于经验的一种能力,当这种能力用某种机器实现时,该机器就是有智能的。我们已经看到,当某一种暗知识是用某一种人造装置获得时,该装置一定对应着一种获得相应知识的智能。在很多人心目中,和人脸识别这种近于本能的简单能力相比,下棋才真正体现出主体拥有的高级智能。然而,只要我们去分析下棋过程,就会发现它同样是主体获得(科学)经验知识,只是获得经验知识的过程较为复杂而已!因为和人脸识别一样,下棋同样是主体根据获得的信息(棋局)来实现某种控制(下一步选择)。如果说人脸识别是信息和控制之间的一次性对应,下棋经验就是主体获得信息和实行控制之间对应关系构成的序列。每一次,主体根据棋局的信息做一次选择,改变了棋局,然后根据对手改变的棋局再次选择。这由一次次选择构成的序列有自己的明确目标,那就是下棋每一步的结果规定的最后结果。

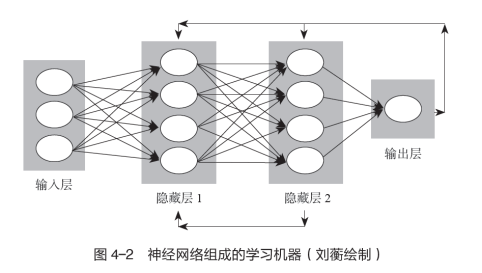

既然下棋的知识实为每一次获得信息后如何进行选择,那么每一次获得信息规定选择什么,是一种(科学)经验知识,它和人脸识别一样,是可以通过一个人造神经网络的学习训练实现的。由于选择序列冗长,两次选择互相依赖,下棋的输赢取决于该序列最后的结果,这一切使人造神经网络的结构和学习训练方式比人脸识别复杂得多。但无论人造神经网络的结构和学习训练多么复杂,其整体上仍是图4-2所示的学习机器。因此,在神经网络组成的学习机器学会下棋后,主体如何下棋亦成为暗知识。和这种暗知识直接对应的是下棋的能力,由此我们可以理解为什么神经网络组成的学习机器战胜世界围棋冠军那么重要了,因为这是人工智能登上历史舞台的象征。

2016年3月9日举行了神经网络学习机器AlphaGo(阿尔法围棋)和世界围棋冠军、职业九段棋手李世石的公开比赛。只要有过下围棋的经验,就知道这种经验知识有多复杂,掌握它无疑需要相当高的智能。AlphaGo具有应付千变万化的围棋棋局的智能吗?人们是持怀疑态度的。但这场比赛的结果是AlphaGo以4∶1取胜,这是有史以来第一次世界围棋冠军输给了神经网络学习机器。这场比赛不仅意味着神经网络学习机器战胜人,而且意味着人无法理解AlphaGo如何下棋。机器的下棋方式是名副其实的暗知识。暗知识和智能的关系终于被世人意识到了。事实不正是如此吗?暗知识这个观念正是王维嘉为了说明神经网络机器是如何用一种和人类获得经验知识完全不同的方式时提出的。从此以后,科学界普遍认识到,只要主体明确要获得的经验知识是什么,都可以用神经网络学习机器来取代人,即神经网络学习机器可以运用到获得科学经验知识的任何一个领域。

地图四色定理证明中的争议

早在20世纪40年代神经网络学习机器的数学模型刚提出时,它已经被证明是有限自动机,并和图灵机等价,即它既可以用来表达电脉冲输入与输出互动中的学习,亦可用来计算和逻辑推理。因此,对科学知识的另一种类型——数学知识,只要用公理推出定理必须通过某种计算机装置,就证明其中也存在暗知识。图灵机就是通用电子计算器,通用电子计算器(冯·诺依曼机)的发明比神经网络学习机器早,故在科学经验知识中发现暗知识之前,人类已经知道数学中存在着暗知识。地图四色定理的证明是典型的例子。

地图四色定理由一个英国业余数学家弗朗西斯·格斯里在1852年提出,它是指任何一张地图只用四种颜色就能使具有共同边界的国家着上不同的颜色。地图即平面图,它由图论的一组公理给出。这样,证明地图四色定理就是将其用平面图的公理推出。证明这一猜想极为困难。1878年英国数学家阿尔弗雷德·肯普发现,如果地图至少需要五色,则一定存在一种正规五色地图。接着他证明:如果有一张正规的五色地图,就会存在一张国数最少的极小正规五色地图;如果极小正规五色地图中有一个国家的邻国数少于六个,就会存在一张国数比其还要少的正规五色地图,这样就不会有国数极小的五色地图,也就不存在正规五色地图了。通过归谬法,肯普认为他已经证明了地图四色定理。但若干年后,英国数学家约翰·赫伍德发现了肯普的证明存在漏洞。

肯普的证明虽被否定,但他提出的两个概念对解决四色问题提供了方法。第一个概念是构形。肯普证明在每一张正规地图中至少有一国具有两个、三个、四个或五个邻国,不存在每个国家都有六个或更多个邻国的正规地图。另一个概念是可约性,即只要五色地图中有一国具有四个或五个邻国,就会有国数减少的五色地图。自从引入构形和可约的概念后,数学家逐步发展出一套检查构形是否可约的标准方法。研究者发现,解决四色问题要证明构形可约,需要检查大量的细节。1950年德国数学家海因里希·黑施通过不断试验指出,用构形化约证明四色定理,涉及的构形有一万多种。要对如此多的构形逐一证明,工作量极为巨大,这非人力所能完成。正因如此,人们一度认为地图四色定理是无法证明的。

1975年愚人节,美国数学家、数学科普作家马丁·加德纳在《科学美国人》上发布了一张地图,声称四色猜想被否定,因为这张地图需要至少五种颜色才能完成上色。当然,这只是一个玩笑。然而,人们万万没有想到,就在几个月以后,美国伊利诺伊大学的数学家沃夫冈·黑肯对黑施的方法做了改进,他与美国数学家肯尼斯·阿佩尔合作设计了一个计算机程序,在计算机专家科克的参与下,终于在1976年1月6日证明了四色猜想。他们是利用穷举检验法检查了1482种构形,一个又一个地证明它们都是可约的,即没有一张需要五色。该工作是在两台IBM360计算器上各做了100亿个判断实现,计算机运行达1200多个小时,两台计算机得到一样的结果。用计算机证明四色定理引起了轰动,但也带来了巨大的争议。

黑肯等人设计的构形化约程序当然是正确的,但化约和相应判断是运用两台计算机分别做出的,鉴别其可靠与否的方法是看两台计算机得到的结果是否一致。这种做法有点像工程技术和物理学鉴定。这里,证明计算机工作是否可靠,就和判别用电子显微镜观察对象所获得的信息是否可靠一模一样。美国数学家威廉·瑟斯顿曾评论说:“一个可以运作的计算机程序,其正确性和完备性标准比起数学界关于可靠的证明的标准,要高出几个数量级。”但是,没有人全面验证过四色猜想证明的每一步,原因是人力不可能做到。正因如此,很多数学家不认可上述证明,苏格兰数学家弗兰克·波塞尔指出,这种证明根本不属于数学。

我认为,可以从两个方面来梳理地图四色定理证明中的争议。一是有些人不知道数学知识中也有暗知识。地图四色问题的证明,属于抽象代数中纯图论的领域。图论定理由相应的基本公理规定。规定这些公理时,已给出相应符号系统的所有可靠信息,证明定理只是把公理注入的信息找出来。主体获得公理注入的可靠信息和主体经历每一步信息的获得过程,原则上亦可分离。数学知识中存在暗知识是没有疑义的。然而,在人类所具有的数学知识中,暗知识占的比例很小,数学家还不习惯数学知识中的暗知识。然而,我要问:为什么一定存在着一个不同于现在已给出四色问题证明的非穷举式证明呢?数学家迟早会意识到必须接受数学知识中亦存在暗知识。

此外,数学家不承认地图四色问题被证明还有一个原因,那就是拒绝这种证明体现了人的数学能力。爱因斯坦做过一个比喻:纯数学是逻辑思想的诗歌,但四色定理的确证依靠的是计算机对人不能处理的个案之穷举,它犹如一本电话簿。数学家很难想象如查电话簿般的、用计算机的快速穷举是一种数学智能。正因如此,至今这个领域的研究被称为机器证明,而非人工智能。但是,任何一种暗知识都对应着一种智能,我们能否定这种帮助数学家获得暗知识的装置是人工智能吗?答案是没有疑义的。纯数学是普遍可重复的受控实验无限扩张的符号表达,主体在研究纯符号系统的结构时,任何一种处理符号系统的能力当然也是智能。因此,在数学领域,由于计算机的运用,用人工智能获得暗知识比在经验领域要早,只是因为其稀少,没有被意识到罢了。

人工智能的历史

其实,只要去追溯人工智能的历史,就知道人工智能正是在利用电子计算机处理符号结构时提出的。早在1956年,数十名来自数学、心理学、神经科学、计算机科学与电气工程学领域的学者聚集在一起,讨论如何用计算机来处理符号结构,会上美国计算机科学家约翰·麦卡锡将这种研究命名为人工智能;同样作为计算机科学家的艾伦·纽厄尔和司马贺把一种被称为“逻辑理论家”的程序带到会议上,他们被会议发起人称为“人工智能之父”。纵观这些被称为人工智能的研究,无一不是发明一种处理信息(符号系统或数字)的装置,用其来整理和提取解决问题的知识。无论是逻辑理论家,还是1959年司马贺、纽厄尔和软件工程师约翰·肖公布的通用问题求解系统,都是如此。这种装置和前文讲过的两类装置(具有学习能力的神经网络和进行数学定理证明的计算机)的不同之处在于,前者处理的不是纯科学经验知识,亦不是纯数学知识,而是科学理论知识。正因为人工智能一开始就被界定为如何用一种装置实现运用科学理论知识解决实际问题,或通过经验提出科学理论,其被广泛地称为专家系统。

举个例子。1964年美国人工智能学家爱德华·费根鲍姆、分子生物学家乔舒亚·莱德伯格和化学家卡尔·杰拉西用某种装置处理火星上采集来的数据,看火星上有无可能存在生命。三人合作的结果就是第一个专家系统DENDRAL的诞生。DENDRAL输入的是质谱仪的数据,输出的是给定物质的化学结构。另一个例子是1978—1983年司马贺和计算机科学家帕特·兰利、盖里·布拉茨霍夫陆续发布了6个版本的BACON系统发现程序,该装置重新发现了一系列著名的物理、化学定律。纵观各式各样的专家系统,它们都是在创造一种装置,以获得科学理论知识的信息。专家系统有时是用科学理论推出经验知识,解决碰到的实际问题;有时是根据受控实验信息提出科学理论,或修改现有的科学理论知识。这些工作本来都是由人完成的,而专家系统是一种人造装置,用它来取代人做的事情。

我要问一个问题:这些专家系统获得的可靠信息中有暗知识吗?根据暗知识的定义,我们知道最后得到的可靠信息是什么,但不知道该信息是如何获得的。今日所有已知的专家系统都没有这样的智能。专家系统之所以做不到这一点,是因为它们不能如人工神经网络那样自行学习,也不能如机器证明那样完全不需要人的干预自行进行逻辑判断。如前所述,科学理论知识的进步依靠的是科学理论信息和经验信息的互动,它包括当从科学理论推出之受控实验信息不包含相应科学经验的受控实验信息时,规定两者哪一个必须修改,即两者如何互动。只有互动过程形成完全的闭环(没有主体参与),其才能完全通过人工装置来实现。这时,主体通过该装置得到科学理论的信息,但不知道该信息是如何得到的。这才是科学理论中的暗知识。

目前,这种装置正在孕育之中,美国人工智能研究实验室OpenAI推出的一款大型预训练人工智能语言模型ChatGPT也许是一个例子。为什么?科学理论作为横跨受控实验和数学世界的拱桥,由拱圈和上盖组成。上盖是用逻辑语言表达的受控实验和受控观察,即目前文献中记录的科学知识。拱圈是建立在测量之上用数量表达的受控实验(观察)结果之间的关系,它是作为各门科学基础的定律。ChatGPT利用自然语言的语法研究把自然语言陈述转化为逻辑语言陈述,然后自动把这些逻辑语言陈述中所蕴含的信息提取出来。当人通过ChatGPT得到了新的科学理论知识,但不知道该新知识是如何得到的时,科学理论知识满足暗知识的定义。对于拱圈,亦可以建立电脑控制的受控实验和受控观察,获得测量数据和实现控制都不需要主体直接参与。这时,研究者也不知道得到的新定律是如何得到的。这也是科学理论的暗知识。

更重要的是,上盖是建立在拱圈之上的。只要将从陈述中得到新信息和电脑自行做实验结合,我们将发现,在科学理论中,暗知识的增长将超过明知识。在今日迅速发展的合成生物学中,正在酝酿着两者结合的可能性。这意味着人工智能第三种形态(获得科学理论知识中的暗知识的装置)也许最先在生命科学中被使用,其背后是物理、化学、数学、信息理论与生命科学理论深度交叉,形成基因合成、基因编辑、蛋白质设计、细胞设计、实验自动化的使能技术。其中,生命铸造厂(biofoundry)或许是典型的例子。然而,在被称为大设施的生命铸造厂的建造和调试中,有中国研究者却以“造物致知”作为口号。该口号沿用了中国传统的“格物致知”,大设施的建造者或许没有想到,只要合成生物学中有关设施实现了科学理论知识修改的闭环,科学理论知识中的暗知识就会产生。这种“致知”和我们熟悉的获得知识不尽相同。通过造物大设施的运作,合成生物会源源不断地被制造出来,但这一切不一定导致今日所知的那种生命科学理论知识的增长,因为它们中的相当一部分可能都是暗知识。

人类发现科学理论中存在大量暗知识,标志着自然现象因果解释的一场革命。我们知道自然现象服从因果律,但能体验因果律认识过程的只是知晓因果律的极小一部分。即便如此,也并不妨碍人类用因果性改造世界,因为就算大多数因果律是暗知识,我们仍可以通过人工智能来驾驭它们。

审核编辑:汤梓红

-

《移动终端人工智能技术与应用开发》人工智能的发展与AI技术的进步2023-02-17 2201

-

嵌入式与人工智能关系是什么2021-10-27 3295

-

中国人工智能的现状与未来2021-07-27 6573

-

一文分析人工智能恐惧现象2021-01-26 2870

-

人工智能语音芯片行业的发展趋势如何?2019-09-11 5088

-

人工智能后续以什么形式发展?2019-08-12 2523

-

“洗牌”当前 人工智能企业如何延续热度?2018-11-07 3105

-

人工智能将助力智能家居产业发展2018-04-19 4267

-

人工智能就业前景2018-03-29 8274

-

选择人工智能才是企业持续发展的坚实基础2018-03-13 5008

-

数据对人工智能发展的重要性2017-10-09 5462

-

人工智能发展的好与坏2017-06-24 7440

-

百度人工智能大神离职,人工智能的出路在哪?2017-03-23 7652

-

人工智能是什么?2015-09-16 6272

全部0条评论

快来发表一下你的评论吧 !