yolov5和YOLOX正负样本分配策略

编程语言及工具

描述

导读

整体上在正负样本分配中,yolov7的策略算是yolov5和YOLOX的结合。因此本文先从yolov5和YOLOX正负样本分配策略分析入手,后引入到YOLOv7的解析中。

整体上在正负样本分配中,yolov7的策略算是yolov5和YOLOX的结合。

首先大概回顾一下yolov5和YOLOX正负样本分配。

由于笔者能力有限,文章中可能出现一些错误,欢迎大家指出。

一、yolov5正负样本分配策略

在我之前的文章中有详细介绍:

步骤:

步骤①:anchors和gt匹配,看哪些gt是当前特征图的正样本

步骤②:将当前特征图的正样本分配给对应的grid

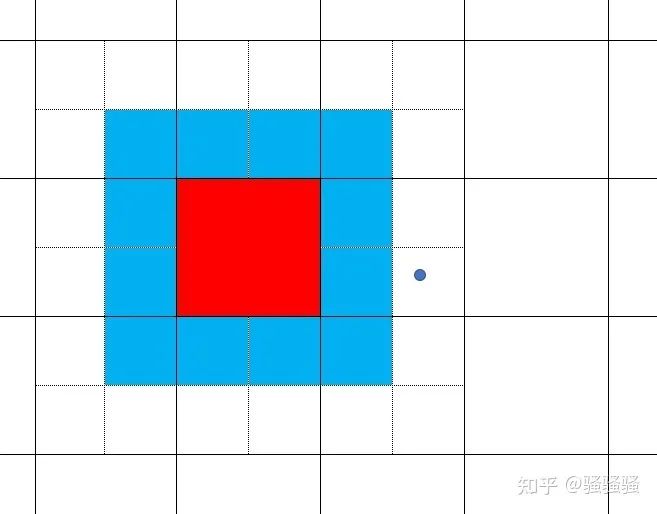

图1:实线网格代表特征图。虚线代表将一个特征点grid分为四个象限。蓝色点代表gt的中心点所处位置。

那么其特点是:

①anchor base。

②一个gt可能会和多个anchor进行匹配。

③某个anchor与gt匹配上,都会在当前anchor上有3个正样本。(理论上如果有9个anchor,那么一个gt至多可能生成9*3=27个正样本)

二、YOLOX正负样本分配策略

在我之前的文章中有详细介绍:

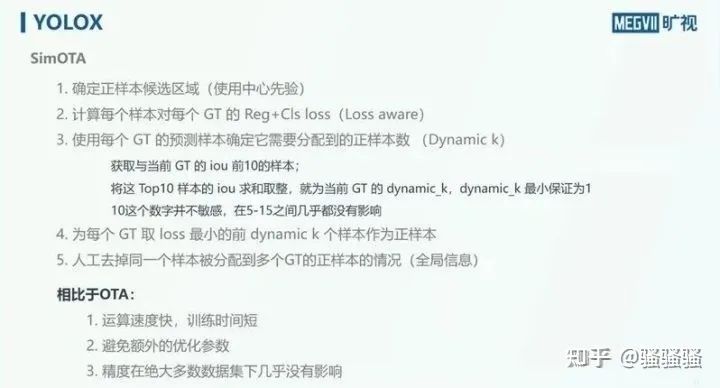

图2:源自旷视公众号

那么其特点是:

①anchor free。

②simOTA能够做到自动的分析每个gt要拥有多少个正样本。

③能自动决定每个gt要从哪个特征图来检测。

三、yolov7正负样本分配策略

首先,yolov7也仍然是anchor base的目标检测算法,yolov7将yolov5和YOLOX中的正负样本分配策略进行结合,流程如下:

①yolov5:使用yolov5正负样本分配策略分配正样本。

②YOLOX: 计算每个样本对每个GT的Reg+Cla loss(Loss aware)

③YOLOX: 使用每个GT的预测样本确定它需要分配到的正样本数(Dynamic k)

④YOLOX: 为每个GT取loss最小的前dynamic k个样本作为正样本

⑤YOLOX: 人工去掉同一个样本被分配到多个GT的正样本的情况(全局信息)

其实主要是将simOTA中的第一步“使用中心先验”替换成“yolov5中的策略”。

代码中也大量的复用了yolov5和YOLOX中的源码。

个人感觉,yolov5策略与YOLOX中simOTA策略的融合,相较于只使用yolov5策略,加入了loss aware,利用当前模型的表现,能够再进行一次精筛。而融合策略相较于只使用YOLOX中simOTA,能够提供更精确的先验知识。

yolov6等工作中也都使用了simOTA作为分配策略,可见simOTA确实是能带来很大提升的策略。

四、yolov7中AUX HEAD

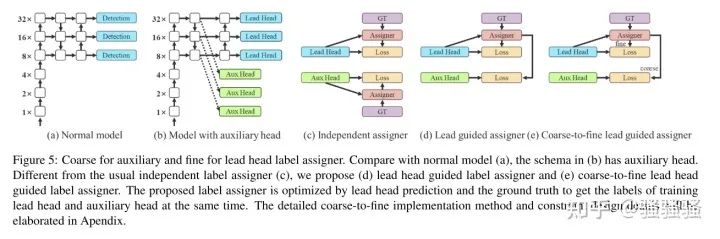

图3:yolov7论文中对于aux head的介绍

yolov7中的p6 model中都使用了aux head。

论文中提到使用aux head与lead head共同进行模型优化,而aux head的标签是较为“粗糙的“。

通过查看源码,发现aux head的assigner和lead head的assigner仅存在很少的不同,包括:

①lead head中每个anchor与gt如果匹配上,分配3个正样本,而aux head分配5个。

②lead head中将top10个样本iou求和取整,而aux head中取top20。

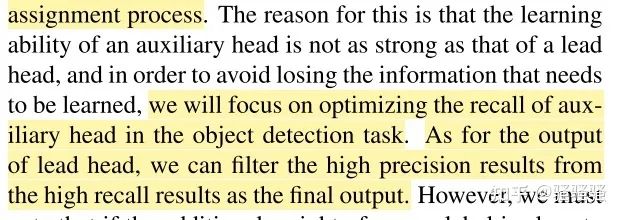

这也印证了论文中的观点。aux head不那么strong,aux head更关注于recall,而lead head从aux head中精准筛选出样本。

图4:yolov7论文中对于aux head的介绍

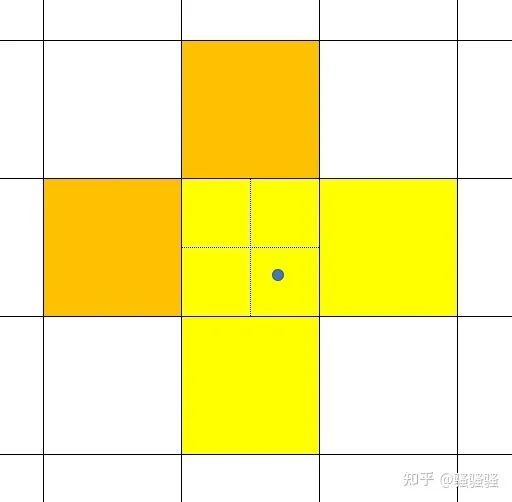

按照yolov7中的这个正负样本分配方式,那么针对图5中,蓝色点代表着gt所处的位置,实线组成的网格代表着特征图grid,虚线代表着一个grid分成了4个象限以进行正负样本分配(不理解的需要去看下yolov5的assign方式)。

如果一个gt位于蓝点位置,那么在lead head中,黄色grid将成为正样本。在aux head中,黄色+橙色grid将成为正样本。

图5:训练时,lead head和aux head中正样本分配图示(蓝色点代表着gt所处的位置,实线组成的网格代表着特征图grid,虚线代表着一个grid分成了4个象限以进行正负样本分配。如果一个gt位于蓝点位置,那么在lead head中,黄色grid将成为正样本。在aux head中,黄色+橙色grid将成为正样本)

而在推理时,下图6中,蓝色点代表着gt所处的位置,实线组成的网格代表着特征图grid,虚线代表着一个grid分成了4个象限,而依照yolov5中的中心点回归方式,仅能将图中红色特征grid,预测在图中红色+蓝色区域,是根本无法将中心点预测到gt处的!而该红色特征grid在训练时是会作为正样本的。

在aux head中,模型也并没有针对这种情况对回归方式作出更改。所以其实在aux head中,即使被分配为正样本的区域,经过不断的学习,可能仍然无法完全拟合至效果特别好。

图6:推理时,红色grid可推理出的cx、cy范围(蓝色点代表着gt所处的位置,实线组成的网格代表着特征图grid,虚线代表着一个grid分成了4个象限)

而在loss融合方面,aux head loss 和lead head loss 按照0.25:1的比例进行融合。

编辑:黄飞

-

【YOLOv5】LabVIEW+YOLOv5快速实现实时物体识别(Object Detection)含源码2023-03-13 3141

-

Yolov5算法解读2023-05-17 13853

-

【YOLOv5】LabVIEW+TensorRT的yolov5部署实战(含源码)2023-08-21 2081

-

龙哥手把手教你学视觉-深度学习YOLOV5篇2021-09-03 7934

-

怎样使用PyTorch Hub去加载YOLOv5模型2022-07-22 3434

-

如何YOLOv5测试代码?2023-05-18 567

-

YOLOX目标检测模型的推理部署2022-04-16 5112

-

YOLOv5在OpenCV上的推理程序2022-11-02 3135

-

YOLOv5 7.0版本下载与运行测试2022-11-30 5931

-

在C++中使用OpenVINO工具包部署YOLOv5模型2023-02-15 11122

-

使用旭日X3派的BPU部署Yolov52023-04-26 1698

-

YOLOv8+OpenCV实现DM码定位检测与解析2023-08-10 2196

-

YOLOv5网络结构训练策略详解2023-09-11 5726

-

yolov5训练部署全链路教程2025-07-25 1452

-

基于瑞芯微RK3576的 yolov5训练部署教程2025-09-11 2493

全部0条评论

快来发表一下你的评论吧 !