自动驾驶中道路异常检测的方法解析

汽车电子

描述

Residual Pattern Learning: 在不影响模型闭集表现的情况下分割异常物体

Out-of-Distribution (OoD) Segmentation 是在原有的闭集分割器的基础上, 让模型进一步拥有识别异常物体的能力。现在的SOTA的方法都是基于重新fine-tuning/retraining整个闭集Segmentation网络, 这样会导致对原本inlier object的性能下降。同时, 大多数OoD的办法很难对多个不同的环境进行很好的拟合, 导致识别异常物体的性能在不同的场景会落差很大。

在这里和大家分享一波我们ICCV 2023中稿的工作 "Residual Pattern Learning for Pixel-wise Out-of-Distribution Detection in Semantic Segmentation". 在本次工作中, 我们针对当前OoD Segmentation中的两个问题进行了优化, 并且用consistent checkpoint 在所有数据集上取得了非常好的性能。

背景:

语义分割模型用于将像素级别的sample分类到 In Distribution (ID) 类别中。然而,当在开放世界中部署时,这些模型的可靠性不仅取决于其对ID像素的分类能力,还取决于其对Out-of-Distribution (OoD) 像素的检测能力。比如在autonomous driving的任务中, 路上出现一些障碍物 (OoD object, 比如说`路障`) 的时候, 传统的闭集semantic segmentation并不能很好的检测出这些物体。因为原本的segmentation 模型在训练的时候并没有定义这些种类, 导致这类物体会被判定成head categories (e.g., road), 会对驾驶造成潜在的危险。

OoD Segmentation方向概述:

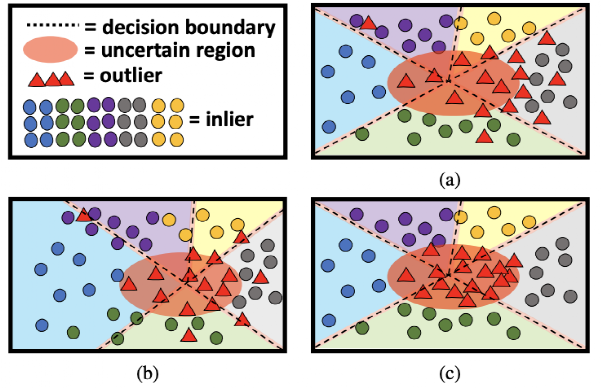

1). 锁网络: 最straight forward的方法就是直接通过softmax 或者 energy的结果来把segmentation输出的mask里面潜在的low confidence pixel判断成OoD。这种方法的好处是不会影响ID的segmentation性能, 并且不需要训练网络, 但是在遇到复杂的inlier或者outlier的时候, 性能会下降的很明显, 如上图 (a) 所示。

2). 重新训练: 最近的办法主要是通过Outlier Exposure (OE) 将一个不相干的OoD数据集加入到ID数据集, 然后fine-tune已经训练好的close-set segmentation模型。在这个fine-tuning过程中, 利用新加入的OoD object来强行增加原本segmentation模型对异常的敏感度, 使得其OoD分割的性能得到了非常大的提升。但是这类方法的重新训练会导致原本ID类别的分割的性能受到不可逆的干扰, 如图 (b) 所示。

由这两点为motivation, 我们想要在保留原本inlier的分类性能的情况下, 得到一个稳定有效的OoD 分割器。

方法:

1). Residual Pattern Block (RPL):

与以往直接fine-tuning/retraining 分割网络不同, 我们在在原本的网络上外接了一个轻便的RPL block (frpl),然后原本的segmentation模型会全程锁住。基本思路是, frpl block对ID的pixel不做任何影响, 但是对潜在的OoD pixel做一个扰动, 让对应的confidence大幅下降, 进而通过最终map里的energy来判别是不是异常。

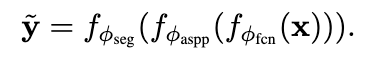

在训练过程中, 我们先用原本的网络生成 y_tilde (ID pseudo label):

然后用RPL扰动后的原本网络的结果:

对ID的pixel, 我们用cross-entropy来做penalty, 保证原本对OE的OoD object, 我们用下面的Energy cost function来约束他的能量

在训练的过程中, RPL不会导致原本segmentation模型的性能受到影响, 并且能高效的分割出潜在的OoD pixel。

2). Context-Robust Contrastive Learning (CoroCL):

目前所有OoD Segmentation在不同场景下的表现都不稳定, 比如大多数分割器在城市场景下能够很好的检测到物体, 但是在以下乡村的环境 (context) 下就会直接失效。

为了应对这个问题, 增强网络对多个context的鲁棒性, 我们引用了supervised contrastive learning。我们在RPL的基础上多加了一层projection layer, 并且随机提取四种样本, 分别是

1). ID 场景里的 inlier pixel, 2). ID 场景里的OoD pixel,  和

和

3). OoD 场景里的inlier pixiel 4). OoD 场景里的OoD Pixel

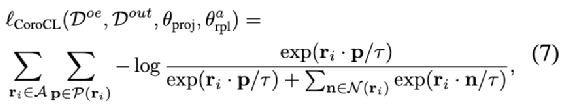

我们通过InfoNCE来将不同场景的Inlier pixel聚合到一起, 并且推远OoD pixel

实验:

1). Test Results (wandb visualisation: https://wandb.ai/yy/RPL?workspace=user-pyedog1976)

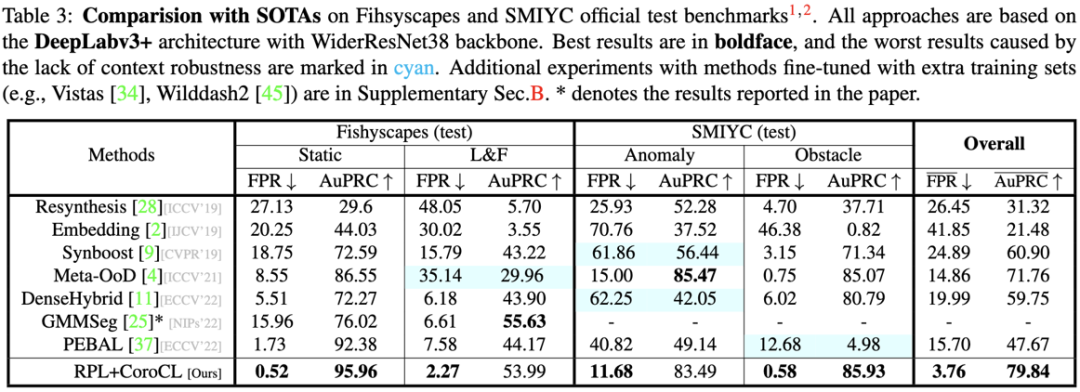

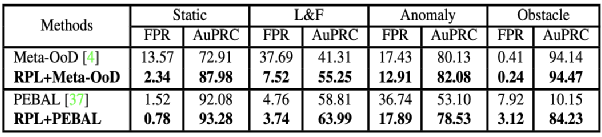

我们的结果在多个benchmark上获得了最稳定的结果, 超过了之前的SOTA超过10个点的FPR和20个点的AuPRC。

2). Ablation Study

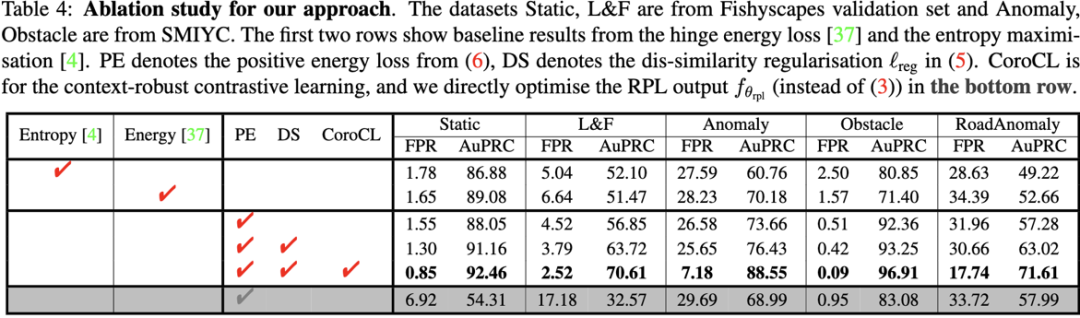

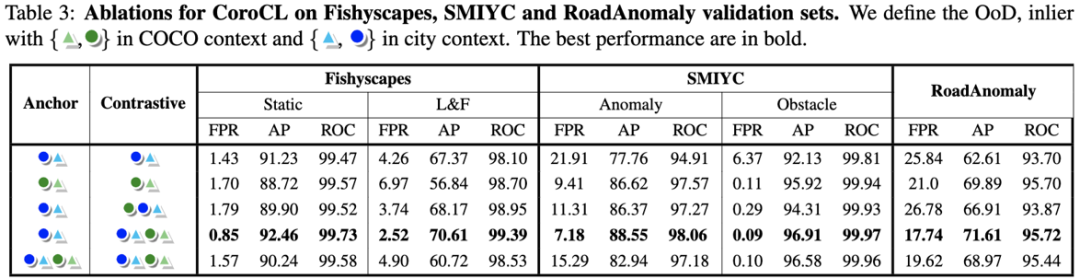

在消融实验里, 我们可以先比较了用entropy和energy用来当loss的结果, 然后比较了使用RPL和直接使用一个binary OoD 检测器 (最后一行), RPL与Energy带来了稳定的提升。然而RPL在不同的context也有之前OoD segmentation的通病: 在FS-StaticL&F这种city环境下效果很好, 但是在其他的benchmark比如Anomaly&RoadAnomaly表现却很差 (25.65 & 17.74), CoroCL很好的缓解了这个问题。

2.1). Ablation of RPL

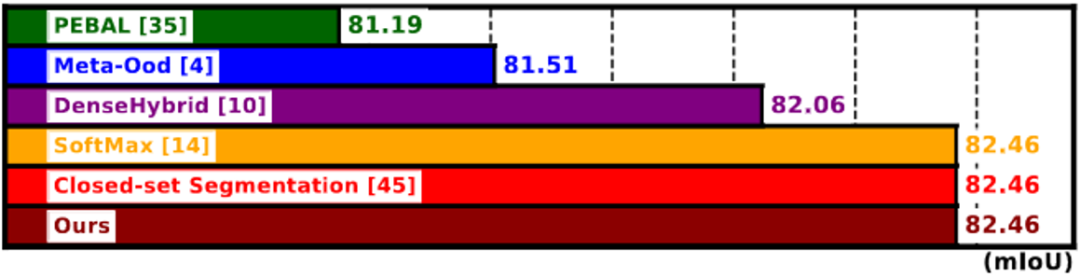

在上图, 我们比较了原本close-set 分割模型的 mIoU [39] 和 其他re-training based OoD ([3], [9] and [31]) 在close-set的表现。我们的方法和freeze model 的方法 [13] 在ID数据集没有改变, 但是我们的方法有更好的识别OoD pixel的性能 (如section 1.) 所示)。

同时如上表, 我们RPL block可以对其他的OoD的方法在所有benchmark带来进一步的提升。

2.2). Ablation of CoroCL

我们在对anchor set 和 contrastive set的选择上, 测试了不同的组合。在最后我们发现当使用Anchor set为Inlier与OE, Contrastive set为全部种类时效果最好。在这种组合下, InfoNCE只会将  互相拉近, 推远

互相拉近, 推远  , 但不会把两种OoD

, 但不会把两种OoD  拉近。

拉近。

3). The Learned RPL Feature

我们用self-attention

torch.einsum(’abc,bca->bc’,r, r.permute(1,2,0))

来可视化RPL的输出学到的OoD pattern (r)。在上图可以看到, RPL对潜在的OoD object会输出扰动, 而ID的pixel会拟合0输出。

3). Final Visualisation

* 颜色越偏红 代表异常可能性越高

编辑:黄飞

-

FPGA在自动驾驶领域有哪些应用?2024-07-29 8175

-

【话题】特斯拉首起自动驾驶致命车祸,自动驾驶的冬天来了?2016-07-05 13719

-

自动驾驶真的会来吗?2016-07-21 14090

-

细说关于自动驾驶那些事儿2017-05-15 7020

-

自动驾驶的到来2017-06-08 7307

-

UWB主动定位系统在自动驾驶中的应用实践2018-12-14 3188

-

自动驾驶汽车的定位技术2019-05-09 3343

-

如何让自动驾驶更加安全?2019-05-13 3625

-

自动驾驶汽车的处理能力怎么样?2019-08-07 2796

-

为何自动驾驶需要5G?2020-06-08 4166

-

UWB定位可以用在自动驾驶吗2020-11-18 3608

-

网联化自动驾驶的含义及发展方向2021-01-12 4822

-

自动驾驶系统设计及应用的相关资料分享2021-08-30 2305

-

自动驾驶技术的实现2021-09-03 3079

-

自动驾驶汽车在公共道路上行驶,但仍存异常驾驶行为2018-08-28 4015

全部0条评论

快来发表一下你的评论吧 !