稚晖君独家撰文:具身智能即将为通用机器人补全最后一块拼图

描述

具身智能新纪元。

*本文为稚晖君独家供稿,「甲子光年」经智元机器人授权发布。稚晖君本名彭志辉,先后任职OPPO、华为,现为智元机器人CTO、首席架构师。

在ChatGPT之后,又一个大模型概念火了——具身智能(Embodied AI)。

在学术界,图灵奖得主、上海期智研究院院长姚期智认为,人工智能领域下一个挑战将是实现“具身通用人工智能”;清华大学计算机系教授张钹院士,也在某产业智能论坛上提出,随着基础模型的突破,通用智能机器人(具身智能)是未来的发展方向。

在产业界,微软、谷歌、英伟达等大厂均开展了相关研究,比如谷歌RT-2、英伟达VIMA等。英伟达创始人兼CEO黄仁勋在ITF World 2023 半导体大会上表示,AI下一个浪潮将是“具身智能”。

具身智能作为人工智能发展的一个重要分支,正在迅速崭露头角,成为科技界和大众关注的热门话题,同时在各个领域中展现出巨大的潜力和吸引力。

1. 什么是具身智能?

具身智能通过在物理世界和数字世界的学习和进化,达到理解世界、互动交互并完成任务的目标。

具身智能是由“本体”和“智能体”耦合而成且能够在复杂环境中执行任务的智能系统。一般认为,具身智能具有如下的几个核心要素:

第一是本体,作为实际的执行者,是在物理或者虚拟世界进行感知和任务执行的机构。

本体通常是具有物理实体的机器人,可以有多种形态。本体的能力边界会限制智能体的能力发挥,所以,具有广泛适应性的机器人本体是非常必要的。

随着机器人技术的进步,本体越来越呈现多样化和灵活性。比如,四足机器人可以具有良好的运动能力和通过性,复合机器人则把运动和操作机构整合,具有较好的任务能力;而人形机器人作为适应性更加广泛,通用能力更强的本体形态,得到了长足的进步,已经到了可以商业化的前夕。

本体具备环境感知能力、运动能力和操作执行能力,是连接数字世界和物理世界的载体。

具身智能的第二个要素是智能体(Embodied Agents),是具身于本体之上的智能核心,负责感知、理解、决策、控制等的核心工作。

智能体可以感知复杂环境,理解环境所包含的语义信息,能够和环境进行交互;可以理解具体任务,并且根据环境的变化和目标状态做出决策,进而控制本体完成任务。

随着深度学习的发展,现代智能体通常由深度网络模型驱动,尤其是随着大语言模型(LLM)的发展,结合视觉等多种传感器的复杂多模态模型,已经开始成为新一代智能体的趋势。

同时,智能体也分化为多种任务形态,处理不同层次和模态的任务。智能体要能够从复杂的数据中学习决策和控制的范式,并且能够持续的自我演进,进而适应更复杂的任务和环境。

智能体设计是具身智能的核心。具有通用能力的LLM和VLM等模型,赋予了通用本体强大的泛化能力,使得机器人从程序执行导向转向任务目标导向,向通用机器人迈出了坚实的步伐。

具身智能的第三个要素是数据。“数据是泛化的关键,但涉及机器人的数据稀缺且昂贵。”

为了适应复杂环境和任务的泛化性,智能体规模变的越来越大,而大规模的模型对于海量数据更为渴求。现在的LLM通常需要web-scale级别的数据来驱动基础的预训练过程,而针对具身智能的场景则更为复杂多样,这造成了多变的环境和任务,以及围绕着复杂任务链的规划决策控制数据。尤其是针对行业场景的高质量数据,将是未来具身智能成功应用落地的关键支撑。

具身智能的第四个要素是学习和进化架构。智能体通过和物理世界(虚拟的或真实的)的交互,来适应新环境、学习新知识并强化出新的解决问题方法。

采用虚拟仿真环境进行部分学习是合理的设计,比如英伟达的元宇宙开发平台Omniverse,就是构建了物理仿真的虚拟世界,来加速智能体的演进。

但真实环境的复杂度通常超过仿真环境,如何耦合仿真和真实世界,进行高效率的迁移(Sim2Real),也是架构设计的关键。

2. 具身智能的科研和技术进展

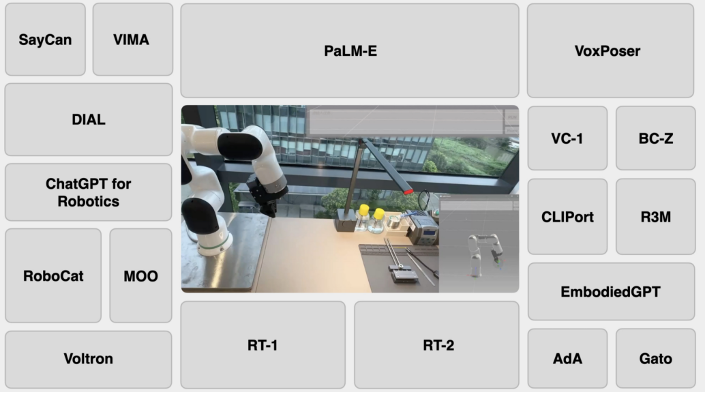

在基于Transformer的大语言模型浪潮带领下,微软、谷歌、英伟达等大厂,以及斯坦福、卡耐基梅隆等高等学府均开展了具身智能的相关研究。

微软基于ChatGPT的强大自然语言理解和推理能力,生成控制机器人的相关代码;

英伟达VIMA基于T5模型,将文本和多模态输入交错融合,结合历史信息预测机器人的下一步行动动作;

斯坦福大学利用LLM的理解、推理和代码能力,与VLM交互并生成3D value map,来规划机械臂的运行轨迹;

谷歌具身智能路线较多,包括从PaLM衍生来的PaLM-E,从Gato迭代来的RoboCat,以及最新基于RT-1和PaLM-E升级得到的RT-2。

谷歌在具身智能的研究上更具有广泛性和延续性。与其他大厂相比,谷歌依托旗下两大AI科研机构,Google Brain和DeepMind(2023年4月两大机构合并为Google DeepMind),在具身智能上研究了更多的技术路线,且各路线之间有很好的技术延续性。

其中基于RT-1研究成果,谷歌融合了VLM(PaLM-E是其中一种)和RT-1中收集的大量机器人真实动作数据,提出了视觉语言动作(VLA)模型 RT-2,在直接预测机器人动作的同时,受益于互联网级别的训练数据,实现了更好的泛化性和涌现性。

从RT-2的实验结果看,一方面,面对训练数据中没见过的物体、背景、环境,RT-2系列模型能够仍能实现较高的成功率,远超基线对比模型,证明了模型有较强的泛化能力。

另一方面,对于符号理解、推理和人类识别三类不存在于机器人训练数据中的涌现任务,RT-2系列模型也能以较高正确率完成,表明语义知识从视觉语言数据中转移到RT-2 中,证明了模型的涌现性能。同时,思维链(CoT)推理能够让RT-2完成更复杂的任务。

任何的训练都需要数据的支撑。目前来看,机器人数据来源通常是真实数据和合成数据。

真实数据效果更好,但需要耗费大量的人力和物力,不是一般的企业或机构能够负担的。谷歌凭借自己的资金和科研实力,耗费17个月时间收集了13台机器人的13万条机器人真实数据,为RT-1和RT-2的良好性能打下根基。

谷歌的另一项研究RoboCat,在面对新的任务和场景时,会先收集100-1000个真实的人类专家示例,再合成更多数据,用于后续训练,是经济性和性能的权衡。

除了数据来源问题,还有一个就是具身智能体的预测如何映射到机器人的动作,这主要取决于预测结果的层级。

以谷歌PaLM-E和微软ChatGPT for Robotics为例,预测结果处于高级别设计层级:PaLM-E实现了对具身任务的决策方案预测,但不涉及机器人动作的实际控制,需要依赖低级别的现成策略或规划器来将决策方案“翻译”为机器人动作。

微软默认提供控制机器人的低层级 API,ChatGPT 输出是更高层级的代码,只需调用到机器人低层级的库或API,从而实现对机器人动作的映射和控制。

还有一种情况就是预测结果已经到了低级别动作层级。例如,RT-2输出的一系列字符串,是可以直接对应到机器人的坐标、旋转角等信息;VoxPoser规划的结果直接就是机器人运行轨迹;VIMA也可以借助现有方法将预测的动作token映射到离散的机器人手臂姿势,即不需要再经过复杂的翻译将高层级设计映射到低层级动作。

3. 具身智能的难点剖析

具身智能作为迈向通用人工智能(AGI)的重要一步,是学术界和产业界的热点,随着大模型的泛化能力进一步提升,各种具身方法和智能体不断涌现,但是要实现好的具身智能,会面临算法、工程技术、数据、场景和复杂软硬件等的诸多挑战。

首先,要有强大的通用本体平台。如何解决硬件的关键零部件技术突破,形成具有优秀运动能力和操作能力的平台级通用机器人产品,将具身本体的可靠性、成本和通用能力做到平衡,是一个巨大的挑战。

从基础的电机、减速器、控制器到灵巧手等各部分,都需要持续进行技术突破,才能够满足大规模商用的落地需求。

同时,考虑到通用能力,人形机器人被认为是具身智能的终极形态。这方面的研发,也将持续成为热点和核心挑战。

其次,需要设计强大的智能体系统。

作为具身智能的核心,具备复杂环境感知认知能力的智能体,将需要解决诸多挑战,包括:物理3D环境精确感知、任务编排与执行、强大的通识能力、多级语义推理能力、人机口语多轮交互能力、long-term记忆能力、个性化情感关怀能力、强大的任务泛化与自学迁移能力等。

同时,具身智能要求实时感知和决策能力,以适应复杂和变化的环境。这要求高速的数据采集、传输和处理,以及实时的决策反应,尤其是LLM所消耗的算力规模巨大,对于资源有限的机器人处理系统将形成巨大的数据量、AI计算能力和低延迟的挑战。

再者,高质量的行业数据将成为巨大挑战。

现实场景的复杂多变,使得现阶段缺乏足够的场景数据来训练一个完全通用的大模型,进而让智能体自我进化。

而且,耦合的本体,需要实际部署到真实环境中,才能够采集数据,这也是和非具身智能的明显不同。

比如,在工厂作业中,由于机器人本体并未参与到实际业务,则很多实际运行数据就无法采集,而大量的人类操作数据虽然可以弥补部分不足,但仍然需要实际业务的数据。

当然,通过大模型的涌现能力和思维链能力,部分任务可以零样本学习到,但对于关键业务,要求成功率,则仍然需要高质量的垂域数据。同时,通过层次化的智能体设计,将不同任务限定到特定领域,则是一个解决泛化和成功率的有效尝试。

最后,通过虚拟和真实的交互,持续学习和进化的能力,则是具身智能演进的重要技术途径。

亿万年的生物演化过程,造就了形态丰富的生命形式。而学习新任务来适应环境的变化,则是持续改进的动力。形态适配环境合适的智能体,则可以快速的学习到解决问题能力,进而更好的适应变化。

但是,由于形态的变化空间无穷巨大,搜索所有可能的选择在有限的计算资源情况下变的几乎不可能。本体的自由度设计,也会物理上约束智能体的任务执行能力,进而限制了控制器的学习效果。

在复杂环境、形态演化和任务的可学习性之间,存在着未可知的隐式关系,如何快速学习到合理的规划和决策能力,则成为具身智能的重要一环。

4. 智元机器人的实践

8月18日,智元机器人在具身智能远征A1的发布会提出了一种具身智脑的概念:

具身智脑EI-Brain(Embodied Intelligence Brain)把机器人的具身智能思维系统分为云端的超脑、端侧的大脑、小脑,以及脑干这样四层,分别对应于机器人任务级、技能级、指令级以及伺服级的能力。

⼤脑⽤于完成前⾯提到的语义级多段推理任务,结合上下文进行任务理解,⽽且如果模型的通识能⼒不满⾜任务需求,还可以借⽤更强的云端超脑的互联⽹能⼒。

小脑则负责结合各种传感器的信息进行运动指令⽣成,就跟⼈类⼀样,⼤家⾛路的时候并不会想着怎么精确地控制每块肌⾁收缩,而是由⼤脑发出⼀个宏观指令后,由⼩脑完成身体的平衡和各种运动学动⼒学的控制,运控算法都跑在这⼀层。

最后在硬件底层,由脑⼲来进⾏精确的伺服闭环控制每个电机⾼效精准地执⾏。

在EI-Brain的设计中,上层大模型聚焦于具体的感知决策和计划生成,不用依赖于具体的机器人载体硬件;下层视控模型和运控算法聚焦于底层的具体场景的特定动作执行,不用决策整个任务如何完成。超脑、大脑与小脑、脑干能够相互解耦,不用相互依赖,实现了具身智能系统的层级划分。

智元远征A1是为了完成重复性的通用任务而设计,设计时考虑了2个非常重要的指标,“任务泛化率”和“任务执行成功率”。

任务泛化率指的是对未见过的任务的泛化能力,是否能够按照上述生成的指令计划进行精准执行。这个指标主要针对是对上层的云端超脑和大脑来说,大模型是否能够对用户各种新说法和新的3D环境进行精确的感知决策和指令计划生成。

任务执行成功率指的是机器人载体在实际物理环境中,执行具体任务的成功率等,这个指标主要针对下层的小脑和脑干来说,视控模型和运控算法是否能够按照上述生成的指令计划进行精准执行。

EI-Brain具身智能系统层级有效保证了这两个指标参数的实现,极大地提升了机器人的智能水平和工作效率,使其在完成复杂任务、泛化任务时,更加得心应手。

类似⾃动驾驶L1到L5的发展过程,全场景适⽤的通⽤机器⼈的实现也不会是⼀步到位的。在技能级模型层⾯,智元机器人定义了⼀系列的元操作(Meta-Skill)库,在元操作库范围限定的这些有限泛化场景内,机器⼈能够⾃主推理决策出端到端完成任务所需要的动作编排。⽽且随着元操作库列表的不断扩充,机器⼈能够胜任的任务空间将呈指数级增⻓,在交互中学习进化,最终实现全场景的覆盖,切⼊千⾏百业。

智元远征A1本体是当前国内通用机器人领域最领先的。智元远征A1形态与人类相似,身高175cm,重量55kg,最高步速可达7km/h,全身49个自由度,整机承重80kg,单臂最大负载5kg。

智元远征A1全身搭载了包含谐波⼀体关节、⾏星伺服、直线驱动器、空⼼杯电机等在内的49个各类执⾏器,也就是说这⼀版机器⼈拥有49个⾃由度。

在硬件层面,智元自研了关节电机PowerFlow、灵巧手SkillHand、反曲膝设计等关键零部件,以此提升具身智能机器人的能力、同时降低成本。

在软件层面,智元自研了AgiROS,是一套机器人运行时中间件系统,在AI感知决策与视觉控制等大模型算法方面,能够实现自主任务编排、常识推理与规划执行等。

未来智元将紧跟算法前沿,尤其是大模型的前沿技术,重视数据原始积累和数据平台建设,形成数据闭环,为算法打下坚实的基础。结合硬件自研优势,以具身智能人形机器人为载体,构建丰富的meta-skills技能库,快速落地相关商业垂域应用场景,在实验室上的学术探索基础上迈出商业落地的最为关键一步。

-

《具身智能机器人系统》第10-13章阅读心得之具身智能机器人计算挑战2025-01-04 2096

-

【「具身智能机器人系统」阅读体验】+两本互为支持的书2025-01-01 1759

-

【「具身智能机器人系统」阅读体验】2.具身智能机器人大模型2024-12-29 1771

-

【「具身智能机器人系统」阅读体验】1.初步理解具身智能2024-12-28 1727

-

【「具身智能机器人系统」阅读体验】1.全书概览与第一章学习2024-12-27 2385

-

《具身智能机器人系统》第7-9章阅读心得之具身智能机器人与大模型2024-12-24 2303

-

【「具身智能机器人系统」阅读体验】+初品的体验2024-12-20 1541

-

《具身智能机器人系统》第1-6章阅读心得之具身智能机器人系统背景知识与基础模块2024-12-19 2160

-

名单公布!【书籍评测活动NO.51】具身智能机器人系统 | 了解AI的下一个浪潮!2024-11-11 4455

-

具身智能在机器人技术中的发展2024-10-27 3102

-

通用机器人初创公司逐际动力完成新一轮战略融资2024-05-21 1048

-

华为天才少年稚晖君轮足机器人“远征A1”正式发布2023-08-18 3777

-

封神了!华为天才少年自制硬萌机器人,再次刷屏网络!2022-03-16 3572

-

dfrobotGMR通用机器人扩展板简介2019-12-26 2142

全部0条评论

快来发表一下你的评论吧 !