AI芯片之xPU技术架构分析

人工智能

描述

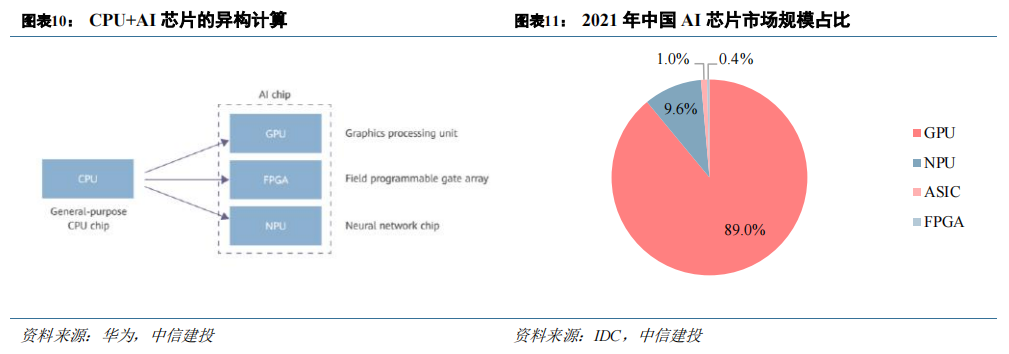

从广义上讲,能运行AI 算法的芯片都叫AI 芯片。CPU、GPU、FPGA、NPU、ASIC 都能执行AI 算法,但在执行效率层面上有巨大的差异。CPU 可以快速执行复杂的数学计算,但同时执行多项任务时,CPU 性能开始下降,目前行业内基本确认CPU 不适用于AI 计算。 内容来源“AI芯片第一极:GPU性能、技术全面分析”。 CPU+xPU 的异构方案成为大算力场景标配,GPU为应用最广泛的 AI 芯片。目前业内广泛认同的AI 芯片类型包括GPU、FPGA、NPU 等。 由于CPU 负责对计算机的硬件资源进行控制调配,也要负责操作系统的运行,在现代计算系统中仍是不可或缺的。GPU、FPGA 等芯片都是作为 CPU 的加速器而存在,因此目前主流的AI计算系统均为CPU+xPU 的异构并行。CPU+GPU 是目前最流行的异构计算系统,在HPC、图形图像处理以及AI 训练/推理等场景为主流选择。IDC 数据显示,2021 年中国 AI 芯片市场中,GPU 市占率为 89%。

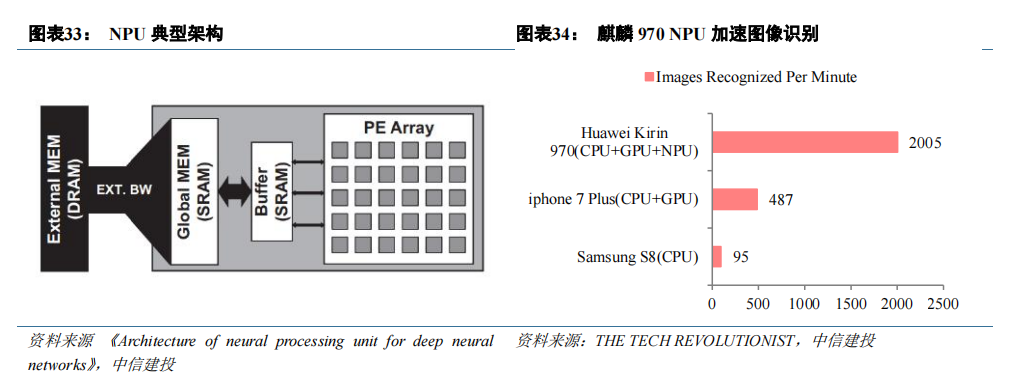

NPU 在人工智能算法上具有较高的运行效率。为了适应某个特定领域中的常见的应用和算法而设计,通常称之为“特定域架构(Domain Specific Architecture,DSA)”芯片,NPU(神经网络处理器)属于其中一种,常被设计用于神经网络运算的加速。以华为手机 SoC 麒麟 970 为例,NPU 对图像识别神经网络的运算起到了显著加速效果,使其图像识别速度明显优于同代竞品的表现。

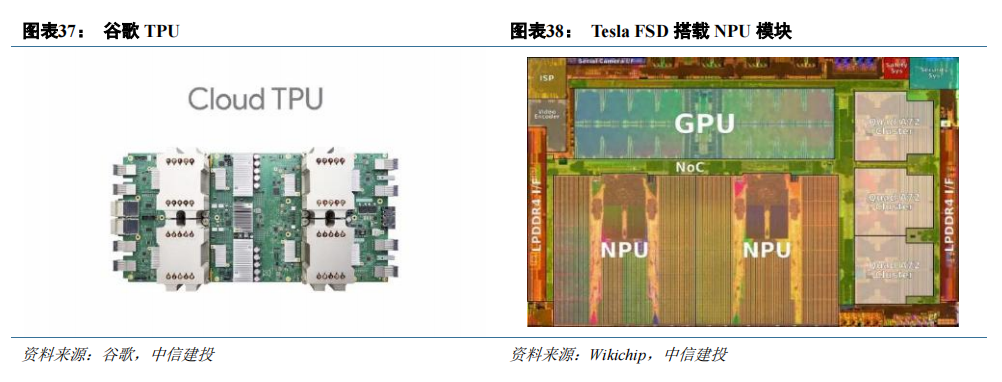

目前已量产的 NPU 或搭载 NPU 模块的芯片众多,其他知名的芯片包括谷歌 TPU、华为昇腾、特斯拉 FSD、特斯拉 Dojo 等。各家厂商在计算核心的设计上有其差异,例如谷歌 TPU 的脉动阵列,华为昇腾的达芬奇架构。

以谷歌 TPU 及计算核心结构脉动阵列为例,对比其相较于 CPU、GPU 的区别:

CPU 和GPU 均具有通用性,但以频繁的内存访问导致资源消耗为代价。CPU 和 GPU 都是通用处理器,可以支持数百万种不同的应用程序和软件。对于 ALU 中的每一次计算,CPU、GPU 都需要访问寄存器或缓存来读取和存储中间计算结果。由于数据存取的速度往往大大低于数据处理的速度,频繁的内存访问,限制了总吞吐量并消耗大量能源。

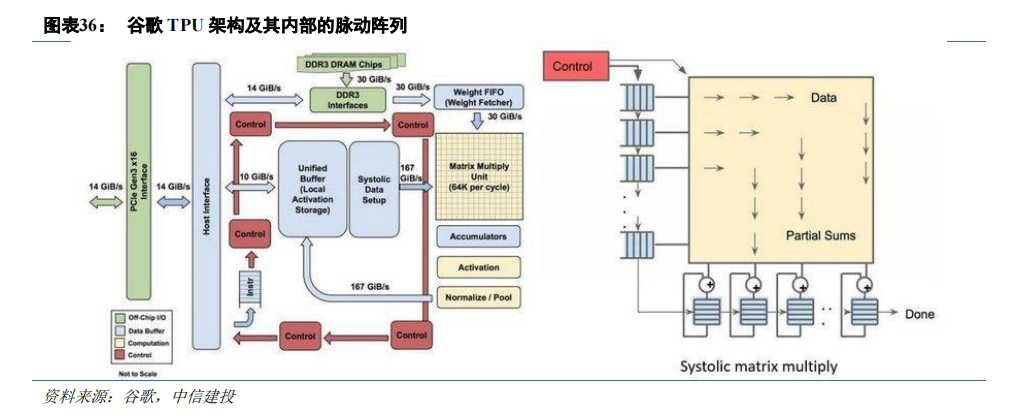

谷歌TPU 并非通用处理器,而是将其设计为专门用于神经网络工作负载的矩阵处理器。TPU 不能运行文字处理器、控制火箭引擎或执行银行交易,但它们可以处理神经网络的大量乘法和加法,速度极快,同时消耗更少的能量,占用更小的物理空间。

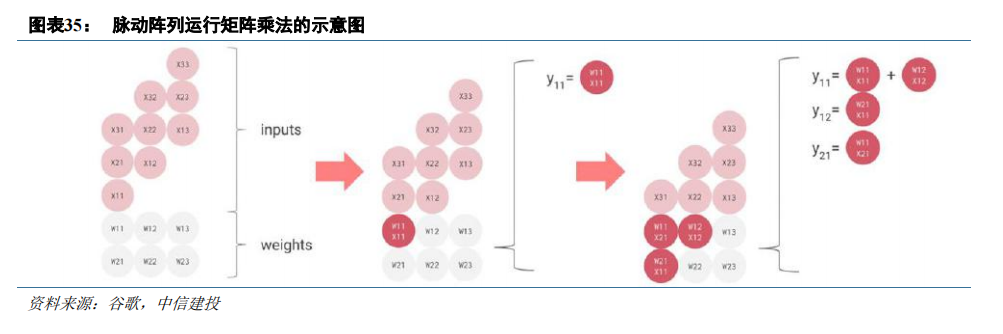

TPU 内部设计了由乘法器和加法器构成的脉动阵列。在计算时,TPU 将内存中的参数加载到乘法器和加法器矩阵中,每次乘法执行时,结果将传递给下一个乘法器,同时进行求和。所以输出将是数据和参数之间所有乘法结果的总和。在整个海量计算和数据传递过程中,完全不需要访问内存。

这就是为什么TPU 可以在神经网络计算上以低得多的功耗和更小的占用空间实现高计算吞吐量。

脉动阵列本质上是在硬件层面多次重用输入数据,在消耗较小的内存带宽的情况下实现较高的运算吞吐率。

脉动阵列结构简单,实现成本低,但它灵活性较差,只适合特定运算。然而,AI 神经网络需要大量卷积运算,卷积运算又通过矩阵乘加实现,正是脉动阵列所适合的特定运算类型。

脉动阵列理论最早在1982 年提出,自谷歌2017 年首次将其应用于 AI 芯片TPU 中,这项沉寂多年的技术重回大众视野,多家公司也加入了脉动阵列行列,在自家加速硬件中集成了脉动阵列单元。

NPU 已经在 AI 运算加速领域获得了广泛应用。在数据中心获得大规模应用的 NPU 案例即 TPU,已被谷歌用于构建数据中心的超级计算机,执行特定神经网络的训练任务。在用户端,手机、汽车、智能安防摄像头等设备开始搭载AI 计算功能,通常是利用训练好的神经网络模型执行图像处理等工作,此时NPU 通用性差的劣势被缩小,高算力、高能耗比的优势被放大,因而得到了广泛的应用。在终端设备中,NPU 常以模块的形式包含在 SoC 内部,对 AI 运算进行加速,例如特斯拉自动驾驶芯片 FSD 均包含 NPU。

模型训练需要规模化的算力芯片部署于智能服务器,CPU 不可或缺,但性能提升遭遇瓶颈,CPU+xPU 异构方案成为大算力场景标配。其中 GPU 并行计算优势明显,CPU+GPU 成为目前最流行的异构计算系统,而NPU 在特定场景下的性能、效率优势明显,推理端应用潜力巨大,随着大模型多模态发展,硬件需求有望从GPU 扩展至周边编解码硬件。

AI 加速芯片市场上,英伟达凭借其硬件产品性能的先进性和生态构建的完善性处于市场领导地位,在训练、推理端均占据领先地位。根据 Liftr Insights 数据,2022 年数据中心AI 加速市场中,英伟达份额达82%。

编辑:黄飞

-

AI 芯片浪潮下,职场晋升新契机?2025-08-19 493

-

《算力芯片 高性能 CPUGPUNPU 微架构分析》第3篇阅读心得:GPU革命:从图形引擎到AI加速器的蜕变2024-11-24 1389

-

AI芯片 CPU+xPU的异构方案全面解析2023-08-22 2100

-

ai芯片技术架构有哪些2023-08-09 3022

-

ai芯片技术架构有哪些?FPGA芯片定义及结构分析2023-08-05 10568

-

AI芯片格局最全分析 精选资料分享2021-07-23 2835

-

AI芯片热潮和架构创新是什么2020-04-24 1993

-

AI芯片热潮和架构创新有什么作用2020-04-23 2285

-

三星与百度合作生产AI芯片,代工服务扩展到数据中心2019-12-19 2979

-

华为采用达芬奇架构的AI芯片Ascend 910正式商用2019-08-23 5146

-

AI发展对芯片技术有什么影响?2019-08-12 3404

-

手把手教你设计人工智能芯片及系统--(全阶设计教程+AI芯片FPGA实现+开发板)2019-07-19 8742

-

带你了解百度发布的XPU——AI云加速芯片细节2017-08-28 1837

-

数位电源技术之架构与应用2011-03-10 2220

全部0条评论

快来发表一下你的评论吧 !