HPC和数据中心融合网络面临的技术挑战

通信网络

描述

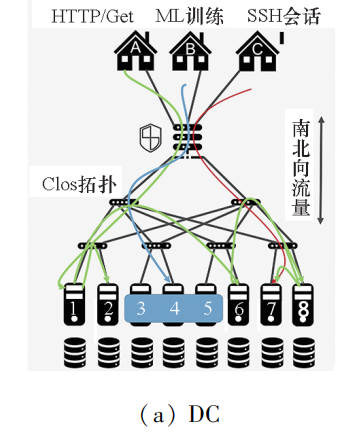

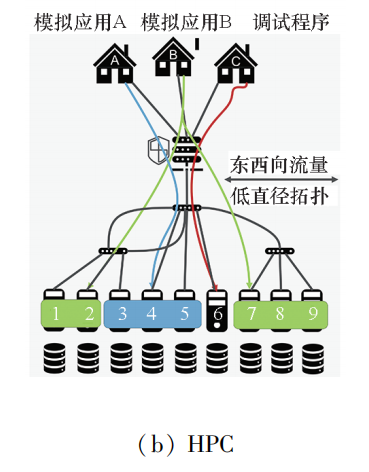

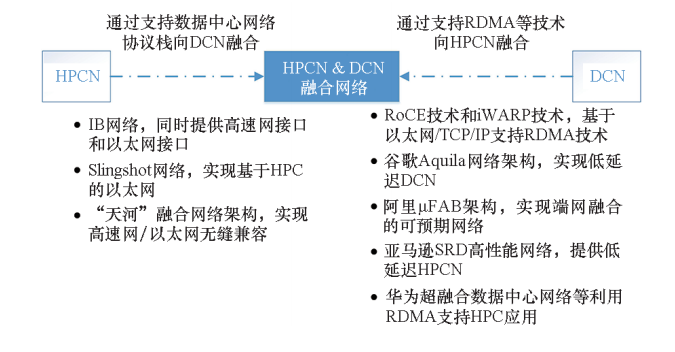

在较新的国际高性能计算排行榜TOP500中,大部分机器并非应用在传统的科学计算领域,而是应用在新兴的互联网云计算和大数据领域。HPC应用已从过去的高精尖向更平民化、普惠化的方向发展。HPC正与云计算、大数据、AI不断融合创新。HPCN与互联网技术进行融合,拓展传统HPCN支持DCN协议栈已成为当前国际高速互连领域的重要发展趋势。

随着大型DC采用具有更高带宽需求的高性能加速器,数据中心网络通过支持远程直接内存访问(RDMA)、RDMA融合以太网(RDMA over converged Ethernet,RoCE)、互联网广域RDMA协议(iWarp)等新技术不断向HPCN融合。

融合网络研究现状

NV的IB高性能互连网络通过开发多模芯片,设计基于IB的以太网协议向以太网融合,已经推出多款多网络融合的芯片产品,具有低延迟和高带宽等高性能,可以极大地提高高性能计算系统和数据中心的性能。

Cray的Slingshot技术以HPC为中心增加了以太网兼容性,其交换机兼容传统以太网并对RoCE的一些不足进行了改进,同时支持高性能计算和数据中心。

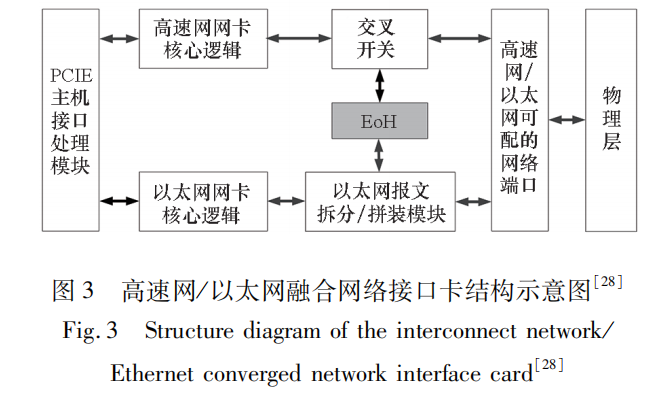

国防科技大学在自主定制高速互连网络的基础上提出一种融合网络创新架构,实现高速网/以太网无缝兼容,灵活支持科学计算和云计算等多领域应用。

“天河”融合网络架构包含PCIE主机接口处理模块、高速网网卡核心逻辑、交叉开关XBAR、以太网网卡核心逻辑、以太网报文拆分/拼装模块、物理层逻辑、高速网/以太网报文转换模块(Ethernet over high performance express,EoH)以及高速网/以太网可配的网络端口。EoH将高速网虚拟为以太网,使得连接在高速网中的节点直接与连接在以太网中的节点通信,通过高速网传输以太网报文,实现高速网/以太网无缝兼容,在一套物理硬件上灵活支持科学计算和云计算应用。

微软云平台、亚马逊云平台、百度机器学习和腾讯云都利用rdma来满足在线服务。大规模数据中心和云计算对网络延迟、吞吐量和CPU计算性能的严格要求形成了一切都在RDMA之上的局面。

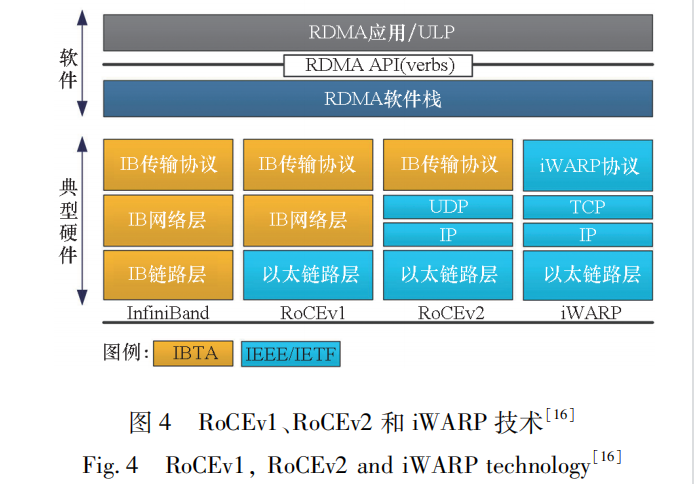

RDMA技术最早在IB专用传输网络上实现,技术先进,性能最优,但价格高昂,应用局限在HPC领域。随着以太网性能的大幅提升,越来越多的人想要选择能兼容传统以太网的高性能网络解决方案,而传统TCP/IP堆栈应用无法支撑HPC网络通信。业界厂家把RDMA技术移植到传统以太网上,降低了RDMA的使用成本,推动了 RDMA技术普及。如图 4所示,根据协议栈融合度的差异,分为 RoCE和iWARP两种技术,而 RoCE又包括 RoCE v1和 RoCEv2两个版本。

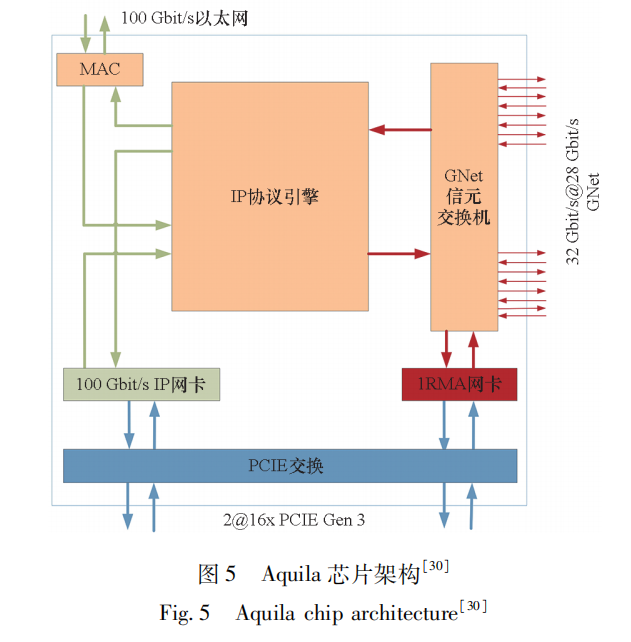

谷歌的Aquila是一种实验性的数据中心网络架构,将超低延迟作为核心设计目标,同时也支持传统的数据中心业务。Aquila芯片架构基于GNet协议设计了融合交换和网卡的定制芯片,具有低延迟远程存储访问。Aquila芯片架构包含100Gbps的IP网卡、1RMA网卡、基于信元的GNet交换芯片以及IP协议引擎。当流量进入交换机时,一部分通过IP网卡走传统的基于数据包的以太网交换,一部分通过1RMA网卡走基于信元的GNet交换。芯片中间的IP协议引擎负责两种交换单位的转换,将IP数据包切割处理为多个信元或者将信元重新组装为IP数据包。

阿里自主研发了高性能网络,以应用为中心,通过“阿里云全栈自研+端网融合技术”,实现高性能可预期网络。2022年8月阿里在顶级会议SIGCOMM上发表端网融合架构,提出了要将数据中心网络从“低时延大带宽”演进到“确定性可预期”的目标,开启了确定性数据中心网络研究的新纪元。

展望

随着HPC、大数据和AI计算呈融合发展趋势,高性能计算机和数据中心之间的界限越来越模糊,HPCN和DCN融合网络成为互连网络发展的重要趋势,从而支撑同一套基础设施高带宽、低延迟运行HPC、云计算、大数据处理和AI计算多领域应用,降低网络成本。

论文分析了当前融合网络研究现状,针对当前最具代表性的融合网络进行了详细阐述,全面展示了该领域的最新技术动态,提出了融合网络面临的技术挑战。基于技术挑战,对融合网络的发展趋势进行了展望,包括融合网络协议栈设计中融合与分化并存、基于在网计算实现融合网络性能加速,面向新兴应用需求,优化融合网络性能。

编辑:黄飞

-

适用于数据中心和AI时代的800G网络2025-03-25 2511

-

锐捷网络中标中国联通数据中心集采项目2017-01-24 3487

-

网络发展怎么改变企业数据中心的面貌的2018-08-16 1722

-

2020第十二届北京国际数据中心技术设备展览会2020-01-03 3093

-

数据中心太耗电怎么办2021-06-30 1632

-

高效率的快速部署 玩转模块化数据中心 相关资料推荐2021-07-05 2750

-

数据中心是什么2021-07-12 1953

-

数据中心网络技术面临的三大难题2018-04-24 2895

-

数据中心末端配电技术迭代面临的挑战和解决方案2020-11-03 2617

-

云南移动基于华为超融合数据中心网络方案实现数据中心网络云化改造2021-02-25 5237

-

超融合数据中心网络简介2021-10-19 3369

-

如何有效的解决数据中心面临的挑战及问题2022-01-30 2893

-

超融合数据中心网络架构的典型特征与价值2022-12-19 2628

-

GTC 2023:NVIDIA数据中心高性能和低功耗挑战2023-03-24 1818

-

超融合数据中心网络发展及趋势2023-05-19 1607

全部0条评论

快来发表一下你的评论吧 !