一种简单而有效的多摄像头算法,用于平衡性能和效率

描述

R3D3是一种用于密集三维重建和自我运动估计的多摄像头算法,该方法通过迭代地结合多摄像头的几何估计和单目深度细化来实现一致的密集三维重建。R3D3的核心思想是将单目线索与来自多摄像头的空间-时间信息的几何深度估计相结合,通过在共视图中迭代密集对应关系,计算准确的几何深度和位姿估计。为了在多摄像头设置中确定共视帧,作者提出了一种简单而有效的多摄像头算法,用于平衡性能和效率。深度细化网络以几何深度和对应的不确定性为输入,并生成细化深度,以改善例如移动物体和低纹理区域的重建,细化的深度估计作为下一次几何估计迭代的基础,从而在增量几何重建和单目深度估计之间闭合循环。R3D3在DDAD和NuScenes基准测试中实现了最优异的多摄像头深度估计性能,与单目SLAM方法相比有更高的精度和鲁棒性。

1. 引言

密集三维重建和自我运动估计是自动驾驶和机器人领域的关键挑战。与当前复杂的多模态系统相比,多摄像头系统提供了一种更简单、低成本的替代方案,然而,基于摄像头的复杂动态场景的三维重建一直面临极大的困难,因为现有的解决方案通常会产生不完整或不连贯的结果。作者提出了R3D3,一种用于密集3D重建和自我运动估计的多摄像头系统,通过迭代地结合多摄像头的几何估计和单目深度细化来实现一致的密集三维模型。

将感知输入转化为环境的密集三维模型,并跟踪观察者的位置是机器人学和自动驾驶的主要研究内容之一。现代系统依赖于融合多种传感器模态,如摄像头、激光雷达、雷达、惯性测量单元等,使硬件和软件栈变得复杂且昂贵,相比之下,多摄像头系统提供了一种更简单、低成本的替代方案,已广泛应用于现代消费者汽车。然而,基于图像的密集3D重建和自我运动估计在大规模动态场景中仍是一个开放性的研究问题,因为移动物体、重复纹理以及光学退化等方面都带来了显著的算法挑战。

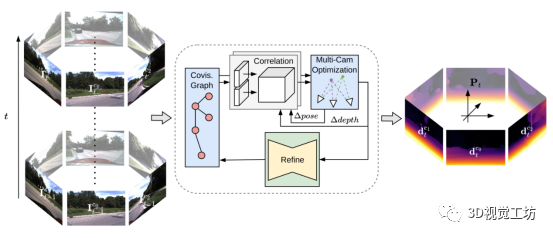

图 1 R3D3网络结构概略图 这篇论文的主要贡献包括以下三点:

提出了一种用于密集三维重建和自我运动估计的多摄像头算法R3D3。

通过一种新颖的多摄像头密集束调整(DBA)方法和多摄像头共视图,实现了准确的几何深度和位姿估计。

通过深度细化网络,整合了先验几何深度和不确定性以及单目线索,从而提高了密集三维重建的质量。

2. 相关工作

这篇论文的相关工作部分主要讨论了多视点立体(MVS)方法、视觉SLAM方法和自监督深度估计方法。MVS方法旨在从具有已知位姿的一组图像中恢复密集的3D场景结构;视觉SLAM方法关注从视觉输入中联合映射环境和跟踪观察者的轨迹,即一个或多个RGB摄像头;自监督深度估计方法关注从单目线索预测密集深度,如透视物体表面和场景上下文。

Multi-view Stereo(MVS)方法旨在从具有已知位姿的一组图像中恢复密集的3D场景结构。尽管早期的研究主要关注经典优化方法,但近年来,许多研究开始利用卷积神经网络(CNN)来估计多个深度假设平面上的特征匹配,从而在3D代价体中进行匹配。早期方法采用多个图像对之间的多个代价体,而最近的方法则使用整个图像集的单一代价体,这些方法假设在一个受控环境中有许多高度重叠的图像和已知的位姿来创建三维代价体。相反,本文的目标是从未知轨迹的移动平台上的任意多摄像头设置中实现稳健的密集3D重建。

传统的SLAM系统通常分为不同阶段,首先将图像处理为关键点匹配,然后使用这些匹配来估计3D场景几何和相机轨迹,另一类方法直接基于像素强度优化3D几何和相机轨迹。最近的方法将基于CNN的深度和姿态预测集成到SLAM流程中,这些方法面临的共同挑战是由于低纹理区域、动态物体或光学退化引起的像素对应中的离群值,需要使用鲁棒估计技术来过滤这些离群值。

自监督深度估计的开创性工作是由Zhou等人[1]提出的,他们通过最小化视图合成损失来学习深度估计,该损失使用几何约束将参考视图中的颜色信息变形到目标视图。后续的研究主要关注改进网络架构、损失正则化和训练策略,最近的方法从多视图立体视觉中汲取灵感,提出使用3D代价体来整合时间信息。然而,这些方法仍然关注单摄像头、前向场景,而这并不能反映自动驾驶汽车中真实世界的传感器设置。另一类最近的研究关注利用多摄像头设置中重叠摄像头的空间信息,这些方法利用空间上下文来提高准确性,并实现绝对尺度深度学习。然而,这些方法忽略了时间域,而时间域对深度估计提供了有用的线索。

3.方法

R3D3 算法通过结合单目视觉线索和来自多摄像头的空间-时间信息的几何深度估计,实现了在动态室外环境中的密集、一致的三维重建。该方法首先利用多摄像头系统的空间-时间信息进行几何深度估计和相机位姿估计,为了提高几何深度不可靠的区域(如移动物体或低纹理区域)的重建质量,作者引入了一个深度细化网络,该网络接受几何深度和不确定性作为输入,并产生细化后的深度。此外,细化后的深度估计作为下一次几何估计迭代的基础,从而在增量几何重建和单目深度估计之间形成闭环。

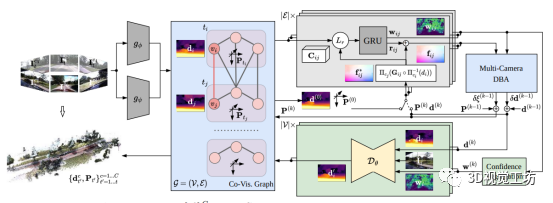

图 2 R3D3网络结构图

3.1 特征提取和相关性

本小节详细介绍了如何从每个图像中提取相关特征和上下文特征,以及如何构建共视图和计算特征相关性。主要内容包括:

特征提取:通过深度相关编码器()和上下文编码器()从每个图像中分别提取相关特征和上下文特征。

共视图:将相关特征和上下文特征存储在一个图中。作者构建了具有三种边的共视图:时间边、空间边和空间-时间边。为了在多摄像头设置中实现高效的共视图构建,作者设计了一个简单而有效的共视图构建算法。

特征相关性:对于图中的每条边,计算特征相关性。通过点积计算4D特征相关体,并使用查找操作符限制相关搜索区域。

这一部分的核心是如何从图像中提取特征并构建共视图,以便在后续步骤中进行几何深度估计和相机位姿估计。

3.2 深度和位姿估计

阐述了如何根据共视图中的每条边来估计相对位姿和深度。这部分主要包括流量校正、多相机密集束调整以及深度和位姿聚合。首先,给定和的初始估计,计算诱导流以采样相关体;然后将采样的相关特征、上下文特征和诱导流输入到卷积GRU中。GRU预测流残差和置信权重;接着,作者提出了一种多相机密集束调整(DBA)算法,用于在共视图中的每条边上迭代地优化深度和相对位姿估计;最后,在多次迭代后,作者使用加权平均法聚合每个节点的深度和位姿估计,以得到最终的深度图和相机位姿。

3.3 深度细化

本小节提出了一种深度优化方法,通过结合几何深度估计和单目视觉线索,可以在几何估计不可靠的情况下改善重建效果。作者使用了一个由参数表示的卷积神经网络,将深度、置信度和对应的图像作为输入。网络预测改进后的密集深度。通过使用每个边缘置信度权重的最大值,计算每个帧的深度置信度。对于低于阈值β的置信度区域,将输入深度和置信度权重设为零。将这些与图像进行连接,并将深度和置信度与1/8缩放的特征进行连接。与之前的方法类似,输出深度在四个尺度上进行预测。为了适应传感器设置中不同摄像头之间的焦距差异,对输出进行焦距缩放。

不同于几何方法,单目深度估计器从语义线索中推断深度,这使得它们在不同领域之间的泛化能力受到限制。因此,作者在原始的真实世界视频上通过自监督的方式训练,最小化视图合成损失。通过计算目标图像Itc和参考图像It'c'在目标视点上的光度误差,实现自监督深度估计。自监督深度估计是一个经过充分研究的领域,作者遵循了应用正则化技术过滤光度误差的通用做法。

3.4 推理过程

在论文的 3.4 小节中,作者详细描述了整个推理过程,包括如何从多个摄像头获取数据、估计深度和相对姿态、以及如何优化和融合这些信息以获得稠密的三维重建结果。

首先,从C个摄像头在时间t处获取帧,并将其编码并整合到具有初始深度图dtc和自我姿态Pt的共视图G=(V,E)中;然后,对于共视图中的每条边(i,j)∈E,从深度di和相对摄像头姿态(由自我姿态P和摄像头外参T导出)计算诱导流,从中聚合特征相关性,作为GRU的输入,该GRU估计流更新和置信度,通过多摄像头DBA操作在k次迭代中使用新的流估计f全局对齐深度d和姿态P;最后,对于共视图中的每个节点i∈V,文中使用深度优化网络优化深度图。

整个推理过程包括以下几个关键步骤:

将来自多个摄像头的帧编码并整合到共视图中。

估计每条边的深度和相对姿态。

使用 GRU 预测流更新和置信度。

通过多摄像头 DBA 方法全局对齐深度和姿态。

使用深度优化网络优化每个节点的深度图。

4. 实验

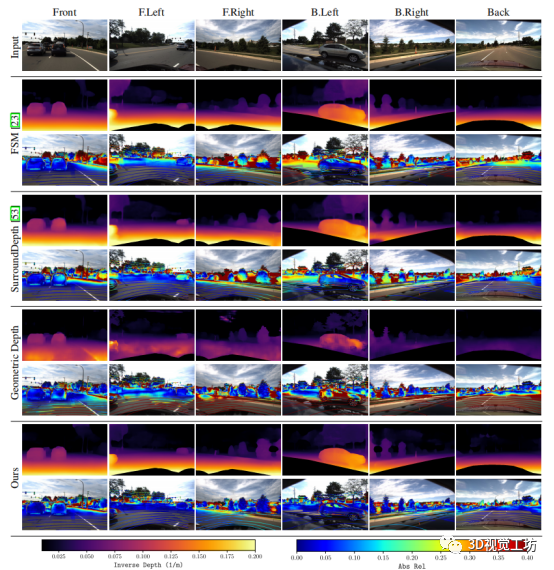

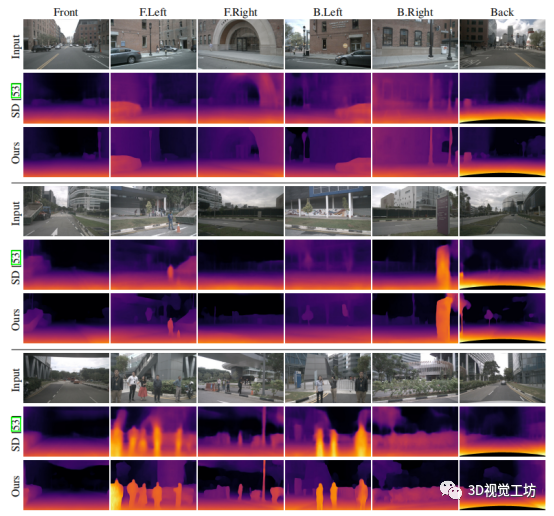

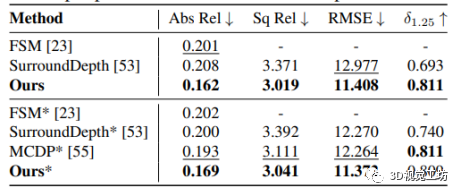

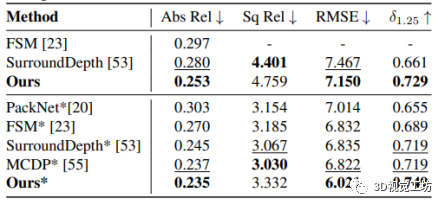

在实验部分,作者展示了他们的方法在两个广泛使用的多摄像头深度估计基准测试(DDAD和NuScenes)上的性能,并与现有的SOTA方法进行了比较。此外,他们还展示了与单目SLAM方法的精度和鲁棒性比较。实验结果表明,通过共同利用多摄像头约束以及单目深度线索,他们的方法在动态户外环境中实现了鲁棒的密集3D重建和自我运动估计。此外,他们还对共视图构建算法进行了评估,并将其与现有算法进行了比较,实验结果证实了他们的方法在几何深度估计、单目深度估计和完整方法之间有效地结合了各自的优势,同时避免了各自的弱点。这里也推荐「3D视觉工坊」新课程《彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进》。

图 3 动态场景中稠密三维重建的对比实验

图 4 在DDAD数据集上的效果

图 5 在NuScenes数据集上的效果

图 6 在DDAD数据集上的定量评价

图 7 在NuScenes数据集上的定量评价

5. 结论

R3D3算法通过共同利用多摄像头约束以及单目深度线索,在动态户外环境中实现了鲁棒的密集3D重建和自我运动估计。作者提出了一种新颖的多摄像头密集束调整方法,并设计了一个深度细化网络,将几何深度和不确定性与单目线索相结合。实验结果表明,R3D3方法在两个广泛使用的多摄像头深度估计基准测试(DDAD和NuScenes)上取得了最优异的性能,此外,与单目SLAM方法相比,R3D3算法具有更高的精度和鲁棒性。总之,R3D3方法为动态场景的密集三维重建和自我运动估计提供了一种有效的解决方案。

-

摄像头常见故障2010-03-16 3010

-

摄像头黑线识别算法2013-06-04 15245

-

如何安装倒车摄像头?2014-06-03 8164

-

b+如何连接多个摄像头?2015-01-24 22004

-

【MYD-Y6ULX申请】基于摄像头的人脸识别项目2018-01-30 2787

-

回收手机摄像头 收购手机摄像头2021-07-05 2872

-

如何去开发一种基于stm32和OV7670的摄像头呢2021-11-15 2803

-

一种摄像头自动白平衡的算法及硬件实现2009-12-14 944

-

基于摄像头的道路识别控制算法2011-03-07 1794

-

基于CCD摄像头黑线提取算法2016-03-23 894

-

基于DirectShow的多摄像头视频采集2017-02-08 3820

-

手机摄像头多摄是什么,它的优势都有哪些2020-09-28 6300

-

一种简单而有效的多通道微流控电化学传感器2020-10-09 3873

-

一种实现高性能锂金属电池的简单而有效的策略2022-09-20 1640

-

智能摄像头抄表器是什么?2024-04-24 1494

全部0条评论

快来发表一下你的评论吧 !