SK hynix的“内存中心计算”系统介绍

存储技术

描述

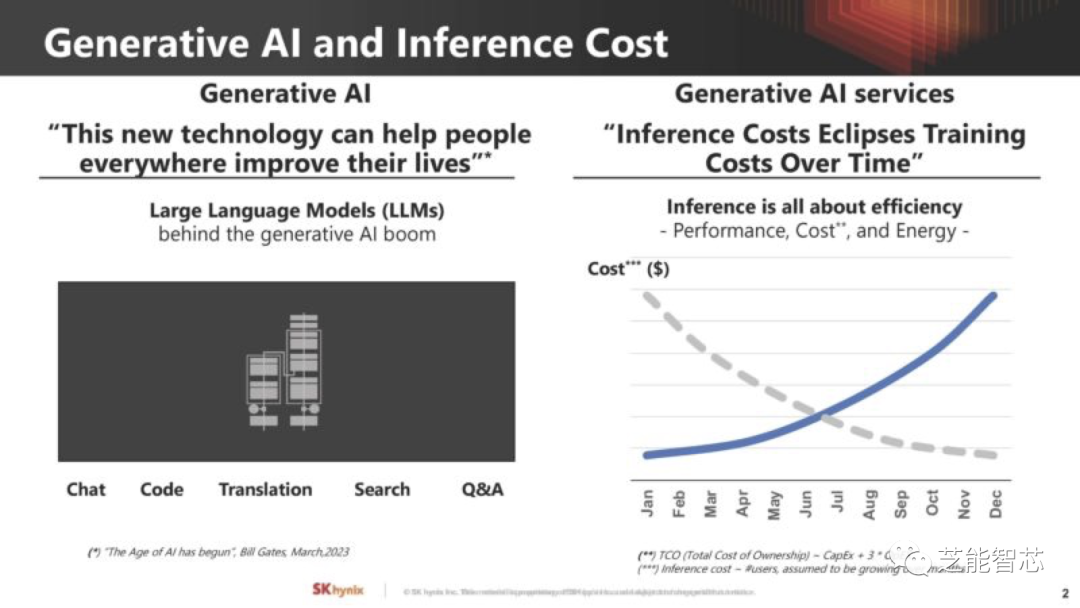

在2023年的Hot Chips 35大会上,SK hynix主要讲解内存领域的专业知识,介绍如何解决当今大规模计算领域人工智能的主要需求。SK hynix展示了其在领域特定内存上的“内存中心计算”工作,在寻找方法来缓解当前人工智能计算面临的最大挑战之一,即内存容量和带宽与可用计算资源之间的关系。本文主要收集这次系统性的介绍,并且做一些表述。

SK hynix面临的问题是这样的:生成式人工智能推理的成本非常高昂,不仅仅涉及到人工智能计算,还包括功耗、互联和内存,这些因素也在很大程度上推动了成本的增加。

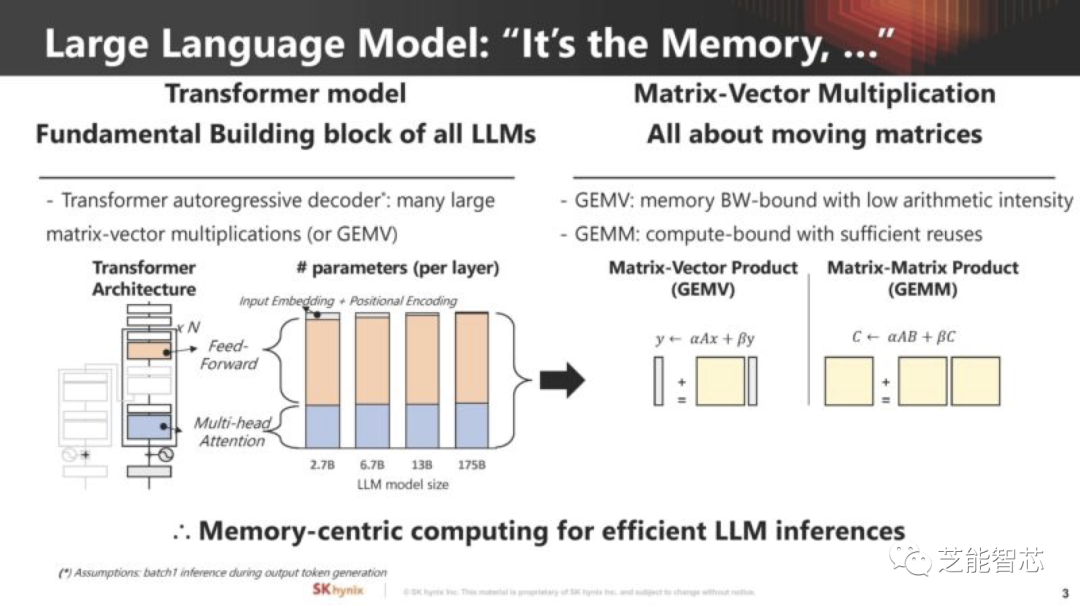

●大型Transformer模型对计算和内存的需求

特别是对于大型Transformer模型,内存是一个主要挑战,模型需要大量数据,通常受到内存容量和带宽的限制。

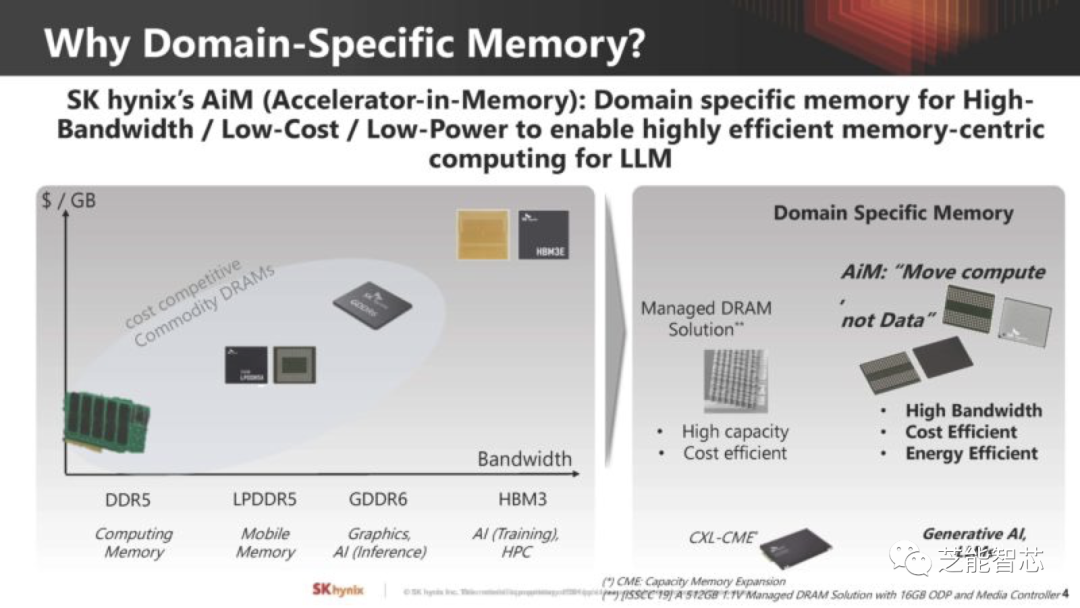

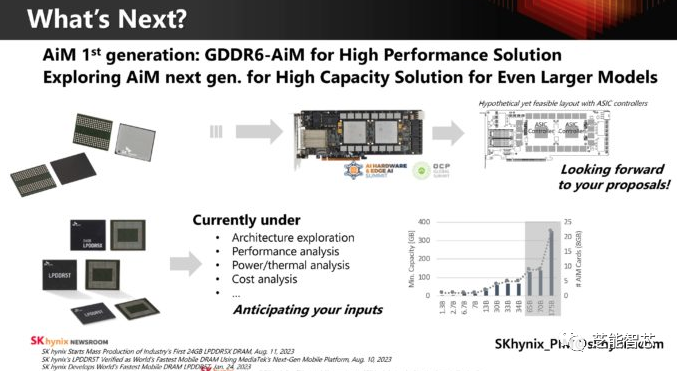

SK hynix认为AI硬件行业需要的不仅仅是内存,还需要包括内置计算功能的不同类型的内存,其中包括领域特定内存,一直在努力成为内存计算提供商,这是提高价值链的方式。

●“内存中计算”或称为SK hynix AiM

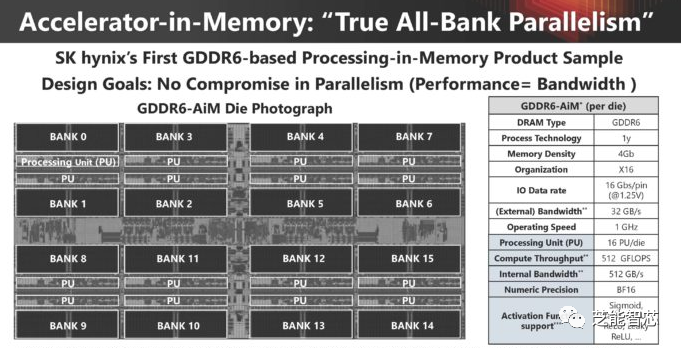

在GDDR6内存中,每个内存块都有自己的1GHz处理单元,能够提供512GB/s的内部带宽。

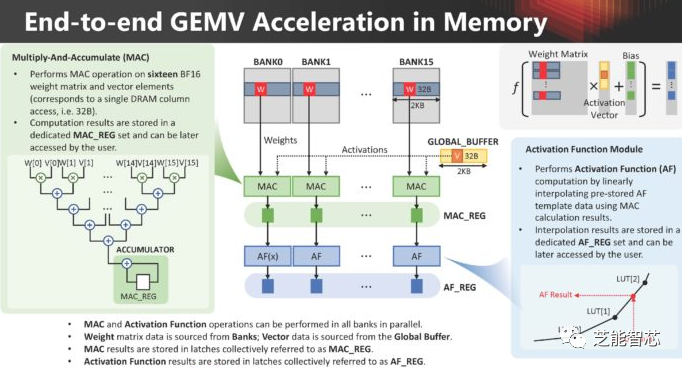

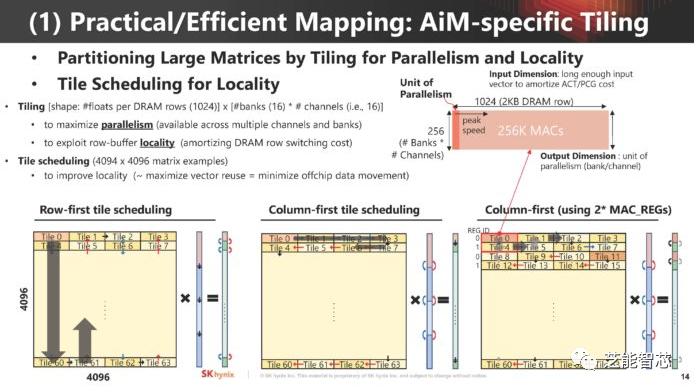

在内存中进行矩阵-向量乘法(GEMV)以进行人工智能计算,权重矩阵数据来自内存块,而向量数据来自全局缓冲区。

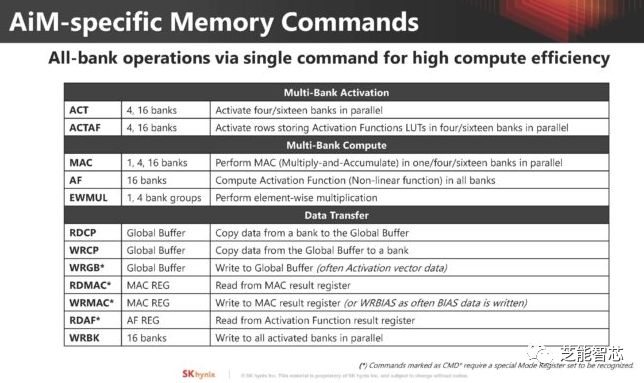

内存中的AiM使用特定的内存命令进行计算。

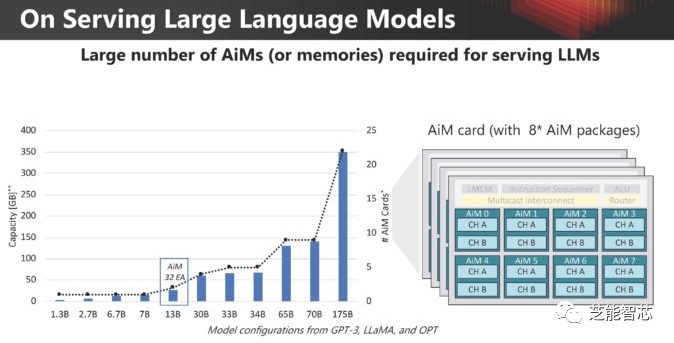

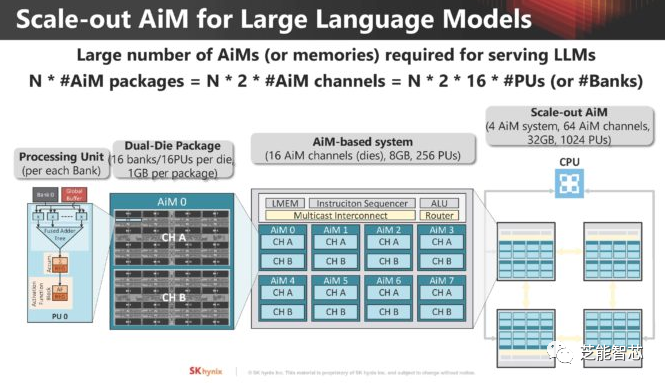

内存的扩展性,以及大型语言模型所需的内存中AiM计算资源。

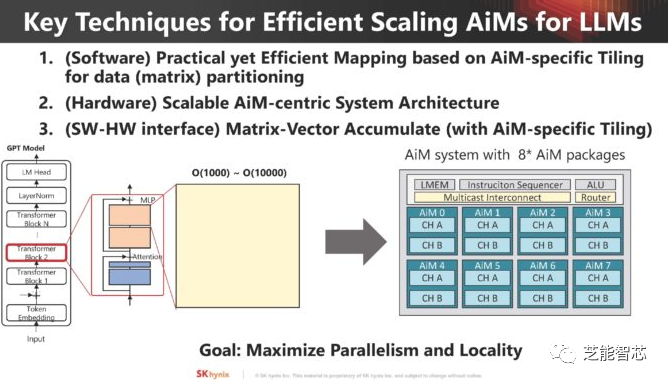

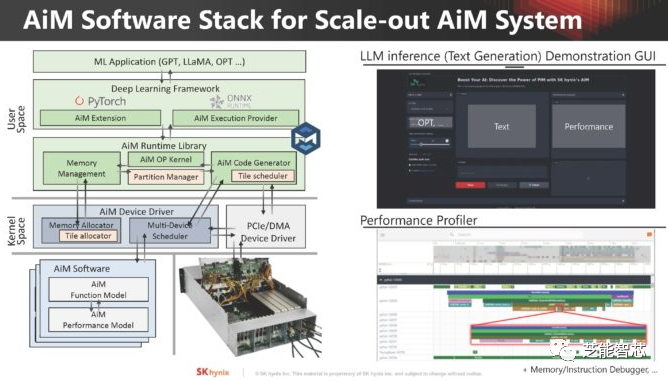

使用这种AiM的情况下,主要挑战是需要在软件端进行映射,为AiM设计硬件架构,然后提供接口,这是采用这种技术的另一个主要障碍。

研究如何将问题映射到AiM

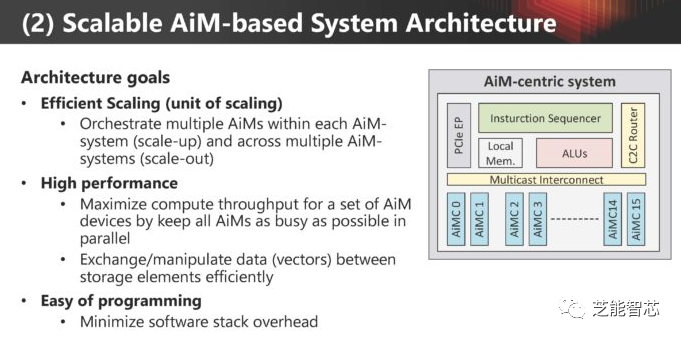

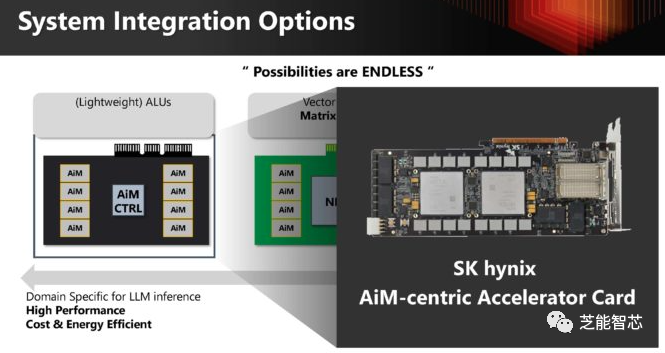

系统架构需要能够处理规模化和扩展性

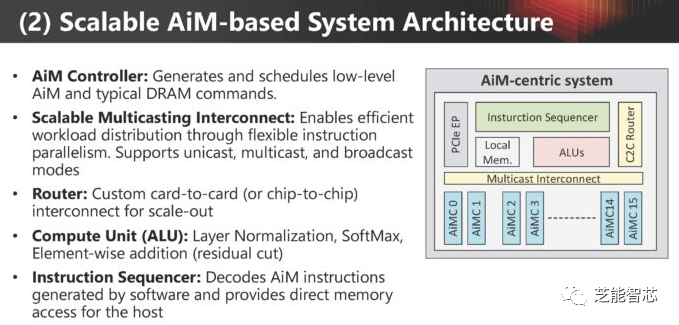

AiM架构的关键组件包括AiM控制器、可扩展多播互连、路由器、计算单元(ALU)和指令序列控制器。

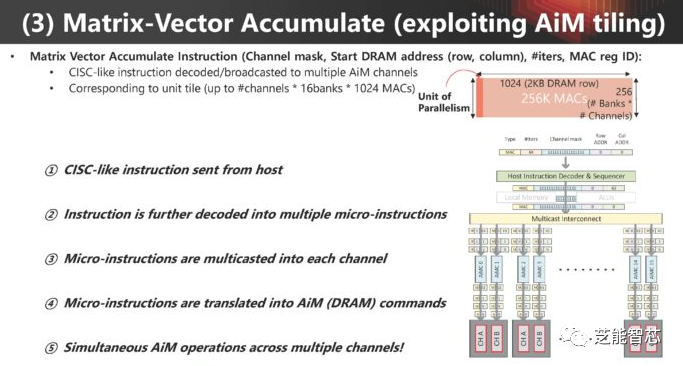

矩阵向量累积函数对人工智能工作负载至关重要,AiM使用一种类似CISC的指令集来管理这些函数。

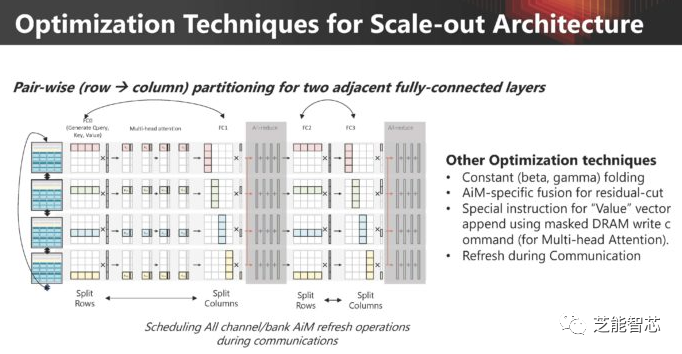

优化:在新的架构中,通常存在可以利用的微妙差异来获得更好性能的方法

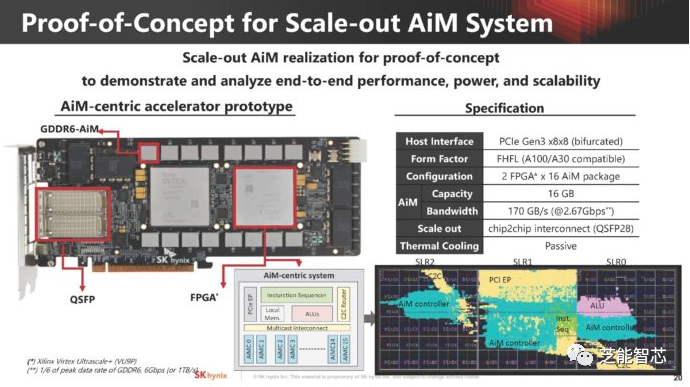

SK hynix不仅仅在抽象层面上讨论了AiM技术,展示了使用两个FPGA的GDDR6 AiM解决方案的概念验证。

AiM软件堆栈

SK hynix用来验证概念,仍然处于评估阶段,对这种解决方案与传统解决方案进行不同类型的分析。这是一个未来可能发展的方向。

编辑:黄飞

- 相关推荐

- 热点推荐

- 内存

- 人工智能

- SK hynix

- Transformer

-

LPDDR4 16Gb 技术文档详解:SK hynix H9HCNNNBKUMLXR 规格书2025-03-03 11672

-

SK Hynix & Spansion & JSC NAND FLASH参数对比2018-01-10 7965

-

基于Visual LISP的压力中心计算机速求系统(CAD)2009-08-28 1339

-

批准国家传感器质量监督检验中心计量认证范围及限制要求2010-12-22 430

-

Hynix 44nm制程2Gb低功耗DDR2内存芯片产品开发2010-01-14 1535

-

SK海力士宣布出货8GB LPDDR4手机内存 比三星晚两个月2016-12-22 2064

-

E级计算机落户深圳 云计算中心计算能力提升千倍2018-05-11 2909

-

SK海力士:内存芯片的需求旺盛,营业利润增长近两倍2018-06-25 1229

-

双TSC695F处理器在星务中心计算机系统中的应用分析2019-10-14 4683

-

SK Hynix展示DDR5存储器模组,支持DDR5的硬件预计明年推出2020-01-15 3850

-

边缘计算数据中心取代“核心计算”,施耐德打造一站式解决方案2020-10-20 3393

-

英特尔把内存芯片业务以90亿美元卖给SK海力士2020-10-21 3096

-

英特尔旗下公司:夺取云和数据中心计算市场尚需时日2020-12-03 1783

-

百度智算峰会精彩回顾:应用驱动的数据中心计算架构演进2022-12-27 1299

-

48V电压在数据中心计算平台中至关重要2025-12-05 280

全部0条评论

快来发表一下你的评论吧 !