大语言模型无损压缩方面超越PNG和FLAC

描述

Google DeepMind 和 Meta 的研究人员发表论文《Language Modeling Is Compression》,他们发现 DeepMind 的大语言模型 Chinchilla 70B 在图像和音频的无损压缩上超过了 PNG 和 FLAC。

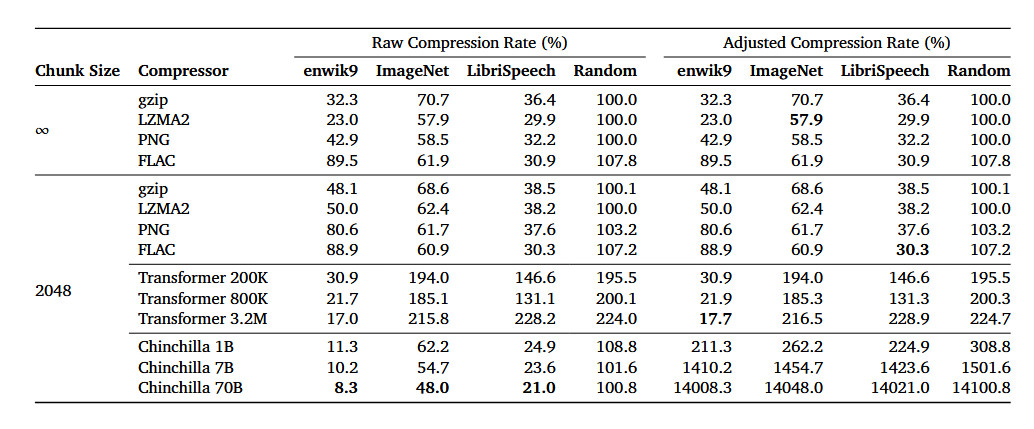

论文提到,Chinchilla 70B 能将 ImageNet 图像数据库中的图像无损压缩到原始大小 43.4%,超过了 PNG 算法的 58.5%。

Chinchilla 能将 LibriSpeech 音频数据集中的样本无损压缩到原始大小 16.4%,超过 FLAC 算法的 30.3%。

据介绍,Chinchilla 70B 主要是训练用于处理文本,但它在压缩其它类型的数据集上的效果也表现优异,甚至优于专门的算法。

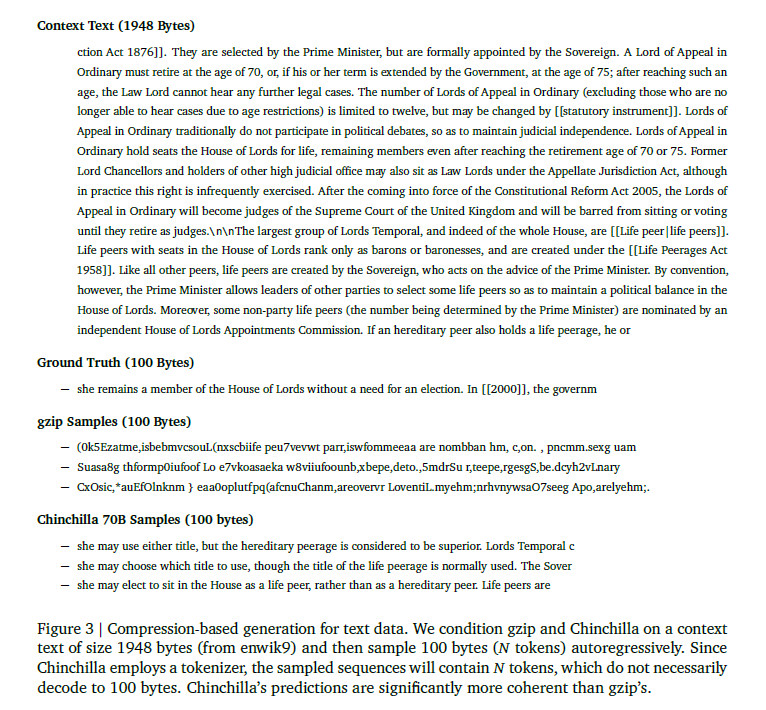

下面的例子比较了 gzip 和 Chinchilla 在示例文本上的压缩效果。可以看到,gzip 的输出没有可读性。

编辑:黄飞

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

音频信号的无损压缩编码是什么2024-09-25 1814

-

数据无损压缩2023-06-05 419

-

STM32F7移植miniLZO实现无损压缩应该怎么操作?2021-12-02 1467

-

浅析嵌入式系统中的数据无损压缩2021-10-27 1325

-

无损压缩:最大限度提高帧率并超越 GigE 带宽的限制2021-10-26 6582

-

基于强连接网络图的无损压缩算法综述2021-06-27 673

-

改变世界的无损压缩算法发展史2021-05-10 4055

-

有损压缩和无损压缩的区别2017-10-18 52462

-

基于改进SPIHT的图像无损压缩算法研究_武永红2017-03-16 820

-

机载图像无损近无损压缩方案及其FPGA实现2016-08-29 580

-

基于FPGA的LZO实时无损压缩的硬件设计2015-07-30 4184

-

LabView可以进行数据的即时无损压缩吗?2015-04-24 3759

-

基于FPGA的数据实时无损压缩系统2011-03-21 1191

-

常用数据无损压缩算法分析2010-12-23 858

全部0条评论

快来发表一下你的评论吧 !